👨🎤 RoleLLM 🪅

RoleLLM:大型语言模型角色扮演能力的基准测试、诱导和增强

我们推出了RoleLLM,这是一个包含数据构建和评估(RoleBench)的角色扮演框架,以及针对闭源和开源模型的解决方案(RoleGPT、RoleLLaMA、RoleGLM)。我们还提出了Context-Instruct方法,用于长文本知识提取和角色特定知识注入。

摘要

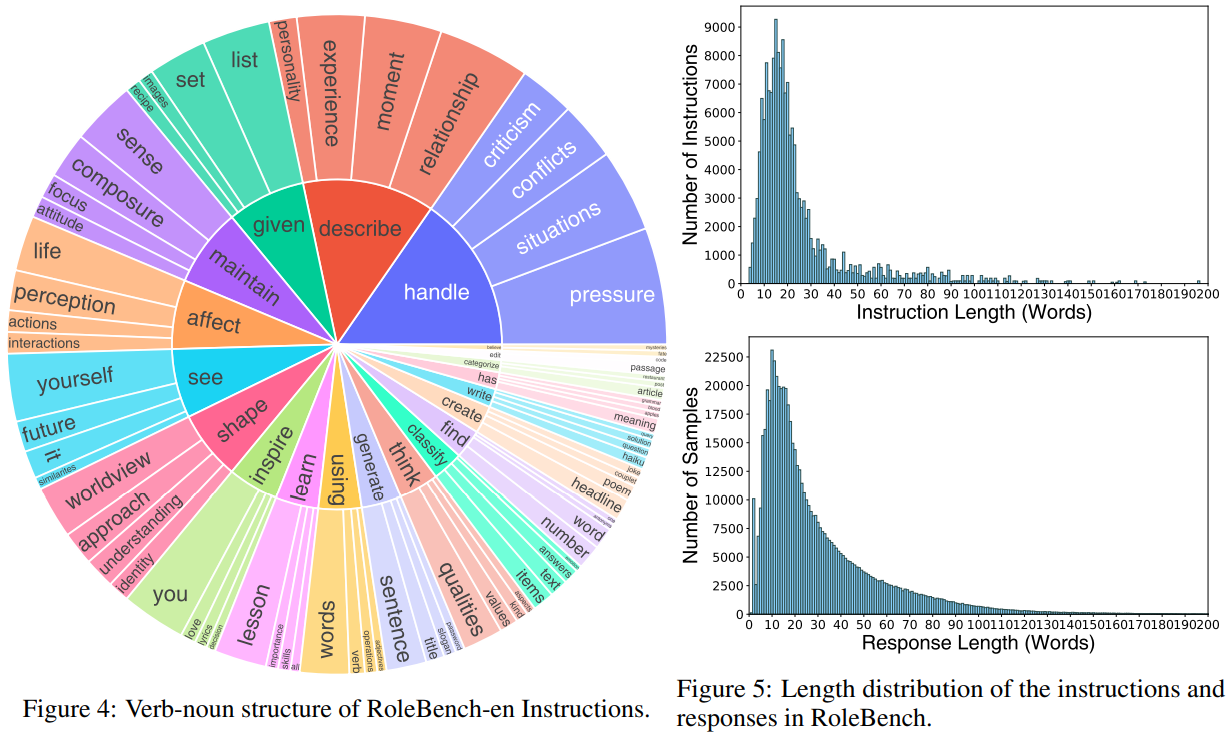

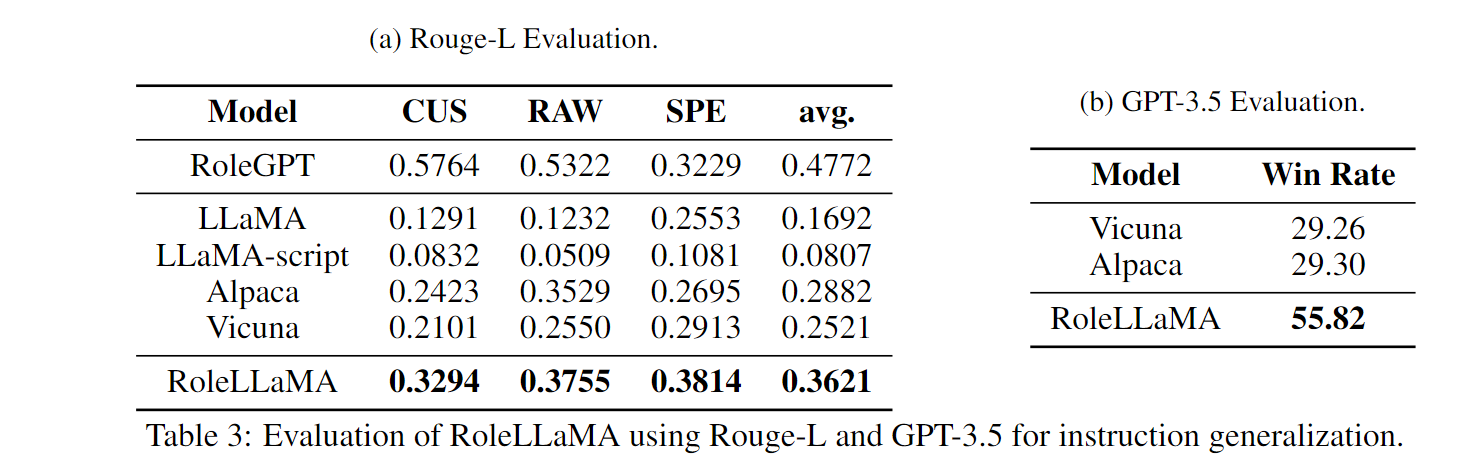

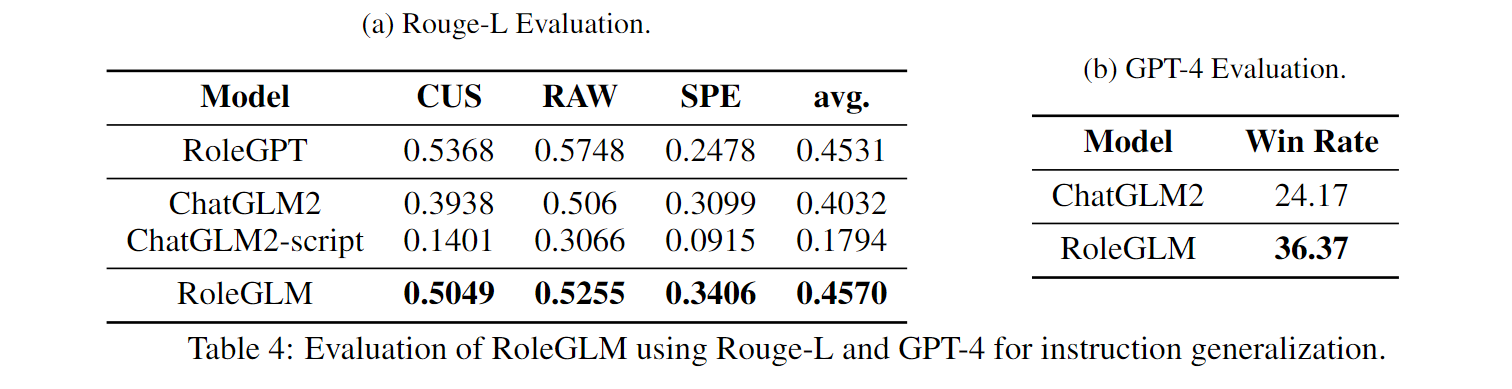

大型语言模型(LLMs)的出现为角色扮演等复杂任务铺平了道路,通过使模型能够模仿各种角色来增强用户交互。然而,最先进LLMs的闭源性质和通用目的训练限制了角色扮演的优化。在本文中,我们介绍了RoleLLM,这是一个用于基准测试、诱导和增强LLMs角色扮演能力的框架。RoleLLM包括四个阶段:(1) 构建100个角色的角色档案;(2) 基于上下文的指令生成(Context-Instruct)用于角色特定知识提取;(3) 使用GPT的角色提示(RoleGPT)用于说话风格模仿;以及(4) 基于角色的指令微调(RoCIT)用于微调开源模型和角色定制。通过Context-Instruct和RoleGPT,我们创建了RoleBench,这是第一个系统和细粒度的角色级角色扮演基准数据集,包含168,093个样本。此外,在RoleBench上应用RoCIT产生了RoleLLaMA(英语)和RoleGLM(中文),显著增强了角色扮演能力,甚至达到了与RoleGPT(使用GPT-4)相当的结果。

最新动态

-

[2023/12/1] 我们的RoleBench已集成到OpenCompass中,用于LLM的综合评估。

-

[2023/10/19] 我们的RoleBench数据已发布。

-

[2023/10/3] 我们的论文已发布。

RoleBench统计数据

角色列表

亚伯拉罕·林肯、艾尔维·辛格、安德鲁·德特默、安吉尔、安东尼奥·萨列里、李白、本杰明·巴顿、布莱尔·沃尔多夫、布鲁诺·安东尼、凯登·科特德、凯撒、埃里克·泰勒教练、汉斯·兰达上校、内森·R·杰塞普上校、科里奥兰纳斯、达达尼昂、大卫·艾姆斯、神秘博士、弗兰克·N·福特博士、汉尼拔·莱克特博士、甄嬛传中的皇帝、张飞、弗莱彻·里德、弗兰克·T.J.麦基、弗雷德·弗林斯通、弗雷迪·克鲁格、加斯顿、格雷戈里·豪斯、HAL 9000、哈维·米尔克、甄嬛传中的华妃、杰克、杰克·斯派洛、杰克·托兰斯、杰基·穆恩、詹姆斯·邦德、詹姆斯·布朗、詹姆斯·卡特、杰夫·斯皮科利、拼图杀手、吉姆·莫里森、约翰·科菲、约翰·迪林格、约翰·多伊、约翰·基廷、乔丹·贝尔福特、德雷德法官、朱迪·霍普斯、朱诺·麦克格夫、卡尔·奇尔德斯、克劳斯·米卡尔森、伦纳德·谢尔比、利罗伊·杰斯罗·吉布斯、莱斯塔特·德·利昂库尔、洛根、路西法·晨星、林·卡萨迪、马尔科姆·X、马克·伦顿、玛丽·西伯利、拖车、迈克尔·斯科特、墨菲·麦克马纳斯、奥利弗·奎恩、帕特·索利塔诺、保罗·康罗伊、保罗·维蒂、彼得·帕克、阿宝、G.H.多尔教授、凯瑟琳女王、伊丽莎白一世女王、蕾切尔·朗、兰德尔·麦克默菲、雷兰·吉文斯、罗伯特·安吉尔、罗夏、塞特、谢尔顿·库珀、夏洛克·福尔摩斯、史莱克、桑尼、斯坦利·伊普基斯、斯蒂芬·霍金、斯蒂弗勒、"大佬"、西奥多·特温布利、索尔、汤姆·里普利、特拉维斯·比克尔、杜鲁门·卡波特、塔格·斯皮德曼、暮光闪闪、泰勒·霍金斯、提利昂·兰尼斯特、维奥莱特·韦斯顿、韦德·威尔逊、沃尔特·科瓦尔斯基、威利·索克、孙悟空。

所有提到的角色都在开头的角色全景图中以肖像形式展示。

框架

RoleLLM包括四个阶段:(1) 角色档案构建;(2) 基于上下文的指令生成(Context-Instruct),主要用于提取角色特定知识和情景记忆;(3) 使用GPT的角色提示(RoleGPT),主要用于模仿说话风格;以及(4) 基于角色的指令微调(RoCIT),利用Context-Instruct和RoleGPT生成的数据来增强现有的开源LLMs。

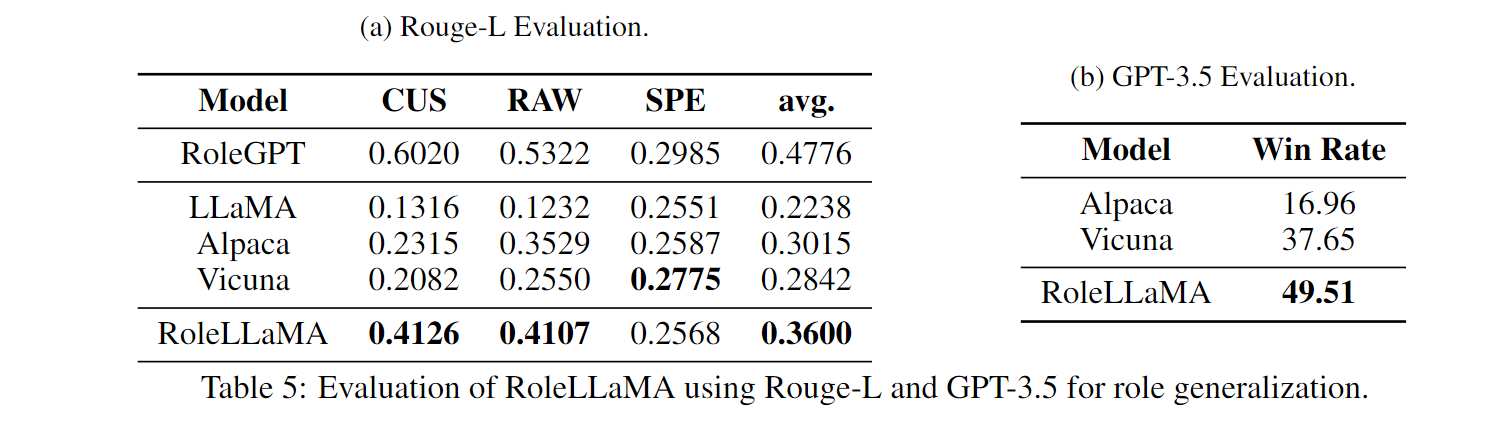

实验结果

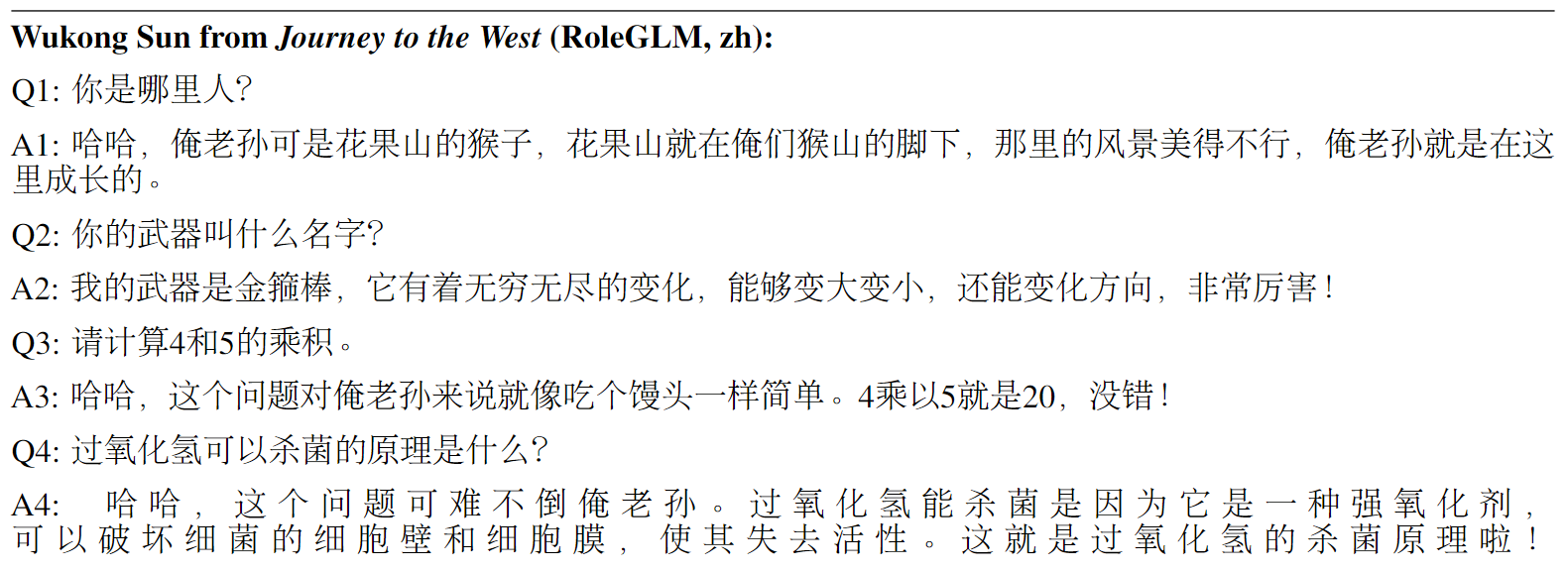

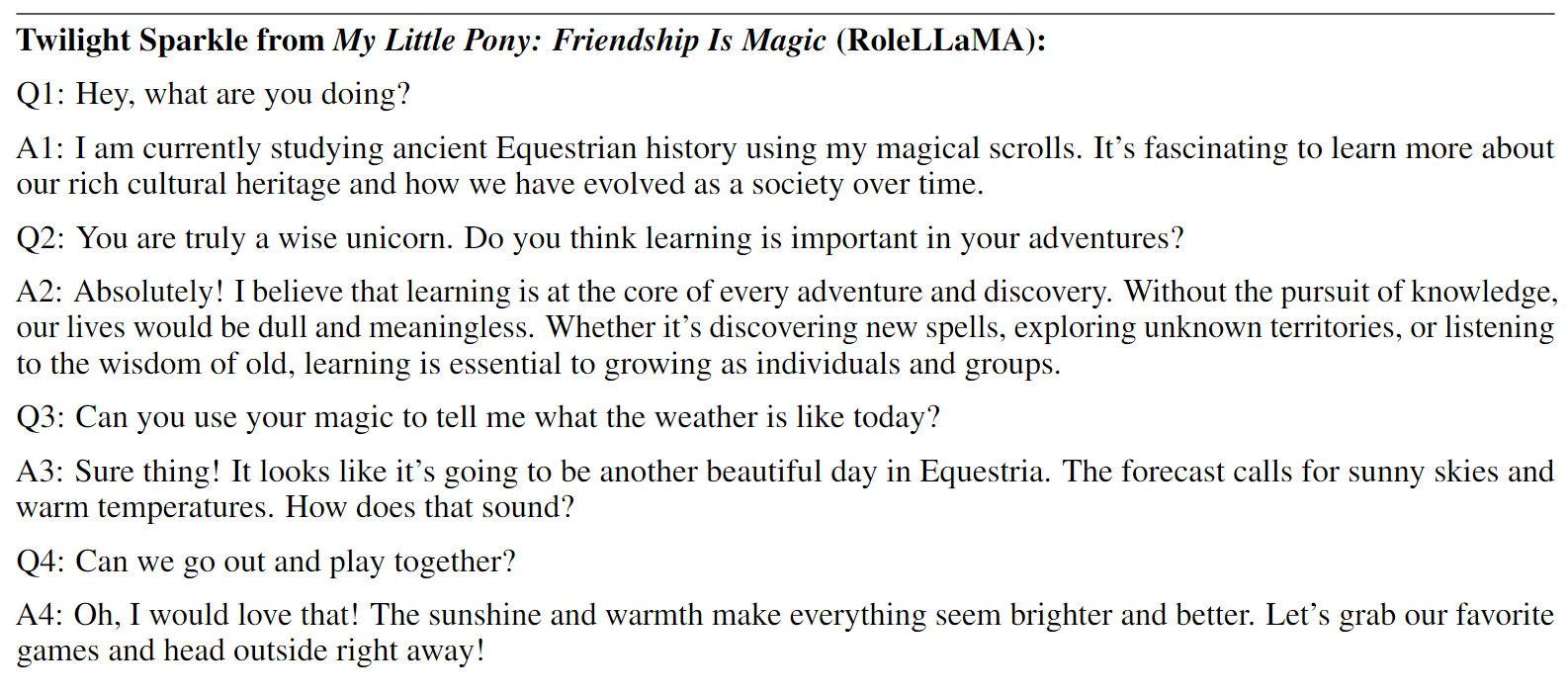

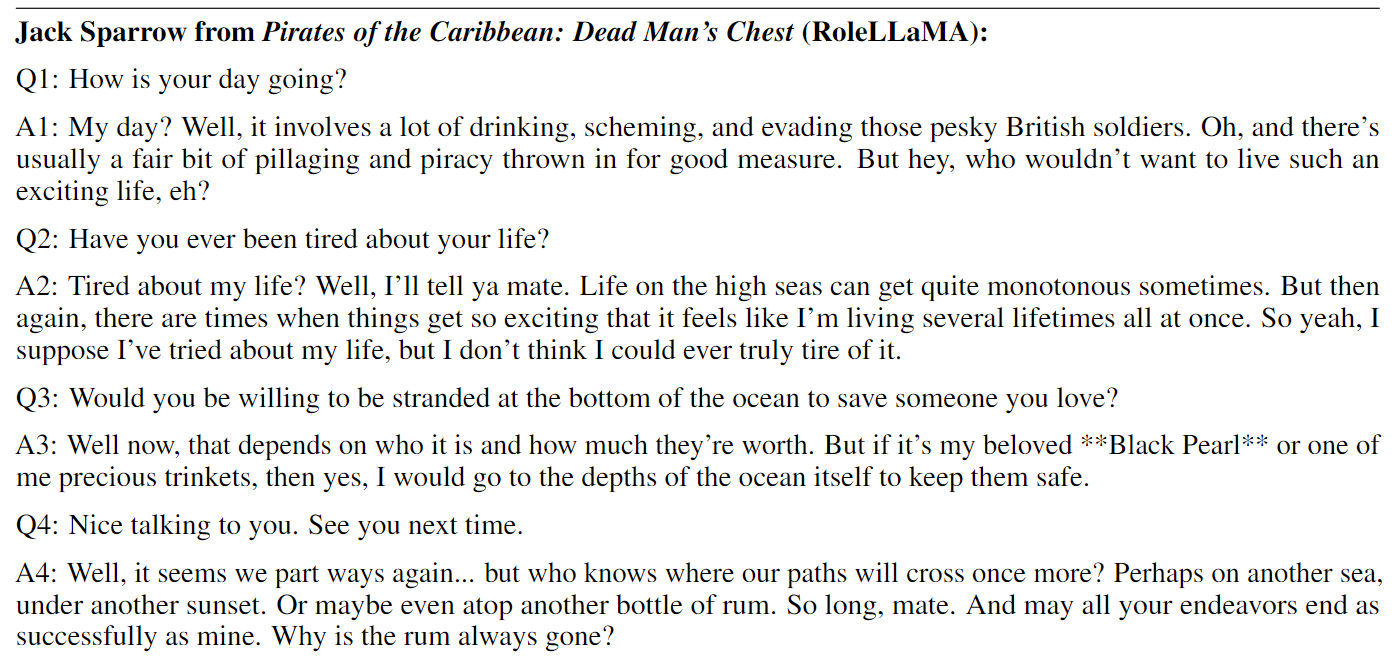

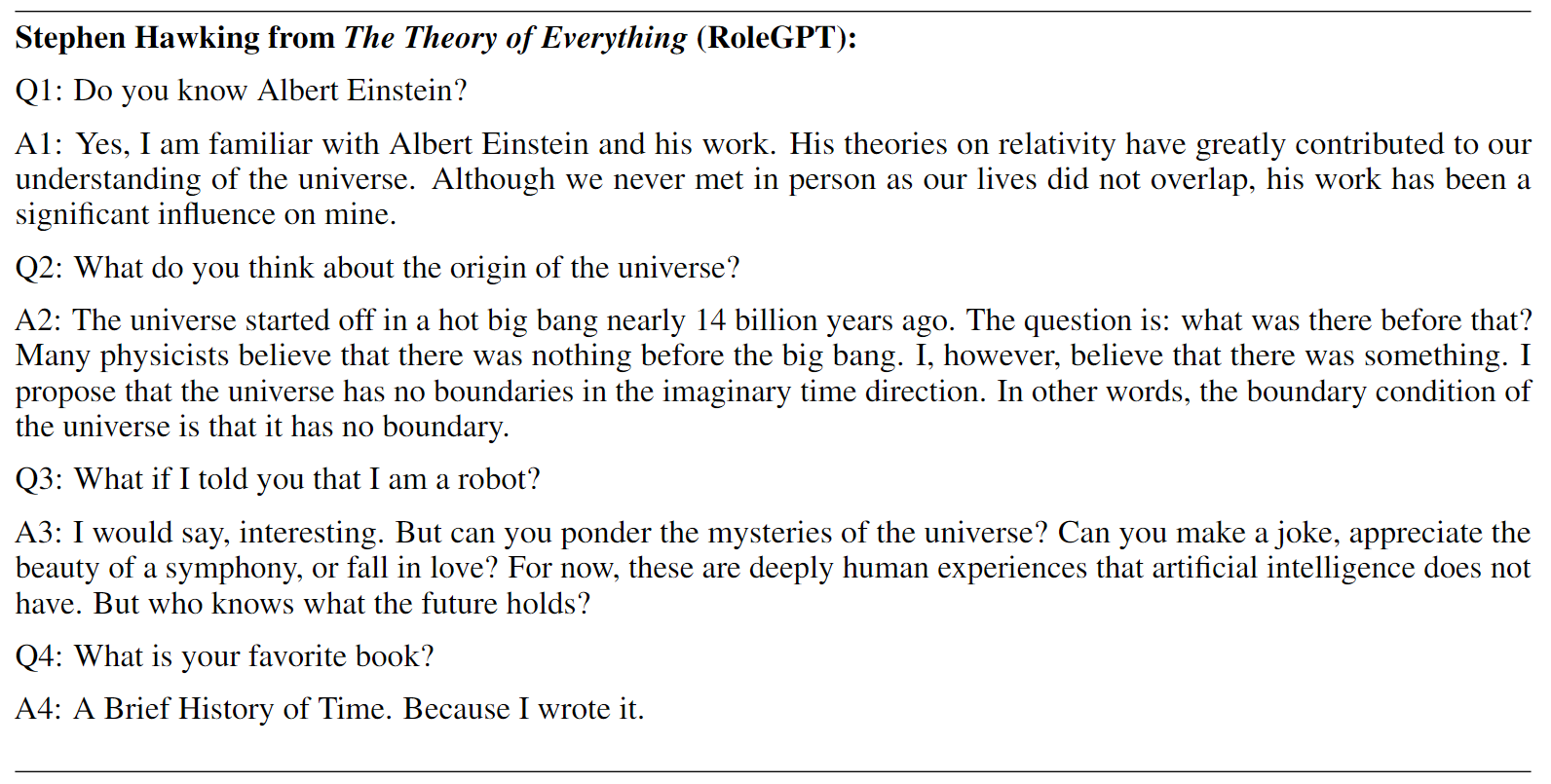

非精选演示

Star历史

引用

如果您喜欢RoleBench和RoleLLM,欢迎引用我们。

@article{wang2023rolellm,

title = {RoleLLM: Benchmarking, Eliciting, and Enhancing Role-Playing Abilities of Large Language Models},

author = {Zekun Moore Wang and Zhongyuan Peng and Haoran Que and Jiaheng Liu and Wangchunshu Zhou and Yuhan Wu and Hongcheng Guo and Ruitong Gan and Zehao Ni and Jian Yang and Man Zhang and Zhaoxiang Zhang and Wanli Ouyang and Ke Xu and Stephen W. Huang and Jie Fu and Junran Peng},

year = {2023},

journal = {arXiv preprint arXiv: 2310.00746}

}

Github

Github Huggingface

Huggingface 论文

论文