针对Hugging Face模型的循环记忆Transformer实现

RMT资源

[ 论文 ] [ 代码 ] 循环记忆Transformer的实现和各种训练示例。

[ 论文 ] [ 代码 ] BABILong - 一个支持20个任务和各种背景文本来源的长上下文基准测试。

[ 代码 ] 在BABILong上评估你的长上下文LLM!

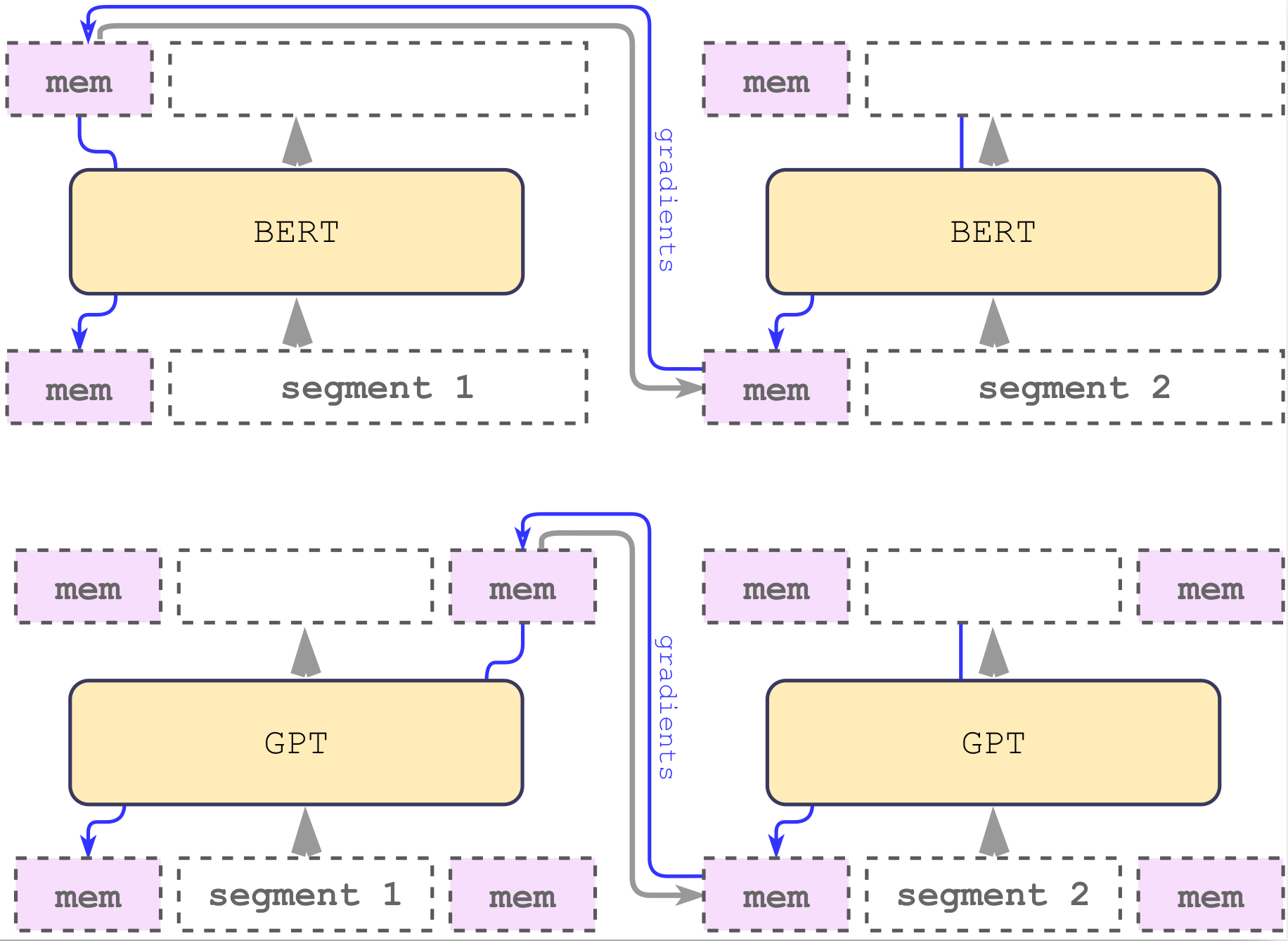

RMT是一种具有记忆增强的段级循环Transformer。我们通过向输入序列添加特殊的记忆标记,将我们的记忆机制实现为任何Hugging Face模型的包装器。该模型经过训练,可以同时控制记忆操作和序列表示处理。

本工作由DeepPavlov.ai、AIRI和伦敦数学科学研究所合作完成。

安装

pip install -e .

此命令将安装lm_experiments_tools,仅包含Trainer和工具所需的包。

lm_experiments_tools Trainer支持梯度累积、记录到tensorboard、基于指标保存最佳模型、自定义指标和数据转换支持。

安装所有实验的要求

所有实验的完整要求在requirements.txt中指定。克隆仓库后安装要求:

pip install -r requirements.txt

引用

如果您觉得我们的工作有用,请考虑引用RMT论文:

@inproceedings{

bulatov2022recurrent,

title={Recurrent Memory Transformer},

author={Aydar Bulatov and Yuri Kuratov and Mikhail Burtsev},

booktitle={Advances in Neural Information Processing Systems},

editor={Alice H. Oh and Alekh Agarwal and Danielle Belgrave and Kyunghyun Cho},

year={2022},

url={https://openreview.net/forum?id=Uynr3iPhksa}

}

@misc{bulatov2023scaling,

title={Scaling Transformer to 1M tokens and beyond with RMT},

author={Aydar Bulatov and Yuri Kuratov and Mikhail S. Burtsev},

year={2023},

eprint={2304.11062},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

@misc{kuratov2024search,

title={In Search of Needles in a 11M Haystack: Recurrent Memory Finds What LLMs Miss},

author={Yuri Kuratov and Aydar Bulatov and Petr Anokhin and Dmitry Sorokin and Artyom Sorokin and Mikhail Burtsev},

year={2024},

eprint={2402.10790},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

访问官网

访问官网 Github

Github 论文

论文