CodeFuse 仓库索引

关于本仓库

本仓库列出了 CodeFuse 的主要项目和相关演示。

关于 CodeFuse

CodeFuse 旨在开发代码大语言模型(Code LLMs),以支持和增强全生命周期的 AI 原生软件开发,涵盖设计需求、编码、测试、构建、部署、运维和洞察分析等关键阶段。以下是 CodeFuse 的整体框架。

发布更新

2024年7月 D2LLM:发布 D2Coder-v1 嵌入模型用于代码搜索,RepoFuse:基于融合双重上下文的语言模型实现仓库级代码补全

2024年6月 Codefuse-ai 页面,D2LLM 发布用于语义搜索的分解和蒸馏大语言模型特性,MFTCoder 发布 V0.4.2 版本。更多详情请见发布与下一步计划

2024年5月 ModelCache 发布 v0.2.1 版本,支持多模态,详见 CodeFuse-ModelCache。DevOps-Model 支持函数调用,详见 CodeFuse-DevOps-Model。更多详情请见发布与下一步计划

2024年4月 CodeFuse-muAgent:一个多智能体框架,更多详情请见发布与下一步计划

CodeFuse 仓库列表

我们根据上述生命周期列出了存储库。

| 生命周期阶段 | 项目存储库 | 存储库描述 | 路线图 |

|---|---|---|---|

| 需求与设计 | MFT-VLM | 视觉语言任务的指令微调 | |

| 编码 | MFTCoder | 指令调优框架 | |

| FastTransformer4CodeFuse | 基于FT的推理引擎 | ||

| CodeFuse-Eval | CodeFuse评估工具包 | ||

| 测试与构建 | TestAgent | TestGPT演示前端 | |

| DevOps | DevOps-Eval | DevOps基准测试 | |

| DevOps-Model | DevOps模型索引 | ||

| 数据洞察 | 暂无 | 暂无 | |

| 基础 | ChatBot | CodeFuse通用聊天机器人前端 | |

| muAgent | 多代理框架 | ||

| ModelCache | LLM服务的语义缓存 | ||

| CodeFuse-Query | 基于查询的代码分析引擎 | ||

| 其他 | CoCA | 共线注意力 | |

| Awesine-Code-LLM | 代码LLM调查 | ||

| 本存储库 | CodeFuse存储库的总体介绍和索引 |

CodeFuse主要发布模型列表

| 模型名称 | 简短描述 | 模型链接 |

|---|---|---|

| CodeFuse-13B | CodeFuse从头训练 | HF ; MS |

| CodeFuse-CodeLLaMA-34B | 基于CodeLLaMA-34B微调 | HF ; MS |

| ** CodeFuse-CodeLLaMA-34B-4bits | 34B模型的4位量化版本 | HF ; MS |

| CodeFuse-DeepSeek-33B | 基于DeepSeek-Coder-33b微调 | HF ; MS |

| ** CodeFuse-DeepSeek-33B-4bits | 33B模型的4位量化版本 | HF ; MS |

| CodeFuse-VLM-14B | 最先进的视觉语言模型 | HF ; MS |

** -- 推荐模型;

演示

-

视频演示:中文版如下,英文版正在准备中。

-

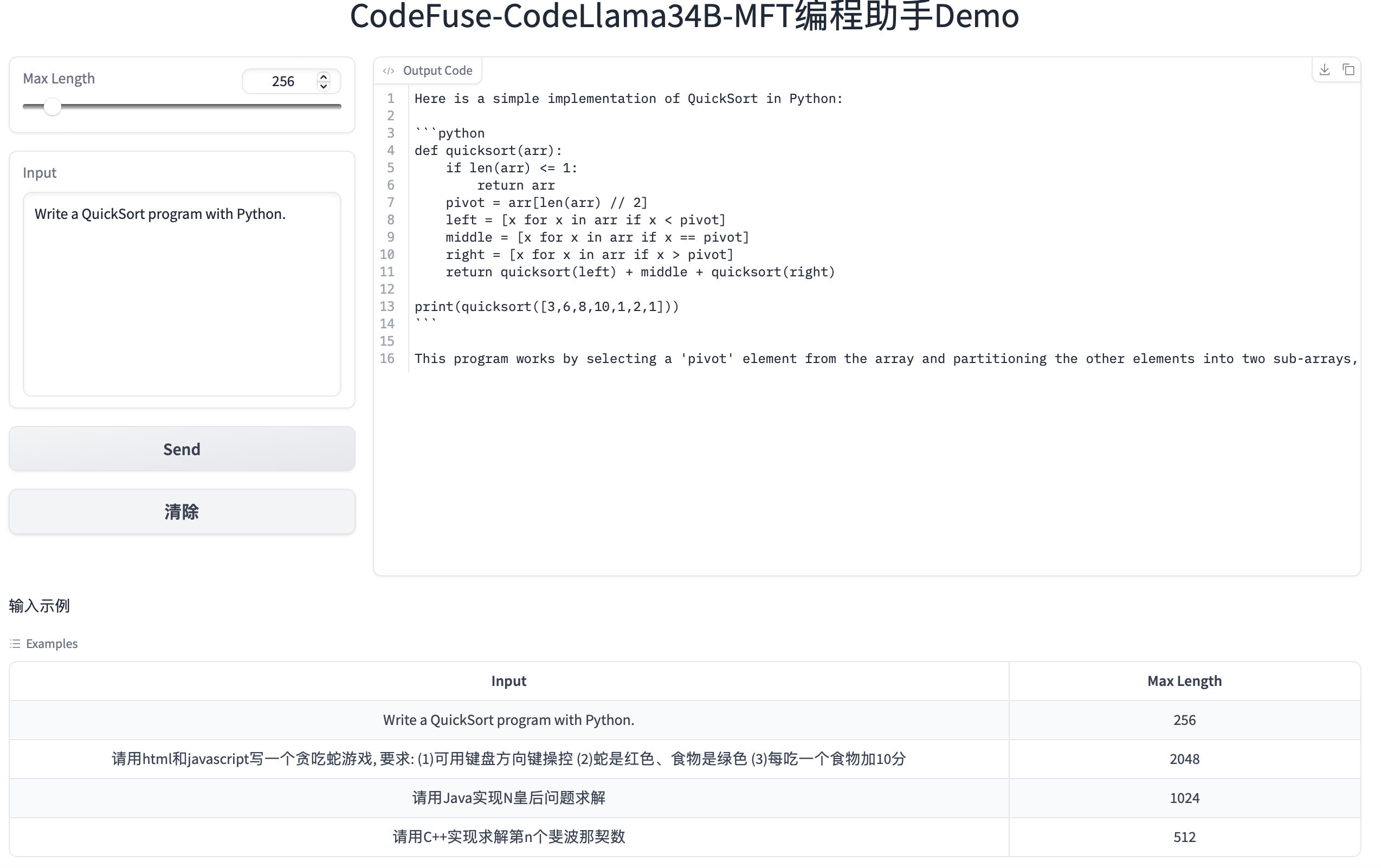

在线演示:您可以在 ModelScope 上试用我们的 CodeFuse-CodeLlama-34B 模型:CodeFuse-CodeLlama34B-MFT-Demo

- 您也可以安装 CodeFuse-Chatbot 来在本地测试我们的模型。

如何获取

- HuggingFace

- ModelScope

- WiseModel

- 如果您想训练或微调自己的模型,可以尝试我们的 MFTCoder,它支持多任务、多模型和多训练框架场景的高效微调。

引用

有关 CodeFuse 的更多技术细节,请参阅我们的论文 MFTCoder。

如果您认为我们的工作对您的研发有帮助,欢迎按以下格式引用我们的论文:

@article{mftcoder2023,

title={MFTCoder: Boosting Code LLMs with Multitask Fine-Tuning},

author={Bingchang Liu and Chaoyu Chen and Cong Liao and Zi Gong and Huan Wang and Zhichao Lei and Ming Liang and Dajun Chen and Min Shen and Hailian Zhou and Hang Yu and Jianguo Li},

year={2023},

journal={arXiv preprint arXiv},

archivePrefix={arXiv},

eprint={2311.02303}

}

Github

Github Huggingface

Huggingface 论文

论文