📥 模型下载 |

⚡ 快速开始 |

📜 许可证 |

📖 引用

📄 论文链接 |

🤗 Huggingface论文链接 |

👁️ 演示

1. 简介

介绍DeepSeek-VL,这是一个为实际视觉和语言理解应用设计的开源视觉语言(VL)模型。DeepSeek-VL具有通用的多模态理解能力,能够处理逻辑图表、网页、公式识别、科学文献、自然图像,以及复杂场景中的具身智能。

卢浩宇*、刘文*、张博**、王冰轩、董凯、刘博、孙敬翔、任卓声、李卓书、杨浩、孙耀锋、邓成奇、徐瀚威、谢震达、阮冲(*共同第一作者,**项目负责人)

2. 发布

✅ 2024-03-14:DeepSeek-VL-7B的演示在Hugging Face上可用。

请在https://huggingface.co/spaces/deepseek-ai/DeepSeek-VL-7B查看DeepSeek-VL-7B的gradio演示。亲身体验其功能!

✅ 2024-03-13:支持DeepSeek-VL gradio演示。

✅ 2024-03-11:DeepSeek-VL系列发布,包括DeepSeek-VL-7B-base、DeepSeek-VL-7B-chat、DeepSeek-VL-1.3B-base和DeepSeek-VL-1.3B-chat。

此次发布包括DeepSeek-VL系列中为各种应用定制的多样化模型。这些模型有两种规模:7B和1.3B参数,每种规模都提供基础和聊天变体,以满足不同的需求和集成场景。

3. 模型下载

我们向公众发布了DeepSeek-VL系列,包括1.3B-base、1.3B-chat、7b-base和7b-chat模型,以支持学术和商业社区内更广泛、更多样化的研究。请注意,本模型的使用受许可证部分中概述的条款约束。根据这些条款,允许商业使用。

Huggingface

| 模型 | 序列长度 | 下载链接 |

|---|---|---|

| DeepSeek-VL-1.3B-base | 4096 | 🤗 Hugging Face |

| DeepSeek-VL-1.3B-chat | 4096 | 🤗 Hugging Face |

| DeepSeek-VL-7B-base | 4096 | 🤗 Hugging Face |

| DeepSeek-VL-7B-chat | 4096 | 🤗 Hugging Face |

4. 快速入门

安装

在Python 3.8或更高版本的环境中,运行以下命令安装必要的依赖项:

pip install -e .

简单推理示例

import torch

from transformers import AutoModelForCausalLM

from deepseek_vl.models import VLChatProcessor, MultiModalityCausalLM

from deepseek_vl.utils.io import load_pil_images

# 指定模型路径

model_path = "deepseek-ai/deepseek-vl-7b-chat"

vl_chat_processor: VLChatProcessor = VLChatProcessor.from_pretrained(model_path)

tokenizer = vl_chat_processor.tokenizer

vl_gpt: MultiModalityCausalLM = AutoModelForCausalLM.from_pretrained(model_path, trust_remote_code=True)

vl_gpt = vl_gpt.to(torch.bfloat16).cuda().eval()

## 单图对话示例

conversation = [

{

"role": "User",

"content": "<image_placeholder>描述这张图片的每个阶段。",

"images": ["./images/training_pipelines.jpg"],

},

{"role": "Assistant", "content": ""},

]

## 多图(或上下文学习)对话示例

# conversation = [

# {

# "role": "User",

# "content": "<image_placeholder>前景中的狗没有穿任何东西,"

# "<image_placeholder>一只戴着圣诞帽的狗,"

# "<image_placeholder>一只穿着巫师服装的狗,以及"

# "<image_placeholder>这只狗穿着什么?",

# "images": [

# "images/dog_a.png",

# "images/dog_b.png",

# "images/dog_c.png",

# "images/dog_d.png",

# ],

# },

# {"role": "Assistant", "content": ""}

# ]

# 加载图片并准备输入

pil_images = load_pil_images(conversation)

prepare_inputs = vl_chat_processor(

conversations=conversation,

images=pil_images,

force_batchify=True

).to(vl_gpt.device)

# 运行图像编码器获取图像嵌入

inputs_embeds = vl_gpt.prepare_inputs_embeds(**prepare_inputs)

# 运行模型获取响应

outputs = vl_gpt.language_model.generate(

inputs_embeds=inputs_embeds,

attention_mask=prepare_inputs.attention_mask,

pad_token_id=tokenizer.eos_token_id,

bos_token_id=tokenizer.bos_token_id,

eos_token_id=tokenizer.eos_token_id,

max_new_tokens=512,

do_sample=False,

use_cache=True

)

answer = tokenizer.decode(outputs[0].cpu().tolist(), skip_special_tokens=True)

print(f"{prepare_inputs['sft_format'][0]}", answer)

命令行聊天

python cli_chat.py --model_path "deepseek-ai/deepseek-vl-7b-chat"

# 或本地路径

python cli_chat.py --model_path "本地模型路径"

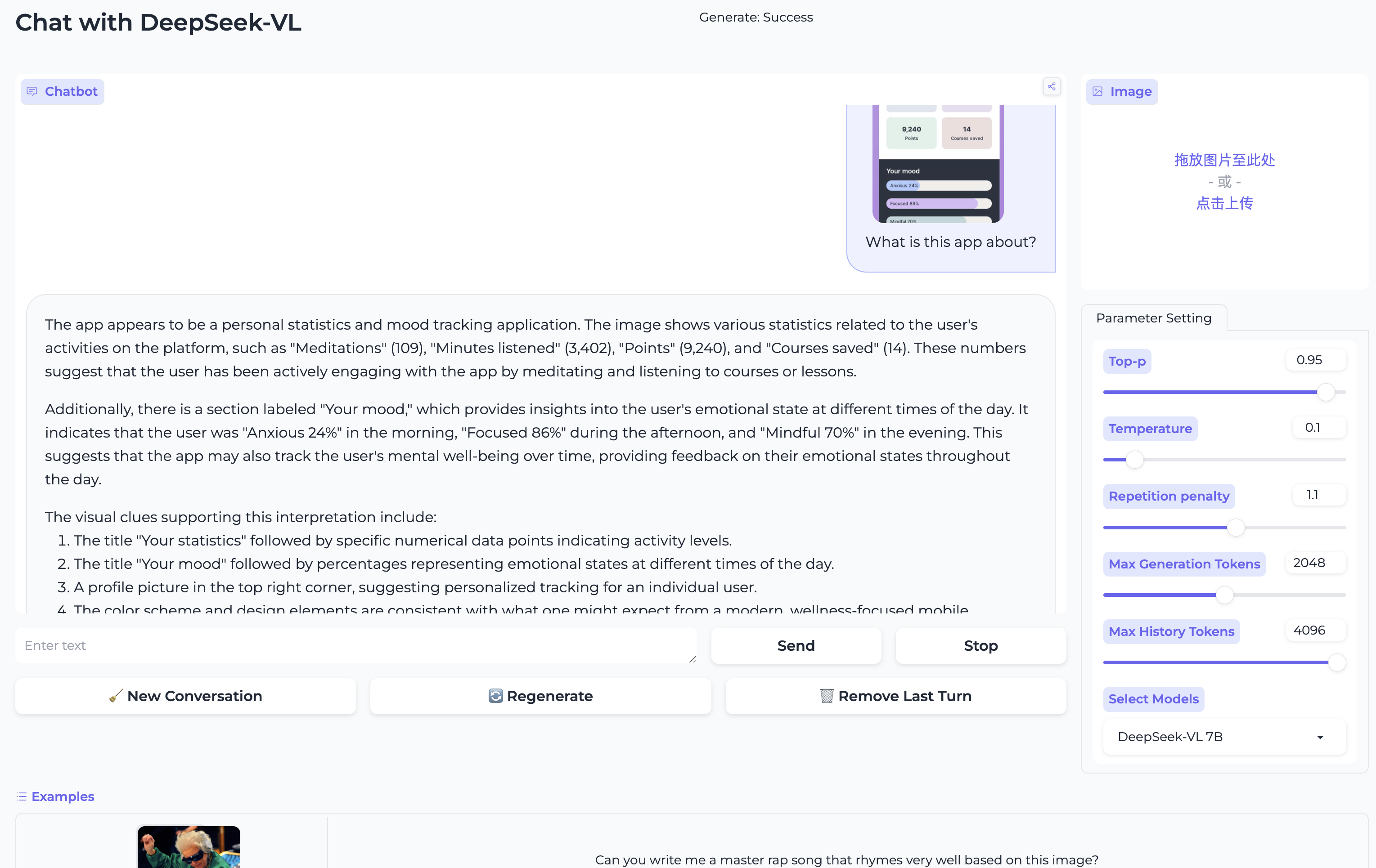

Gradio演示

pip install -e .[gradio]

python deepseek_vl/serve/app_deepseek.py

玩得开心!

5. 许可证

此代码仓库采用MIT许可证。DeepSeek-VL Base/Chat模型的使用受DeepSeek模型许可证约束。DeepSeek-VL系列(包括Base和Chat)支持商业使用。

6. 引用

@misc{lu2024deepseekvl,

title={DeepSeek-VL: Towards Real-World Vision-Language Understanding},

author={Haoyu Lu and Wen Liu and Bo Zhang and Bingxuan Wang and Kai Dong and Bo Liu and Jingxiang Sun and Tongzheng Ren and Zhuoshu Li and Hao Yang and Yaofeng Sun and Chengqi Deng and Hanwei Xu and Zhenda Xie and Chong Ruan},

year={2024},

eprint={2403.05525},

archivePrefix={arXiv},

primaryClass={cs.AI}

}

7. 联系方式

如果您有任何问题,请提出issue或通过service@deepseek.com联系我们。

访问官网

访问官网 Github

Github Huggingface

Huggingface 论文

论文