TensorFlow Lite简介

TensorFlow Lite是Google专为移动和嵌入式设备设计的轻量级机器学习框架。它能够在资源受限的环境中高效运行复杂的AI模型,为移动应用程序带来智能化功能。本文将以一个实际的Android项目为例,详细介绍TensorFlow Lite的工作原理及其在移动端的应用。

Android-TensorFlow-Lite-Example项目概述

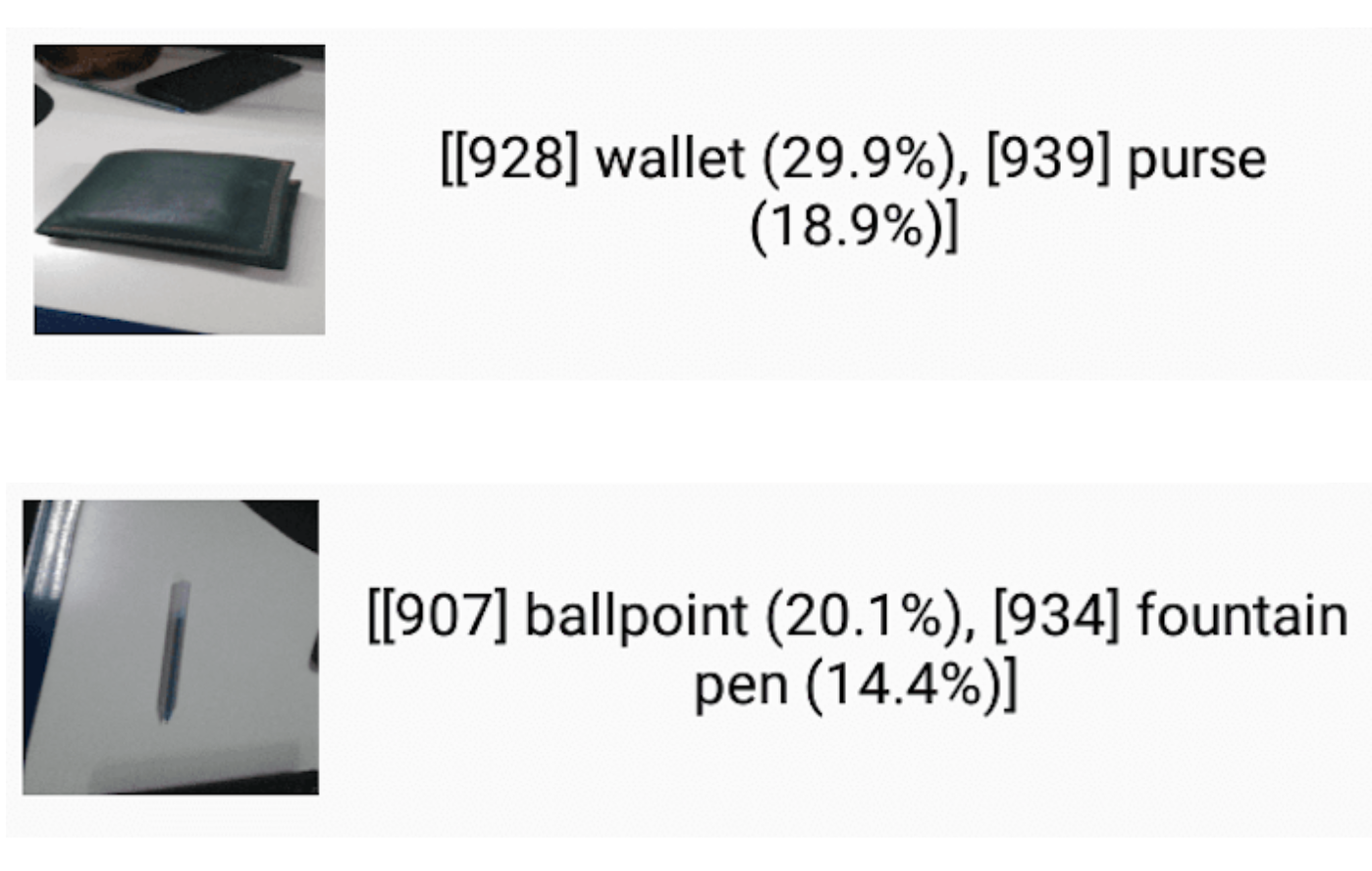

Android-TensorFlow-Lite-Example是一个开源的示例项目,展示了如何在Android应用中集成TensorFlow Lite。该项目实现了一个基于相机的实时物体检测功能,能够识别摄像头中捕捉到的物体并给出分类结果。

项目核心功能

- 相机集成:利用Android Camera2 API实现实时视频流捕捉。

- 图像预处理:将摄像头捕获的图像转换为TensorFlow Lite模型所需的输入格式。

- 模型推理:使用预训练的MobileNet模型进行实时物体检测。

- 结果展示:在屏幕上实时显示检测结果,包括物体类别和置信度。

TensorFlow Lite工作流程

- 模型转换:将训练好的TensorFlow模型转换为TensorFlow Lite格式(.tflite)。

- 模型加载:在Android应用中加载.tflite模型文件。

- 输入准备:将图像数据转换为模型所需的输入格式。

- 模型推理:使用TensorFlow Lite Interpreter运行模型推理。

- 输出处理:解析模型输出,获取识别结果。

项目实现细节

1. 项目配置

在app模块的build.gradle文件中添加TensorFlow Lite依赖:

dependencies {

implementation 'org.tensorflow:tensorflow-lite:2.4.0'

implementation 'org.tensorflow:tensorflow-lite-support:0.1.0'

}

2. 模型准备

本项目使用预训练的MobileNet模型。将转换好的.tflite文件放置在app/src/main/assets目录下。

3. 图像处理

使用Android的Bitmap类和Matrix类对捕获的图像进行缩放和裁剪,以符合模型的输入要求:

private Bitmap processBitmap(Bitmap bitmap) {

int dimension = Math.min(bitmap.getWidth(), bitmap.getHeight());

bitmap = ThumbnailUtils.extractThumbnail(bitmap, dimension, dimension);

bitmap = Bitmap.createScaledBitmap(bitmap, INPUT_SIZE, INPUT_SIZE, false);

return bitmap;

}

4. 模型推理

使用TensorFlow Lite Interpreter进行模型推理:

private void runInference() {

if (null == tflite) {

try {

tflite = new Interpreter(loadModelFile(this.getAssets()));

} catch (Exception e) {

e.printStackTrace();

}

}

if (null != tflite) {

// 运行模型推理

tflite.run(imgData, labelProbArray);

}

}

5. 结果处理

解析模型输出,获取top-N个预测结果:

private void printTopKLabels() {

for (int i = 0; i < labels.size(); ++i) {

sortedLabels.add(

new AbstractMap.SimpleEntry<>(labels.get(i), labelProbArray[0][i]));

}

Collections.sort(sortedLabels,

(o1, o2) -> (o2.getValue().compareTo(o1.getValue())));

// 显示top-3结果

for (int i = 0; i < 3; ++i) {

Map.Entry<String, Float> label = sortedLabels.poll();

Log.i(TAG, String.format("%s: %4.2f",label.getKey(),label.getValue()));

}

}

性能优化技巧

- 量化:使用量化模型可以显著减小模型体积,提高推理速度。

- 硬件加速:利用GPU或NPU等硬件加速器提升推理性能。

- 多线程:将图像预处理和模型推理放在不同线程中执行,提高并发性能。

应用场景拓展

TensorFlow Lite不仅限于图像分类,还可以应用于多种场景:

- 自然语言处理:文本分类、情感分析等。

- 语音识别:关键词检测、声音分类等。

- 姿态估计:人体关键点检测、动作识别等。

未来发展趋势

- 模型压缩技术的进步将使更复杂的AI模型能够在移动设备上运行。

- 边缘计算的普及将推动更多AI任务在本地设备上完成,提高隐私保护和实时性。

- 跨平台开发工具的完善将简化TensorFlow Lite的开发流程。

总结

Android-TensorFlow-Lite-Example项目展示了如何在Android平台上集成和使用TensorFlow Lite,为开发者提供了一个很好的起点。通过这个项目,我们可以看到TensorFlow Lite为移动设备带来的AI能力,以及它在实际应用中的巨大潜力。随着移动AI技术的不断发展,我们可以期待看到更多创新的移动应用场景。

对于有志于探索移动AI领域的开发者来说,深入学习TensorFlow Lite无疑是一个明智的选择。它不仅能够帮助你构建智能化的移动应用,还能让你站在人工智能技术的前沿。希望本文能为你的TensorFlow Lite学习之旅提供有价值的参考。