BCL:提升记忆效果的对比学习新方法

在机器学习领域,自监督学习已经成为表示学习的一个重要方向,尤其是在视觉和文本数据处理方面取得了巨大的成功。然而,当前的大多数方法主要在精心策划的数据集上进行验证,这些数据集并不能很好地反映现实世界中的长尾分布特征。为了解决这一问题,研究人员提出了一种名为BCL(Boosted Contrastive Learning)的新型对比学习方法,该方法巧妙地利用了深度神经网络的记忆效应,以提高长尾数据的学习效果。

BCL方法的创新之处

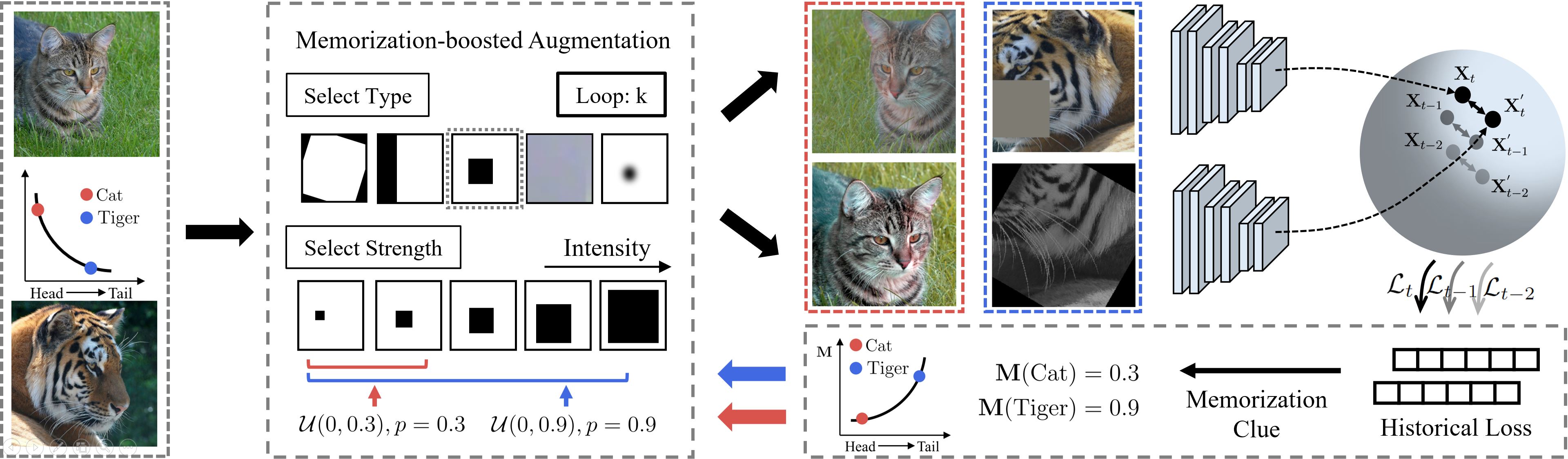

BCL方法的核心创新在于从数据角度出发,利用深度神经网络的记忆效应来自动驱动对比学习中样本视图的信息差异。这种方法在无标签的情况下能够更有效地增强长尾学习。具体来说,BCL方法包含以下几个关键步骤:

-

记忆增强的数据处理:使用特殊设计的memoboosted_CIFAR100等数据集,通过跟踪训练过程中的动量损失来调整样本权重。

-

动量损失跟踪:在训练过程中,使用shadow和momentum_loss等变量来记录和更新每个样本的损失信息。

-

自适应视图生成:根据记忆的损失信息,动态调整数据增强策略,为不同样本生成信息量差异更大的视图对。

-

对比学习优化:在此基础上进行对比学习,使模型能够更好地学习到长尾数据的特征表示。

这种方法不依赖于标签信息,也不需要复杂的模型设计,而是通过数据本身的特性来提升学习效果,这使得BCL在处理现实世界中的长尾分布数据时具有独特的优势。

BCL的实现与评估

BCL方法的实现主要基于PyTorch框架,核心代码结构清晰,易于理解和扩展。以下是BCL方法的一个代码片段,展示了其核心思想:

train_datasets = memoboosted_CIFAR100(train_idx_list, args, root=args.data_folder, train=True)

# 初始化动量损失

shadow = torch.zeros(dataset_total_num).cuda()

momentum_loss = torch.zeros(args.epochs,dataset_total_num).cuda()

shadow, momentum_loss = train(train_loader, model, optimizer, scheduler, epoch, log, shadow, momentum_loss, args=args)

train_datasets.update_momentum_weight(momentum_loss, epoch)

在训练过程中,BCL方法通过跟踪每个样本的损失信息来动态调整其权重:

if epoch > 1:

new_average = (1.0 - args.momentum_loss_beta) * loss[batch_idx].clone().detach() + args.momentum_loss_beta * shadow[index[batch_idx]]

else:

new_average = loss[batch_idx].clone().detach()

shadow[index[batch_idx]] = new_average

momentum_loss[epoch-1,index[batch_idx]] = new_average

为了全面评估BCL方法的性能,研究人员在多个基准数据集上进行了实验,包括CIFAR-100-LT等。评估指标包括全量样本(Full-shot)、100样本(100-shot)和50样本(50-shot)的线性探测准确率。实验结果表明,BCL方法在各种设置下都显著优于现有的自监督学习方法。

BCL的应用前景

BCL方法不仅在学术研究中展现出优异的性能,还有望在多个实际应用场景中发挥重要作用:

-

计算机视觉:在图像分类、目标检测等任务中,BCL可以帮助模型更好地处理长尾分布的视觉数据,提高对稀有类别的识别能力。

-

自然语言处理:对于长尾分布的文本数据,BCL可以改善词嵌入和语言模型的表示学习,提高对低频词和罕见表达的处理能力。

-

推荐系统:在处理用户-物品交互数据时,BCL可以帮助捕捉长尾物品的特征,改善对冷门物品的推荐效果。

-

异常检测:在工业场景中,BCL可以提高对罕见故障模式的识别能力,增强预测性维护系统的性能。

-

医疗诊断:对于罕见疾病的诊断,BCL可以帮助模型从有限的样本中学习更好的特征表示,提高诊断准确率。

未来研究方向

尽管BCL方法在长尾分布学习中取得了显著进展,但仍有一些值得进一步探索的方向:

-

理论分析:深入研究BCL方法的理论基础,分析其在不同数据分布下的性能保证。

-

大规模应用:探索BCL方法在更大规模数据集和更复杂任务中的应用,如ImageNet等。

-

与其他技术的结合:研究BCL与迁移学习、元学习等技术的结合,进一步提升其在实际应用中的性能。

-

动态调整策略:开发更智能的动态调整策略,使BCL能够更好地适应不同数据集的特性。

-

跨模态学习:探索BCL在跨模态学习任务中的应用,如图像-文本对比学习等。

总的来说,BCL方法为解决自监督学习中的长尾分布问题提供了一个新的视角和有效的解决方案。随着进一步的研究和优化,BCL有望在更广泛的机器学习应用中发挥重要作用,推动人工智能技术在处理现实世界复杂数据分布时的进步。

🔬 如果您对BCL方法感兴趣,可以访问BCL项目的GitHub仓库获取更多详细信息,包括完整的代码实现、预训练模型和实验结果。研究人员也欢迎社区贡献,共同推进这一创新方法的发展。