ChatGLM模型微调技术详解:从Freeze到全参数训练的全面指南

随着ChatGLM系列大型语言模型的不断发展,如何有效地对这些模型进行微调以适应特定任务已成为一个重要课题。本文将深入探讨ChatGLM、ChatGLM2和ChatGLM3模型的多种微调技术,包括Freeze方法、P-Tuning方法、LoRA方法以及全参数训练方法,为开发者提供全面的微调指南。

Freeze方法:冻结部分参数实现高效微调

Freeze方法是一种简单而有效的微调技术,其核心思想是冻结原始模型的部分参数,仅训练剩余的参数。这种方法可以在单卡或多卡环境下,无需进行张量并行(TP)或流水线并行(PP)操作就能对大模型进行训练。

实现Freeze方法的核心代码如下:

freeze_module_name = args.freeze_module_name.split(",")

for name, param in model.named_parameters():

if not any(nd in name for nd in freeze_module_name):

param.requires_grad = False

通过修改freeze_module_name参数,可以灵活地控制模型的哪些层参数被冻结。例如,可以设置为"layers.27.,layers.26.,layers.25.,layers.24."来冻结模型的最后四层。

对于ChatGLM模型,单卡训练的命令示例如下:

CUDA_VISIBLE_DEVICES=0 deepspeed --master_port 520 train.py \

--train_path data/spo_0.json \

--model_name_or_path ChatGLM-6B/ \

--per_device_train_batch_size 1 \

--max_len 1560 \

--max_src_len 1024 \

--learning_rate 1e-4 \

--weight_decay 0.1 \

--num_train_epochs 2 \

--gradient_accumulation_steps 4 \

--warmup_ratio 0.1 \

--mode glm \

--train_type freeze \

--freeze_module_name "layers.27.,layers.26.,layers.25.,layers.24." \

--seed 1234 \

--ds_file ds_zero2_no_offload.json \

--gradient_checkpointing \

--show_loss_step 10 \

--output_dir ./output-glm

对于多卡训练,只需修改CUDA_VISIBLE_DEVICES参数即可。ChatGLM2和ChatGLM3的训练命令类似,只需将mode参数分别改为glm2和glm3。

P-Tuning方法:软提示微调的优化

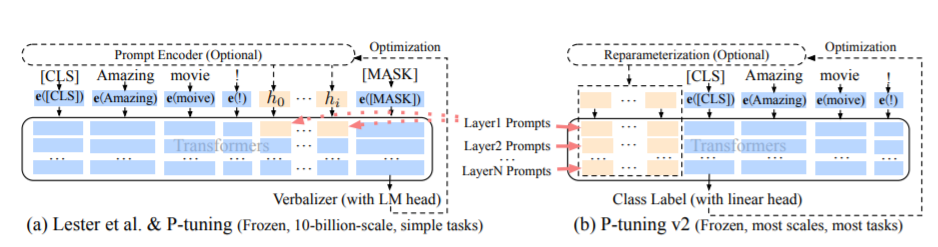

P-Tuning是一种针对大模型的软提示(soft-prompt)微调方法。它分为两个版本:

- P-Tuning:仅在大模型的Embedding层加入新的参数。

- P-Tuning-V2:在大模型的Embedding层和每一层前都加上新的参数。

实现P-Tuning方法的核心代码如下:

config = MODE[args.mode]["config"].from_pretrained(args.model_name_or_path)

config.pre_seq_len = args.pre_seq_len

config.prefix_projection = args.prefix_projection

model = MODE[args.mode]["model"].from_pretrained(args.model_name_or_path, config=config)

for name, param in model.named_parameters():

if not any(nd in name for nd in ["prefix_encoder"]):

param.requires_grad = False

当prefix_projection为True时,使用P-Tuning-V2方法;为False时,使用P-Tuning方法。

对于ChatGLM模型,单卡训练的命令示例如下:

CUDA_VISIBLE_DEVICES=0 deepspeed --master_port 520 train.py \

--train_path data/spo_0.json \

--model_name_or_path ChatGLM-6B \

--per_device_train_batch_size 1 \

--max_len 768 \

--max_src_len 512 \

--learning_rate 1e-4 \

--weight_decay 0.1 \

--num_train_epochs 2 \

--gradient_accumulation_steps 4 \

--warmup_ratio 0.1 \

--mode glm \

--train_type ptuning \

--seed 1234 \

--ds_file ds_zero2_no_offload.json \

--gradient_checkpointing \

--show_loss_step 10 \

--pre_seq_len 16 \

--prefix_projection True \

--output_dir ./output-glm

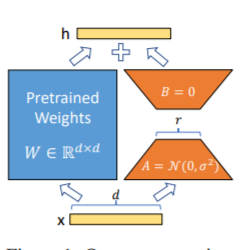

LoRA方法:低秩适应的高效微调

LoRA (Low-Rank Adaptation) 方法是一种在大型语言模型上并行增加额外低秩矩阵的微调技术。在训练过程中,仅训练这些新增的低秩矩阵参数。当"秩值"远小于原始参数维度时,新增的低秩矩阵参数量也就很小,从而实现高效微调。

实现LoRA方法的核心代码如下:

model = MODE[args.mode]["model"].from_pretrained(args.model_name_or_path)

lora_module_name = args.lora_module_name.split(",")

config = LoraConfig(r=args.lora_dim,

lora_alpha=args.lora_alpha,

target_modules=lora_module_name,

lora_dropout=args.lora_dropout,

bias="none",

task_type="CAUSAL_LM",

inference_mode=False,

)

model = get_peft_model(model, config)

model.config.torch_dtype = torch.float32

对于ChatGLM模型,单卡训练的命令示例如下:

CUDA_VISIBLE_DEVICES=0 deepspeed --master_port 520 train.py \

--train_path data/spo_0.json \

--model_name_or_path ChatGLM-6B \

--per_device_train_batch_size 1 \

--max_len 1560 \

--max_src_len 1024 \

--learning_rate 1e-4 \

--weight_decay 0.1 \

--num_train_epochs 2 \

--gradient_accumulation_steps 4 \

--warmup_ratio 0.1 \

--mode glm \

--train_type lora \

--lora_dim 16 \

--lora_alpha 64 \

--lora_dropout 0.1 \

--lora_module_name "query_key_value" \

--seed 1234 \

--ds_file ds_zero2_no_offload.json \

--gradient_checkpointing \

--show_loss_step 10 \

--output_dir ./output-glm

需要注意的是,LoRA方法在模型保存时仅保存了LoRA训练参数,因此在模型预测时需要将模型参数进行合并。

全参数训练方法:借助DeepSpeed实现大规模微调

全参数训练方法对大模型进行全量参数训练,主要借助DeepSpeed-Zero3方法对模型参数进行多卡分割,并利用Offload方法将优化器参数卸载到CPU上以解决显存不足的问题。

实现全参数训练的核心代码非常简单:

model = MODE[args.mode]["model"].from_pretrained(args.model_name_or_path)

对于ChatGLM模型,四卡训练的命令示例如下:

CUDA_VISIBLE_DEVICES=0,1,2,3 deepspeed --master_port 520 train.py \

--train_path data/spo_0.json \

--model_name_or_path ChatGLM-6B \

--per_device_train_batch_size 1 \

--max_len 1560 \

--max_src_len 1024 \

--learning_rate 1e-4 \

--weight_decay 0.1 \

--num_train_epochs 2 \

--gradient_accumulation_steps 4 \

--warmup_ratio 0.1 \

--mode glm \

--train_type all \

--seed 1234 \

--ds_file ds_zero3_offload.json \

--gradient_checkpointing \

--show_loss_step 10 \

--output_dir ./output-glm

显存占用分析

不同的微调方法和模型版本对显存的占用有显著差异。以下是一些典型配置的显存占用情况:

| 模型 | DeepSpeed-Stage | Offload | Gradient Checkpointing | Batch Size | Max Length | GPU数量 | 显存占用 |

|---|---|---|---|---|---|---|---|

| ChatGLM (Freeze) | zero2 | No | Yes | 1 | 1560 | 1 | 36G |

| ChatGLM2 (Freeze) | zero2 | No | Yes | 1 | 1560 | 1 | 35G |

| ChatGLM (P-Tuning) | zero2 | No | Yes | 1 | 768 | 1 | 43G |

| ChatGLM2 (P-Tuning) | zero2 | No | Yes | 1 | 1560 | 1 | 20G |

| ChatGLM (LoRA) | zero2 | No | Yes | 1 | 1560 | 1 | 20G |

| ChatGLM2 (LoRA) | zero2 | No | Yes | 1 | 1560 | 1 | 20G |

| ChatGLM (全参数) | zero3 | Yes | Yes | 1 | 1560 | 4 | 33G |

| ChatGLM2 (全参数) | zero3 | Yes | Yes | 1 | 1560 | 4 | 26G |

从上表可以看出,LoRA方法在保持较好性能的同时,显存占用最小。而全参数训练方法虽然能够充分发挥模型潜力,但对硬件要求较高。

结语

本文详细介绍了ChatGLM系列模型的多种微调技术,包括Freeze、P-Tuning、LoRA和全参数训练方法。每种方法都有其独特的优势和适用场景,开发者可以根据自己的硬件条件和任务需求选择合适的微调策略。

值得注意的是,虽然这些微调技术能够有效提升模型在特定任务上的性能,但在实际应用中仍需谨慎。特别是在处理敏感领域(如医疗、法律等)的任务时,必须对模型输出进行严格的验证和人工审核。

随着ChatGLM模型的不断更新和微调技术的持续发展,我们期待看到更多创新的应用场景和更高效的微调方法。开发者们可以基于本文提供的代码示例和指南,进一步探索和优化ChatGLM模型在各种下游任务中的表现。

最后,希望本文能为广大NLP从业者和研究人员提供有价值的参考,推动ChatGLM等大型语言模型在更多领域发挥其强大的能力。让我们共同期待人工智能技术带来的无限可能! 🚀🔬💡