GAN-MNIST:用生成对抗网络生成手写数字

生成对抗网络(Generative Adversarial Network, GAN)是近年来深度学习领域最具创新性的模型之一。它通过生成器和判别器的对抗训练,可以生成高质量的仿真数据。本文将介绍一个基于GAN的项目——GAN-MNIST,该项目旨在生成逼真的MNIST手写数字图像。

项目概述

GAN-MNIST是一个使用TensorFlow框架实现的GAN模型,用于生成MNIST数据集风格的手写数字图像。该项目的主要目标是:

- 实现一个能够生成高质量MNIST风格数字图像的GAN模型

- 展示GAN的工作原理和训练过程

- 探索GAN在图像生成任务中的应用

项目地址: https://github.com/ethanhe42/GAN-MNIST

MNIST数据集简介

MNIST是一个广泛使用的手写数字图像数据集,包含60,000张训练图像和10,000张测试图像。每张图像是一个28x28像素的灰度图,对应0-9中的一个数字。MNIST数据集被广泛用于机器学习算法的测试和基准对比。

GAN模型原理

GAN模型包含两个核心组件:生成器(Generator)和判别器(Discriminator)。它们通过对抗学习的方式进行训练:

- 生成器: 尝试生成逼真的假样本,目标是骗过判别器

- 判别器: 尝试区分真实样本和生成的假样本

通过不断的对抗训练,生成器逐渐学会生成高质量的假样本,而判别器则提高了区分能力。最终,生成器可以产生与真实数据分布相似的样本。

项目实现

GAN-MNIST项目的核心代码包括以下几个部分:

- 数据预处理

- 生成器网络定义

- 判别器网络定义

- 损失函数和优化器设置

- 训练循环

- 结果可视化

下面我们来详细介绍每个部分的实现。

1. 数据预处理

首先我们需要加载MNIST数据集并进行预处理:

from tensorflow.examples.tutorials.mnist import input_data

mnist = input_data.read_data_sets('MNIST_data', one_hot=True)

def get_batch(batch_size):

batch_x, _ = mnist.train.next_batch(batch_size)

batch_x = batch_x.reshape((batch_size, 28, 28, 1))

return batch_x

这段代码从TensorFlow的示例中加载MNIST数据,并定义了一个获取批次数据的函数。

2. 生成器网络定义

生成器网络负责将随机噪声转换为手写数字图像:

def generator(z, reuse=False):

with tf.variable_scope('generator', reuse=reuse):

h1 = tf.layers.dense(z, 7*7*256, activation=tf.nn.relu)

h1 = tf.reshape(h1, [-1, 7, 7, 256])

h2 = tf.layers.conv2d_transpose(h1, 128, 5, strides=2, padding='same', activation=tf.nn.relu)

h3 = tf.layers.conv2d_transpose(h2, 64, 5, strides=2, padding='same', activation=tf.nn.relu)

out = tf.layers.conv2d_transpose(h3, 1, 5, strides=1, padding='same', activation=tf.nn.tanh)

return out

生成器使用了全连接层和转置卷积层,逐步将低维噪声上采样为28x28的图像。

3. 判别器网络定义

判别器网络负责区分真实图像和生成的图像:

def discriminator(x, reuse=False):

with tf.variable_scope('discriminator', reuse=reuse):

h1 = tf.layers.conv2d(x, 64, 5, strides=2, padding='same', activation=tf.nn.leaky_relu)

h2 = tf.layers.conv2d(h1, 128, 5, strides=2, padding='same', activation=tf.nn.leaky_relu)

h3 = tf.layers.flatten(h2)

h4 = tf.layers.dense(h3, 1024, activation=tf.nn.leaky_relu)

out = tf.layers.dense(h4, 1)

return out

判别器使用了卷积层和全连接层,最终输出一个标量值表示真实程度。

4. 损失函数和优化器设置

GAN的损失函数设置如下:

# 生成器损失

g_loss = tf.reduce_mean(tf.nn.sigmoid_cross_entropy_with_logits(

logits=discriminator(generator(z), reuse=True), labels=tf.ones_like(discriminator(generator(z)))

))

# 判别器损失

d_loss_real = tf.reduce_mean(tf.nn.sigmoid_cross_entropy_with_logits(

logits=discriminator(x), labels=tf.ones_like(discriminator(x)))

)

d_loss_fake = tf.reduce_mean(tf.nn.sigmoid_cross_entropy_with_logits(

logits=discriminator(generator(z), reuse=True), labels=tf.zeros_like(discriminator(generator(z)))

))

d_loss = d_loss_real + d_loss_fake

# 优化器

g_optimizer = tf.train.AdamOptimizer(learning_rate=0.0002, beta1=0.5)

d_optimizer = tf.train.AdamOptimizer(learning_rate=0.0002, beta1=0.5)

这里使用了交叉熵损失函数和Adam优化器。

5. 训练循环

GAN的训练过程如下:

for epoch in range(num_epochs):

for i in range(mnist.train.num_examples // batch_size):

batch_x = get_batch(batch_size)

batch_z = np.random.uniform(-1, 1, [batch_size, z_dim])

# 训练判别器

_, d_loss_curr = sess.run([d_train, d_loss], feed_dict={x: batch_x, z: batch_z})

# 训练生成器

_, g_loss_curr = sess.run([g_train, g_loss], feed_dict={z: batch_z})

# 输出训练进度

print(f'Epoch [{epoch+1}/{num_epochs}], d_loss: {d_loss_curr:.4f}, g_loss: {g_loss_curr:.4f}')

# 可视化生成的图像

if (epoch + 1) % 10 == 0:

samples = sess.run(generator(z, reuse=True), feed_dict={z: sample_z})

fig, axes = plt.subplots(nrows=4, ncols=4, figsize=(4, 4), sharey=True, sharex=True)

for ax, img in zip(axes.flatten(), samples):

ax.xaxis.set_visible(False)

ax.yaxis.set_visible(False)

ax.imshow(img.reshape((28,28)), cmap='Greys_r')

plt.show()

在每个epoch中,我们先训练判别器,再训练生成器。每隔一定轮数,我们会可视化生成的图像来观察训练效果。

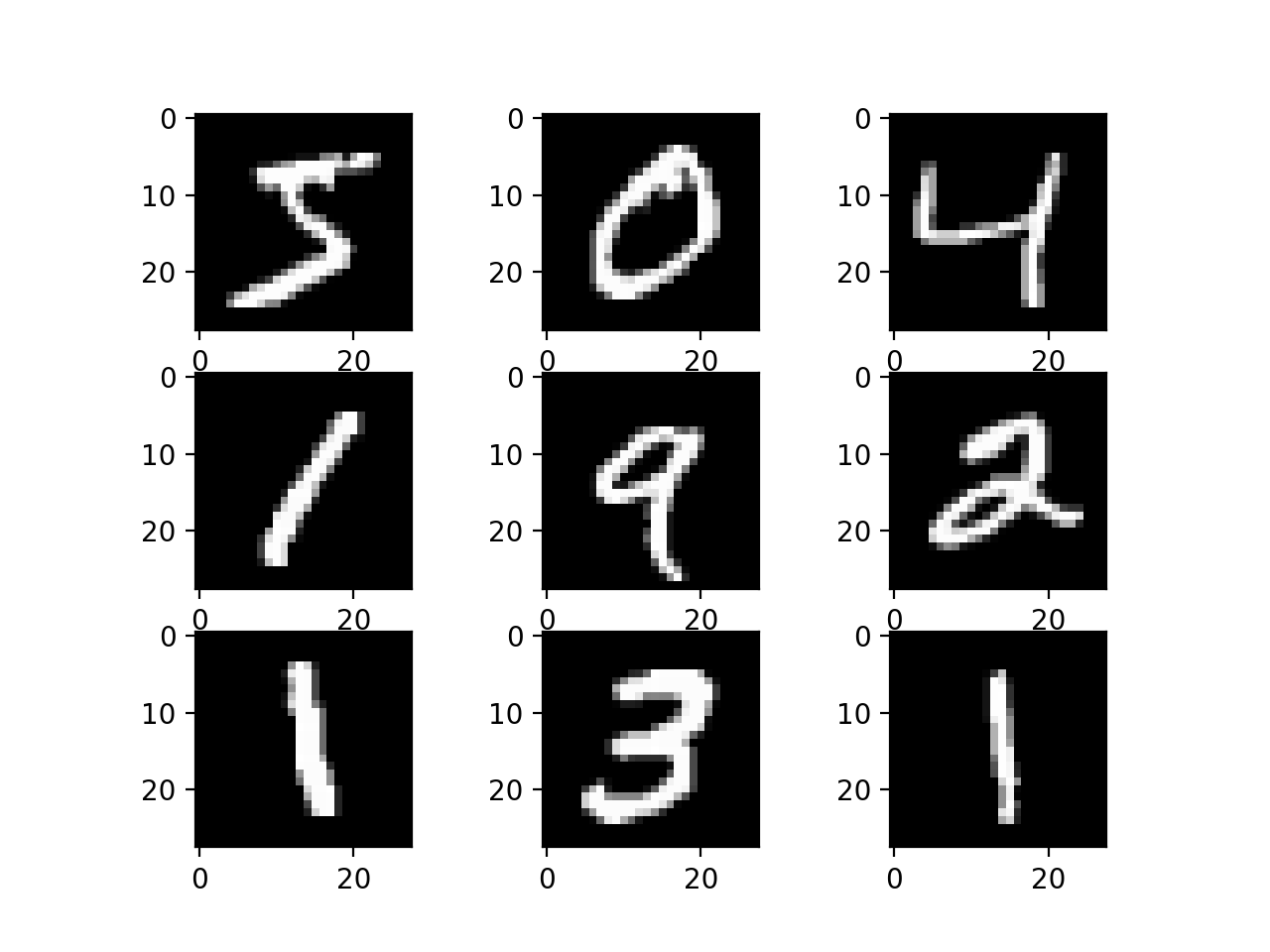

训练结果

通过多轮训练,GAN-MNIST模型能够生成高质量的手写数字图像。以下是训练过程中不同阶段的生成结果:

从左到右,我们可以看到生成图像的质量逐渐提高,最终生成的图像与真实的MNIST数字非常相似。

项目优势与应用

GAN-MNIST项目具有以下优势:

- 实现简单: 使用TensorFlow框架,代码结构清晰,易于理解和修改

- 训练快速: 在普通GPU上即可在短时间内完成训练

- 效果显著: 能够生成高质量的手写数字图像

该项目的潜在应用包括:

- 数据增强: 生成更多的手写数字样本,用于扩充训练数据集

- 风格迁移: 将其他数字数据集转换为MNIST风格

- 图像修复: 用于修复或重建损坏的手写数字图像

结论

GAN-MNIST项目展示了生成对抗网络在图像生成任务中的强大能力。通过对抗训练,模型成功学习了MNIST数据集的分布,能够生成逼真的手写数字图像。这个项目不仅是学习GAN原理的良好实践,也为更复杂的图像生成任务提供了基础。

未来的改进方向可以包括:

- 尝试不同的网络架构,如DCGAN或WGAN

- 加入条件信息,实现可控的数字生成

- 扩展到更复杂的数据集,如彩色图像或高分辨率图像

通过不断的探索和改进,GAN技术必将在图像生成、图像编辑等领域发挥更大的作用。

参考资料

- Goodfellow, I., et al. (2014). Generative Adversarial Nets. In Advances in Neural Information Processing Systems.

- Radford, A., Metz, L., & Chintala, S. (2015). Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks. arXiv preprint arXiv:1511.06434.

- TensorFlow MNIST Tutorial: https://www.tensorflow.org/tutorials/quickstart/beginner