OpenFedLLM:联邦学习赋能大语言模型隐私保护训练

在人工智能蓬勃发展的今天,大语言模型(Large Language Models, LLMs)已经成为了技术前沿的焦点。然而,随着公开数据的逐渐枯竭,如何利用分散在各方的私有数据来训练更强大的语言模型成为了一个迫切需要解决的问题。OpenFedLLM项目应运而生,为这一挑战提供了创新性的解决方案。

OpenFedLLM:开创性的联邦学习框架

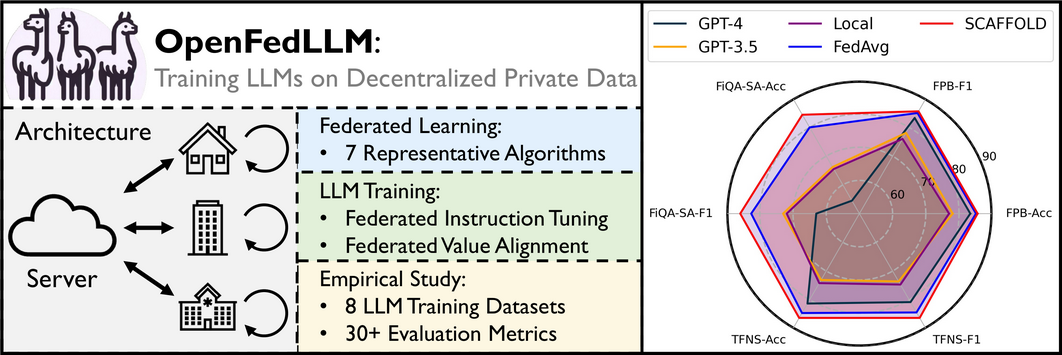

OpenFedLLM是一个开源的研究代码库,旨在通过联邦学习(Federated Learning, FL)的方式在分散的私有数据上训练大语言模型。该项目由一群来自学术界和工业界的研究人员共同开发,为解决数据隐私和合规性问题提供了新的思路。

OpenFedLLM的核心理念是利用联邦学习的分布式特性,让参与方能够在不直接共享原始数据的情况下协作训练模型。这种方法不仅保护了数据隐私,还能充分利用分散在各方的大量高质量私有数据,从而推动大语言模型的进一步发展。

丰富的功能与灵活的设计

OpenFedLLM集成了多项先进特性,使其成为一个功能强大且灵活的研究平台:

-

多样化的联邦学习算法: 项目实现了7种主流的联邦学习算法,包括FedAvg、FedProx、SCAFFOLD和FedAvgM等。研究人员可以轻松比较不同算法的性能,并针对特定场景选择最佳方案。

-

先进的LLM训练方法: OpenFedLLM支持两种关键的LLM训练算法 - 指令微调(SFT)和价值对齐(DPO)。这使得研究人员能够探索如何在联邦学习环境下改进模型的指令遵循能力和对齐人类价值观。

-

全面的评估指标: 项目提供了30多种评估指标,涵盖了通用能力、医疗问答、金融问答、代码生成和数学解题等多个领域。这些指标可以全面衡量模型在不同任务上的表现。

-

模块化设计: OpenFedLLM采用了高度模块化的设计,将联邦学习和LLM训练的实现解耦。这不仅降低了工程复杂度,还方便了两个领域研究人员的独立贡献。

-

资源友好型: 通过量化技术和参数高效微调等方法,OpenFedLLM大大降低了硬件要求。研究人员甚至可以在单张消费级GPU(如NVIDIA 3090)上进行实验,这极大地提高了项目的可访问性。

快速上手与实践

对于想要尝试OpenFedLLM的研究人员和开发者,项目提供了详细的安装和使用指南。以下是一个简单的步骤概览:

- 克隆仓库并安装依赖:

git clone --recursive --shallow-submodules https://github.com/rui-ye/OpenFedLLM.git

cd OpenFedLLM

conda create -n fedllm python=3.10

conda activate fedllm

pip install -r requirements.txt

source setup.sh

- 运行联邦指令微调实验:

CUDA_VISIBLE_DEVICES=1 python main_sft.py \

--model_name_or_path "meta-llama/Llama-2-7b-hf" \

--dataset_name "vicgalle/alpaca-gpt4" \

--dataset_sample 20000 \

--fed_alg "fedavg" \

--num_clients 20 \

--sample_clients 2 \

--max_steps 10 \

--num_rounds 200 \

--batch_size 16 \

--gradient_accumulation_steps 1 \

--seq_length 512 \

--peft_lora_r 32 \

--peft_lora_alpha 64 \

--use_peft \

--load_in_8bit \

--output_dir "./output" \

--template "alpaca"

这个示例展示了如何使用FedAvg算法在Alpaca-GPT4数据集上对Llama-2-7b模型进行联邦指令微调。用户可以根据需要调整参数,如模型大小、数据集、联邦学习算法等。

OpenFedLLM的实际应用与性能

OpenFedLLM不仅仅是一个理论框架,其在实际应用中也展现出了令人瞩目的性能。以金融情感分析为例,研究人员使用FinGPT数据集进行了一系列实验,结果表明:

- 联邦学习方法(如FedAvg)显著优于本地训练,平均提升了11.5%的性能。

- 某些联邦学习算法(如SCAFFOLD、FedAvgM和FedAdaGrad)在金融领域表现尤为出色。

- 最令人惊喜的是,联邦学习训练的模型在某些任务上甚至超越了GPT-4的表现。

这些结果充分说明了OpenFedLLM的潜力,它不仅能够保护数据隐私,还能够通过协作训练达到甚至超越中心化训练的效果。

未来展望与挑战

尽管OpenFedLLM已经取得了显著的成果,但在联邦学习和大语言模型结合的道路上仍然存在诸多挑战和机遇:

-

异构偏好问题: 在联邦价值对齐中,不同参与方可能有着各自独特的文化、伦理和情境价值观。如何在训练共享模型的同时协调这些差异是一个复杂的问题。

-

个性化联邦学习: 如何在提升模型通用能力的同时,满足每个参与方对特定领域(如金融问答)的需求,是一个值得探索的方向。

-

隐私保护增强: 虽然联邦学习本身就具有一定的隐私保护性,但大语言模型强大的记忆能力可能会带来新的隐私风险。如何在保证模型效果的同时进一步加强隐私保护是一个重要课题。

-

效率优化: 考虑到大语言模型的规模,如何提高联邦学习过程中的训练效率和通信效率是亟待解决的问题。

OpenFedLLM为这些挑战提供了一个理想的研究平台。研究人员可以基于此框架开发新的算法、探索创新的应用场景,推动联邦学习和大语言模型两个领域的共同发展。

结语

OpenFedLLM的出现无疑为大语言模型的发展注入了新的活力。它不仅解决了数据隐私和合规性的问题,还为充分利用分散的私有数据提供了可能。随着更多研究者和开发者的加入,我们有理由相信,OpenFedLLM将成为推动AI技术向更加开放、安全和高效方向发展的重要力量。

对于有志于探索这一前沿领域的研究人员和开发者,OpenFedLLM无疑是一个值得深入研究的项目。无论您是对联邦学习感兴趣,还是专注于大语言模型的开发,OpenFedLLM都为您提供了一个理想的起点。让我们共同期待OpenFedLLM在未来带来更多突破性的成果,为人工智能的发展贡献力量。