深度学习模型的生产部署实践指南

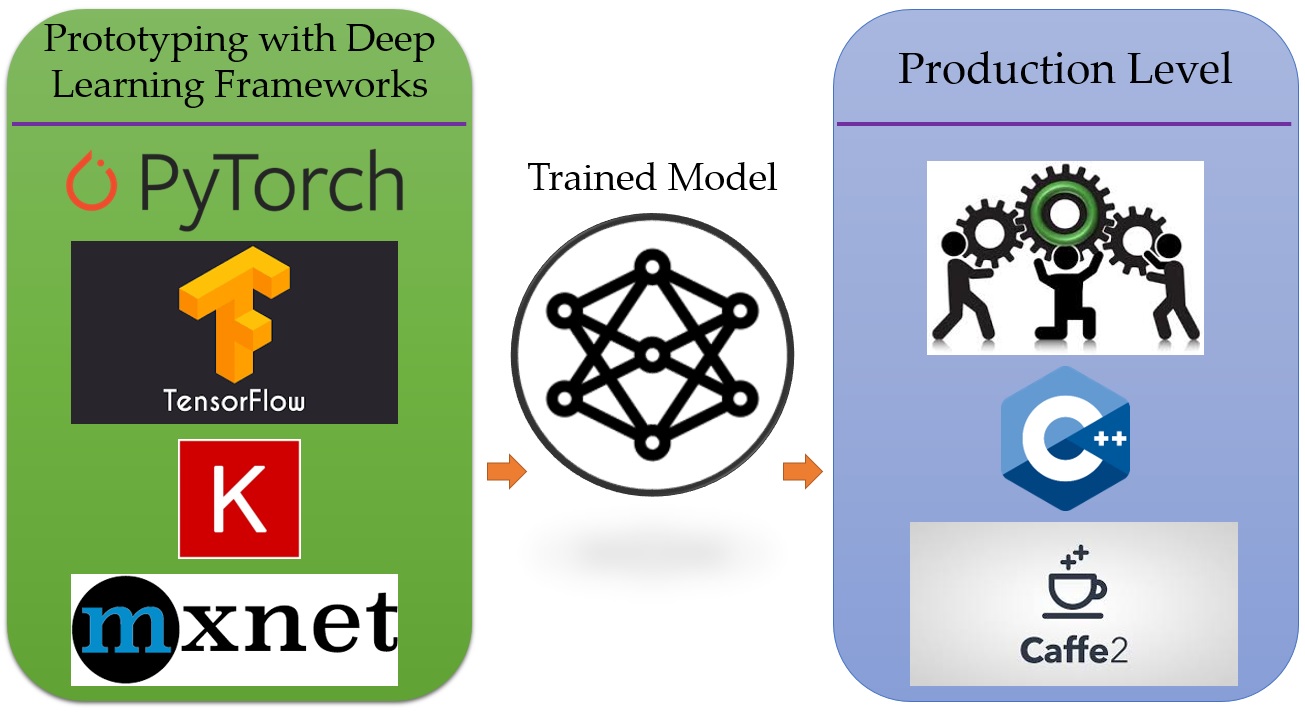

随着人工智能技术的快速发展,如何将训练好的深度学习模型高效地部署到生产环境中,已经成为AI工程师面临的一大挑战。本文将全面介绍深度学习模型生产部署的最佳实践和关键技术,为读者提供实用的指导。

模型转换与优化

将深度学习模型部署到生产环境的第一步是进行模型转换和优化。不同的深度学习框架(如PyTorch、TensorFlow等)都有各自的模型格式,需要进行适当的转换才能在生产环境中使用。

PyTorch模型转换

PyTorch是目前最流行的深度学习框架之一,其模型转换主要有以下几种方式:

-

使用TorchScript进行即时编译(JIT),将PyTorch模型转换为可以脱离Python环境独立运行的格式。

-

使用ONNX(开放神经网络交换)格式,可以实现PyTorch模型到其他框架的转换。

-

使用C++ API直接加载PyTorch模型,适合对性能要求极高的场景。

PyTorch官方提供了详细的生产级教程,可以作为很好的参考。

TensorFlow模型转换

TensorFlow模型的部署同样有多种选择:

-

使用TensorFlow Serving,这是Google官方推荐的TensorFlow模型服务框架。

-

将模型转换为TensorFlow Lite格式,适合在移动和嵌入式设备上部署。

-

使用TensorFlow.js将模型部署到Web浏览器中运行。

此外,TensorFlow还提供了模型优化工具包,可以对模型进行量化、剪枝等优化操作,以提高inference性能。

模型服务部署

模型转换完成后,下一步就是将其部署为可以提供预测服务的形式。常见的部署方式包括:

-

使用Flask等轻量级Web框架,快速构建RESTful API。

-

使用专门的模型服务框架,如TorchServe、TensorFlow Serving等。

-

使用Kubernetes等容器编排平台,实现大规模分布式部署。

-

使用Serverless架构,如AWS Lambda,实现按需自动扩展。

在选择部署方式时,需要根据具体的业务需求、性能要求和基础设施情况来权衡。

性能优化

模型部署到生产环境后,性能优化是一个持续的过程。主要的优化方向包括:

-

模型压缩:通过量化、剪枝等技术减小模型大小,提高inference速度。

-

硬件加速:利用GPU、TPU等专用硬件加速inference。

-

批处理:合理设置batch size,提高吞吐量。

-

缓存优化:对热点数据进行缓存,减少重复计算。

-

分布式部署:利用多机多卡并行处理,提高系统整体性能。

NVIDIA提供的TensorRT是一个强大的深度学习inference优化器和运行时环境,可以显著提升GPU上的inference性能。

监控与运维

将模型部署到生产环境后,还需要建立完善的监控和运维体系:

-

使用Prometheus等工具监控模型服务的各项指标。

-

建立日志分析系统,及时发现和定位问题。

-

实现模型的热更新,支持在线升级。

-

建立A/B测试框架,评估新模型的效果。

-

制定应急预案,确保服务的高可用性。

结语

深度学习模型的生产部署是一个复杂的工程问题,涉及模型优化、服务部署、性能调优、监控运维等多个方面。随着MLOps实践的不断发展,相关的工具和最佳实践也在不断完善。工程师们需要持续学习和实践,才能构建出高效可靠的AI生产系统。

在实际项目中,我们还需要根据具体的业务场景和技术栈来选择最适合的部署方案。希望本文能为读者提供一些有价值的参考和启发。如果您对深度学习模型部署还有任何疑问,欢迎在评论区留言讨论。