SAM-HQ简介

SAM-HQ(Segment Anything in High Quality)是由ETH Zurich和HKUST的研究人员在2023年提出的一个高质量零样本分割模型。它在原有SAM模型的基础上进行了改进,旨在解决SAM在处理复杂结构物体时分割质量不佳的问题。

SAM-HQ的主要创新点包括:

- 引入了可学习的高质量输出令牌(High-Quality Output Token),注入到SAM的mask解码器中。

- 将mask解码器特征与早期和最终的ViT特征进行融合,以获得更精细的mask细节。

- 仅使用44K张精细标注的mask进行训练,耗时4小时即可完成。

- 保持了SAM的原有优势,如灵活的提示方式、高效率和零样本泛化能力。

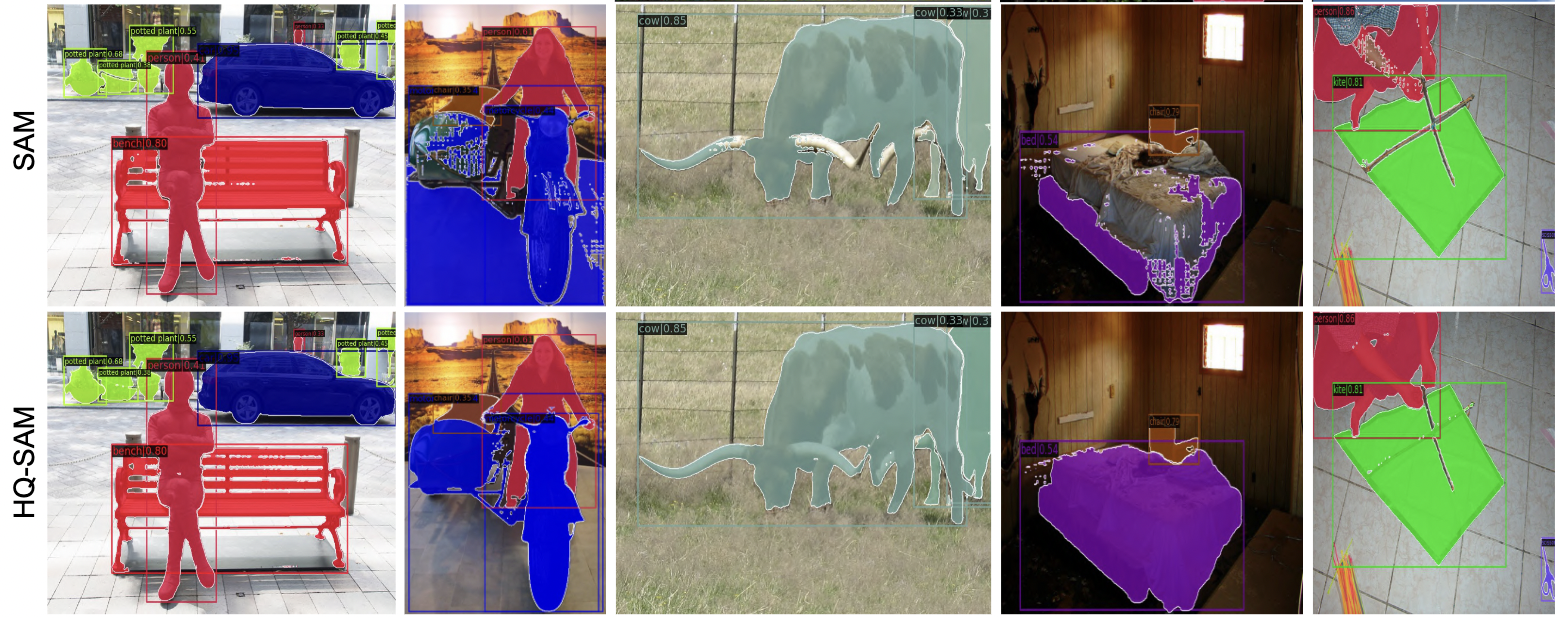

通过这些改进,SAM-HQ能够更准确地分割任何物体,尤其是在处理具有复杂结构的对象时表现出色。

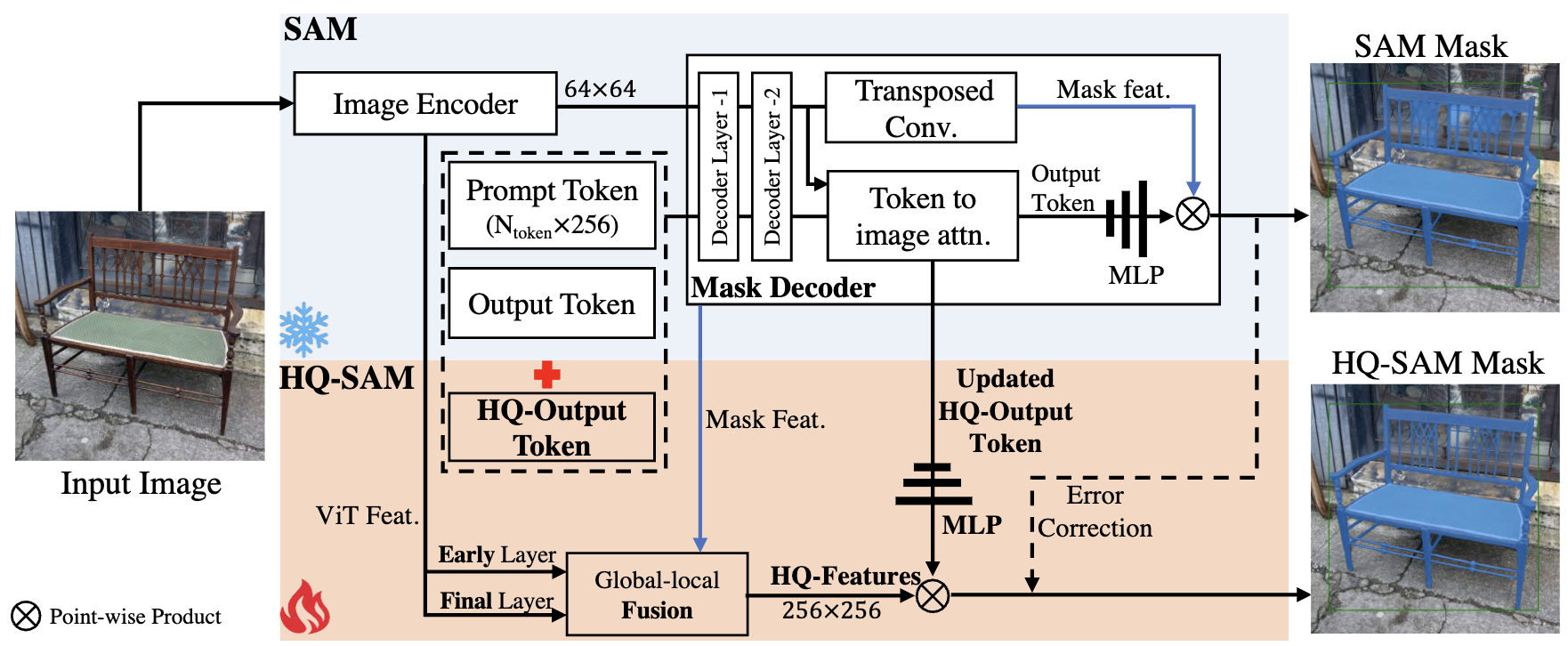

SAM-HQ的技术原理

1. 高质量输出令牌

SAM-HQ的核心创新是引入了一个可学习的高质量输出令牌。这个令牌被注入到SAM的mask解码器中,负责预测高质量的mask。与直接在mask解码器特征上应用不同,SAM-HQ首先将这些特征与早期和最终的ViT特征进行融合,从而获得更丰富的mask细节。

2. 特征融合

SAM-HQ采用了一种巧妙的特征融合策略。它不仅利用了mask解码器的特征,还融合了来自视觉transformer(ViT)的早期和最终特征。这种多层次的特征融合使得模型能够捕捉到更多的细节信息,从而生成更精确的分割mask。

3. 轻量级设计

尽管引入了新的组件,SAM-HQ的设计仍然保持了轻量级。它复用并保留了SAM的预训练模型权重,只引入了少量的额外参数和计算。这种设计使得SAM-HQ能够在保持高效性的同时,显著提升分割质量。

4. 高效训练策略

SAM-HQ的训练数据集由来自多个来源的44K张精细标注的mask组成。尽管数据量相对较小,但通过精心设计的训练策略,SAM-HQ仅需4小时在8个GPU上即可完成训练。这种高效的训练方式大大降低了模型的开发和部署成本。

SAM-HQ与SAM的性能对比

为了直观地展示SAM-HQ的优势,研究人员进行了详细的性能对比实验。以下是SAM-HQ与原始SAM在多个数据集和任务上的表现对比:

1. COCO数据集上的表现

在COCO数据集上,SAM-HQ在各种ViT backbone下都显著优于SAM:

- ViT-B: SAM-HQ的AP达到38.9,比SAM提高了1.4个点。

- ViT-L: SAM-HQ的AP达到44.3,比SAM提高了1.7个点。

- ViT-H: SAM-HQ的AP达到46.3,比SAM提高了1.6个点。

这些结果表明,无论是在小型还是大型模型上,SAM-HQ都能带来显著的性能提升。

2. 视频分割任务

在YTVIS和HQ-YTVIS视频分割数据集上,SAM-HQ同样表现出色:

- YTVIS: SAM-HQ的AP达到44.6,比SAM高2.0个点。

- HQ-YTVIS: SAM-HQ的AP达到44.7,比SAM高2.3个点。

这说明SAM-HQ在处理视频序列时也具有优势,能够生成更连贯和精确的分割结果。

3. DAVIS数据集

在DAVIS数据集上,SAM-HQ在多个指标上都优于SAM:

- J&F Mean: SAM-HQ达到78.8,比SAM高1.8个点。

- J Mean: SAM-HQ达到76.1,比SAM高1.7个点。

- F Mean: SAM-HQ达到81.5,比SAM高1.9个点。

这些结果进一步证明了SAM-HQ在处理复杂场景和动态物体时的优越性。

SAM-HQ的应用前景

SAM-HQ的出色性能为许多计算机视觉任务带来了新的可能性:

-

自动驾驶: SAM-HQ可以更精确地分割道路、行人和其他车辆,提高自动驾驶系统的安全性。

-

医疗图像分析: 在医疗领域,SAM-HQ可以帮助更准确地分割器官、肿瘤等复杂结构,辅助医生进行诊断。

-

增强现实(AR): SAM-HQ可以为AR应用提供更精确的物体分割,实现更自然的虚拟物体插入。

-

视频编辑: 在视频后期制作中,SAM-HQ可以帮助实现更精细的物体追踪和分割,提高特效质量。

-

遥感图像分析: SAM-HQ在处理复杂地形和建筑时表现出色,可以应用于卫星图像分析和城市规划。

-

工业检测: 在制造业中,SAM-HQ可以用于精确检测产品缺陷,提高质量控制的效率。

SAM-HQ的使用方法

SAM-HQ的使用非常简便,与原始SAM模型类似。以下是使用SAM-HQ的基本步骤:

- 安装SAM-HQ:

pip install segment-anything-hq

- 加载模型:

from segment_anything_hq import sam_model_registry

model_type = "vit_h" # 可选 vit_l, vit_b, vit_h, vit_tiny

sam_checkpoint = "path/to/sam_hq_vit_h.pth"

sam = sam_model_registry[model_type](checkpoint=sam_checkpoint)

- 使用模型进行预测:

from segment_anything import SamPredictor

predictor = SamPredictor(sam)

predictor.set_image(your_image)

masks, _, _ = predictor.predict(input_prompts)

SAM-HQ支持多种提示方式,包括点、框和文本提示,使用灵活方便。

SAM-HQ的未来发展

尽管SAM-HQ已经取得了显著的进展,但研究人员仍在不断探索其潜力和改进方向:

-

更高效的backbone: 研究人员正在开发更轻量级的backbone,如Light HQ-SAM,以实现更快的推理速度。

-

多模态集成: 未来可能会探索将SAM-HQ与语言模型、3D模型等结合,实现更智能的场景理解。

-

领域特定优化: 针对医疗、遥感等特定领域,可能会开发专门优化的SAM-HQ版本。

-

实时应用: 进一步优化SAM-HQ的推理速度,使其能够在实时应用中发挥作用。

-

自监督学习: 探索使用更大规模的无标注数据来进一步提升SAM-HQ的性能。

结论

SAM-HQ代表了计算机视觉领域零样本分割任务的最新进展。通过巧妙的设计和高效的训练策略,SAM-HQ在保持SAM原有优势的同时,显著提升了分割质量。这一突破为众多应用领域带来了新的可能性,也为未来的研究指明了方向。随着技术的不断发展,我们有理由相信,SAM-HQ将在计算机视觉领域发挥越来越重要的作用,推动人工智能技术在更多领域的应用和创新。