Stable Diffusion多用户系统简介

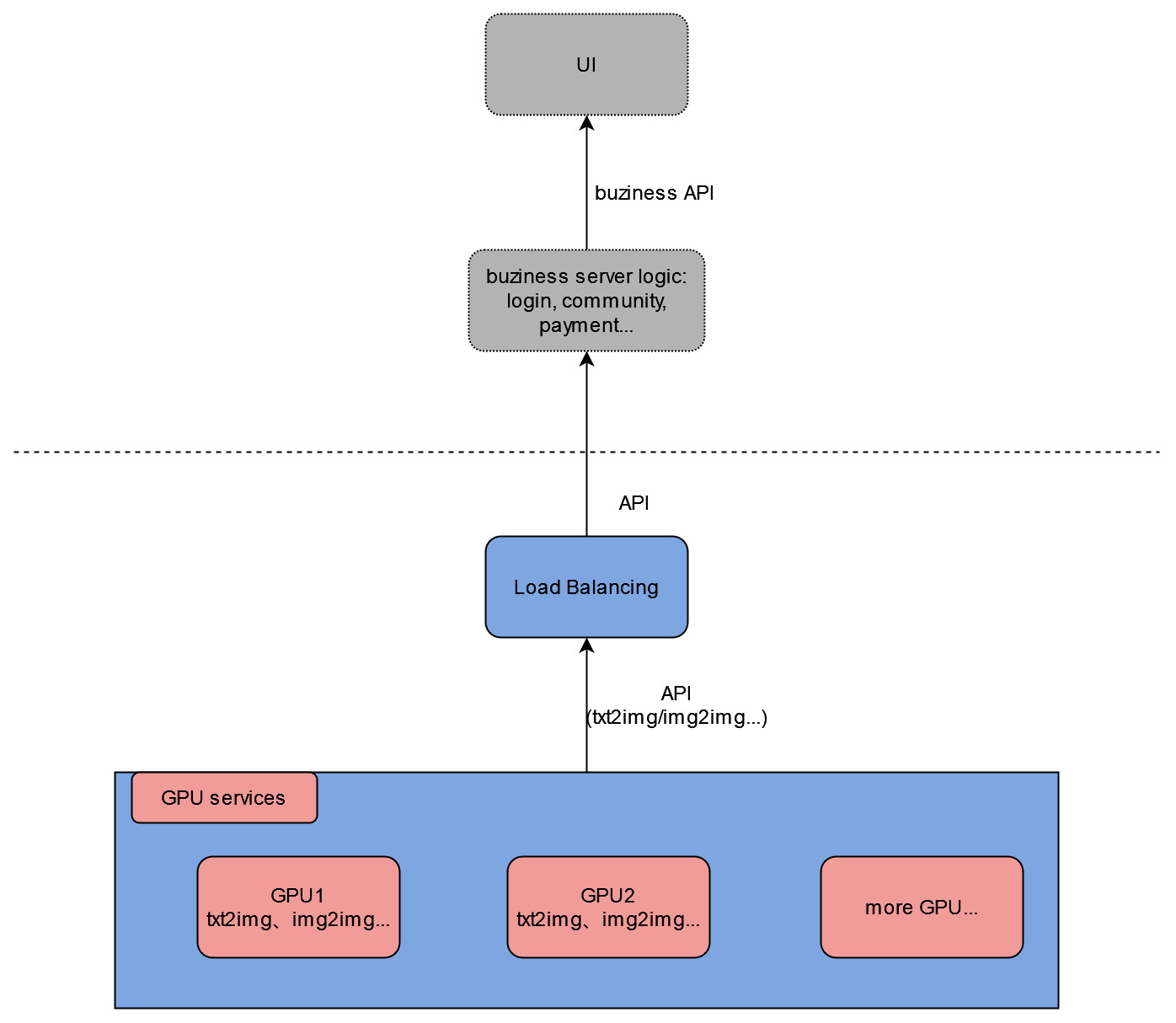

Stable Diffusion作为一款强大的AI绘图工具,受到了越来越多用户的青睐。然而,如何高效地为多个用户提供Stable Diffusion服务,一直是困扰许多开发者和企业的问题。本文将详细介绍一个名为stable-diffusion-multi-user的开源项目,该项目提供了一套完整的解决方案,可以轻松部署支持多用户的Stable Diffusion系统。

主要特性

stable-diffusion-multi-user项目具有以下主要特性:

- 提供完整的HTTP API,支持txt2img、img2img等核心功能

- 支持Civitai模型和LoRA等扩展

- 多用户排队功能

- 用户可单独切换模型,互不影响

- 负载均衡功能,可在多个GPU服务器间自动分配任务

- 支持在单GPU卡上部署多个Stable Diffusion模型

- 支持自动扩展,可根据需求自动增减计算资源

有了这些功能,开发者可以轻松构建自己的UI界面、社区功能、账户登录和支付系统等。

部署方式概述

stable-diffusion-multi-user项目提供了三种部署方式,以适应不同的需求:

- Django API部署:适合自有服务器的情况

- Runpod Serverless部署:适合需要自动扩展的场景

- Replicate部署:适合快速验证和小规模使用

接下来,我们将详细介绍这三种部署方式。

Django API部署

Django API部署是最基础的部署方式,适合有自有服务器资源的用户。这种方式允许用户对系统进行最大程度的定制。

项目结构

项目主要分为两部分:

- Django服务器代码

- stable-diffusion-webui代码(用于初始化和运行模型)

主要目录结构如下:

modules/: stable-diffusion-webui模块models/: Stable Diffusion模型文件sd_multi/: Django项目主目录simple/: 主要的Django代码requirements.txt: pip依赖文件setup.sh: 环境设置脚本gen_http_conf.py: Apache配置生成脚本

GPU服务器部署步骤

- SSH连接到GPU服务器

- 克隆或下载项目仓库

- 进入项目主目录(包含

manage.py的目录) - 运行

sudo bash setup.sh并选择合适的选项(建议按env,venv,sd_model,apache的顺序) - 重启Apache:

sudo service apache2 restart

API定义

/: 主页,用于测试Apache配置是否成功/txt2img_v2/: 文本生成图像API,支持与sd-webui相同的参数/img2img_v2/: 图像生成图像API,支持与sd-webui相同的参数

这两个API都支持扩展参数,如ControlNet等。

负载均衡服务器部署

为了实现多GPU服务器之间的负载均衡,需要部署一个负载均衡服务器:

- SSH连接到一台CPU服务器

- 克隆或下载项目仓库

- 进入项目主目录

- 运行

sudo bash setup.sh lb - 执行

mv sd_multi/urls.py sd_multi/urls1.py && mv sd_multi/urls_lb.py sd_multi/urls.py - 在

simple/lb_views.py中修改ip_list变量,填入你的GPU服务器IP和端口 - 重启Apache:

sudo service apache2 restart

部署完成后,可以通过访问ip+port/multi_demo/路径来测试负载均衡功能。

Runpod Serverless部署

Runpod Serverless部署方式适合需要自动扩展功能的用户。这种方式具有以下特点:

- 支持高度自定义的扩展策略

- 支持sd-webui检查点、LoRA等功能

- Docker镜像与模型文件分离,方便随时上传和替换模型

详细的部署指南和现成的Docker镜像可以在项目的sd-docker-slim目录中找到。

Replicate部署

Replicate部署是最快速和简单的部署方式,特别适合想要快速验证或小规模使用的场景。

特点

- 自动扩展

- 使用最新的sd-webui源代码和最新版本的PyTorch和CUDA

- 支持带扩展的sd-webui API

- 支持sd-webui检查点、LoRA等功能

部署步骤

- 在Replicate上创建一个模型

- 准备一台至少50GB磁盘空间的Linux GPU机器

- 克隆项目仓库:

git clone https://github.com/wolverinn/stable-diffusion-multi-user.git cd stable-diffusion-multi-user/replicate-cog-slim/ - 修改

replicate-cog-slim/cog.yaml文件中的第30行,将其改为你自己的Replicate模型 - (可选)修改

replicate-cog-slim/predicy.py文件中的predict()函数,以自定义API输入和输出 - 安装cog工具

- 安装Docker

- 下载你想部署的检查点/LoRA/扩展/其他模型到

replicate-cog-slim/的相应目录下 - 运行相关命令完成部署

部署完成后,你就可以在Replicate上看到你的模型,并通过API或Replicate网站使用它。

结语

通过stable-diffusion-multi-user项目,我们可以轻松地部署一个支持多用户的Stable Diffusion系统。无论是使用自有服务器、需要自动扩展,还是想要快速验证,项目都提供了相应的解决方案。这为开发者和企业提供了极大的灵活性,使得构建自己的AI绘图服务变得更加简单和高效。

随着AI技术的不断发展,类似的多用户AI服务部署需求将会越来越多。掌握这些部署技能,不仅可以为Stable Diffusion搭建多用户系统,也为未来部署其他AI服务奠定了基础。希望本文能够帮助读者更好地理解和使用stable-diffusion-multi-user项目,开启AI服务部署的新篇章。