Android上的TensorFlow MNIST手写数字识别应用

在移动设备上运行机器学习模型一直是AI领域的热门话题。本文将介绍如何在Android设备上使用TensorFlow实现MNIST手写数字识别,这是一个经典的机器学习入门项目。通过这个实例,读者可以了解到机器学习模型如何在移动端部署和应用。

项目背景

MNIST是一个手写数字数据集,包含60,000个训练样本和10,000个测试样本。每个样本是一个28x28像素的灰度图像,对应一个0-9之间的数字标签。MNIST常被用作机器学习算法的基准测试。

本项目的目标是在Android设备上实现一个应用,让用户在屏幕上手写数字,然后用预先训练好的TensorFlow模型对其进行识别。这不仅展示了机器学习的实际应用,也体现了移动设备上运行复杂模型的可能性。

模型训练

模型训练是在PC上使用TensorFlow完成的。主要步骤包括:

- 准备MNIST数据集

- 设计神经网络结构

- 定义损失函数和优化器

- 训练模型

- 评估模型性能

- 导出模型为.pb文件

训练代码示例:

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

# 加载MNIST数据

mnist = input_data.read_data_sets("MNIST_data/", one_hot=True)

# 定义网络结构

x = tf.placeholder(tf.float32, [None, 784])

W = tf.Variable(tf.zeros([784, 10]))

b = tf.Variable(tf.zeros([10]))

y = tf.nn.softmax(tf.matmul(x, W) + b)

# 定义损失函数和优化器

y_ = tf.placeholder(tf.float32, [None, 10])

cross_entropy = tf.reduce_mean(-tf.reduce_sum(y_ * tf.log(y), reduction_indices=[1]))

train_step = tf.train.GradientDescentOptimizer(0.5).minimize(cross_entropy)

# 训练模型

sess = tf.InteractiveSession()

tf.global_variables_initializer().run()

for _ in range(1000):

batch_xs, batch_ys = mnist.train.next_batch(100)

sess.run(train_step, feed_dict={x: batch_xs, y_: batch_ys})

# 评估模型

correct_prediction = tf.equal(tf.argmax(y,1), tf.argmax(y_,1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32))

print(sess.run(accuracy, feed_dict={x: mnist.test.images, y_: mnist.test.labels}))

# 保存模型

tf.train.write_graph(sess.graph_def, '.', 'mnist_model.pb', as_text=False)

Android应用开发

Android应用的开发主要包括以下几个部分:

- 界面设计:创建一个可以让用户手写数字的画布。

- 图像处理:将用户绘制的图像转换为28x28的灰度图像,以符合MNIST数据集的格式。

- TensorFlow集成:导入训练好的模型,并使用TensorFlow Lite进行推理。

- 结果展示:显示识别结果及置信度。

关键代码示例:

// 初始化TensorFlow Lite

private static final String MODEL_PATH = "mnist_model.tflite";

private Interpreter tflite;

private void initializeTensorFlow() {

try {

tflite = new Interpreter(loadModelFile());

} catch (Exception e) {

e.printStackTrace();

}

}

private MappedByteBuffer loadModelFile() throws IOException {

AssetFileDescriptor fileDescriptor = getAssets().openFd(MODEL_PATH);

FileInputStream inputStream = new FileInputStream(fileDescriptor.getFileDescriptor());

FileChannel fileChannel = inputStream.getChannel();

long startOffset = fileDescriptor.getStartOffset();

long declaredLength = fileDescriptor.getDeclaredLength();

return fileChannel.map(FileChannel.MapMode.READ_ONLY, startOffset, declaredLength);

}

// 进行推理

private int doInference(float[] inputData) {

float[][] output = new float[1][10];

tflite.run(inputData, output);

return argmax(output[0]);

}

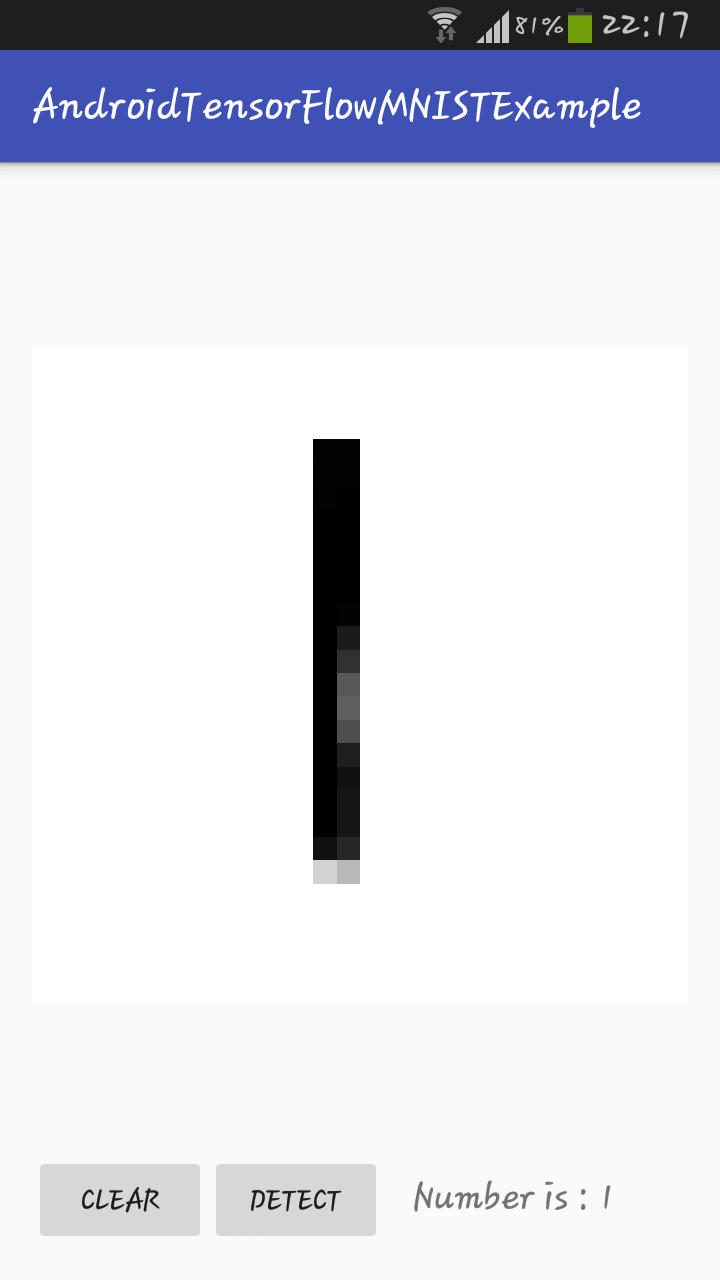

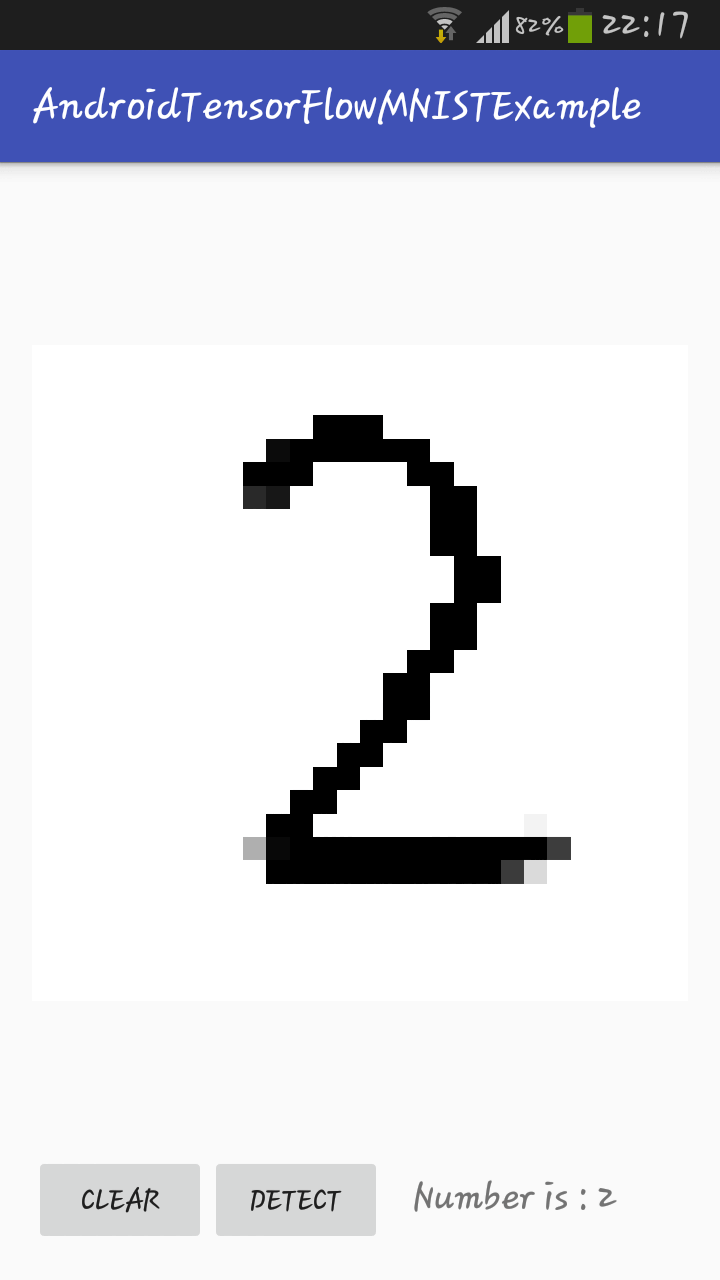

实际效果展示

下面是应用运行的实际效果:

从上面的截图可以看到,用户在屏幕上手写数字后,应用能够准确识别出对应的数字。这充分展示了机器学习模型在移动设备上的实际应用潜力。

项目改进方向

虽然这个项目已经实现了基本功能,但仍有许多可以改进的地方:

- 模型优化:可以尝试使用更复杂的神经网络结构,如卷积神经网络(CNN),以提高识别准确率。

- 性能优化:使用TensorFlow Lite的量化技术,减小模型大小,提高推理速度。

- 用户体验:改进绘图界面,添加清除和撤销功能,使应用更加用户友好。

- 扩展功能:不仅限于数字识别,可以扩展到字母或简单图形的识别。

结论

本项目成功地将TensorFlow模型部署到Android设备上,实现了手写数字的实时识别。这不仅是机器学习在移动端应用的一个很好示例,也为开发者提供了一个可以进一步扩展和改进的基础。随着移动设备计算能力的不断提升,我们可以期待在未来看到更多复杂的AI应用运行在手机上。

通过实践这个项目,开发者可以学习到:

- 如何训练一个基本的机器学习模型

- 如何将训练好的模型转换为移动设备可用的格式

- 如何在Android应用中集成TensorFlow Lite

- 如何处理实时输入并进行推理

这些技能对于希望在移动AI领域发展的开发者来说都是非常宝贵的。我们鼓励读者基于这个项目进行更多的探索和创新,推动移动AI技术的进一步发展。

参考资源

通过阅读以上资源,读者可以获得更深入的技术细节和实现思路,从而更好地理解和扩展这个项目。