Kubernetes AI 工具链操作器 (Kaito)

| 最新版本:2024年7月12日。Kaito v0.3.0。 |

| 首次发布:2023年11月15日。Kaito v0.1.0。 |

Kaito 是一个操作器,用于在 Kubernetes 集群中自动化 AI/ML 模型推理或微调工作负载。目标模型是流行的开源大型模型,如 falcon 和 phi-3。与大多数基于虚拟机基础设施构建的主流模型部署方法相比,Kaito 具有以下主要差异:

- 使用容器镜像管理大型模型文件。提供 HTTP 服务器以使用模型库执行推理调用。

- 提供预设配置,避免根据 GPU 硬件调整工作负载参数。

- 根据模型要求自动配置 GPU 节点。

- 如果许可允许,将大型模型镜像托管在公共 Microsoft 容器注册表 (MCR) 中。

使用 Kaito,在 Kubernetes 中部署大型 AI 推理模型的工作流程大大简化。

架构

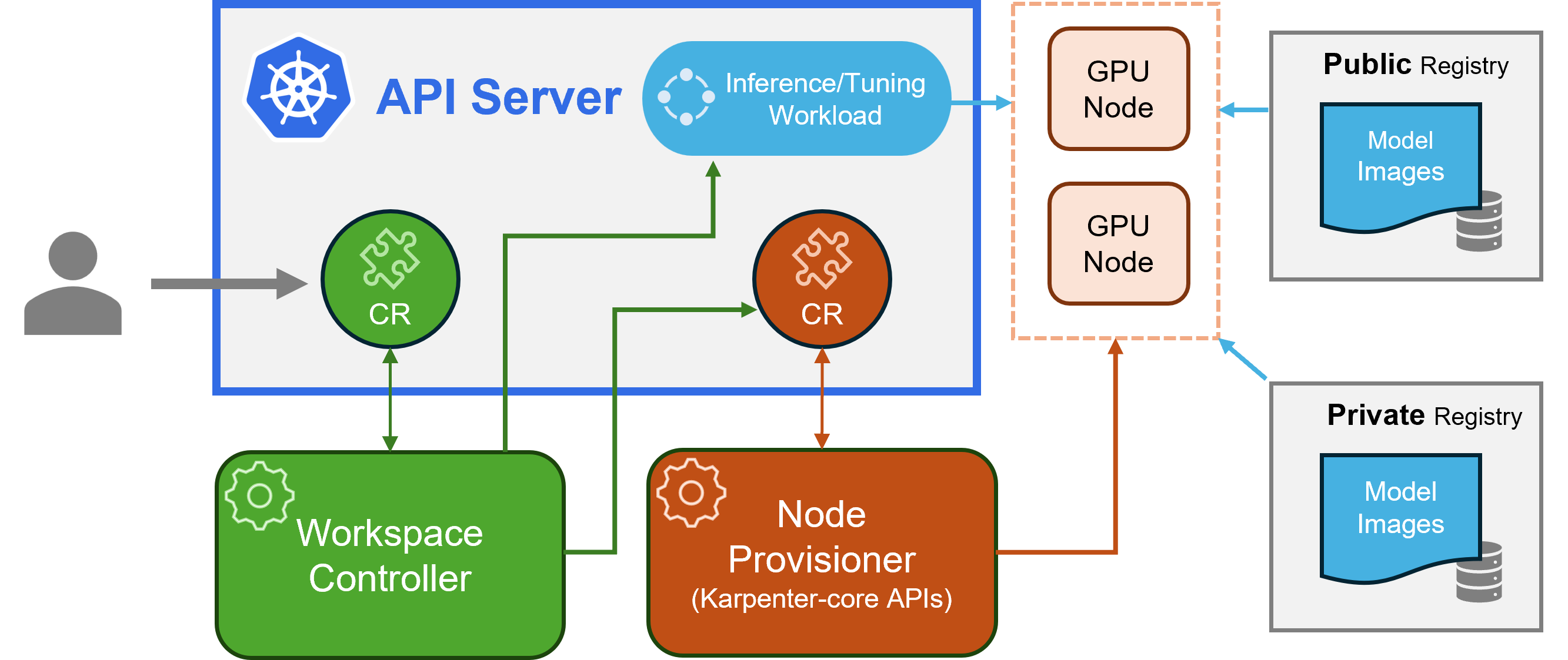

Kaito 遵循经典的 Kubernetes 自定义资源定义 (CRD) / 控制器设计模式。用户管理一个 workspace 自定义资源,描述 GPU 要求和推理或微调规范。Kaito 控制器将通过协调 workspace 自定义资源来自动化部署。

上图展示了 Kaito 架构概览。其主要组件包括:

- 工作空间控制器:协调

workspace自定义资源,创建machine(下文解释)自定义资源以触发节点自动配置,并根据模型预设配置创建推理或微调工作负载(deployment、statefulset或job)。 - 节点配置控制器:控制器名称为 gpu-provisioner helm chart 中的 gpu-provisioner。它使用源自 Karpenter 的

machineCRD 与工作空间控制器交互。它集成了 Azure Resource Manager REST API,以将新的 GPU 节点添加到 AKS 集群。

注意:gpu-provisioner 是一个开源组件。如果其他控制器支持 Karpenter-core API,可以替换它。

安装

请查看此处的安装指南。

快速开始

安装 Kaito 后,可以尝试以下命令启动 falcon-7b 推理服务。

$ cat examples/inference/kaito_workspace_falcon_7b.yaml

apiVersion: kaito.sh/v1alpha1

kind: Workspace

metadata:

name: workspace-falcon-7b

resource:

instanceType: "Standard_NC12s_v3"

labelSelector:

matchLabels:

apps: falcon-7b

inference:

preset:

name: "falcon-7b"

$ kubectl apply -f examples/inference/kaito_workspace_falcon_7b.yaml

可以通过运行以下命令跟踪工作空间状态。当 WORKSPACEREADY 列变为 True 时,表示模型已成功部署。

$ kubectl get workspace workspace-falcon-7b

NAME INSTANCE RESOURCEREADY INFERENCEREADY WORKSPACEREADY AGE

workspace-falcon-7b Standard_NC12s_v3 True True True 10m

接下来,可以找到推理服务的集群 IP,并使用临时的 curl pod 在集群中测试服务端点。

$ kubectl get svc workspace-falcon-7b

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

workspace-falcon-7b ClusterIP <CLUSTERIP> <none> 80/TCP,29500/TCP 10m

export CLUSTERIP=$(kubectl get svc workspace-falcon-7b -o jsonpath="{.spec.clusterIPs[0]}")

$ kubectl run -it --rm --restart=Never curl --image=curlimages/curl -- curl -X POST http://$CLUSTERIP/chat -H "accept: application/json" -H "Content-Type: application/json" -d "{\"prompt\":\"您的问题在这里\"}"

使用方法

Kaito 支持的模型的详细使用说明可以在这里找到。如果用户想部署自己的容器化模型,他们可以在工作空间自定义资源的 inference 字段中提供 pod 模板(详情请参见 API 定义)。控制器将使用所有配置的 GPU 节点创建部署工作负载。请注意,目前控制器不处理自动模型升级。它仅根据预设配置创建推理工作负载(如果工作负载不存在)。

Kaito 支持的模型数量正在增长!请查看此文档,了解如何添加新支持的模型。

从 v0.3.0 版本开始,Kaito 支持模型微调和在推理服务中使用微调后的适配器。有关更多信息,请参阅微调文档和推理文档。

常见问题

如何确保首选节点正确标记以在我的工作空间中使用?

要使用首选节点,请确保节点具有 labelSelector 中 matchLabels 下指定的标签。例如,如果您的 labelSelector 是:

labelSelector:

matchLabels:

apps: falcon-7b

那么节点应该有标签:apps=falcon-7b。

如何将现有部署升级以使用最新的模型配置?

使用托管的公共模型时,用户可以手动删除现有的推理工作负载(Deployment 或 StatefulSet),工作空间控制器将使用当前版本中定义的最新预设配置(例如,镜像版本)创建一个新的工作负载。对于私有模型,建议在 Spec 中使用新的镜像版本创建一个新的工作空间。

如何更新模型/推理参数以覆盖 Kaito 预设配置?

Kaito 提供了有限的功能,可以手动覆盖使用 transformer 运行时的模型的预设配置。

要更新已部署模型的参数,请对工作负载执行 kubectl edit,该工作负载可能是 StatefulSet 或 Deployment。

例如,要在 falcon-7b-instruct 部署上启用 4 位量化,您可以执行:

kubectl edit deployment workspace-falcon-7b-instruct

在部署规范中,找到并修改命令字段。

原始

accelerate launch --num_processes 1 --num_machines 1 --machine_rank 0 --gpu_ids all inference_api.py --pipeline text-generation --torch_dtype bfloat16

修改以启用 4 位量化

accelerate launch --num_processes 1 --num_machines 1 --machine_rank 0 --gpu_ids all inference_api.py --pipeline text-generation --torch_dtype bfloat16 --load_in_4bit

目前,我们允许用户手动更改以下参数:

pipeline:对于文本生成模型,这可以是text-generation或conversational。load_in_4bit或load_in_8bit:模型量化分辨率。

如果您需要自定义其他参数,请提交问题以供未来可能纳入考虑。

instruct 模型和非 instruct 模型有什么区别?

主要区别在于它们的预期用途。Instruct 模型是经过微调的版本,针对交互式聊天应用进行了优化。由于它们在对话环境中表现更好,通常是大多数实现的首选。 另一方面,非 instruct 或原始模型是为进一步微调而设计的。

贡献

本项目欢迎贡献和建议。大多数贡献需要您同意一份贡献者许可协议 (CLA),声明您有权并实际授予我们使用您贡献的权利。有关详细信息,请访问 https://cla.opensource.microsoft.com。

当您提交拉取请求时,CLA 机器人会自动确定您是否需要提供 CLA,并适当地装饰 PR(例如,状态检查、评论)。只需按照机器人提供的说明操作即可。您只需在所有使用我们 CLA 的仓库中执行一次此操作。

本项目已采用 Microsoft 开源行为准则。 有关更多信息,请参阅行为准则常见问题解答或联系 opencode@microsoft.com 获取任何其他问题或意见。

商标

本项目可能包含项目、产品或服务的商标或标志。Microsoft 商标或标志的授权使用必须遵循并遵守 Microsoft 的商标和品牌准则。 在本项目的修改版本中使用 Microsoft 商标或标志不得造成混淆或暗示 Microsoft 赞助。 任何第三方商标或标志的使用均受这些第三方的政策约束。

许可证

参见 LICENSE。

行为准则

本项目已采用 Microsoft 开源行为准则。有关更多信息,请参阅行为准则常见问题解答或联系 opencode@microsoft.com 获取任何其他问题或意见。

联系方式

"Kaito 开发者" kaito-dev@microsoft.com

Github

Github Huggingface

Huggingface