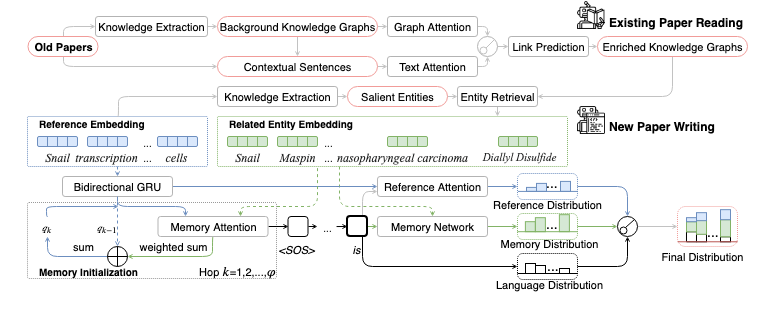

PaperRobot: 增量草稿生成科学思想

被第57届计算语言学协会年会(ACL 2019)接受

目录

概述

要求

环境:

- Python 3.6 注意!! 该模型可能无法在Python 3.5下正确保存和加载

- Ubuntu 16.04/18.04 注意!! 由于Windows使用反斜杠而Linux/OS X使用正斜杠,该模型可能无法在Windows上正确运行

软件包

您可以点击以下链接获取详细的安装说明。

数据:

-

PubMed论文阅读数据集 该数据集从PubMed中收集了14,857个实体,133个关系和相应的标记文本。它包含875,698个训练对,109,462个开发对和109,462个测试对。

-

PubMed术语、摘要、结论、标题数据集 该数据集从PubMed中收集了三种类型的配对:标题到摘要(训练:22,811/开发:2095/测试:2095)、摘要到结论和未来工作(训练:22,811/开发:2095/测试:2095)、结论和未来工作到标题(训练:15,902/开发:2095/测试:2095)。每对包含一对输入和输出以及相应的术语(来自原始KB和链接预测结果)。

快速开始

现有论文阅读

注意!! 由于数据集相当大,链接预测模型的训练和评估会非常慢。

预处理:

从PubMed论文阅读数据集下载并解压缩paper_reading.zip。将paper_reading文件夹放在现有论文阅读文件夹下。

训练

超参数可以如下调整:例如,如果你想将隐藏单元数更改为6,可以在train.py后添加--hidden 6

python train.py

要继续训练,可以使用以下命令并将之前的模型路径放在--model后

python train.py --cont --model models/GATA/best_dev_model.pth.tar

测试

将完成的模型路径放在--model后 test.py将为测试集提供排名分数。

python test.py --model models/GATA/best_dev_model.pth.tar

新论文写作

预处理:

从PubMed术语、摘要、结论、标题数据集下载并解压缩data_pubmed_writing.zip。将data文件夹放在新论文写作文件夹下。

训练

将数据类型放在--data_path之后。例如,如果你想训练一个摘要模型,将data/pubmed_abstract放在--data_path之后。

将模型目录放在--model_dp之后

python train.py --data_path data/pubmed_abstract --model_dp abstract_model/

要继续训练,可以使用以下命令并将之前的模型路径放在--model后

python train.py --data_path data/pubmed_abstract --cont --model abstract_model/memory/best_dev_model.pth.tar

更多选项,请检查代码。

测试

将完成的模型路径放在--model后 test.py将为测试集提供评分。

python test.py --data_path data/pubmed_abstract --model abstract_model/memory/best_dev_model.pth.tar

预测一个实例

将完成的模型路径放在--model后 input.py将为定制输入提供预测。

python input.py --data_path data/pubmed_abstract --model abstract_model/memory/best_dev_model.pth.tar

引用

@inproceedings{wang-etal-2019-paperrobot,

title = "{P}aper{R}obot: Incremental Draft Generation of Scientific Ideas",

author = "Wang, Qingyun and

Huang, Lifu and

Jiang, Zhiying and

Knight, Kevin and

Ji, Heng and

Bansal, Mohit and

Luan, Yi",

booktitle = "Proceedings of the 57th Conference of the Association for Computational Linguistics",

month = jul,

year = "2019",

address = "Florence, Italy",

publisher = "Association for Computational Linguistics",

url = "https://aclanthology.org/P19-1191",

pages = "1980--1991"

}

Github

Github 文档

文档 论文

论文