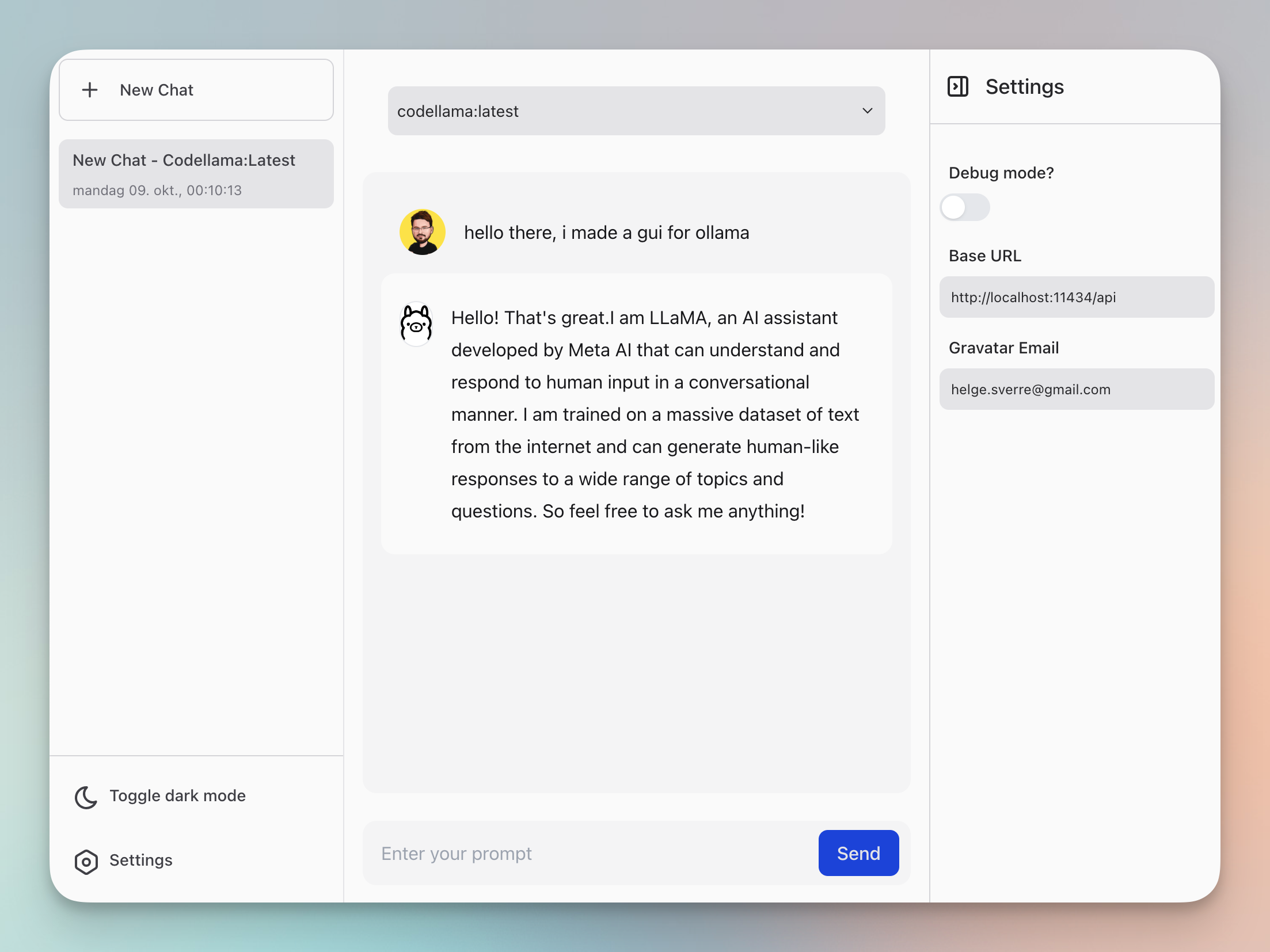

Ollama GUI:与本地LLMs聊天的Web界面

Ollama GUI是一个用于ollama.ai的Web界面,这是一个能让你在本地机器上运行大型语言模型(LLMs)的工具。

🛠 安装

前提条件

- 下载并安装ollama CLI。

- 下载并安装yarn和node。

ollama pull <模型名称>

ollama serve

入门指南

- 克隆仓库并启动开发服务器。

git clone https://github.com/HelgeSverre/ollama-gui.git

cd ollama-gui

yarn install

yarn dev

或者使用托管的Web版本,通过以下命令运行ollama(文档)

OLLAMA_ORIGINS=https://ollama-gui.vercel.app ollama serve

使用Docker运行

要使用Docker运行Ollama GUI,请按以下步骤操作:

-

克隆仓库:

git clone https://github.com/HelgeSverre/ollama-gui.git cd ollama-gui -

构建Docker镜像:

docker build -t ollama-gui . -

运行Docker容器:

docker run -p 8080:8080 ollama-gui -

通过打开网络浏览器并导航到

http://localhost:8080来访问应用程序。

注意:确保Ollama CLI在您的主机上运行,因为Ollama GUI的Docker容器需要与之通信。

模型

为了方便和可复制性,这里列出了一些您可能想尝试的有趣模型表格。

有关Ollama支持的完整模型列表,请访问ollama.ai/library。

📋 待办事项

- 正确格式化聊天消息中的换行(PHP中有

nl2br,基本上想要同样的功能) - 使用IndexedDB在本地存储聊天历史

- 清理代码,为了速度和快速发布,我把代码弄得有点乱

- 添加Markdown解析库

- 允许浏览和安装可用模型(库)

- 确保移动端响应性(目前非优先考虑的用例)

- 添加文件上传功能,包括OCR等

🛠 技术栈

- Ollama.ai - 模型CLI工具

- LangUI

- Vue.js

- Vite

- Tailwind CSS

- VueUse

- @tabler/icons-vue

📝 许可证

根据MIT许可证授权。详情请参阅LICENSE.md文件。

访问官网

访问官网 Github

Github 文档

文档