动态高斯网格

项目页面 | 论文

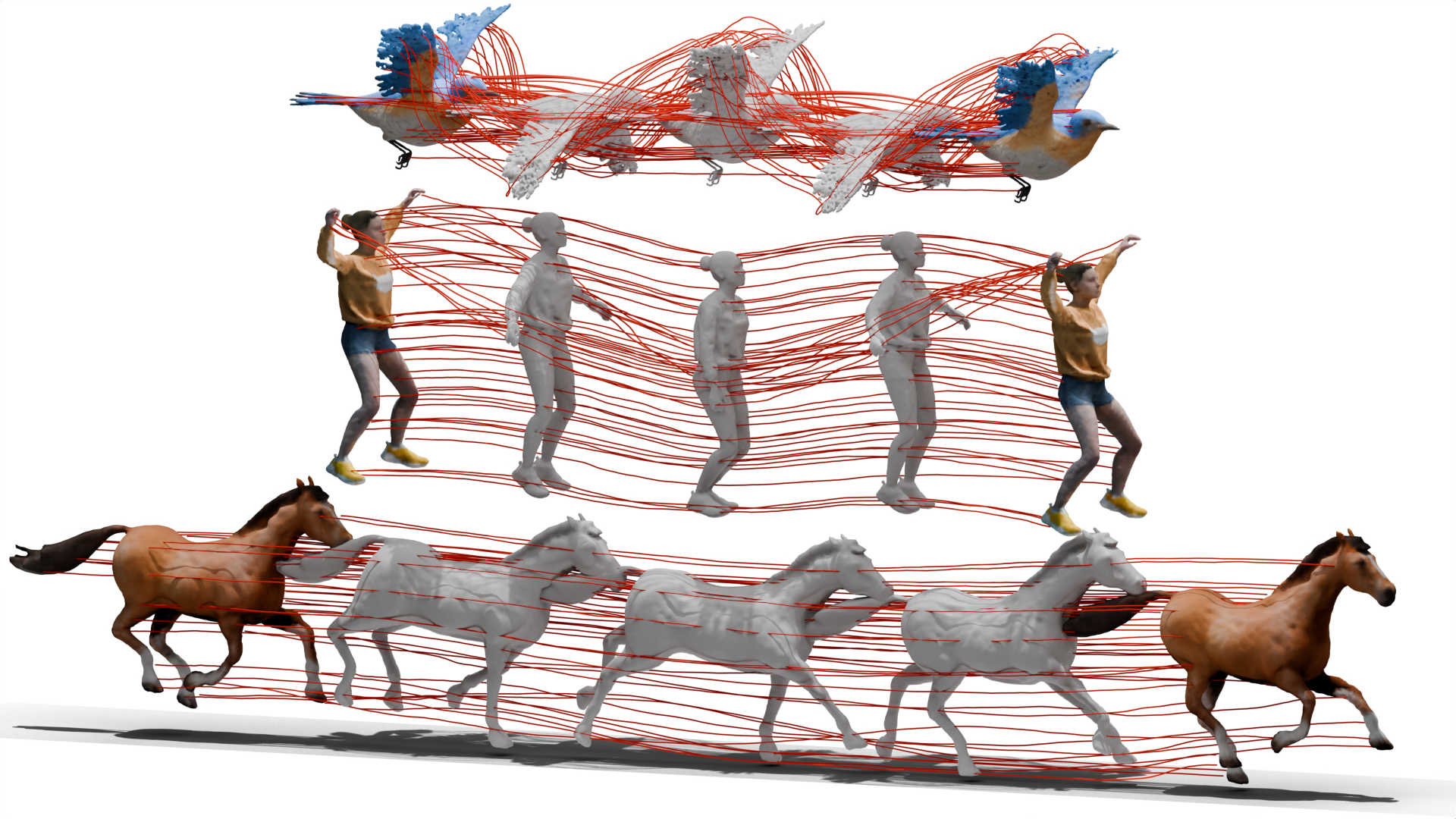

我们提出了DG-Mesh,一个从单目视频重建高保真时间一致网格的框架。给定动态场景的单目输入和相机参数,我们的方法可以重建高质量的表面及其外观,以及跨时间帧的网格顶点运动。我们的方法可以重建具有灵活拓扑变化的网格。即使在像鸟翼这样具有挑战性的细薄结构中,我们也能重建出令人满意的表面。

待办事项

- 安装说明

- 训练/推理代码

- 网格评估代码

- DG-Mesh数据集

- 网格对应关系可视化

安装

conda create -n dg-mesh python=3.9

conda activate dg-mesh

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

# 安装nvdiffrast

pip install git+https://github.com/NVlabs/tiny-cuda-nn#subdirectory=bindings/torch

pip install git+https://github.com/NVlabs/nvdiffrast/

# 安装pytorch3d

export FORCE_CUDA=1

conda install -c fvcore -c iopath -c conda-forge fvcore iopath -y

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

# 克隆此仓库

git clone https://github.com/Isabella98Liu/DG-Mesh.git

cd DG-Mesh

# 安装子模块

pip install dgmesh/submodules/diff-gaussian-rasterization

pip install dgmesh/submodules/simple-knn

# 安装其他依赖

pip install -r requirements.txt

在D-NeRF数据集上训练

我们提供配置文件以在D-NeRF数据集上训练我们的模型。下载数据集并更改相应配置文件中的source_path:

python dgmesh/train.py --config dgmesh/configs/d-nerf/jumpingjacks.yaml

我们还提供渲染脚本来可视化网格及其渲染结果,以及训练模型中的高斯点。将--start_checkpoint设置为已训练模型的路径。例如:

python dgmesh/render_trajectory.py --config dgmesh/configs/d-nerf/jumpingjacks.yaml --start_checkpoint outputs/d-nerf/jumpingjacks/jumpingjacks-2024-07-01_06-03-50

D-NeRF数据集上的网格渲染结果和高斯点示例。

在DG-Mesh数据集上训练

为了定量评估重建的网格,我们提供了一个包含六个动态场景的合成数据集。每个场景包括200帧移动物体的图像和真实相机参数,以及每个时间帧下的真实网格。您可以通过提供的链接下载DG-Mesh数据集。数据格式遵循D-NeRF数据集。

要训练模型,请修改相应配置文件中的 source_path 并运行以下命令:

python dgmesh/train.py --config dgmesh/configs/dg-mesh/beagle.yaml

DG-Mesh数据集上的网格渲染结果和高斯点示例。

在Nerfies数据集上训练

我们提供了部分处理过的Nerfies数据,其中还包含了物体前景掩码;你可以在发布页面的这里下载。要在Nerfies数据集上训练模型,请运行以下命令:

python dgmesh/train.py --config dgmesh/configs/nerfies/toby-sit.yaml

要在测试摄像机视角下渲染网格,请运行以下脚本:

python dgmesh/render_test.py --config /mnt/samsung990/ECCV2024/Release/DG-Mesh/dgmesh/configs/nerfies/toby-sit.yaml --start_checkpoint outputs/nerfies/toby-sit/toby-sit-2024-07-04_22-56-29

在NeuralActor数据集上训练

NeuralActor数据集是一个多视角动态数据集,包含了移动中的人体多视角视频。我们处理了部分数据集(如果获得批准将发布处理后的数据)。要在NeuralActor数据集上运行模型:

python dgmesh/train.py --config dgmesh/configs/neural-actor/D2_vlad.yaml

在iPhone拍摄的视频上训练

我们使用iPhone 14 Pro和Record3D捕捉了几个动态场景,并使用Reality Check中的流程进行处理。我们使用DEVA获取前景掩码。你可以通过发布页面的链接下载数据。要在我们捕捉的数据上训练模型,请运行:

python dgmesh/train.py --config /dgmesh/configs/iphone/tiger.yaml

网格评估

我们提供了DG-Mesh数据集上的网格评估脚本;请按以下方式组织网格GT数据和你的网格结果:

mesh_eval_folder/

├── gt/

│ ├── objname0.obj

│ ├── objname1.obj

│ └── ...

├── DG-Mesh/

│ └── dynamic_mesh/

│ ├── frame_0.ply

│ ├── frame_1.ply

│ └── ...

└── transforms_train.json

您可能需要安装StructuralLoss来计算EMD;请按照以下说明进行操作:

cd dgmesh/metrics/pytorch_structural_losses/

make clean

make

要运行评估:

python mesh_evaluation.py --path mesh_eval_folder --eval_type dgmesh

引用

如果您觉得我们的代码或论文有帮助,请考虑引用:

@misc{liu2024dynamic,

title={Dynamic Gaussians Mesh: Consistent Mesh Reconstruction from Monocular Videos},

author={Isabella Liu and Hao Su and Xiaolong Wang},

year={2024},

eprint={2404.12379},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

同时感谢Deformable 3DGS和3DGS的作者们提供的优秀代码!

访问官网

访问官网 Github

Github 论文

论文