VITA: 迈向开源交互式全能多模态大语言模型

🔥 新闻

2024.08.12🌟 我们非常自豪地推出VITA,这是史上首个开源交互式全能多模态大语言模型!所有训练代码、部署代码和模型权重将很快发布!我们已提交开源代码,目前正在内部审核中。我们正在尽快推进这个过程,敬请期待!

👀 VITA概览

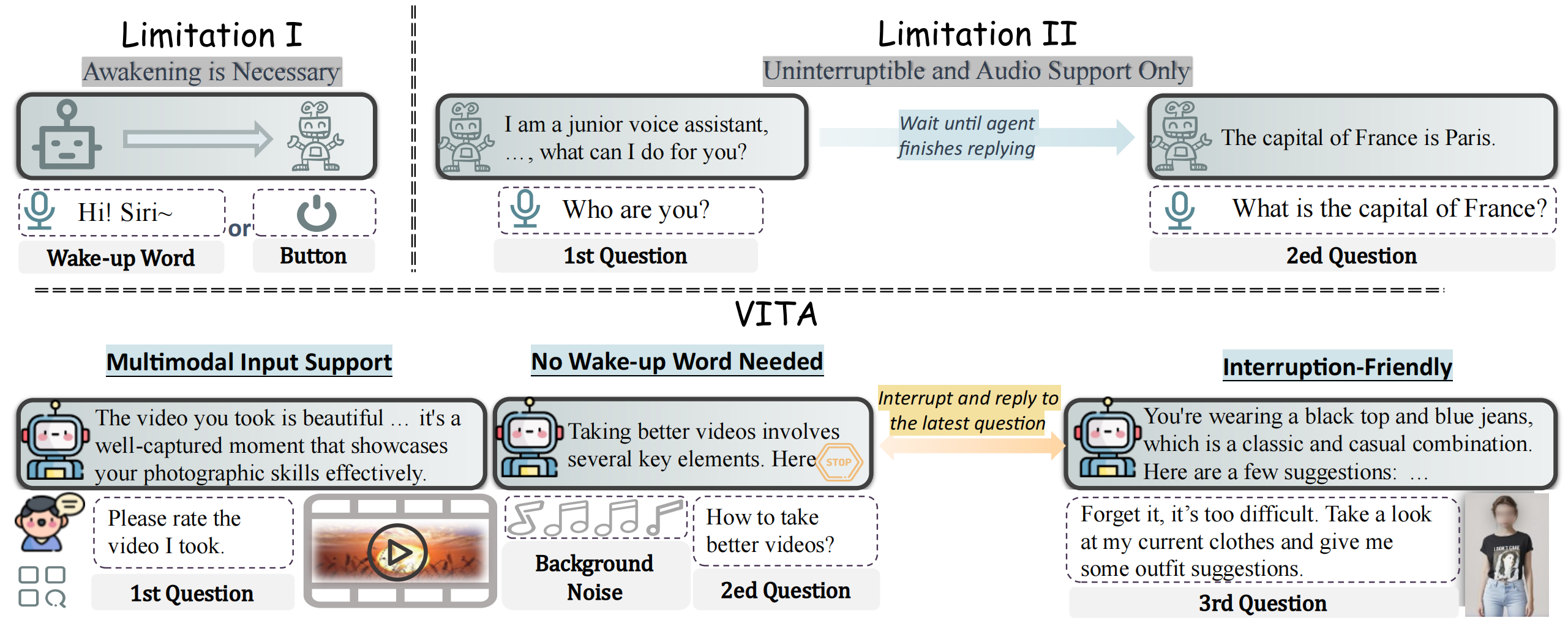

GPT-4的出色多模态能力和交互体验凸显了它们在实际应用中的必要性,但开源模型很少在这两个方面都表现出色。在本文中,我们介绍了VITA,这是首个能够同时处理和分析视频、图像、文本和音频模态,并且具有先进多模态交互体验的开源多模态大语言模型。我们的工作通过三个关键特性与现有开源多模态大语言模型区分开来:

- 全能多模态理解。VITA展示了强大的多语言、视觉和音频理解基础能力,这一点在一系列单模态和多模态基准测试中的出色表现得到了证实。

- 无唤醒交互。VITA可以在环境中被激活并回应用户的音频问题,无需唤醒词或按钮。

- 音频中断交互。VITA能够实时同步跟踪和过滤外部查询。这使用户可以随时用新问题中断模型的生成,VITA将相应地回应新的查询。

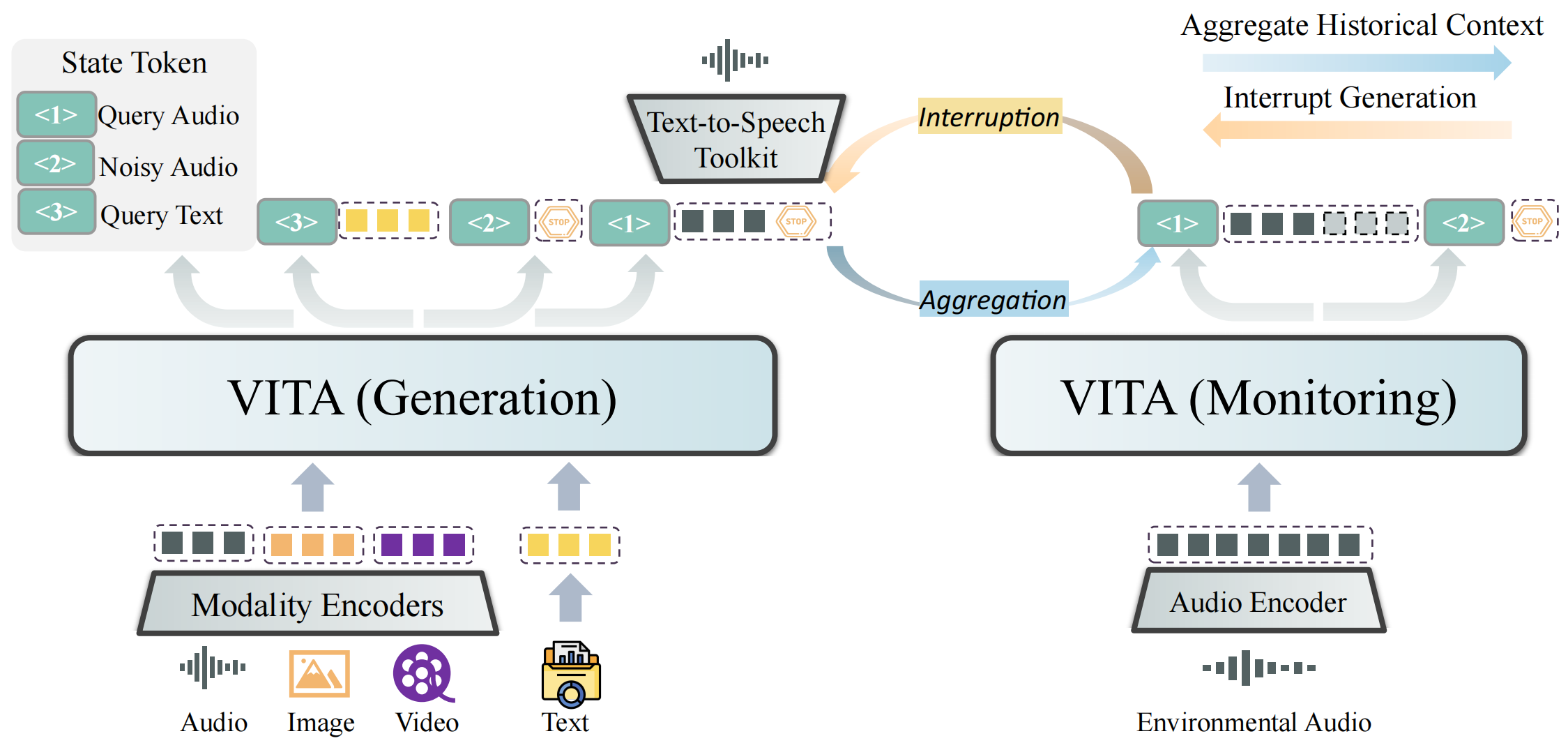

VITA能够处理纯文本/音频形式的输入,以及视频/图像与文本/音频的组合。此外,我们采用了两项关键技术来提升多模态交互体验:

- 状态标记。我们为不同的查询输入设置不同的状态标记。<1>对应有效的查询音频,例如"世界上最大的动物是什么?",我们期望模型对此做出回应。<2>对应噪音音频,例如环境中有人叫我吃饭,我们期望模型不做回应。<3>对应查询文本,即用户以文本形式提出的问题。在训练阶段,我们尝试教会模型自动区分不同的输入查询。在部署阶段,通过<2>我们可以实现无唤醒交互。

- 双工方案。我们进一步引入了音频中断交互的双工方案。两个模型同时运行,其中生成模型负责处理用户查询。当生成模型开始工作时,另一个模型监控环境。如果用户用另一个有效的音频查询中断,监控模型会汇总历史上下文以响应最新的查询,同时生成模型暂停并转为监控,即两个模型交换身份。

📈 实验结果

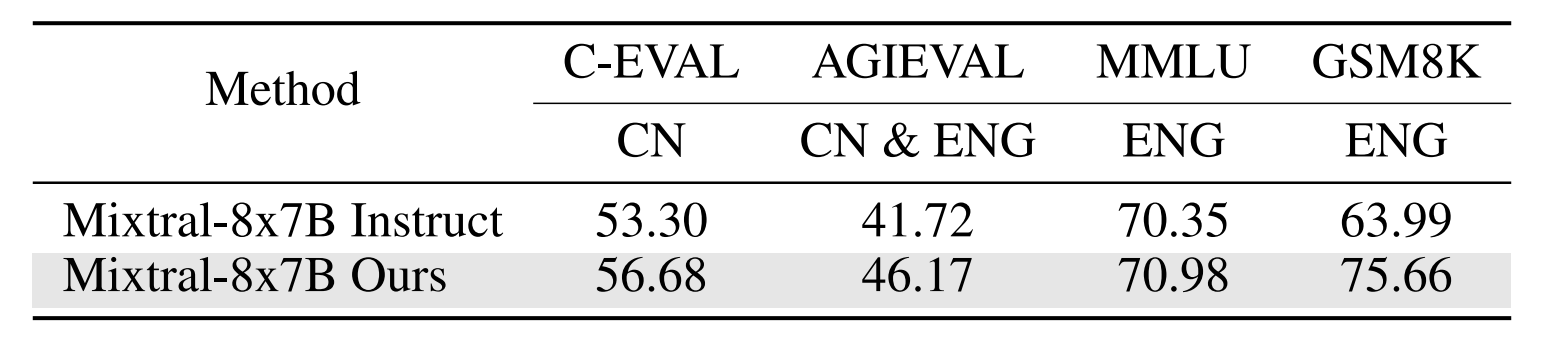

- 官方Mixtral 8x7B Instruct与我们训练的Mixtral 8x7B的比较

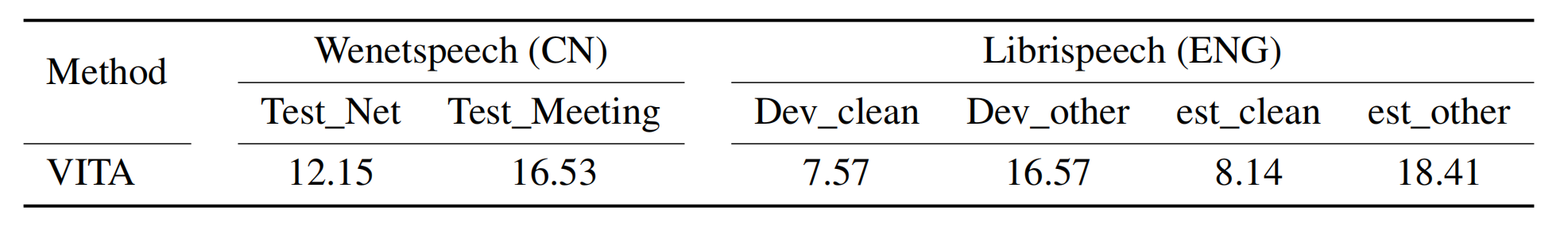

- ASR任务评估

- 图像和视频理解评估

✒️ 引用

如果您发现我们的工作对您的研究有帮助,请考虑引用我们的工作。

@article{fu2024vita,

title={VITA: Towards Open-Source Interactive Omni Multimodal LLM},

author={Fu, Chaoyou and Lin, Haojia and Long, Zuwei and Shen, Yunhang and Zhao, Meng and Zhang, Yifan and Wang, Xiong and Yin, Di and Ma, Long and Zheng, Xiawu and He, Ran and Ji, Rongrong and Wu, Yunsheng and Shan, Caifeng and Sun, Xing},

journal={arXiv preprint arXiv:2408.05211},

year={2024}

}

📜 相关工作

探索我们的相关研究:

- [Video-MME] Video-MME:首个全面评估多模态大语言模型在视频分析中表现的基准测试

- [MME] MME:多模态大语言模型的全面评估基准

- [Awesome-MLLM] 多模态大语言模型综述

访问官网

访问官网 Github

Github 论文

论文