LongForm:利用反向指令进行有效的指令微调

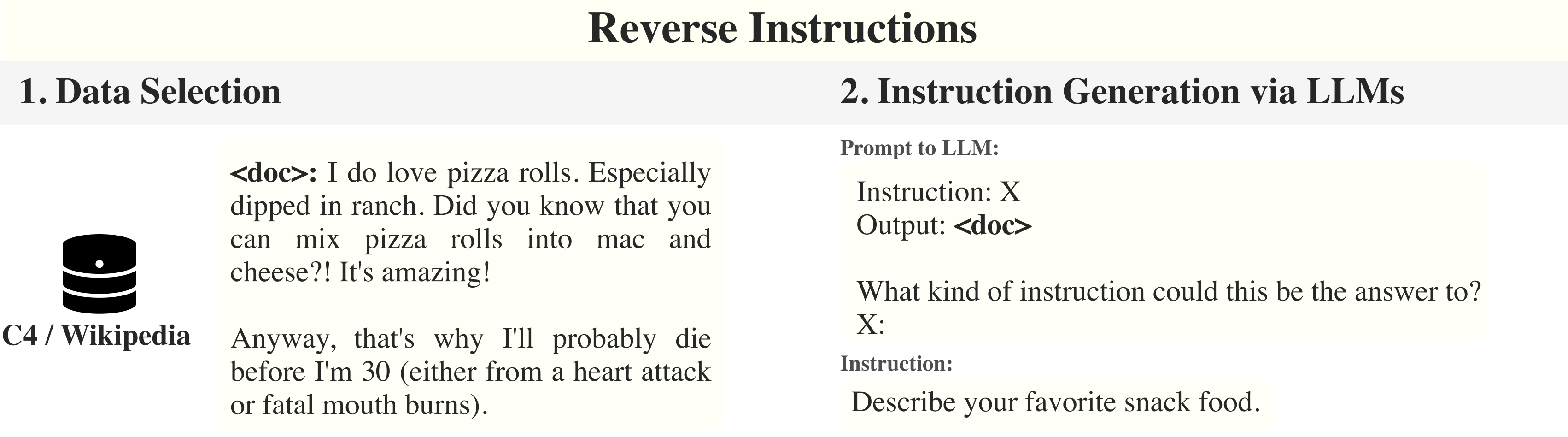

LongForm数据集是通过利用反向指令方法从英语语料库示例中创建的。我们从现有的语料库(如C4和维基百科)中选择多样化的人工编写文档,并通过大型语言模型为给定文档生成指令。然后,我们使用结构化语料库示例(如Stack Exchange和WikiHow)以及任务示例(如问答、邮件写作、语法错误纠正、故事/诗歌生成和文本摘要)来扩展这些示例。

数据集和模型

我们在Github和HuggingFace上发布了_LongForm-C数据集_。更多详细信息请查看论文或这些链接。

LongForm模型: 我们在HuggingFace的模型中心发布了这些模型。由于LLaMA模型的限制,我们无法公开发布LongForm-LLaMA-7B。

- LongForm-LLaMA-7B-diff*: https://huggingface.co/akoksal/LongForm-LLaMA-7B-diff

- LongForm-T5-XL: https://huggingface.co/akoksal/LongForm-T5-XL

- LongForm-OPT-125M: https://huggingface.co/akoksal/LongForm-OPT-125M

- LongForm-OPT-350M: https://huggingface.co/akoksal/LongForm-OPT-350M

- LongForm-OPT-1.3B: https://huggingface.co/akoksal/LongForm-OPT-1.3B

- LongForm-OPT-2.7B: https://huggingface.co/akoksal/LongForm-OPT-2.7B

- LongForm-OPT-6.7B: https://huggingface.co/akoksal/LongForm-OPT-6.7B

*您需要拥有LLaMA-7B的原始权重,并与此差异相加以获得LongForm模型。

评估

我们在论文中提供了LongForm模型和基线的深入评估。我们展示了模型在领域外数据集上的METEOR分数。在所有任务中,包括食谱生成(RGen)、长篇问答(ELI5)和短篇故事生成(WritingPrompts/WP),LongForm模型都优于之前的指令微调模型。

| 总体 | 食谱生成 | ELI5 | 写作提示 | |

|---|---|---|---|---|

| T0++ | 10.9 | 18.7 | 3.8 | 10.2 |

| Tk-Instruct | 6.3 | 12.9* | 3.6 | 2.4 |

| Flan-T5 | 10.6 | 20.9* | 3.5 | 7.4 |

| Alpaca-LLaMA-7B | 14.6 | 19.5 | 12.5 | 11.8 |

| OPT-30B | 11.1 | 18.6 | 12.2 | 2.6 |

| LongForm-T5-XL | 16.3 | 20.2 | 18.3 | 10.6 |

| LongForm-OPT-6.7B | 17.7 | 16.9 | 17.2 | 19.0 |

| LongForm-LLaMA-7B‡ | 19.7 | 21.7 | 18.6 | 18.9 |

语言理解和生成

我们比较了LongForm-C数据集、FLAN数据集以及结合两个数据集微调的模型在自然语言生成(NLG)和自然语言理解(NLU)任务上的表现,旨在评估LongForm-C在提升NLU任务性能的同时改善生成任务的效果。

| 模型 | 数据集 | NLG | NLU (5-shot MMLU) |

|---|---|---|---|

| LLaMA-7B | FLAN | 9.1 | 36.6 |

| LLaMA-7B | LongForm-C | 19.7 | 35.2 |

| LLaMA-7B | FLAN+LongForm-C | 16.5 | 38.9 |

LongForm-OPT模型的小型版本也可用:

‡: 由于LLaMA模型的限制,我们只能公开发布LongForm-LLaMA-7B和预训练LLaMA-7B之间的差异。

局限性

LongForm数据集和模型主要关注长文本生成,在自然语言处理的结构化预测任务方面存在局限性。此外,我们观察到LongForm模型可能存在与大型语言模型类似的幻觉问题。

许可证

LongForm项目受MIT许可证约束,并附带OpenAI(针对指令生成部分)施加的自定义限制,以及语言模型(OPT、LLaMA和T5)的许可证。LongForm-C中的WikiHow子集受WikiHow提出的许可证约束。

引用

@misc{koksal2023longform,

title={LongForm: 通过反向指令进行有效的指令调优},

author={Abdullatif Köksal and Timo Schick and Anna Korhonen and Hinrich Schütze},

year={2023},

eprint={2304.08460},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Github

Github Huggingface

Huggingface 论文

论文