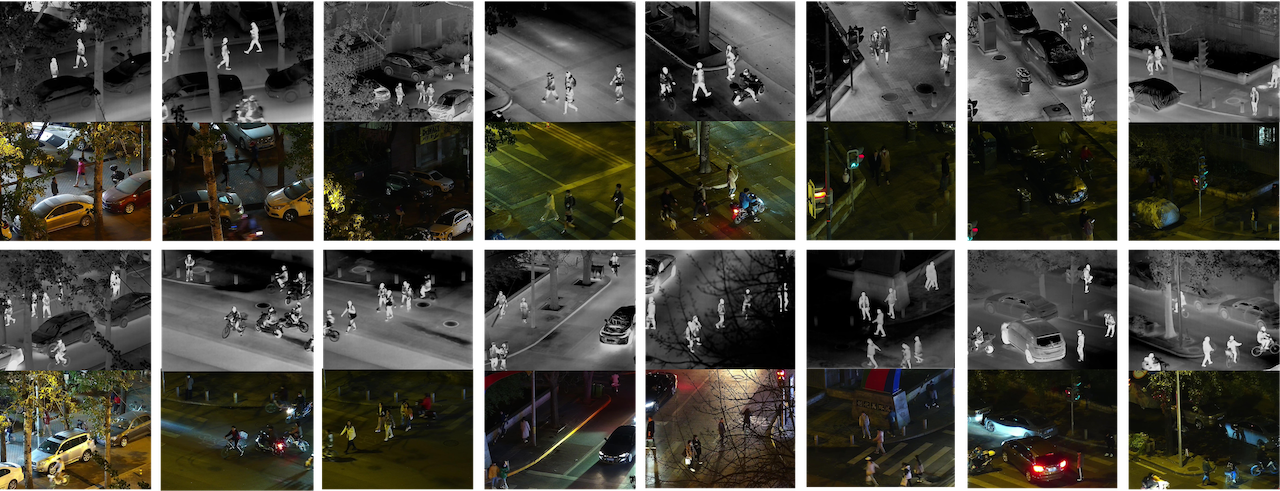

LLVIP: 一个可见光-红外配对的低光照视觉数据集

新闻

- ⚡(2024-1-8): 在LLVIP上预训练的pix2pixGAN已发布 点击此处下载

- ⚡(2023-2-21): 部分图像的标注已经修正并更新,包括一些遗漏行人的标注,以及对一些不精确标注的优化。更新后的数据集现可从主页或这里获取。如需先前版本的标注,请参考这里。

- ⚡(2022-5-24): 我们提供了一个工具箱,用于各种格式转换(xml到yolov5、xml到yolov3、xml到coco)

- ⚡(2022-3-27): 我们发布了一些原始数据(未配准的图像对和视频)用于进一步研究,包括图像配准。请访问主页获取更新。(2022-3-28 我们更新了LLVIP原始数据的百度网盘链接,新链接下载的数据支持在

windows和macos下解压。原链接仅支持windows。) - ⚡(2021-12-25): 我们基于部分LLVIP数据集发布了一个Kaggle社区竞赛"在黑暗中寻找人!"欢迎参与并享受其中!注意:仅允许使用我们上传到Kaggle平台的可见光图像数据(禁止使用LLVIP中的红外图像或其他外部数据)

- ⚡(2021-11-24): 行人检测模型已发布

- ⚡(2021-09-01): 我们已发布数据集,请访问主页或这里获取数据集。(注意我们从原始数据集中移除了一些低质量图像,此版本共有30976张图像。)

数据集下载:

主页 或 数据集下载

引用

如果您在研究中使用了此数据,请引用我们的论文 LLVIP: A Visible-infrared Paired Dataset for Low-light Vision:

@inproceedings{jia2021llvip,

title={LLVIP: A visible-infrared paired dataset for low-light vision},

author={Jia, Xinyu and Zhu, Chuang and Li, Minzhen and Tang, Wenqi and Zhou, Wenli},

booktitle={Proceedings of the IEEE/CVF International Conference on Computer Vision},

pages={3496--3504},

year={2021}

}

或

@misc{https://doi.org/10.48550/arxiv.2108.10831,

doi = {10.48550/ARXIV.2108.10831},

url = {https://arxiv.org/abs/2108.10831},

author = {Jia, Xinyu and Zhu, Chuang and Li, Minzhen and Tang, Wenqi and Liu, Shengjie and Zhou, Wenli},

keywords = {Computer Vision and Pattern Recognition (cs.CV), Artificial Intelligence (cs.AI), FOS: Computer and information sciences, FOS: Computer and information sciences},

title = {LLVIP: A Visible-infrared Paired Dataset for Low-light Vision},

publisher = {arXiv},

year = {2021},

copyright = {arXiv.org perpetual, non-exclusive license}

}

图像融合

基线方法

FusionGAN

准备工作

- 安装依赖

git clone https://github.com/bupt-ai-cz/LLVIP.git cd LLVIP/FusionGAN # 使用anaconda创建虚拟环境 conda create -n FusionGAN python=3.7 conda activate FusionGAN conda install matplotlib scipy==1.2.1 tensorflow-gpu==1.14.0 pip install opencv-python sudo apt install libgl1-mesa-glx - 文件结构

FusionGAN ├── ... ├── Test_LLVIP_ir | ├── 190001.jpg | ├── 190002.jpg | └── ... ├── Test_LLVIP_vi | ├── 190001.jpg | ├── 190002.jpg | └── ... ├── Train_LLVIP_ir | ├── 010001.jpg | ├── 010002.jpg | └── ... └── Train_LLVIP_vi ├── 010001.jpg ├── 010002.jpg └── ...

训练

python main.py --epoch 10 --batch_size 32

更多训练选项请参见main.py。

测试

python test_one_image.py

请记得将预训练模型放在checkpoint文件夹中,并在test_one_image.py中更改相应的模型名称。

如需获取完整的LLVIP数据集,请访问https://bupt-ai-cz.github.io/LLVIP/。

Densefuse

准备工作

- 安装依赖

git clone https://github.com/bupt-ai-cz/LLVIP cd LLVIP/imagefusion_densefuse # 使用anaconda创建虚拟环境 conda create -n Densefuse python=3.7 conda activate Densefuse conda install scikit-image scipy==1.2.1 tensorflow-gpu==1.14.0 - 文件结构

imagefusion_densefuse ├── ... ├──datasets | ├──010001_ir.jpg | ├──010001_vi.jpg | └── ... ├──test | ├──190001_ir.jpg | ├──190001_vi.jpg | └── ... └──LLVIP ├── infrared | ├──train | | ├── 010001.jpg | | ├── 010002.jpg | | └── ... | └──test | ├── 190001.jpg | ├── 190002.jpg | └── ... └── visible ├──train | ├── 010001.jpg | ├── 010002.jpg | └── ... └── test ├── 190001.jpg ├── 190002.jpg └── ...

训练与测试

python main.py

请在main.py中检查并修改训练/测试选项。在训练/测试之前,您需要重命名LLVIP数据集中的图像并将它们放在指定的文件夹中。我们提供了一个名为rename.py的脚本,用于重命名图像并将它们保存在datasets或test文件夹中。检查点保存在./models/densefuse_gray/中。如需获取完整的LLVIP数据集,请访问https://bupt-ai-cz.github.io/LLVIP/。

IFCNN

请访问https://github.com/uzeful/IFCNN。

行人检测

基准模型

Yolov5

准备工作

Linux和Python>=3.6.0

-

安装依赖

git clone https://github.com/bupt-ai-cz/LLVIP.git cd LLVIP/yolov5 pip install -r requirements.txt -

文件结构

LLVIP的训练集用于训练yolov5模型,测试集用于验证yolov5模型。

yolov5 ├── ... └──LLVIP ├── labels | ├──train | | ├── 010001.txt | | ├── 010002.txt | | └── ... | └──val | ├── 190001.txt | ├── 190002.txt | └── ... └── images ├──train | ├── 010001.jpg | ├── 010002.jpg | └── ... └── val ├── 190001.jpg ├── 190002.jpg └── ...我们提供了一个工具箱,用于将注释文件转换为yolov5格式的txt文件。

训练

python train.py --img 1280 --batch 8 --epochs 200 --data LLVIP.yaml --weights yolov5l.pt --name LLVIP_export

更多训练选项请参见train.py。预训练模型yolov5l.pt可以从这里下载。训练好的模型将保存在./runs/train/LLVIP_export/weights文件夹中。

测试

python val.py --data --img 1280 --weights last.pt --data LLVIP.yaml

请记得将训练好的模型放在与val.py相同的文件夹中。

我们训练好的模型可以从以下链接下载:Google-Drive-Yolov5-model或百度网盘-Yolov5-model(提取码:qepr)

- 点击这里查看Yolov3的教程(我们训练好的Yolov3模型可以从以下链接下载:Google-Drive-Yolov3-model或百度网盘-Yolov3-model(提取码:ine5))。

结果

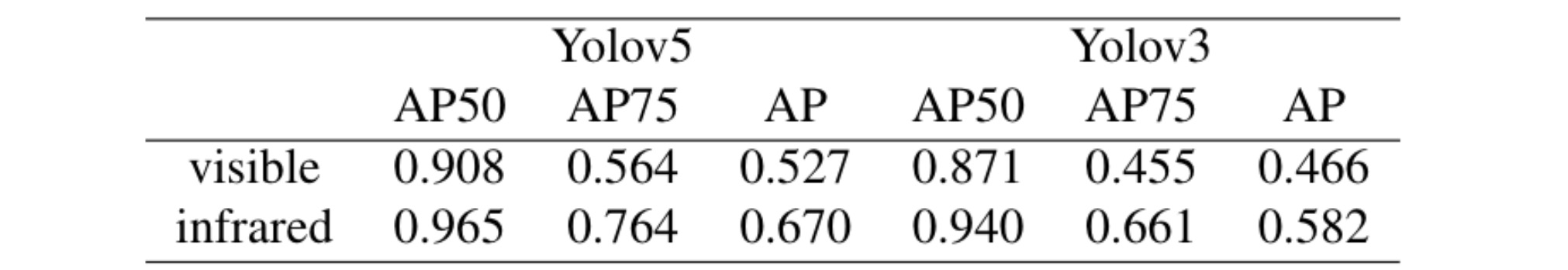

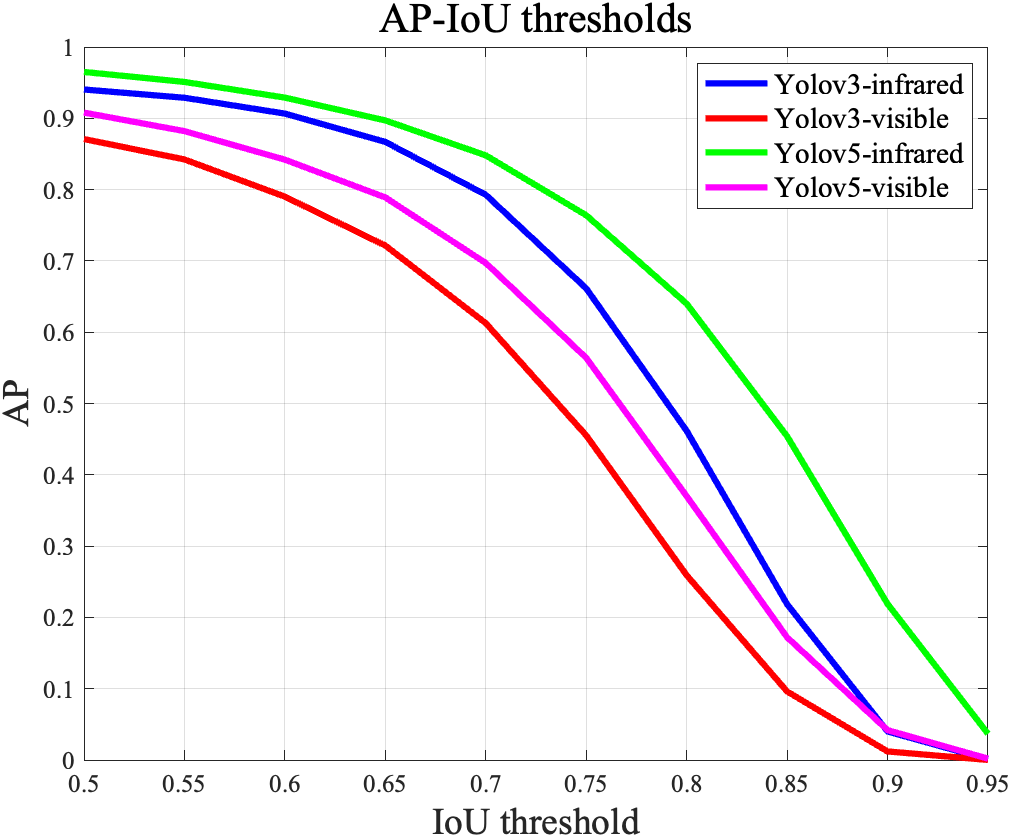

我们在更新后的数据集(30976张图像)上重新训练并测试了Yolov5l和Yolov3。

上图显示了不同IoU阈值下AP的变化。当IoU阈值高于0.7时,AP值迅速下降。此外,红外图像突出显示行人,在检测任务中取得了比可见光图像更好的效果,这不仅证明了红外图像的必要性,还表明在低光照条件下可见光图像行人检测算法的性能不够理想。

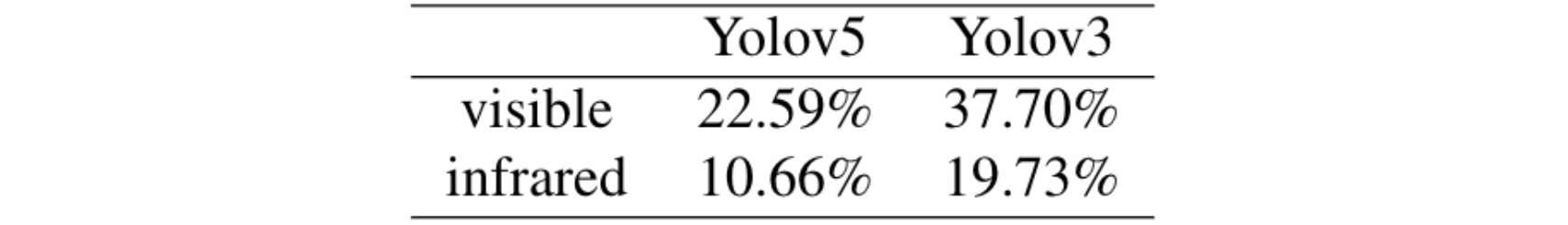

我们还根据测试结果计算了对数平均漏检率,并绘制了漏检率-FPPI曲线。

图像到图像转换

基准

pix2pixGAN

准备工作

- 安装依赖

cd pix2pixGAN pip install -r requirements.txt - 准备数据集

- 文件结构

pix2pixGAN ├── ... └──datasets ├── ... └──LLVIP ├── train | ├── 010001.jpg | ├── 010002.jpg | ├── 010003.jpg | └── ... └── test ├── 190001.jpg ├── 190002.jpg ├── 190003.jpg └── ...

训练

python train.py --dataroot ./datasets/LLVIP --name LLVIP --model pix2pix --direction AtoB --batch_size 8 --preprocess scale_width_and_crop --load_size 320 --crop_size 256 --gpu_ids 0 --n_epochs 100 --n_epochs_decay 100

测试

python test.py --dataroot ./datasets/LLVIP --name LLVIP --model pix2pix --direction AtoB --gpu_ids 0 --preprocess scale_width_and_crop --load_size 320 --crop_size 256

更多训练和测试选项请参见 ./pix2pixGAN/options。

结果

我们在更新后的数据集(30976张图像)上重新训练和测试了pix2pixGAN。生成器的结构是unet256,判别器的结构是默认的基本PatchGAN。

许可证

LLVIP数据集免费提供给学术和非学术实体用于非商业目的,如学术研究、教学、科学出版或个人实验。在您同意我们的许可条款的情况下,允许使用该数据。

征集贡献

欢迎指出数据标注中的错误。如果您想修改标签,请参考标注教程,并将修正后的标签文件发送给我们。

我们也欢迎更多的标注形式(如分割),请与我们联系。

致谢

感谢XueZ-phd对LLVIP数据集的贡献。他纠正了数据集中不完善的标注。

联系方式

电子邮件:shengjie.Liu@bupt.edu.cn, czhu@bupt.edu.cn, jiaxinyujxy@qq.com, tangwenqi@bupt.edu.cn

访问官网

访问官网 Github

Github 论文

论文