CoT-Collection

本仓库用于论文"The CoT Collection: 通过思维链微调改进语言模型的零样本和少样本学习",包含从1,060个任务中提取的184万条CoT推理。

论文链接:https://arxiv.org/abs/2305.14045

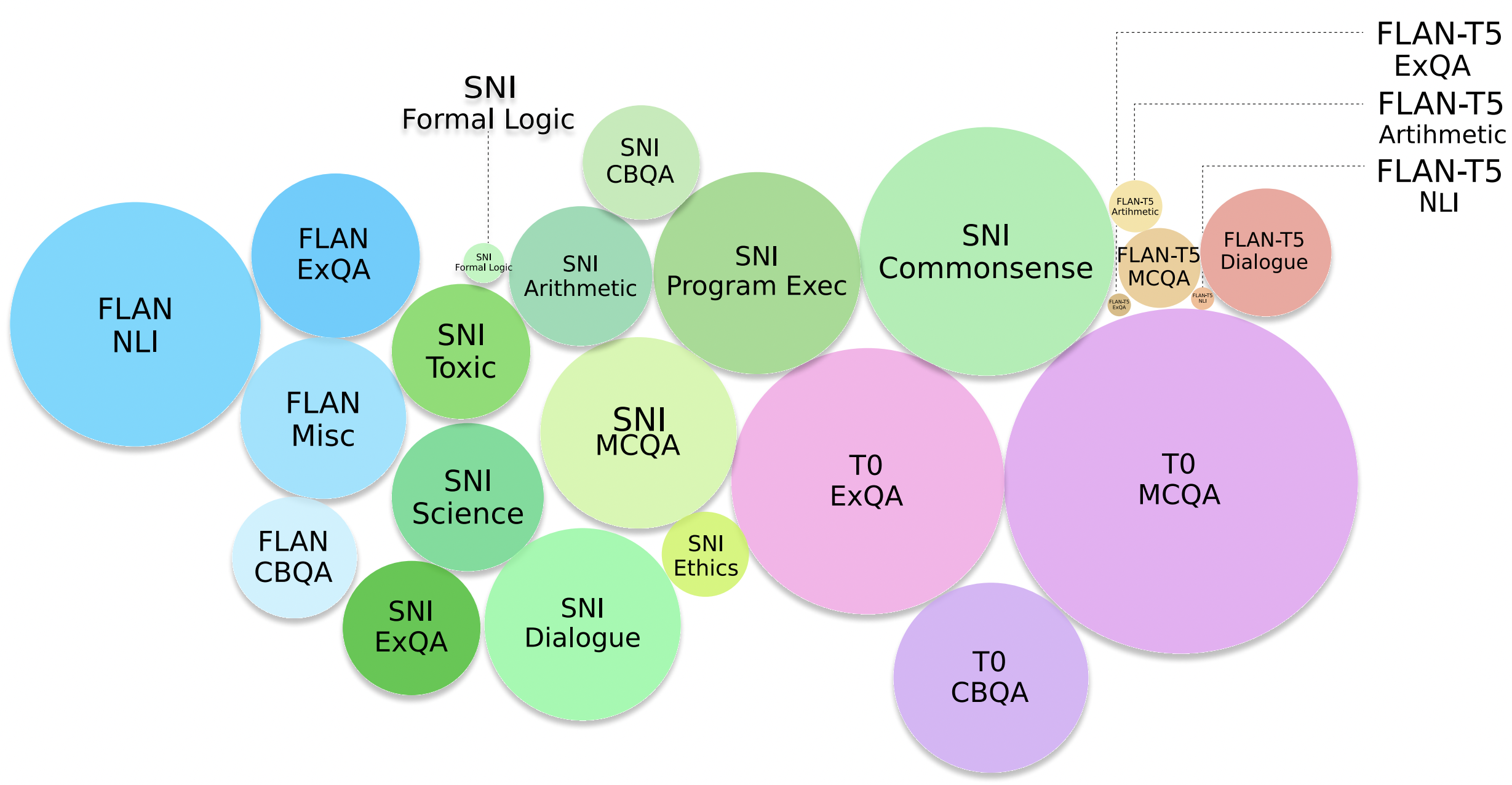

CoT Collection概览

数据集访问

您可以通过huggingface datasets库访问CoT Collection,如下所示:

from datasets import load_dataset

dataset = load_dataset("kaist-ai/CoT-Collection")

模型检查点访问

您可以通过huggingface transformers库访问在CoT Collection上训练的CoT-T5,如下所示:

from transformers import AutoTokenizer, AutoModelForSeq2SeqLM

tokenizer = AutoTokenizer.from_pretrained("kaist-ai/CoT-T5-11B")

model = AutoModelForSeq2SeqLM.from_pretrained("kaist-ai/CoT-T5-11B")

请注意,我们有11B版本和3B版本的CoT-T5!

代码

我们目前正在重构代码!我们很快会上传:)

推理增强

sh scripts/{subset}.sh # flan, sni, t0, t0p, additional

通过运行与CoTCollection数据子集对应的每个脚本,可以获得CoTCollection的推理。

在第一次运行时,系统会要求您提供OpenAI的API密钥。 这些密钥将作为api.json本地保存,并在将来的运行中重复使用。

结果,

- 增强过程中每个实例的结果将保存在"CoT_Rationale_Augmentation/outputs/{subset}/{model_name}/rat/temp_{temperature}/"下

- 所有增强过程完成后,合并的数据可以在"data_extraction/data/{split}/{subset}/codex_rationale_{split}_{phase}.json"中找到

许可

CoT Collection仅供非商业用途,并受OpenAI对生成数据的使用条款约束。如果您怀疑有任何违规行为,请与我们联系。

引用

如果您觉得这个有用,请考虑引用我们的论文:

@article{kim2023cot,

title={The CoT Collection: Improving Zero-shot and Few-shot Learning of Language Models via Chain-of-Thought Fine-Tuning},

author={Kim, Seungone and Joo, Se June and Kim, Doyoung and Jang, Joel and Ye, Seonghyeon and Shin, Jamin and Seo, Minjoon},

journal={arXiv preprint arXiv:2305.14045},

year={2023}

}

联系方式

如果您对论文的实现或内容有任何疑问,可以通过以下电子邮件联系我:)

seungone@kaist.ac.kr

Github

Github Huggingface

Huggingface 论文

论文