FeatUp: 适用于任意分辨率特征的模型无关框架

ICLR 2024

Stephanie Fu*、 Mark Hamilton*、 Laura Brandt、 Axel Feldman、 Zhoutong Zhang、 William T. Freeman *贡献相同。

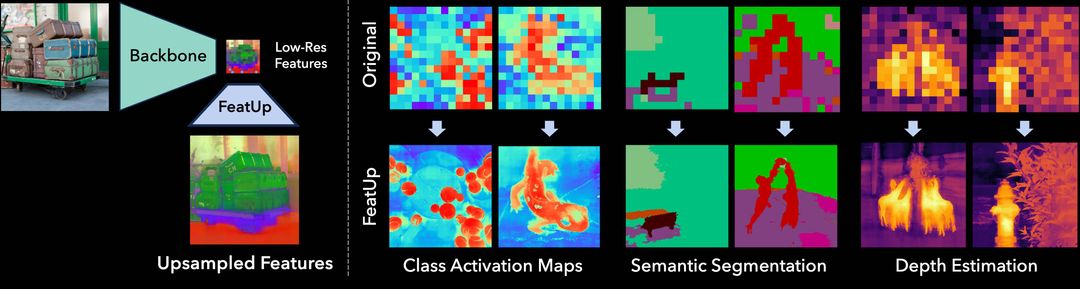

简述:FeatUp将任何模型的特征空间分辨率提高16-32倍,而不改变其语义。

https://github.com/mhamilton723/FeatUp/assets/6456637/8fb5aa7f-4514-4a97-aebf-76065163cdfd

目录

安装

Pip

如果只想快速使用FeatUp API,请通过以下命令安装:

pip install git+https://github.com/mhamilton723/FeatUp

本地开发

要安装FeatUp进行本地开发并获取示例图像,请使用以下命令安装:

git clone https://github.com/mhamilton723/FeatUp.git

cd FeatUp

pip install -e .

使用预训练的上采样器

要查看预训练模型使用示例,请参阅我们的Colab笔记本。我们目前提供以下FeatUp JBU上采样器的预训练版本:

| 模型名称 | 检查点 | 检查点(无LayerNorm) | Torch Hub仓库 | Torch Hub名称 |

|---|---|---|---|---|

| DINO | 下载 | 下载 | mhamilton723/FeatUp | dino16 |

| DINO v2 | 下载 | 下载 | mhamilton723/FeatUp | dinov2 |

| CLIP | 下载 | 下载 | mhamilton723/FeatUp | clip |

| MaskCLIP | 不适用 | 下载 | mhamilton723/FeatUp | maskclip |

| ViT | 下载 | 下载 | mhamilton723/FeatUp | vit |

| ResNet50 | 下载 | 下载 | mhamilton723/FeatUp | resnet50 |

例如,要加载DINO骨干网络的FeatUp JBU上采样器,且不对空间特征使用额外的LayerNorm:

upsampler = torch.hub.load("mhamilton723/FeatUp", 'dino16', use_norm=False)

要加载在骨干网络上训练的上采样器,并附加额外的LayerNorm操作(这使得训练和迁移学习更加稳定):

upsampler = torch.hub.load("mhamilton723/FeatUp", 'dino16')

为图像拟合隐式上采样器

要为给定图像和骨干网络训练隐式上采样器,首先克隆仓库并为本地开发安装。然后运行:

cd featup

python train_implicit_upsampler.py

此训练操作的参数可在隐式上采样器配置文件中找到。

本地Gradio演示

要在本地运行我们的HuggingFace Spaces托管的FeatUp演示,首先为本地开发安装FeatUp。然后运行:

python gradio_app.py

等待几秒钟让演示启动,然后导航到http://localhost:7860/查看演示。

即将推出:

- 训练您自己的FeatUp联合双边上采样器

- 隐式FeatUp训练的简单API

引用

@inproceedings{

fu2024featup,

title={FeatUp: A Model-Agnostic Framework for Features at Any Resolution},

author={Stephanie Fu and Mark Hamilton and Laura E. Brandt and Axel Feldmann and Zhoutong Zhang and William T. Freeman},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024},

url={https://openreview.net/forum?id=GkJiNn2QDF}

}

联系方式

如有反馈、问题或媒体咨询,请联系Stephanie Fu和Mark Hamilton

访问官网

访问官网 Github

Github Huggingface

Huggingface 论文

论文