基于静态分析的代码仓库上下文的监视器引导解码

替代标题:使用监视器通过全局上下文引导代码语言模型

引言

本仓库包含了发表在NeurIPS 2023会议上的论文"基于静态分析的代码仓库上下文的监视器引导解码"(arXiv版本:"使用监视器通过全局上下文引导代码语言模型")的官方代码和数据。该工作引入了监视器引导解码(MGD)用于代码生成语言模型,其中监视器利用静态分析来引导解码过程。

仓库内容

- 数据集: PragmaticCode和DotPrompts

- 评估脚本: 用于评估语言模型的脚本,接收DotPrompts示例的推理结果(模型生成的代码)作为输入,并生成论文中报告的指标的score@k分数:编译率(CR)、下一个标识符匹配(NIM)、标识符序列匹配(ISM)和前缀匹配(PM)。

- DotPrompts的推理结果: 论文中报告的各种模型配置在DotPrompts示例上生成的代码。通过对提供的推理结果运行评估脚本,可以重现论文中报告的图表。

multilspy: 一个跨平台库,旨在简化创建语言服务器客户端的过程,以查询和获取各种通过语言服务器协议通信的语言服务器的静态分析结果。multilspy旨在作为一个库,方便地查询各种语言服务器,而无需担心设置配置和实现语言服务器协议的客户端。multilspy目前支持运行Java、Rust、C#和Python的语言服务器,我们希望在社区的帮助下扩展这个列表。- 监视器引导解码: 实现了论文中报告的各种监视不同属性的监视器(例如:监视类型有效的标识符解引用、监视方法调用参数数量的正确性、监视方法调用序列的类型状态有效性等),涵盖3种编程语言。

multilspy库现已迁移到microsoft/multilspy。

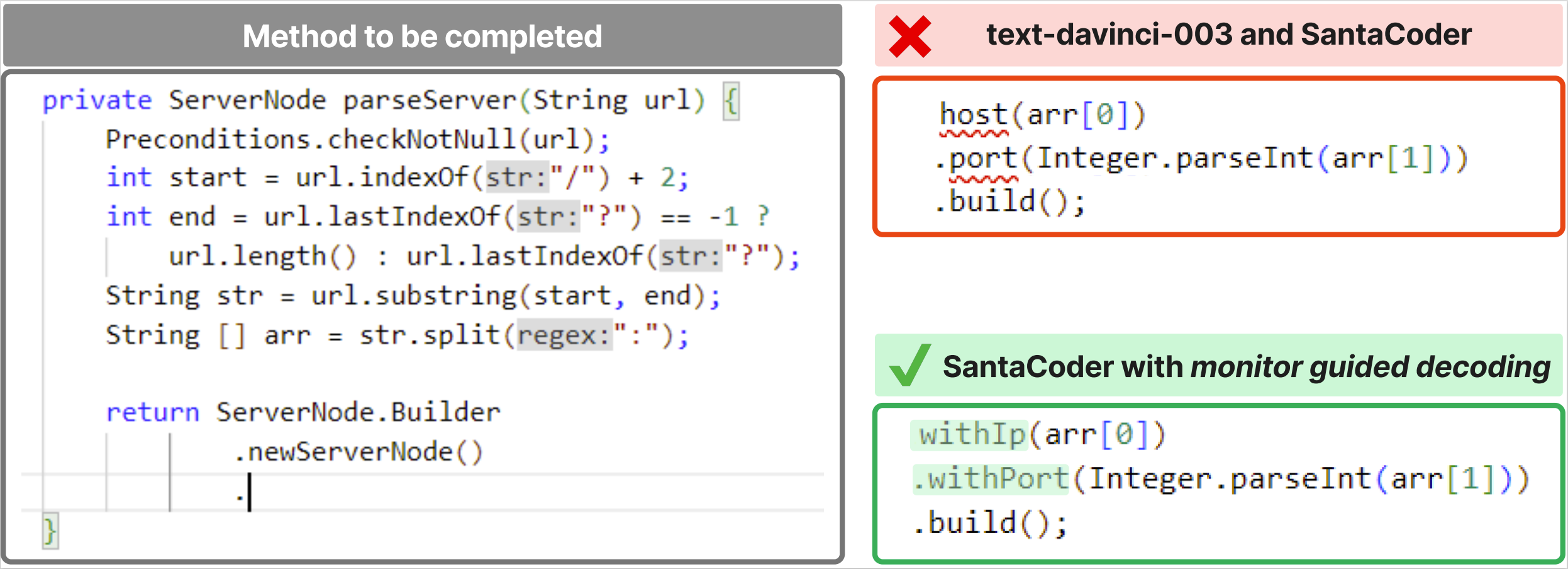

监视器引导解码:动机示例

例如,考虑下图中要完成的部分代码。要完成这段代码,语言模型必须生成与ServerNode.Builder.newServerNode()返回的对象类型一致的标识符。newServerNode方法及其返回类型ServerNode.Builder类在另一个文件中定义。如果语言模型没有关于ServerNode.Builder类型的信息,就会产生幻觉,如text-davinci-003和SantaCoder模型的示例生成所示。完成的代码使用了host和port标识符,这些标识符在ServerNode.Builder类型中不存在。因此,生成的代码会导致"找不到符号"的编译错误。

MGD使用静态分析来引导语言模型的解码,以生成遵循特定属性的代码。在示例中,MGD用于监视生成具有类型正确解引用的代码,使用相同提示的SantaCoder模型能够生成正确的代码完成,该代码可以编译并与地面真值匹配。

正如论文中报告的,我们观察到MGD可以将各种规模(350M-175B)的语言模型生成的代码的编译率提高19-25%,而无需任何训练/微调。此外,它还提高了从标记级到方法级代码完成的所有粒度的地面真值匹配。

1. 数据集

数据集统计

| PragmaticCode中的仓库数量 | 100 |

| DotPrompts中的方法数量 | 1420 |

| DotPrompts中的示例数量 | 10538 |

PragmaticCode

PragmaticCode是一个真实世界开源Java项目的数据集,包括它们的开发环境和依赖项(通过各自的构建系统)。作者试图确保PragmaticCode中的所有仓库都是在确定的CodeGen、SantaCoder和text-davinci-003系列模型的训练数据集截止日期(2022年3月31日)之后才公开发布的,这些模型用于评估MGD。

完整的数据集,包括仓库zip文件,可在我们的Zenodo数据集发布中获得:https://zenodo.org/records/10072088。构成PragmaticCode的仓库列表及其各自的许可证可在datasets/PragmaticCode/repos.csv中找到。每个仓库推理所需的文件内容可在datasets/PragmaticCode/fileContentsByRepo.json中找到。

DotPrompts

DotPrompts是从PragmaticCode派生的一组示例,每个示例包含一个解引用位置的提示(Java中包含"."运算符的代码位置)。DotPrompts可用于基准测试代码语言模型利用仓库级上下文生成方法级完成任务代码的能力。模型的任务是完成一个部分编写的Java方法,利用PragmaticCode提供的完整仓库。由于PragmaticCode中的所有仓库都是可构建的,DotPrompts(源自PragmaticCode)支持编译率作为生成代码评估的指标,除了标准的地面真值匹配指标,如下一个标识符匹配、标识符序列匹配和前缀匹配。

上面的动机示例中描述的场景是DotPrompts中的一个示例。

DotPrompts中示例的完整描述是一个元组 - (repo, classFileName, methodStartIdx, methodStopIdx, dot_idx)。数据集可在datasets/DotPrompts/dataset.csv中获得。

2. 评估脚本

环境设置

我们使用 requirements.txt 中列出的 Python 包。我们的实验使用 Python 3.10。建议在独立的虚拟环境中安装相同的版本及其依赖项。使用 venv 创建虚拟环境:

python3 -m venv venv_monitors4codegen

source venv_monitors4codegen/bin/activate

或使用 conda:

conda create -n monitors4codegen python=3.10

conda activate monitors4codegen

有关创建 Python 虚拟环境的更多详细信息和说明,可以在官方文档中找到。此外,我们还建议用户使用 Miniconda,作为上述创建虚拟环境步骤的替代方案。

要安装运行评估所需的依赖项,如下文所述:

pip3 install -r requirements.txt

运行评估脚本

评估脚本可以按以下方式运行:

python3 eval_results.py <推理结果的 csv 文件路径> <PragmaticCode 文件内容的 json 文件路径> <输出目录路径>

上述命令将创建一个目录 <输出目录路径>,其中包含论文中报告的所有图表以及额外详细信息。该命令还会在输出目录中生成一个名为 Report.md 的报告,将生成的图表与论文中的各个部分关联起来。

为确保环境设置正确,请运行以下命令,该命令在样本数据(包含在 inference_results/dotprompts_results_sample.csv 中)上运行评估脚本。如果命令失败,表示环境设置出错,作者请您kindly报告该问题。

python3 evaluation_scripts/eval_results.py inference_results/dotprompts_results_sample.csv datasets/PragmaticCode/fileContentsByRepo.json results_sample/

推理结果 csv 文件格式说明

评估脚本输入的推理结果 csv 文件中预期列的说明:

repo:测试用例来源的仓库名称classFileName:包含测试用例提示位置的文件的相对路径methodStartIdx:方法起始'{'的字符串索引methodStopIdx:方法结束'}'的字符串索引dot_idx:作为解引用提示点的'.'的字符串索引configuration:用于生成给定代码样本的配置标识。值来自:['SC-classExprTypes', 'CG-6B', 'SC-FIM-classExprTypes', 'SC-RLPG-MGD', 'SC-MGD', 'SC-FIM-classExprTypes-MGD', 'CG-2B', 'SC', 'CG-2B-MGD', 'CG-350M-classExprTypes-MGD', 'SC-FIM', 'TD-3', 'CG-350M-MGD', 'SC-FIM-MGD', 'SC-RLPG', 'CG-350M', 'CG-350M-classExprTypes', 'SC-classExprTypes-MGD', 'CG-6B-MGD', 'TD-3-MGD']temperature:用于采样的温度。值来自:[0.8, 0.6, 0.4, 0.2]model:用于采样的模型名称。值来自:['Salesforce/codegen-6B-multi', 'bigcode/santacoder', 'Salesforce/codegen-2B-multi', 'Salesforce/codegen-350M-multi', 'text-davinci-003']context:使用的解码策略。值来自:['autoregressive', 'fim']prefix:使用的提示策略。值来自:['classExprTypes', 'none', 'rlpg']rlpg_best_rule_name:用于创建 RLPG 提示的规则名称(如果用于相应的测试用例)。值来自:[nan, 'in_file#lines#0.25', 'in_file#lines#0.5', 'in_file#lines#0.75', 'import_file#method_names#0.5']output:模型生成的输出compilationSucceeded:在完整仓库上下文中编译生成的方法的结果。成功为 1,否则为 0。值来自:[1, 0]

3. DotPrompts 上的推理结果

我们提供了论文中报告的所有模型配置在 DotPrompts 的每个示例上生成的所有推理(生成的代码)。这包括 18 种不同模型配置(涵盖参数规模、提示模板、FIM 上下文的使用等)对 DotPrompts 中每个示例的 6 次独立采样生成。

按照上述格式生成的样本及其编译状态可在 inference_results/dotprompts_results.csv 中获取。该文件使用 git lfs 存储。如果克隆此仓库后本地无法获取该文件,请查看 git lfs 网站 了解设置说明,并在 git lfs 设置后再次克隆仓库。

文件中的每一行都包含几个多行字符串单元格,因此,在使用 Microsoft Office Excel 等工具查看时,请启用"自动换行"以便查看完整内容。

要在推理结果上运行评估脚本,以重现论文中报告的图表,请运行:

python3 evaluation_scripts/eval_results.py inference_results/dotprompts_results.csv datasets/PragmaticCode/fileContentsByRepo.json results/

上述命令会创建一个目录 results(已包含在仓库中),其中包含论文中提供的所有图表以及额外详细信息。该命令还会在输出目录中生成一个报告,将生成的图表与论文中的各个部分关联起来。对于上述命令,报告生成在 results/Report.md。

4. multilspy

multilspy 库现已迁移至 microsoft/multilspy。

multilspy是一个跨平台库,我们构建它用于以统一和简便的方式设置和与各种语言服务器交互。语言服务器是对源代码执行各种静态分析并通过语言服务器协议(LSP)提供有用信息的工具,如类型导向的代码补全建议、符号定义位置、符号引用等。multilspy旨在简化使用语言服务器的过程,它抽象了语言服务器的设置、执行特定语言的配置以及通过基于json-rpc的协议与服务器通信的处理,同时向用户提供简单的接口。

由于LSP与语言无关,multilspy可以通过通用接口提供不同语言代码的静态分析结果。multilspy可以轻松扩展到任何有语言服务器的语言,目前支持Java、Rust、C#和Python,我们计划支持更多来自语言服务器实现列表的语言服务器。

multilspy可以提供的一些分析结果包括:

- 查找函数或类的定义

- 查找函数的调用者或类的实例化

- 提供基于类型的解引用补全

- 获取悬停在符号上时显示的信息,如方法签名

- 获取给定文件中定义的所有符号的列表/树,包括类、方法等符号类型

- 请创建问题/PR以添加上面未列出的任何其他LSP请求

安装

要使用pip安装multilspy,请执行以下命令:

pip install https://github.com/microsoft/multilspy/archive/main.zip

使用

使用示例:

from multilspy import SyncLanguageServer

from multilspy.multilspy_config import MultilspyConfig

from multilspy.multilspy_logger import MultilspyLogger

...

config = MultilspyConfig.from_dict({"code_language": "java"}) # 还支持"python"、"rust"、"csharp"

logger = MultilspyLogger()

lsp = SyncLanguageServer.create(config, logger, "/abs/path/to/project/root/")

with lsp.start_server():

result = lsp.request_definition(

"relative/path/to/code_file.java", # 发出请求的位置的文件名

163, # 请求符号的行号

4 # 请求符号的列号

)

result2 = lsp.request_completions(

...

)

result3 = lsp.request_references(

...

)

result4 = lsp.request_document_symbols(

...

)

result5 = lsp.request_hover(

...

)

...

multilspy还提供了一个基于asyncio的API,可以在异步上下文中使用。使用示例(asyncio):

from multilspy import LanguageServer

...

lsp = LanguageServer.create(...)

async with lsp.start_server():

result = await lsp.request_definition(

...

)

...

文件microsoft/multilspy - src/multilspy/language_server.py提供了multilspy API。microsoft/multilspy - tests/multilspy/下的几个multilspy测试提供了详细的multilspy使用示例。可以通过运行以下命令执行这些测试:

pytest tests/multilspy

5. 监控引导解码

在监控引导解码框架下,监控器使用multilspy作为LSP客户端实例化,并提供maskgen来引导LM解码。监控器接口在文件src/monitors4codegen/monitor_guided_decoding/monitor.py中定义为Monitor类。该接口由支持不同属性的各种监控器实现,如有效标识符解引用、有效参数数量、有效类型状态方法调用等。

使用HuggingFace模型的MGD

src/monitors4codegen/monitor_guided_decoding/hf_gen.py提供了MGDLogitsProcessor类,可以与任何HuggingFace语言模型一起使用,作为LogitsProcessor来使用MGD引导LM。使用SantaCoder模型的示例可在tests/monitor_guided_decoding/test_dereferences_monitor_java.py中找到。

使用OpenAI模型的MGD

src/monitors4codegen/monitor_guided_decoding/openai_gen.py提供了openai_mgd方法,它接受提示和Monitor作为输入,并返回使用OpenAI模型的MGD引导生成。

监控器

解引用监控器

src/monitors4codegen/monitor_guided_decoding/monitors/dereferences_monitor.py提供了解引用监控器的Monitor类实例化。它可以用来引导LM生成有效的标识符解引用。解引用监控器的单元测试位于tests/monitor_guided_decoding/test_dereferences_monitor_java.py,其中还提供了解引用监控器的使用示例。

监控函数调用的有效参数数量

src/monitors4codegen/monitor_guided_decoding/monitors/numargs_monitor.py 提供了numargs_monitor的Monitor类实例化。它可以用来指导语言模型生成正确数量的函数调用参数。单元测试(同时也提供了使用示例)位于 tests/monitor_guided_decoding/test_numargs_monitor_java.py。

监控类型状态规范

类型状态分析用于确保对象的方法按照API契约提供的顺序约束被正确调用。Rust的类型状态监控器使用示例可在单元测试文件 tests/monitor_guided_decoding/test_typestate_monitor_rust.py 中找到。

Switch-Enum 监控器

src/monitors4codegen/monitor_guided_decoding/monitors/switch_enum_monitor.py 提供了用于生成C#中有效命名枚举常量的Monitor实例化。Switch-enum监控器的单元测试位于 tests/monitor_guided_decoding/test_switchenum_monitor_csharp.py,其中也提供了switch-enum监控器的使用示例。

类实例化监控器

src/monitors4codegen/monitor_guided_decoding/monitors/class_instantiation_monitor.py 提供了用于在Java代码库中生成有效类实例化(跟随'new ')的Monitor实例化。类实例化监控器的单元测试(提供了使用示例)位于 tests/monitor_guided_decoding/test_classinstantiation_monitor_java.py。

联合监控

可以同时使用多个监控器来指导语言模型遵守多个属性。使用两个监控器联合的示例演示位于 tests/monitor_guided_decoding/test_joint_monitors.py。

常见问题解答(FAQ)

执行MGD测试时出现asyncio相关的运行时错误

如果你遇到以下错误:

RuntimeError: Task <Task pending name='Task-2' coro=<_AsyncGeneratorContextManager.__aenter__() running at

python3.8/contextlib.py:171> cb=[_chain_future.<locals>._call_set_state() at

python3.8/asyncio/futures.py:367]> got Future <Future pending> attached to a different loop python3.8/asyncio/locks.py:309: RuntimeError

请确保你使用Python >=3.10创建了一个新环境。更多详情,请查看StackOverflow讨论。

贡献

本项目欢迎贡献和建议。大多数贡献需要你同意一份贡献者许可协议(CLA),声明你有权利,并且实际上授予我们使用你贡献的权利。详情请访问 https://cla.opensource.microsoft.com 。

当你提交拉取请求时,CLA机器人会自动确定你是否需要提供CLA,并适当地修饰PR(例如,状态检查、评论)。只需按照机器人提供的说明操作即可。你只需在所有使用我们CLA的仓库中执行一次这个操作。

本项目已采用Microsoft开源行为准则。 更多信息请参见行为准则常见问题解答或联系 opencode@microsoft.com 获取任何其他问题或意见。

商标

本项目可能包含项目、产品或服务的商标或标识。Microsoft 商标或标识的授权使用必须遵循并符合 Microsoft的商标和品牌指南。 在本项目的修改版本中使用Microsoft商标或标识不得造成混淆或暗示Microsoft赞助。 任何第三方商标或标识的使用都要遵守这些第三方的政策。

访问官网

访问官网 Github

Github Huggingface

Huggingface 文档

文档 论文

论文