🛰️ SatCLIP - 全球通用地理位置编码器

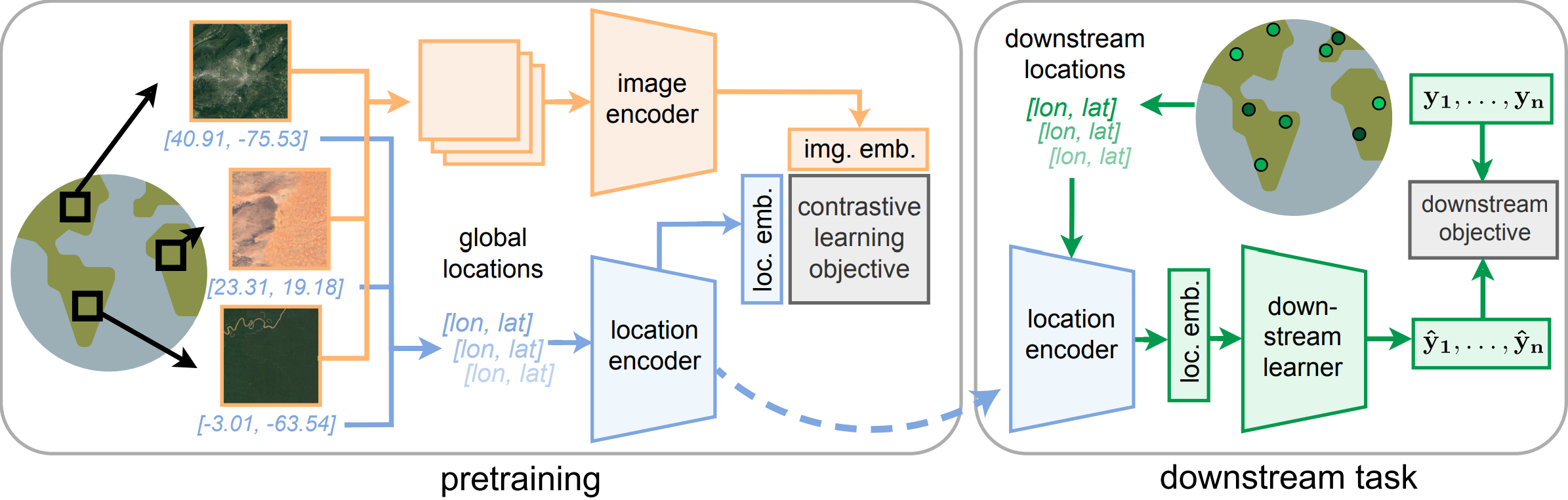

SatCLIP预训练和部署流程概览。

方法

SatCLIP通过对比学习训练位置和图像编码器,将图像与其对应的位置进行匹配。这类似于CLIP方法,后者将图像与相应的文本进行匹配。通过这个过程,位置编码器学习卫星图像所代表的位置特征。更多详细信息,请查看我们的论文。

概述

SatCLIP的使用非常简单:

from model import *

from location_encoder import *

model = SatCLIP(

embed_dim=512,

image_resolution=224, in_channels=13, vision_layers=4, vision_width=768, vision_patch_size=32, # 图像编码器

le_type='sphericalharmonics', pe_type='siren', legendre_polys=10, frequency_num=16, max_radius=360, min_radius=1, harmonics_calculation='analytic' # 位置编码器

)

img_batch = torch.randn(32, 13, 224, 224) # 表示32张图像的批次

loc_batch = torch.randn(32, 2) # 表示对应的32个位置(经度/纬度)

with torch.no_grad():

logits_per_image, logits_per_coord = model(img_batch, loc_batch)

probs = logits_per_image.softmax(dim=-1).detach().cpu().numpy()

训练

首先,您需要在/data/s2中下载S2-100k数据集。先下载索引文件:

cd data/s2

wget https://satclip.z13.web.core.windows.net/satclip/index.csv

在/data/s2中,进入/images目录,下载所有图像并解压:

cd images

wget https://satclip.z13.web.core.windows.net/satclip/satclip.tar

tar -xf satclip.tar

现在,要训练SatCLIP模型,请设置正确的路径,调整satclip/configs/default.yaml中的训练配置,然后运行以下命令训练SatCLIP:

cd satclip

python main.py

S2-100K数据集的使用

S2-100K数据集是通过Microsoft Planetary Computer从Sentinel-2采样的100,000张多光谱卫星图像集。Copernicus Sentinel数据采集于2021年1月1日至2023年5月17日之间。该数据集在陆地上大致均匀采样,且仅包含无云覆盖的图像。该数据集仅供研究目的使用。如果您使用该数据集,请引用我们的论文。更多关于数据集的信息可以在我们的论文中找到。

预训练模型

全球不同位置通过不同位置编码器获得的嵌入可视化。

我们提供六个预训练的SatCLIP模型,这些模型使用不同的视觉编码器和空间分辨率超参数$L$进行训练(这些表示用于球谐函数位置编码的勒让德多项式数量。更多详细信息请参阅我们的论文)。预训练模型可以通过以下方式下载:

- SatCLIP-ResNet18-L10:

wget https://satclip.z13.web.core.windows.net/satclip/satclip-resnet18-l10.ckpt - SatCLIP-ResNet18-L40:

wget https://satclip.z13.web.core.windows.net/satclip/satclip-resnet18-l40.ckpt - SatCLIP-ResNet50-L10:

wget https://satclip.z13.web.core.windows.net/satclip/satclip-resnet50-l10.ckpt - SatCLIP-ResNet50-L40:

wget https://satclip.z13.web.core.windows.net/satclip/satclip-resnet50-l40.ckpt - SatCLIP-ViT16-L10:

wget https://satclip.z13.web.core.windows.net/satclip/satclip-vit16-l10.ckpt - SatCLIP-ViT16-L40:

wget https://satclip.z13.web.core.windows.net/satclip/satclip-vit16-l40.ckpt

预训练模型的使用非常简单:

from load import get_satclip

device = 'cuda'

c = torch.randn(32, 2) # 表示32个位置的批次(经度/纬度)

model = get_satclip('path_to_satclip', device=device) #默认只加载位置编码器

model.eval()

with torch.no_grad():

emb = model(c.double().to(device)).detach().cpu()

您也可以通过Hugging Face直接访问SatCLIP模型权重。

示例

关于如何获取和使用预训练的SatCLIP嵌入的示例可以在notebooks文件夹中找到。我们提供了以下用例的笔记本(针对Google Colab使用进行了优化)。

设置:

示例用例:

使用基线预训练位置编码器:

引用

@article{klemmer2023satclip,

title={SatCLIP: Global, General-Purpose Location Embeddings with Satellite Imagery},

author={Klemmer, Konstantin and Rolf, Esther and Robinson, Caleb and Mackey, Lester and Ru{\ss}wurm, Marc},

journal={arXiv preprint arXiv:2311.17179},

year={2023}

}

贡献

本项目欢迎贡献和建议。大多数贡献都要求您同意贡献者许可协议(CLA),声明您有权并确实授予我们使用您贡献的权利。有关详细信息,请访问 https://cla.opensource.microsoft.com。

当您提交拉取请求时,CLA机器人会自动确定您是否需要提供CLA,并适当地修饰PR(例如,状态检查、评论)。只需按照机器人提供的说明操作即可。您只需在所有使用我们CLA的存储库中执行一次此操作。 本项目已采用Microsoft开源行为准则。 欲了解更多信息,请参阅行为准则常见问题或 联系opencode@microsoft.com提出任何其他问题或意见。

商标

本项目可能包含项目、产品或服务的商标或标志。Microsoft商标或标志的授权使用必须遵循 Microsoft商标和品牌使用指南。 在本项目的修改版本中使用Microsoft商标或标志时,不得引起混淆或暗示Microsoft赞助。 任何第三方商标或标志的使用均受该第三方的政策约束。

访问官网

访问官网 Github

Github Huggingface

Huggingface 论文

论文