UniTable:迈向统一的表格基础模型

- 📈 高性能表格结构识别变换器需要早期卷积。彭盛云、李成民、王晓静、Rajarajeswari Balasubramaniyan、Duen Horng Chau。发表于NeurIPS第二届表格表示学习研讨会,2023年。(口头报告)

- 🚀 表格结构识别变换器的自监督预训练。彭盛云、李成民、王晓静、Rajarajeswari Balasubramaniyan、Duen Horng Chau。发表于AAAI科学文献理解研讨会,2024年。(口头报告)

- 🆕 UniTable:通过自监督预训练迈向表格结构识别的统一框架。彭盛云、李成民、王晓静、Rajarajeswari Balasubramaniyan、Duen Horng Chau。ArXiv,2024年。

表格以人类创造的隐含约定传递事实和定量数据,这常常给机器解析带来挑战。以往的表格识别(TR)研究主要集中在现有输入和工具的复杂任务特定组合上。我们提出了UniTable,这是一个统一了TR的训练范式、训练目标和模型架构的训练框架。 其训练范式结合了纯像素级输入的简单性以及由来自多样未标注表格图像的自监督预训练(SSP)赋能的有效性和可扩展性。我们的框架将所有三个TR任务的训练——提取表格结构、单元格内容和单元格边界框(bbox)——统一为一个统一的与任务无关的训练目标:语言建模。广泛的定量和定性分析突显了UniTable在四个最大的TR数据集上的最先进(SOTA)性能。为了促进可复现研究、增强透明度和SOTA创新,我们发布了首创的Jupyter笔记本,包含整个推理流程,在多个TR数据集上进行了微调,支持所有三个TR任务。

本仓库包含线性投影变换器的代码。对于卷积主干(早期卷积)变换器,请查看我们的tsr-convstem仓库。

新闻

2024年4月 - 您可以在我们的Jupyter笔记本中完全数字化您自己的表格图像。

2024年4月 - UniTable v1.0.0现已上线,模型权重可在HuggingFace获取。

2024年2月 - 我们在AAAI'24上展示了"自监督预训练"论文。

2024年1月 - "自监督预训练"论文被选为口头报告。

2023年12月 - "自监督预训练"论文被AAAI'24科学文献理解研讨会接收。

2023年12月 - 我们在NeurIPS'23上展示了"早期卷积"论文。

2023年10月 - "早期卷积"论文被选为口头报告。

2023年10月 - "早期卷积"论文被NeurIPS'23表格表示学习研讨会接收。

快速开始

- 在终端运行

make .done_venv设置虚拟环境(unitable)。 - 在终端运行

make .done_download_weights从HuggingFace下载所有模型权重。 - 使用您自己的表格图像尝试我们的演示Jupyter笔记本!记得选择"unitable"作为您的笔记本内核。

训练

我们的代码由Makefile目标驱动,并通过Hydra进行配置。实验名称在CONFIG.mk实验部分中定义为EXP_<name>。我们还在每个实验上方的注释中提供了如何启动make目标的说明。

数据集标注格式

我们提供了PubTabNet的一小部分(20个样本)作为示例,以快速演示训练过程。数据集(表格图像和标注)可在dataset/mini_pubtabnet获取。所有图像的标注都在mini_pubtabnet_examples.jsonl中。每行是一个json对象,对应一个png图像,结构如下:

"filename": "'train'、'val'或'test'中的一个文件夹内的表格图像文件名",

"split": "'train'、'val'或'test'中的一个",

"html": "表格结构、单元格内容和单元格边界框",

"cells": "包含所有单元格内容和边界框的数组",

"tokens": "单元格内容的数组",

"bbox": "单元格的边界框,格式为[x1, y1, x2, y2]。仅在单元格非空时提供。",

"structure": "描述表格结构的字典",

"tokens": "描述表格结构的HTML标签数组。'[]'表示非空单元格",

如果您想在自己的数据集上进行训练,请根据提供的格式转换您的数据集。

我们在论文中使用的五个数据集是PubTabNet、SynthTabNet、FinTabNet、ICDAR 2019 B2 Modern和PubTables-1M。

下载这些数据集后,请在configs/dataset/root_dir。

跟踪您的训练进度

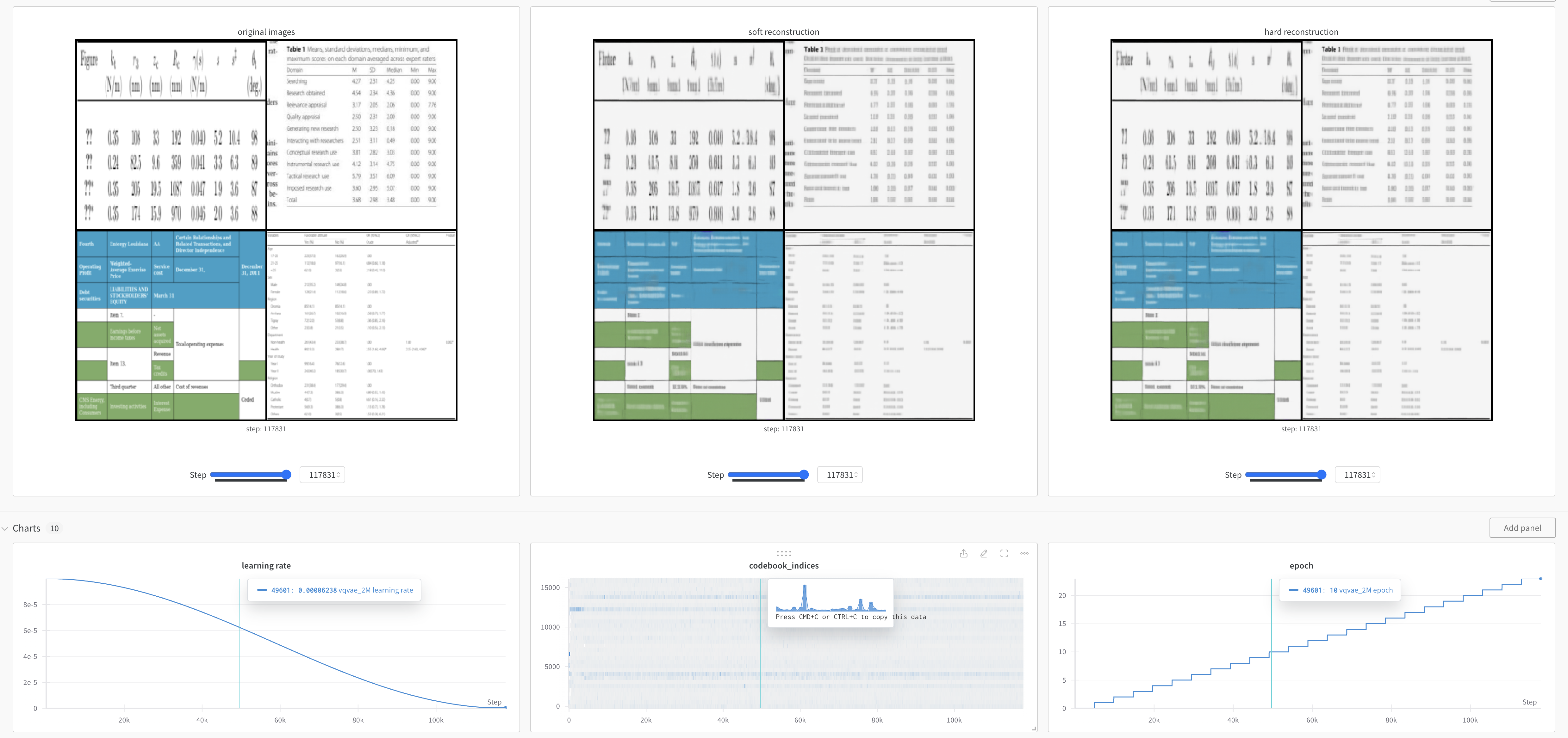

如果您想可视化训练曲线和重构的表格(仅适用于预训练VQ-VAE),请注册Weights & Biases账户。以下是VQ-VAE重构表格的示例:

微调

我们展示了在提供的mini-PubTabNet上进行微调。有关跨数据集微调的更多详情,请查看CONFIG.mk。

# 表格结构

make experiments/ssp_2m_mini_html_base/.done_finetune

# 单元格边界框

make experiments/ssp_2m_mini_bbox_base/.done_finetune

# 单元格内容

make experiments/ssp_2m_mini_cell_base/.done_finetune

预训练

我们展示了在提供的mini-PubTabNet上训练VQ-VAE和预训练视觉编码器。有关跨数据集微调的更多详情,请查看CONFIG.mk。

VQ-VAE

make experiments/vqvae_mini/.done_pretrain

SSP视觉编码器 - 掩码表格图像建模(MTIM)

make experiments/mtim_mini_base/.done_pretrain

多GPU

默认设置是单GPU,即Makefile中的NGPU := 1。要启用多GPU,请使用以下格式启动上述命令:CUDA_VISIBLE_DEVICES=0,1,2,3 make NGPU=4 experiment/<exp name>/.done_<training type>。

引用

@article{peng2024unitable,

title={UniTable: Towards a Unified Framework for Table Structure Recognition via Self-Supervised Pretraining},

author={Peng, ShengYun and Lee, Seongmin and Wang, Xiaojing and Balasubramaniyan, Rajarajeswari and Chau, Duen Horng},

journal={arXiv preprint},

year={2024}

}

@article{peng2024self,

title={Self-Supervised Pretraining for Table Structure Recognition Transformer},

author={Peng, ShengYun and Lee, Seongmin and Wang, Xiaojing and Balasubramaniyan, Rajarajeswari and Chau, Duen Horng},

journal={arXiv preprint},

year={2024}

}

@inproceedings{彭2023高性能, 标题={用于表格结构识别的高性能Transformer模型需要早期卷积}, 作者={彭安东尼 和 李成民 和 王晓静 和 巴拉苏布拉马尼扬·拉贾拉杰什瓦里·拉吉 和 周敦宏}, 会议论文集={NeurIPS 2023 第二届表格表示学习研讨会}, 年份={2023} }

## 联系方式

如果您有任何问题,请随时联系[彭安东尼](https://shengyun-peng.github.io/)(佐治亚理工学院计算机科学博士)。

Github

Github Huggingface

Huggingface 论文

论文