MedTrinity-25M:一个具有多粒度标注的大规模多模态医学数据集

MedTrinity-25M:一个具有多粒度标注的大规模多模态医学数据集

谢云飞*, 周策*, 高朗*, 吴俊成*, 李宪航, 周洪宇, 刘盛, 邢磊, 邹宇, 谢辞航, 周宇寅

📢 重大新闻

- [🔥2024年8月7日] 💥 我们的arxiv论文已发布。

- [🔥2024年7月21日] 💥 完整数据集已发布。

- [🔥2024年6月16日] 💥 演示数据集已发布。

如果您觉得有帮助,请给我们点个星 🌟 !

🚀 数据集

数据集构建流程

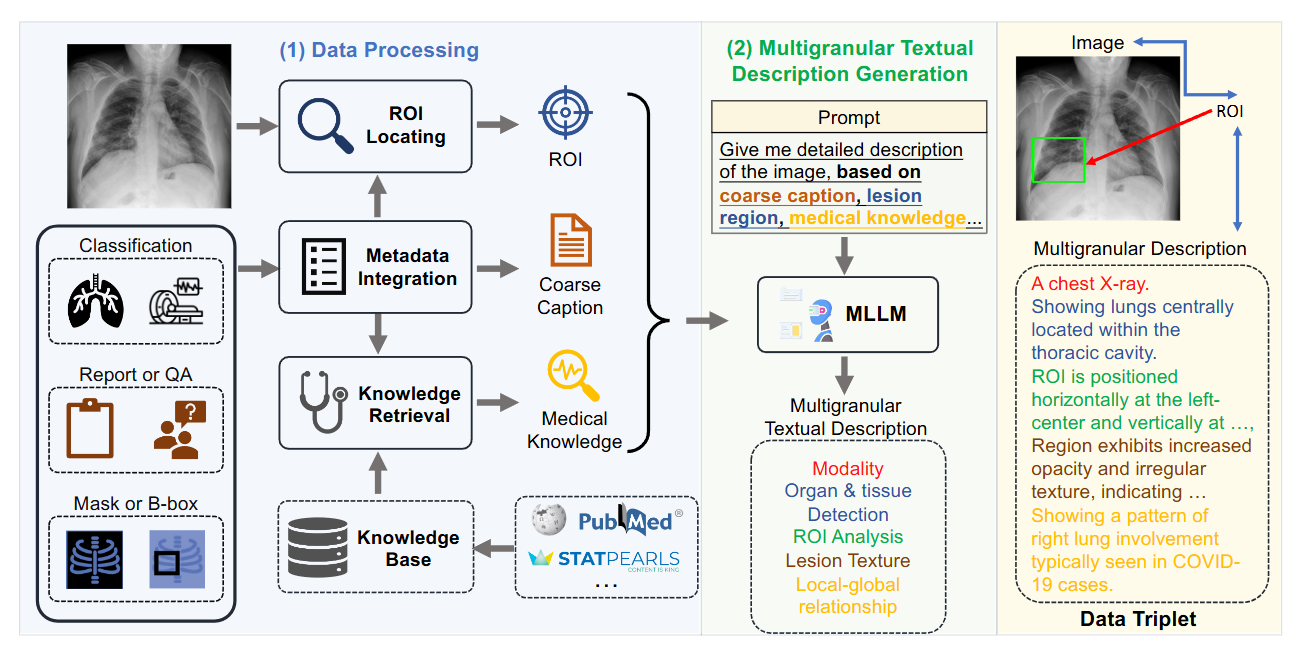

- 数据处理:从收集的数据中提取关键信息,包括元数据整合以生成粗粒度描述、感兴趣区域定位和医学知识收集。

- 多粒度文本描述生成:利用这些信息来引导大型语言模型生成细粒度描述。

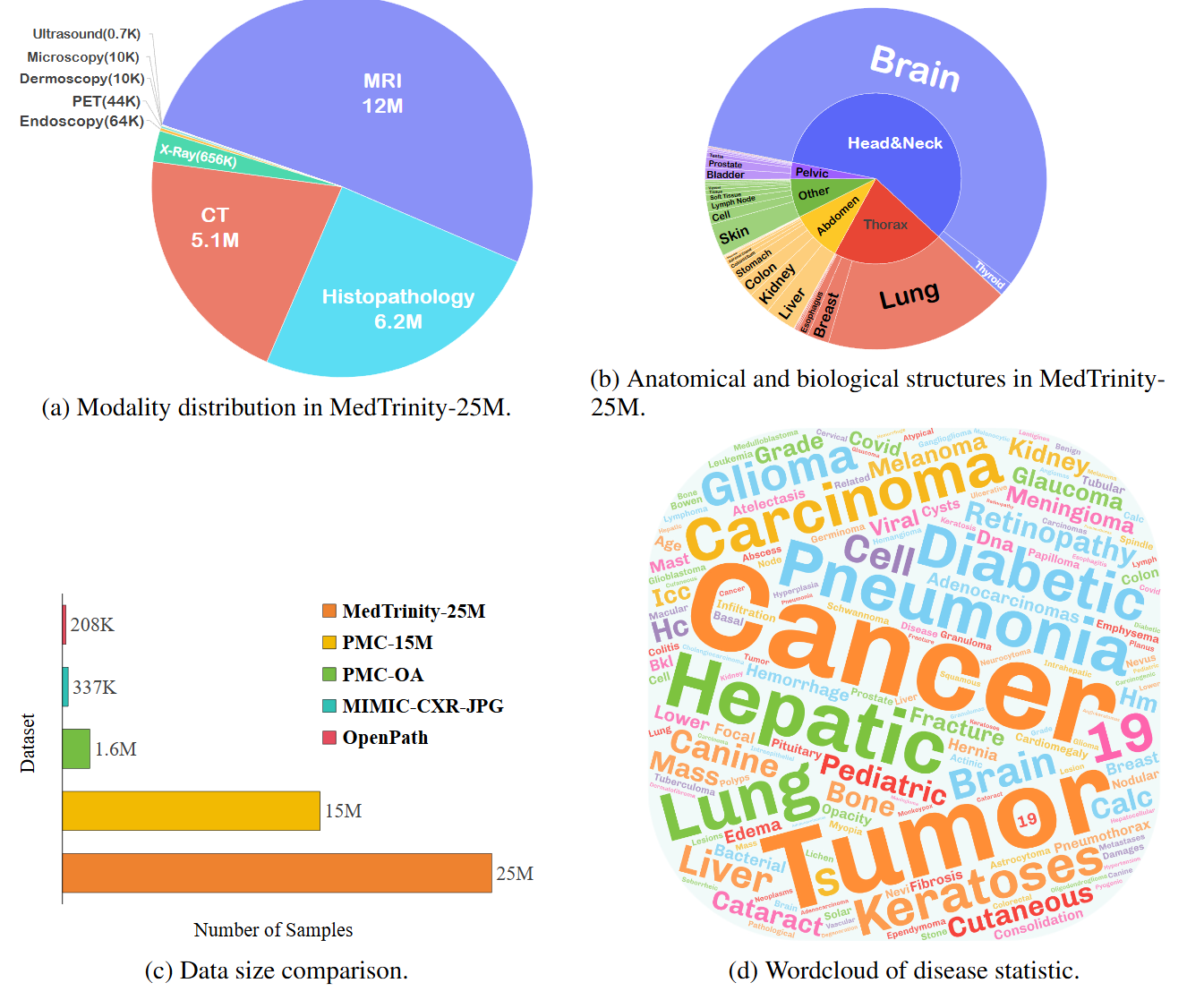

MedTrinity-25M的统计概览

数据集下载

| 数据集 | 🤗 Huggingface Hub |

|---|---|

| MedTrinity-25M | UCSC-VLAA/MedTrinity-25M |

🏆 结果

💬 快速开始

安装

使用Linux系统,

- 克隆此仓库并进入文件夹

git clone https://github.com/UCSC-VLAA/MedTrinity-25M.git

- 安装包

conda create -n llava-med++ python=3.10 -y

conda activate llava-med++

pip install --upgrade pip # 启用PEP 660支持

pip install -e .

- 安装训练所需的额外包

pip install -e ".[train]"

pip install flash-attn --no-build-isolation

pip install git+https://github.com/bfshi/scaling_on_scales.git

pip install multimedeval

升级到最新代码库

git pull

pip install -e .

# 如果升级时遇到一些导入错误,

# 请尝试运行以下命令(不带#)

# pip install flash-attn --no-build-isolation --no-cache-dir

🤖 模型库

下表概述了我们模型库中可用的模型。对于每个模型,您可以找到其Hugging Face页面或Google Drive文件夹的链接。

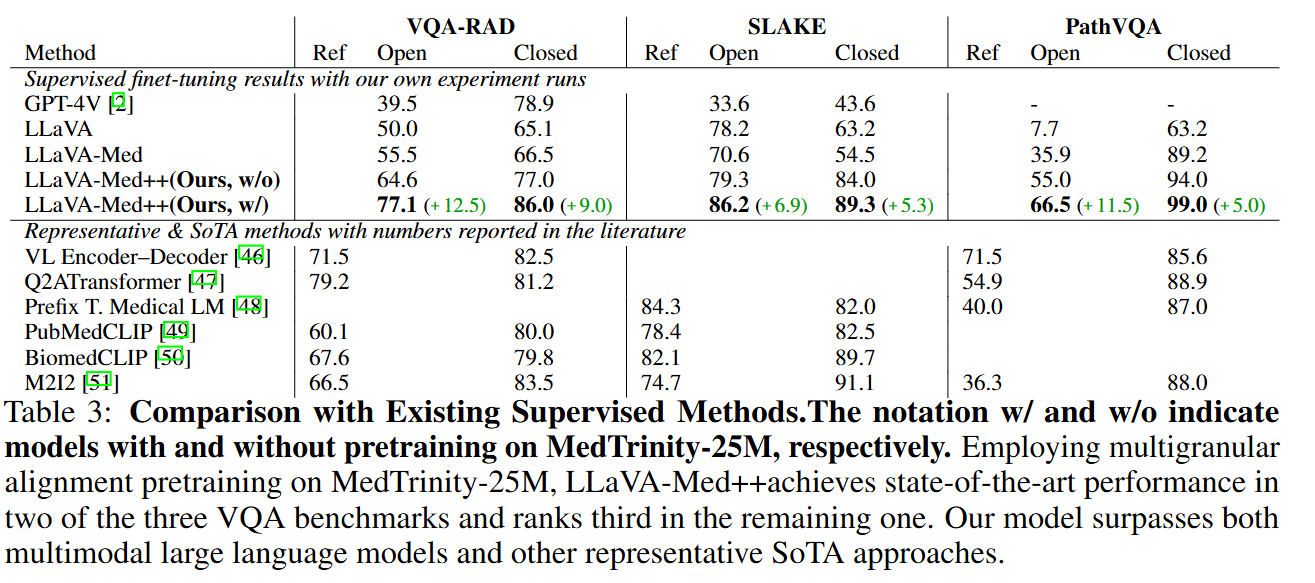

| 模型名称 | 链接 | 摘要 |

|---|---|---|

| LLaVA-Med++ (VQA-RAD) | 谷歌云盘 | 在LLaVA-Med数据和MedTrinity-25M(特别是VQA-RAD训练集子集)上预训练,在VQA-RAD训练集上微调。 |

| LLaVA-Med++ (SLAKE) | 谷歌云盘 | 在LLaVA-Med数据和MedTrinity-25M(特别是SLAKE训练集子集)上预训练,在SLAKE训练集上微调。 |

| LLaVA-Med++ (PathVQA) | 谷歌云盘 | 在LLaVA-Med数据和MedTrinity-25M(特别是PathVQA训练集子集)上预训练,在PathVQA训练集上微调。 |

| LLaVA-Med-Captioner | Hugging Face | 用于生成多粒度注释的字幕生成器,在MedTrinity-Instruct-200K(即将推出)上微调。 |

训练和评估LLaMA-Med++

首先,你需要下载基础模型LLaVA-Meta-Llama-3-8B-Instruct-FT-S2,并在LLaVA-Med中下载第一阶段和第二阶段的数据集。

- 预训练

# 第一阶段训练

cd MedTrinity-25M

bash ./scripts/med/llava3_med_stage1.sh

# 第二阶段训练

bash ./scripts/med/llava3_med_stage2.sh

- 微调

cd MedTrinity-25M

bash ./scripts/med/llava3_med_finetune.sh

- 评估 首先,你需要从模型库下载相应的权重,并更改评估脚本中的路径。 然后运行:

cd MedTrinity-25M

bash ./scripts/med/llava3_med_eval_batch_vqa_rad.sh

📜 引用

如果你发现MedTrinity-25M对你的研究和应用有用,请使用以下BibTeX进行引用:

@misc{xie2024medtrinity25mlargescalemultimodaldataset,

title={MedTrinity-25M: A Large-scale Multimodal Dataset with Multigranular Annotations for Medicine},

author={Yunfei Xie and Ce Zhou and Lang Gao and Juncheng Wu and Xianhang Li and Hong-Yu Zhou and Sheng Liu and Lei Xing and James Zou and Cihang Xie and Yuyin Zhou},

year={2024},

eprint={2408.02900},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2408.02900},

}

🙏 致谢

- 我们感谢微软加速基础模型研究计划、OpenAI研究人员访问计划、TPU研究云(TRC)计划、谷歌云研究积分计划、AWS云研究积分计划和Lambda Cloud支持我们的计算需求。

- 感谢我们所基于的LLaVA-pp、LLaVA-Med和LLaVA的代码库,以及我们具有惊人语言能力的基础模型LLaVA-Meta-Llama-3-8B-Instruct-FT-S2!

访问官网

访问官网 Github

Github Huggingface

Huggingface 论文

论文