CAGrad算法简介

在机器学习领域,多任务学习一直是一个充满挑战的研究方向。传统的多任务学习方法通常采用简单平均所有任务目标的策略,但这种方法往往会导致单个任务性能的严重下降。为了解决这一问题,研究人员开发出了冲突规避梯度下降(Conflict-Averse Gradient Descent, CAGrad)算法。

CAGrad的核心思想是在优化过程中,通过巧妙处理不同任务目标之间的梯度冲突来提高整体性能。该算法在2021年的神经信息处理系统会议(NeurIPS)上首次提出,迅速引起了学术界的广泛关注。

CAGrad的工作原理

CAGrad算法的主要目标是最小化平均损失函数,同时利用个别任务的最差局部改进来规范化算法轨迹。这种方法可以自动平衡不同任务的目标,并且理论上保证了对平均损失的收敛性。

具体来说,CAGrad通过以下步骤来实现其目标:

- 计算每个任务的梯度

- 分析任务梯度之间的冲突程度

- 根据冲突程度动态调整每个任务的优化方向

- 综合考虑所有任务,得出最终的优化方向

通过这种方式,CAGrad能够在保证整体性能的同时,尽可能地照顾到每个单独任务的优化需求。

CAGrad的优势

与传统的多任务学习方法相比,CAGrad具有以下几个显著优势:

-

自适应平衡: CAGrad能够根据任务间的冲突程度自动调整优化策略,无需人为设置权重。

-

理论保证: CAGrad在理论上保证了对平均损失函数的收敛,为算法的稳定性提供了坚实基础。

-

广泛适用性: CAGrad可以应用于各种多任务学习场景,包括监督学习和强化学习等。

-

性能提升: 在多个benchmark数据集上,CAGrad展现出了优于现有方法的性能。

CAGrad的应用场景

CAGrad在多个领域展现出了广阔的应用前景:

1. 图像到图像预测

在图像处理领域,CAGrad被应用于NYU-v2和CityScapes数据集上的多任务学习实验。这些实验涉及多个相关但不同的图像处理任务,如语义分割、深度估计等。CAGrad通过有效处理任务间的冲突,在整体性能上超越了传统方法。

2. 多任务强化学习(MTRL)

在强化学习领域,CAGrad被应用于Metaworld基准测试中。这些实验涉及同时学习多个相关但不同的控制任务。CAGrad的应用显著提高了agent在多个任务上的综合表现。

3. 玩具优化问题

为了直观展示CAGrad的工作原理,研究人员设计了一个简单的玩具优化问题。通过可视化优化过程,我们可以清楚地看到CAGrad如何在conflicting objectives之间寻找平衡点。

上图展示了CAGrad在一个简单的二维优化问题上的表现。可以看到,算法能够在两个相互冲突的目标之间找到一个平衡点,实现整体最优。

CAGrad的实际应用考量

在实际应用CAGrad时,有一些重要的技术细节需要注意:

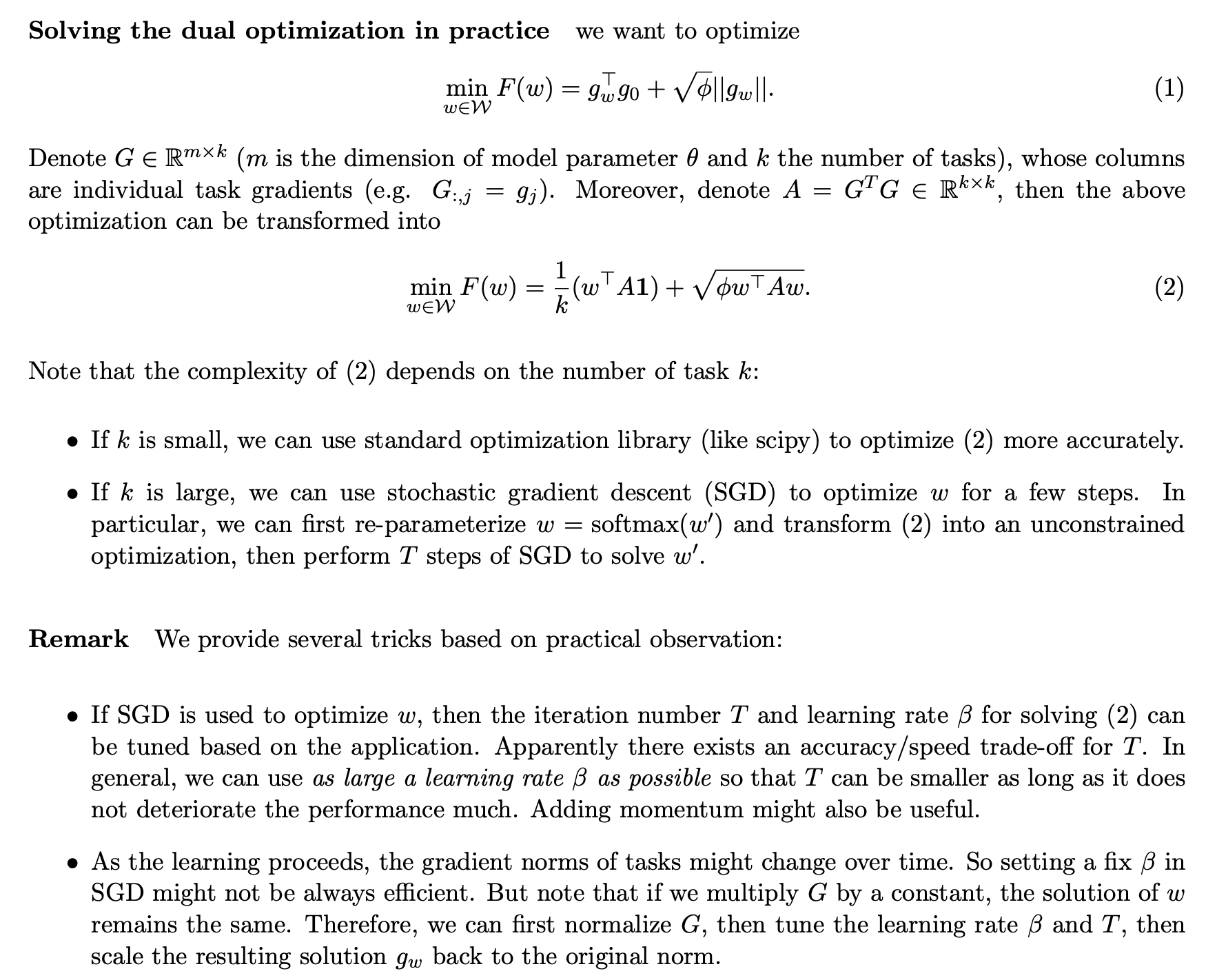

- 双重优化问题的求解: CAGrad的核心涉及一个双重优化问题的求解。下图展示了如何在实践中高效地解决这个问题:

-

GPU内存优化: 感谢社区贡献,研究人员发现将最后一个

backward(retain_graph=True)替换为简单的backward()可以显著节省GPU内存使用。 -

参数调优: 虽然CAGrad能够自适应地平衡任务,但在某些情况下,适当调整算法的超参数可能会带来更好的性能。

CAGrad的未来发展

尽管CAGrad已经展现出了强大的性能,但研究人员并未止步于此。最近,该团队又推出了一种改进版算法——FAMO (Fast Adaptive Multitask Optimization)。FAMO进一步优化了CAGrad的计算效率,主要通过以下两个创新:

- 确保所有任务目标尽可能以相等的速率优化

- 通过时间上的计算分摊,避免在多目标优化中计算所有任务梯度

这些改进使得FAMO在处理大规模多任务问题时更加高效,为CAGrad的实际应用开辟了新的可能性。

结论

冲突规避梯度下降(CAGrad)算法为多任务学习领域带来了新的突破。通过巧妙处理任务间的梯度冲突,CAGrad实现了在保证整体性能的同时,兼顾各个单独任务的优化需求。其在图像处理、强化学习等多个领域的成功应用,充分证明了该方法的有效性和广泛适用性。

随着FAMO等新版本的推出,我们有理由相信,基于CAGrad的多任务学习方法将在未来发挥更大的作用,为人工智能在复杂、多变的现实世界中的应用提供强有力的支持。

对于希望深入了解CAGrad的研究者和开发者,建议参考原始论文和官方PyTorch实现。同时,积极关注该领域的最新进展,如FAMO等新算法,也将有助于在实际应用中获得最佳性能。

参考文献

-

Liu, B., Liu, X., Jin, X., Stone, P., & Liu, Q. (2021). Conflict-Averse Gradient Descent for Multi-task Learning. Advances in Neural Information Processing Systems, 34.

-

Liu, B., Feng, Y., Stone, P., & Liu, Q. (2023). FAMO: Fast Adaptive Multitask Optimization. arXiv preprint arXiv:2306.03792.

通过深入理解和灵活运用CAGrad算法,研究人员和实践者可以更好地应对多任务学习中的挑战,为人工智能在各个领域的应用开辟新的可能性。🚀🧠💡