Recurrent Memory Transformer简介

Recurrent Memory Transformer(简称RMT)是由Aydar Bulatov等人在2022年提出的一种新型Transformer模型。它通过巧妙地结合递归结构和外部记忆机制,成功突破了传统Transformer在处理长序列时的瓶颈,能够有效建模长达100万个token的超长序列。这一突破性进展为自然语言处理、强化学习等领域带来了新的可能性。

RMT的核心机制

递归结构

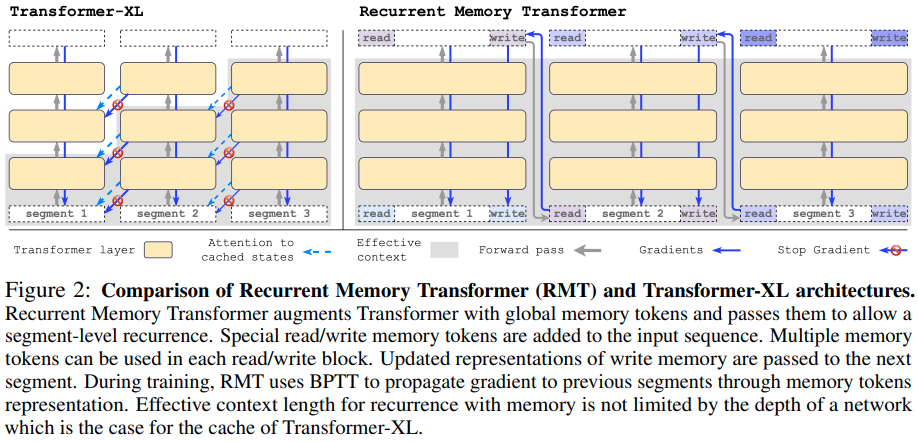

RMT的一个关键创新是引入了递归结构。不同于标准Transformer一次性处理整个序列,RMT将输入序列分割成多个片段,然后逐段处理。这种方法大大降低了内存需求,使得模型能够处理远超传统Transformer能力的超长序列。

外部记忆

RMT引入了外部记忆机制,用于存储和传递跨片段的信息。这个外部记忆由两部分组成:

- 写入记忆:用于捕获当前片段的关键信息。

- 读取记忆:从先前的片段中提取相关信息。

这种设计使得模型能够在处理新的输入片段时,有效利用之前片段的信息,从而实现对长期依赖关系的建模。

XL记忆增强

除了基本的外部记忆机制,RMT还引入了XL(eXtra Long)记忆增强技术。这种技术允许模型保留更长时间跨度的历史信息,进一步提升了模型处理超长序列的能力。

RMT的技术优势

-

超长序列建模:RMT能够处理长达100万个token的序列,这是传统Transformer难以企及的。

-

内存效率:通过递归结构和外部记忆机制,RMT大大降低了内存需求,使得在有限硬件资源下处理超长序列成为可能。

-

灵活性:RMT可以根据需要调整片段长度和记忆大小,以适应不同的任务需求。

-

信息传递效率:外部记忆机制确保了关键信息能够在超长序列中有效传递,避免了信息丢失。

-

可解释性:外部记忆的设计为模型决策提供了一定的可解释性,有助于理解模型的工作机制。

RMT的应用前景

自然语言处理

在自然语言处理领域,RMT的超长序列建模能力为以下任务带来了新的可能:

-

长文档理解:能够一次性处理整篇长文档,提高文档摘要、问答等任务的性能。

-

对话系统:可以维护更长的对话历史,提升长期一致性和上下文理解能力。

-

大规模语言模型:为训练更大规模的语言模型提供了新的思路,有望突破当前大语言模型的性能上限。

强化学习

RMT在强化学习领域也展现出了巨大潜力:

-

长期策略规划:能够基于更长的历史信息进行决策,适用于需要长期规划的复杂任务。

-

环境建模:可以更好地捕捉和利用环境中的长期依赖关系,提高agent的表现。

-

记忆增强型智能体:结合RMT的记忆机制,可以设计出具有更强记忆和推理能力的智能体。

时间序列分析

在金融、气象等领域的时间序列分析任务中,RMT的长序列建模能力可以:

- 捕捉更长时间跨度的模式和趋势。

- 提高对罕见事件和长期周期的预测能力。

多模态学习

RMT的架构也可以扩展到多模态学习领域:

- 视频理解:处理更长的视频序列,提升对长视频的理解和分析能力。

- 跨模态长序列关联:在文本-图像、音频-视频等多模态任务中建立长期依赖关系。

RMT的实现和使用

PyTorch实现的RMT已经开源,可以通过以下方式安装:

pip install recurrent-memory-transformer-pytorch

使用示例:

import torch

from recurrent_memory_transformer_pytorch import RecurrentMemoryTransformer

model = RecurrentMemoryTransformer(

num_tokens = 20000,

num_memory_tokens = 128,

dim = 512,

depth = 6,

causal = True,

dim_head = 64,

heads = 8,

seq_len = 1024,

use_flash_attn = True

)

x = torch.randint(0, 256, (1, 1024))

logits1, mem1, _ = model(x)

logits2, mem2, _ = model(x, mem1)

logits3, mem3, _ = model(x, mem2)

未来发展方向

尽管RMT已经展现出了强大的潜力,但仍有多个方向值得进一步探索:

- 算法优化:进一步提高模型的计算效率和内存使用效率。

- 架构改进:探索更高效的记忆机制和信息传递方式。

- 多任务学习:研究如何在RMT框架下更好地支持多任务学习。

- 可解释性:深入分析RMT的决策过程,提高模型的可解释性。

- 领域适应:针对不同应用领域,开发专门的RMT变体。

结语

Recurrent Memory Transformer为解决长序列建模问题提供了一个强大而灵活的框架。它不仅突破了传统Transformer的限制,还为各种需要处理长期依赖关系的任务开辟了新的可能性。随着进一步的研究和优化,RMT有望在自然语言处理、强化学习、时间序列分析等多个领域带来突破性进展,推动人工智能技术向着处理更复杂、更长期的任务迈进。

作为一项前沿技术,RMT的发展仍处于早期阶段。研究者和开发者应该密切关注这一领域的最新进展,积极探索RMT在各种实际应用中的潜力。同时,也要注意到RMT可能面临的挑战,如计算复杂度、模型解释性等问题,并在实际应用中权衡其利弊。

未来,随着硬件性能的提升和算法的进一步优化,我们有理由相信,RMT及其衍生技术将在人工智能领域扮演越来越重要的角色,为解决复杂的长期依赖问题提供强有力的工具。