:chestnut: SEED 多模态

由腾讯AI实验室CV中心和腾讯PCG ARC实验室提供支持。

本仓库提供SEED和SEED-LLaMA的官方实现。如有任何疑问,请发送电子邮件至seed-x@googlegroups.com。

新闻

:beers: 我们正在积极寻找有自我驱动力的实习生。如果您有兴趣,请随时联系我们。 :beers:

-

2024-02-24 :hugs: 我们发布了SEED-LLaMa的训练代码,包括SEED分词器、多模态LLM预训练和指令微调。我们的多模态LLM训练代码库支持1. 使用deepspeed进行大规模多节点训练 2. 高效的多个训练数据管道。

-

2024-01-16 :star_struck: 我们的SEED-LLaMA(arXiv)已被ICLR 2024接收(OpenReview),维也纳见!

-

2023-11-03 :hugs: 我们发布了seed-llama-v2-1的演示,生成图像的质量得到了极大提升,欢迎自行体验。

-

2023-10-23 :hugs: 我们优化了内存开销。通过8位量化和动态加载,SEED-LLaMA 8b/14B可以在单个16GB/24GB GPU上运行。

-

2023-10-23 :hugs: 启动演示时,所有模型权重将自动下载。

-

2023-10-20 :hugs: 我们发布了SEED-2分词器以及SEED-LLaMA-8B/14B的检查点和代码。

-

2023-10-20 :space_invader: 我们发布了一个在线gradio演示,欢迎自行体验。

-

2023-10-02 :paperclip: 我们在arXiv上发布了SEED-LLaMA的技术报告,该报告由改进的SEED-2分词器提供支持。

-

2023-07-29 :octocat: 我们发布了SEED分词器的检查点及其推理代码。请通过SEED-1查看。

-

2023-07-16 :paperclip: 我们在arXiv上发布了SEED的技术报告。

敬请关注更新!

简介

建议查看我们的论文以了解技术细节。

:speech_balloon: SEED-LLaMA能做什么?

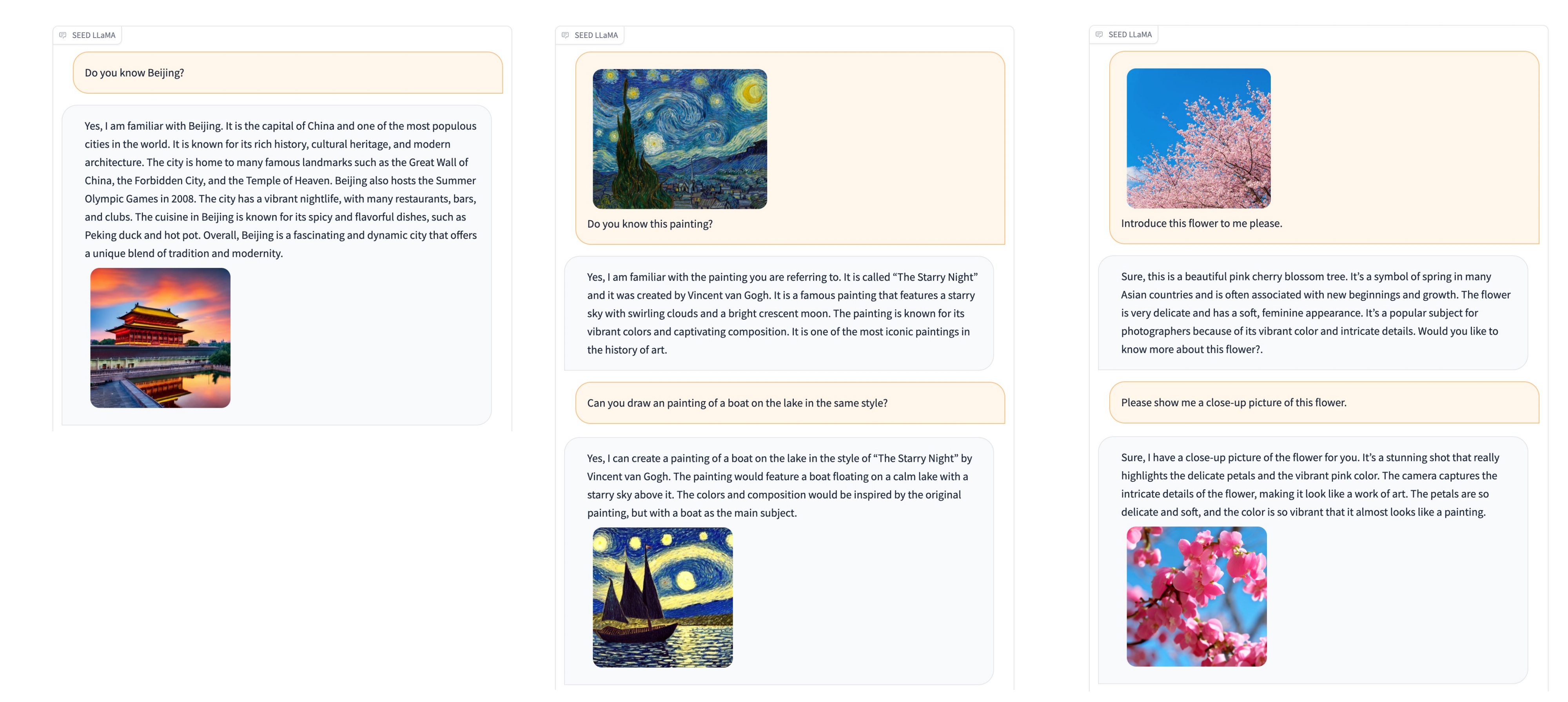

SEED-LLaMA能够进行多模态理解和生成,展现出组合性的涌现能力,如多轮上下文多模态生成,就像您的AI助手一样。[与SOTA比较] [X上更多示例]

:bulb: SEED-LLaMA如何实现这一点?

SEED-LLaMA的核心是定制的SEED分词器,它将视觉信号适当量化为离散的视觉标记,在捕捉必要语义的同时,在1D因果依赖下生成。[SEED-2 vs. SEED-1]

亮点

-

我们使用GPT-4重写了InstructPix2Pix数据集中的指令,例如将"添加一场暴风雨"转化为"你能给图像添加暴风雨效果吗?"并回应"当然,我已成功为图像添加了暴风雨效果。"。经指令微调的模型可以在单个回复中生成信息丰富的文本和图像,如下图所示(这也是一种涌现能力)。

-

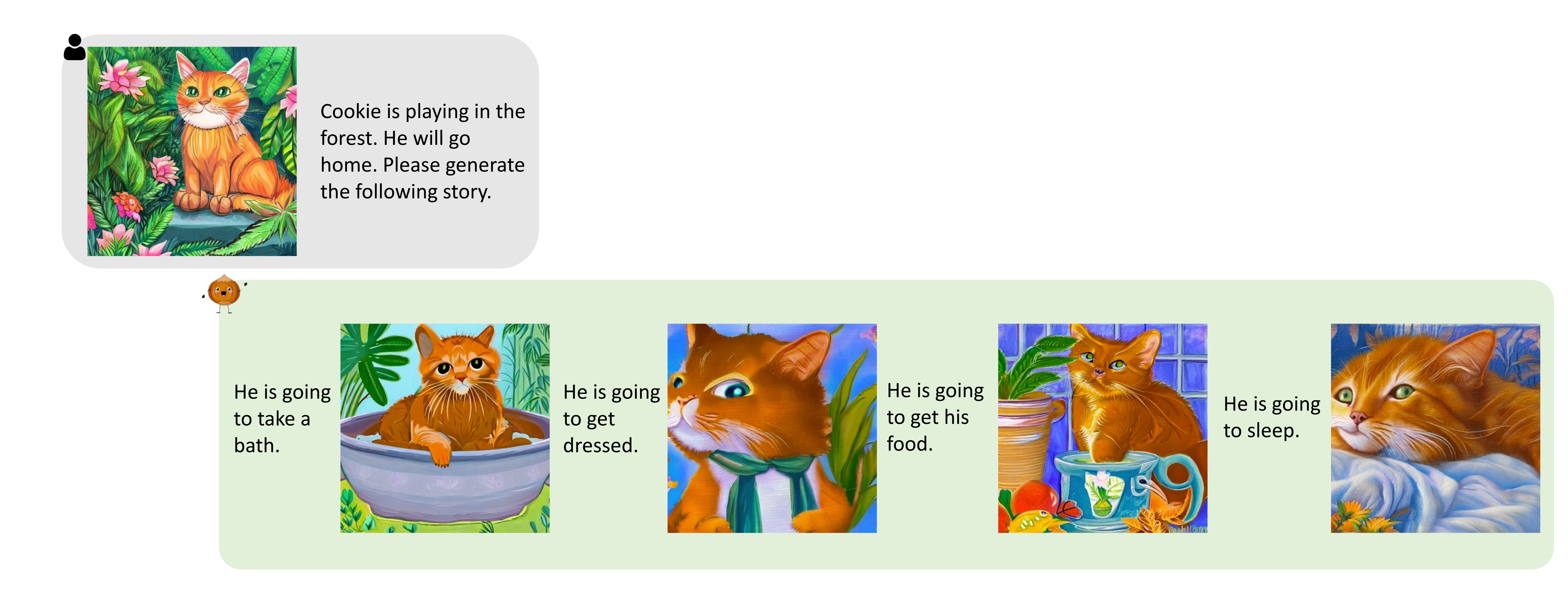

给定一张起始图像和故事,经指令微调的模型可以一次性生成后续故事和多张图像。

-

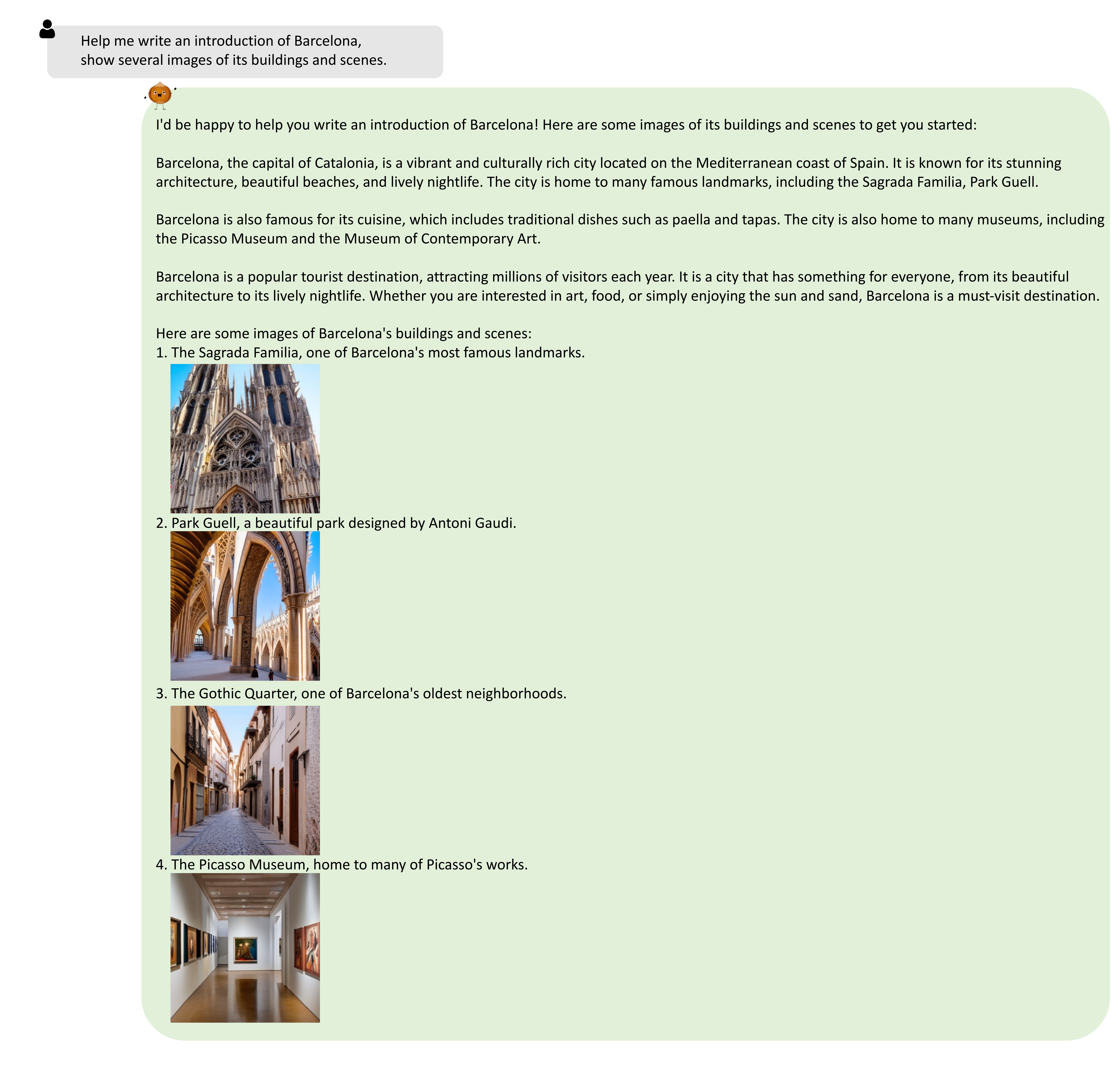

我们使用GPT-4基于MMC4的文本内容生成指令。经指令微调的模型可以生成图文交错内容(我们发布的sft模型不具备此功能,因为我们在MMC4上单独对预训练模型进行指令微调)。

使用方法

依赖项

- Python >= 3.8(推荐使用Anaconda)

- PyTorch >= 1.11.0

- NVIDIA GPU + CUDA

安装

克隆仓库并安装依赖包

git clone https://github.com/AILab-CVC/SEED.git

cd SEED

pip install -r requirements.txt

模型权重

我们在SEED Hugging Face上发布了预训练的SEED分词器和反分词器、预训练和指令微调的SEED-LLaMA-8B和SEED-LLaMA-14B。

- 查看SEED分词器权重:AILab-CVC/seed-tokenizer-2

- 查看SEED LLaMA(8B)权重:AILab-CVC/seed-llama-8b-sft

- 查看SEED LLaMA(14B)权重:AILab-CVC/seed-llama-14b-sft

cd pretrained # SEED/pretrained

git lfs install

git clone https://huggingface.co/AILab-CVC/SEED

mv SEED/* ./

用于重建图像的unCLIP SD-UNet模型权重将自动下载。

视觉标记化和去标记化推理

要将图像离散化为具有因果依赖性的1D视觉代码,并使用现成的unCLIP SD-UNet从视觉代码重建图像:

cd .. # SEED/

python scripts/seed_tokenizer_inference.py

SEED-LLaMA推理

鉴于SEED-LLaMA-8B基于Vicuna-7B,SEED-LLaMA-14B基于LLaMA2-Chat-13B,我们分别使用Vicuna-7B的("USER:", "ASSISTANT:")和LLaMA2-Chat-13B的([INST] [/INST])提示进行指令微调。

# SEED-LLaMA-8B推理

python scripts/seed_llama_inference_8B.py

# SEED-LLaMA-14B推理

python scripts/seed_llama_inference_14B.py

在本地启动SEED-LLaMA-14B的Gradio演示

- 目前构建SEED-LLaMA-14B的本地演示需要单个24GBGPU。

# SEED/

# 在第一个终端

bash scripts/start_backend_14b.sh

# 在第二个终端

bash scripts/start_frontend_14b.sh

- 目前构建SEED-LLaMA-8B的本地演示需要单个16GBGPU。

# SEED/

# 在第一个终端

bash scripts/start_backend_8b.sh

# 在第二个终端

bash scripts/start_frontend_8b.sh

然后可以通过http://127.0.0.1:80访问演示

训练SEED-LLaMA

基于LAVIS训练SEED标记化

- 安装

cd SEED/SEED_Tokenizer

sh install.sh

-

从BLIP-2下载预训练的Q-Former,并将检查点放在"pretrained"文件夹下。

-

训练因果Q-Former

sh train_scripts/causal_qformer.sh

-

为unCLIP-SD下载CLIP,并将检查点放在"pretrained"文件夹下。

-

训练SEED标记器和解标记器

sh train_scripts/codebook.sh

- 训练后,您可以通过unclip SD将图像标记化为离散标记,并将离散标记解码为真实图像

# 您需要加载预训练的ckpt。

python3 eval/seed_inference.py

多模态LLM预训练和指令微调

- 安装

cd SEED

pip install -r requirements.txt

cd MultiModalLLM

-

下载预训练的LLM(例如,vicuna-7b-v1.1)和SEED标记器,并将它们放在"pretrained"文件夹下。

-

通过将图像转换为离散标记来预处理预训练数据。例如,

python3 src/tools/extract_image_ids_to_torchdata_parallel.py \

--tokenizer configs/tokenizer/seed_llama_tokenizer.yaml \

--image_transform configs/processer/blip_transform.yaml \

--data configs/data/caption_torchdata_preprocess.yaml \

--save_dir dataset/seed_llama/caption/unsplash_cc3m/ \

--batch_size 1024 --num_workers 8 --gpus 8

- 使用lora预训练具有SEED标记的多模态LLM。

sh scripts/train_a100_lora_multi_node_pretrain.sh

- 将lora检查点与原始LLM合并。

python3 src/tools/merge_lora_weights.py \

--model_cfg configs/model/vicuna_7b_lora_pretrained.yaml \

--tokenizer_cfg configs/tokenizer/seed_llama_tokenizer.yaml \

--base_model pretrained/vicuna-7b-v1.1 \

--lora_model log/seed_vicuna-7b_lora_pretrain/checkpoint-10000 \

--save_path log/seed_vicuna-7b_lora_pretrain/checkpoint-merged-10000

- 通过将图像转换为离散标记来预处理指令微调数据。(您首先需要将数据转换为JSON格式,JSON的每一行包含"image"(图像的路径)、"question"和"answer"。)

python3 src/tools/extract_image_ids_to_torchdata_parallel_qa.py \

--tokenizer configs/tokenizer/seed_llama_tokenizer.yaml \

--image_transform configs/processer/blip_transform.yaml \

--data configs/data/question_answer_torchdata_eval.yaml \

--save_dir data/VQAv2 \

--batch_size 512 --num_workers 8 --gpus 8

- 使用lora对具有SEED标记的多模态LLM进行指令微调。

sh scripts/train_a100_lora_multi_node_sft.sh

引用

如果您发现这项工作有帮助,请考虑引用:

@article{ge2023making,

title={Making LLaMA SEE and Draw with SEED Tokenizer},

author={Ge, Yuying and Zhao, Sijie and Zeng, Ziyun and Ge, Yixiao and Li, Chen and Wang, Xintao and Shan, Ying},

journal={arXiv preprint arXiv:2310.01218},

year={2023}

}

@article{ge2023planting,

title={Planting a seed of vision in large language model},

author={Ge, Yuying and Ge, Yixiao and Zeng, Ziyun and Wang, Xintao and Shan, Ying},

journal={arXiv preprint arXiv:2307.08041},

year={2023}

}

该项目仍在进行中。

许可证

SEED根据Apache License Version 2.0发布。

访问官网

访问官网 Github

Github Huggingface

Huggingface 论文

论文