Cannoli

Cannoli允许您使用Obsidian Canvas编辑器构建和运行无代码LLM脚本。

什么是Cannoli?

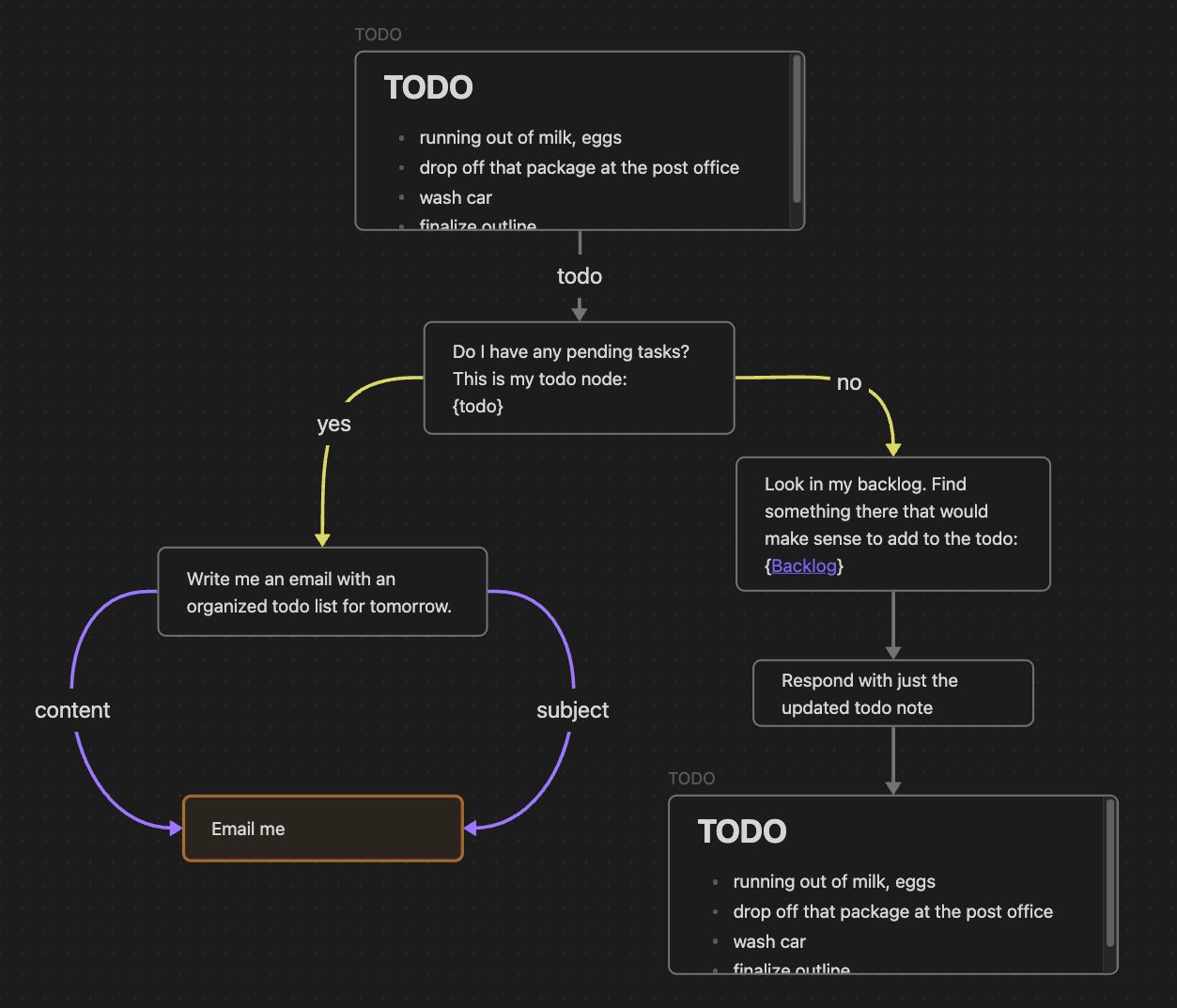

Cannoli是利用LLM读写您的知识库并通过HTTP请求执行操作的脚本。Cannoli在Obsidian Canvas编辑器中创建,使用卡片和箭头来定义变量和逻辑。它们可以在Obsidian中使用控制功能区按钮或命令面板运行。

通过使用颜色或前缀,您可以创建不同类型的节点和箭头,以定义基本逻辑功能,如变量、字段、循环和分支选择。如果Canvas是一个有向无环图并遵循Cannoli架构,它就可以作为cannoli运行。

Cannoli还可用于制作具有自定义逻辑和功能的LLM聊天机器人,包括流式传输和可定制的格式。

文档

您可以在插件设置中访问示例cannoli的演示文件夹(完整文档网站即将推出)。

运行Cannoli

Cannoli可以通过以下几种方式运行:

-

点击Cannoli功能区图标

- 如果您在Canvas文件上,它将作为cannoli运行

- 如果您在带有"cannoli"属性的笔记上,该属性中的Canvas文件将作为cannoli运行

-

在命令面板中运行"启动/停止cannoli"命令(功能与功能区图标相同)

-

如果Canvas文件名以".cno"结尾,它将在命令面板中有自己的运行命令

-

在带有"cannoli"属性的笔记上进行音频录制

- 该录音将(1)使用Whisper转录,(2)替换引用,(3)触发属性中定义的cannoli。

AI提供商

Cannoli目前支持以下LLM提供商:

- OpenAI

- Groq

- Anthropic

- Gemini

您可以选择默认提供商,单独编辑其设置,并在任何地方覆盖该默认值。

Ollama设置

Cannoli还可以使用Ollama的本地LLM。要使用Ollama,请将"AI提供商"下拉菜单切换到Ollama,并确保ollama url反映您的设置(通常默认设置即可)。

我们还需要将OLLAMA_ORIGINS环境变量配置为"*",以便来自Obsidian桌面的请求能够成功到达ollama服务器。参考此文档为每个操作系统配置此环境变量,例如,在Mac OS中,您将在终端中运行命令launchctl setenv OLLAMA_ORIGINS "*"并重启ollama。

您可以在设置中更改默认模型,并在Cannoli本身中使用配置箭头为每个节点定义模型,但请注意,每次更改模型时都需要加载,因此在一个cannoli中使用多个模型会花费更长时间。

网络使用

- Cannoli根据正在运行的cannoli的设置向LLM提供商API发送请求。

- Cannoli可以发送您预先定义的HTTP请求。

Github

Github 文档

文档