描述

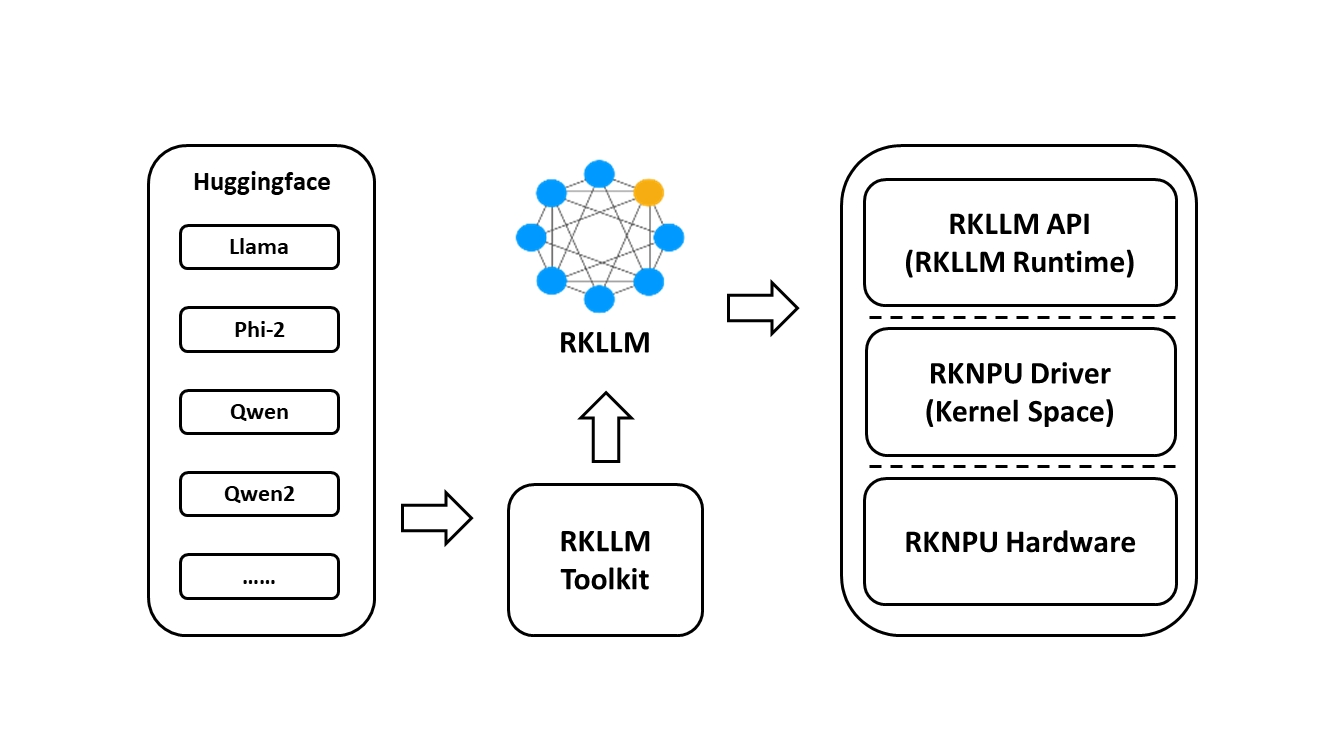

RKLLM软件栈可帮助用户快速将AI模型部署到瑞芯微芯片上。整体框架如下:

为了使用RKNPU,用户需要首先在计算机上运行RKLLM-Toolkit工具,将训练好的模型转换为RKLLM格式的模型,然后在开发板上使用RKLLM C API进行推理。

-

RKLLM-Toolkit是一个软件开发工具包,用于用户在PC上进行模型转换和量化。

-

RKLLM Runtime为瑞芯微NPU平台提供C/C++编程接口,帮助用户部署RKLLM模型并加速LLM应用的实现。

-

RKNPU内核驱动负责与NPU硬件交互。它已开源,可以在瑞芯微内核代码中找到。

支持平台

- RK3588系列

- RK3576系列

支持模型

- TinyLLAMA 1.1B

- Qwen 1.8B

- Qwen2 0.5B

- Phi-2 2.7B

- Phi-3 3.8B

- ChatGLM3 6B

- Gemma 2B

- InternLM2 1.8B

- MiniCPM 2B

下载

- 您也可以从RKLLM_SDK下载所有软件包、Docker镜像、示例、文档和平台工具,提取码:rkllm

RKNN Toolkit2

如果您想部署其他AI模型,我们推出了一个名为RKNN-Toolkit2的SDK。详情请参考:

https://github.com/airockchip/rknn-toolkit2

更新日志

v1.0.1

- 优化模型转换内存占用

- 优化推理内存占用

- 提高预填充速度

- 减少初始化时间

- 提高量化精度

- 增加对Gemma、ChatGLM3、MiniCPM、InternLM2和Phi-3的支持

- 增加服务器调用

- 增加推理中断接口

- 在返回值中添加logprob和token_id

对于旧版本,请参考更新日志

Github

Github 文档

文档