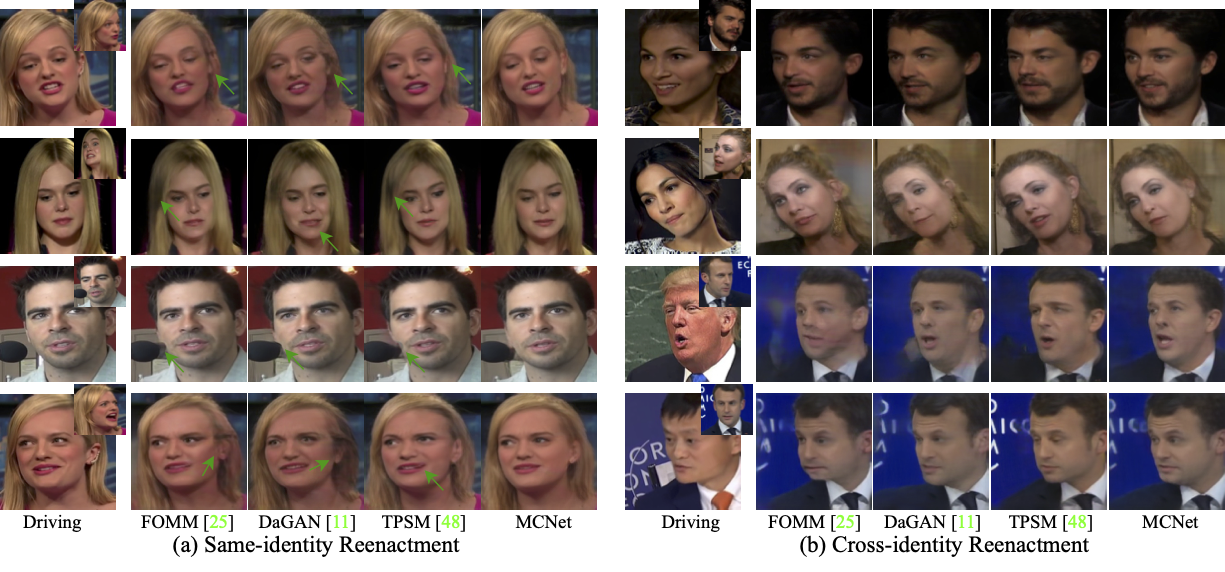

:book: 基于隐式身份表示和条件内存补偿网络的说话头视频生成 (ICCV 2023)

:fire: 如果MCNet对您的照片/项目有帮助,请给它一个:star:或向您的朋友推荐。谢谢:fire:

有趣示例

https://github.com/harlanhong/ICCV2023-MCNET/assets/19970321/4e8af5f6-b042-4ced-af2c-93c95e1b7009

:triangular_flag_on_post: 更新

- :fire::fire::white_check_mark: 2023年7月20日: 我们的新说话头工作 MCNet 被ICCV2023接收。代码将在十天内发布。您可以先看看我们之前的工作 DaGAN。

:wrench: 依赖和安装

- Python >= 3.7 (推荐使用 Anaconda 或 Miniconda)

- PyTorch >= 1.7

- 可选: NVIDIA GPU + CUDA

- 可选: Linux

安装

我们现在提供了一个干净版本的MCNet,不需要自定义CUDA扩展。

-

克隆仓库

git clone https://github.com/harlanhong/ICCV2023-MCNET.git cd ICCV2023-MCNET -

安装依赖包

pip install -r requirements.txt ## 安装人脸对齐库 cd face-alignment pip install -r requirements.txt python setup.py install

:zap: 快速推理

我们以论文版本为例。更多模型可以在这里找到。

YAML配置

查看 config/vox-256.yaml 获取每个参数的描述。

预训练检查点

人脸深度网络的预训练检查点和我们的MCNet检查点可以在以下链接找到: OneDrive。

推理! 要运行演示,下载检查点并运行以下命令:

CUDA_VISIBLE_DEVICES=0 python demo.py --config config/vox-256.yaml --driving_video 驱动视频路径 --source_image 源图像路径 --checkpoint 检查点路径 --relative --adapt_scale --kp_num 15 --generator Unet_Generator_keypoint_aware --result_video 结果视频路径 --mbunit ExpendMemoryUnit --memsize 1

结果将存储在 结果视频路径。驱动视频和源图像在用于我们的方法之前应该被裁剪。要获得一些半自动裁剪建议,可以使用 python crop-video.py --inp some_youtube_video.mp4。它将生成使用ffmpeg进行裁剪的命令。

:computer: 训练

数据集

- VoxCeleb。请按照 https://github.com/AliaksandrSiarohin/video-preprocessing 的说明进行操作。

在 VoxCeleb 上训练

要在特定数据集上训练模型,请运行:

CUDA_VISIBLE_DEVICES=0 python -m torch.distributed.launch --master_addr="0.0.0.0" --master_port=12347 run.py --config config/vox-256.yaml --name MCNet --batchsize 8 --kp_num 15 --generator Unet_Generator_keypoint_aware --GFM GeneratorFullModel --memsize 1 --kp_distance 10 --feat_consistent 10 --generator_gan 0 --mbunit ExpendMemoryUnit

代码会在日志目录中创建一个文件夹(每次运行都会创建一个新的特定名称的目录)。

检查点将保存到这个文件夹中。

要查看训练过程中的损失值,请查看 log.txt。

默认情况下,批量大小已调整为在 8 个 GeForce RTX 3090 GPU 上运行(约 150 个 epoch 后可获得最佳性能)。您可以在 .yaml 文件中的 train_params 中更改批量大小。

此外,您可以通过运行以下命令来查看训练损失:

tensorboard --logdir log/MCNet/log

如果您在训练过程中由于某些原因终止了进程,可能会出现僵尸进程,您可以使用我们提供的工具来终止它:

python kill_port.py 端口号

在您自己的数据集上训练

-

将所有视频调整为相同的大小,例如 256x256,视频可以是 '.gif'、'.mp4' 格式或包含图像的文件夹。 我们推荐后者,为每个视频创建一个单独的文件夹,其中包含所有 '.png' 格式的帧。这种格式是无损的,并且具有更好的 I/O 性能。

-

创建一个

data/dataset_name文件夹,其中包含train和test两个子文件夹,将训练视频放在train中,测试视频放在test中。 -

创建一个配置文件

config/dataset_name.yaml,在 dataset_params 中指定根目录root_dir: data/dataset_name。同时在 train_params 中调整 epoch 数量。

致谢

我们的 MCNet 实现受到 FOMM 的启发。我们感谢 FOMM 的作者将他们的代码公开。

BibTeX

@inproceedings{hong23implicit,

title={Implicit Identity Representation Conditioned Memory Compensation Network for Talking Head video Generation},

author={Hong, Fa-Ting and Xu, Dan},

booktitle={ICCV},

year={2023}

}

@inproceedings{hong2022depth,

title={Depth-Aware Generative Adversarial Network for Talking Head Video Generation},

author={Hong, Fa-Ting and Zhang, Longhao and Shen, Li and Xu, Dan},

journal={IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR)},

year={2022}

}

@inproceedings{hong2023depth,

title={DaGAN++: Depth-Aware Generative Adversarial Network for Talking Head Video Generation},

author={Hong, Fa-Ting and and Shen, Li and Xu, Dan},

journal={arXiv preprint arXiv:2305.06225},

year={2023}

}

联系方式

如果您有任何问题或合作需求(研究目的或商业目的),请发邮件至 fhongac@cse.ust.hk。

访问官网

访问官网 Github

Github 论文

论文