🔥 新闻

- 🔥🔥🔥 我们发布了 MOMENT研究 代码,您可以使用自己的数据预训练时间序列基础模型,并重现我们论文中的实验!

- 我们修复了分类问题中MOMENT无法处理多通道输入的问题。

- MOMENT被ICML 2024接收!

- 对多模态时间序列和文本基础模型感兴趣吗?请查看我们关于JoLT(时间序列和文本的联合学习表示)的初步工作 [AAAI 2024学生摘要, NeurIPS 2023 DGM4H研讨会]。JoLT在AAAI获得了最佳学生摘要展示奖!敬请期待多模态时间序列和文本基础模型!

📖 简介

我们推出MOMENT,一系列用于通用时间序列分析的开源基础模型。预训练大型时间序列模型面临挑战,原因包括:(1)缺乏大规模且连贯的公开时间序列库,(2)时间序列特性多样,导致多数据集训练困难。此外,(3)评估这些模型在资源、时间和监督有限情况下的实验基准仍处于初期阶段。为应对这些挑战,我们汇编了大规模且多样化的公开时间序列集合,称为时间序列堆(Time-series Pile),并系统地解决时间序列特有的挑战,以实现大规模多数据集预训练。最后,我们在最新研究基础上设计了一个基准,用于在有限监督环境下评估时间序列基础模型在各种任务和数据集上的表现。基准实验证明了我们预训练模型在最少数据和特定任务微调下的有效性。我们还提出了关于大型预训练时间序列模型的一些有趣的实证观察。

MOMENT:一个模型,多种任务、数据集和领域

MOMENT在不同数据集和任务上的表现,无需参数更新:

- 插值: 优于统计插值基准

- 异常检测: $F_1$值仅次于最佳基准

- 分类: 在16种对比方法中准确率超过11种

- 短期预测: 在某些数据集上优于ARIMA

通过线性探测(微调最后一层线性层):

- 插值: 在6个数据集中的4个上优于基准

- 异常检测: 最佳$F_1$值

- 长期预测: 在某些情况下具有竞争力

MOMENT捕捉时间序列的语言

合成生成的正弦波嵌入的主成分分析表明,MOMENT能够捕捉微妙的趋势、尺度、频率和相位信息。在每个实验中,$c$控制感兴趣的因素,例如趋势多项式的幂$c \in [\frac{1}{8}, 8)$(Oreshkin等,2020)。我们通过改变$c$生成多个正弦波,使用MOMENT获取它们的序列级表示,并使用PCA在二维空间中可视化。

MOMENT学习数据的有意义表示

MOMENT在UCR分类档案中的ECG5000数据集上学习的表示的PCA可视化。不同颜色代表不同类别。即使没有针对特定数据集进行微调,MOMENT也能为不同类别学习独特的表示。

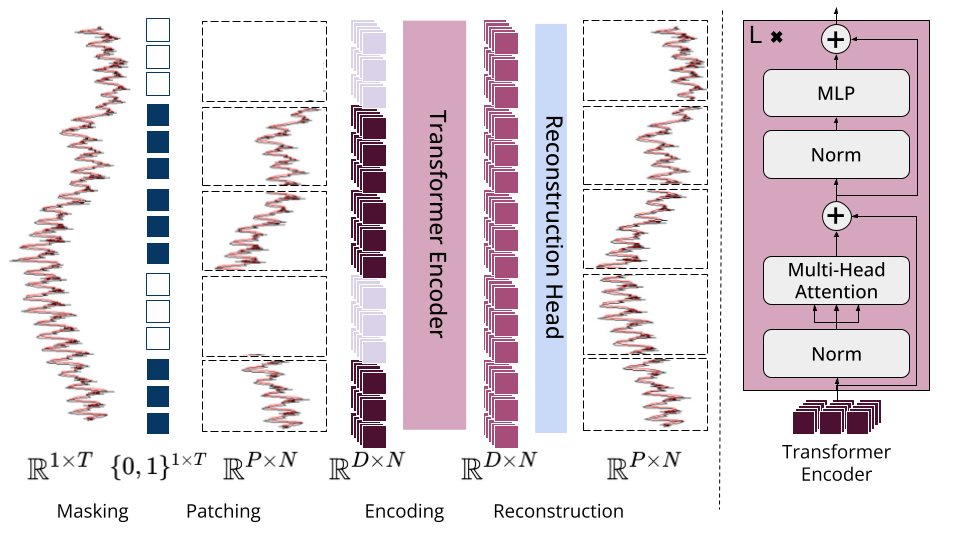

架构概述

时间序列被分解为固定长度的不相交子序列,称为patches,每个patch被映射到D维的patch嵌入。在预训练过程中,我们通过使用特殊的掩码嵌入[MASK]随机均匀地掩盖patches。预训练的目标是学习patch嵌入,这些嵌入可以用轻量级重建头重构输入时间序列。

🧑💻 使用方法

推荐Python版本: Python 3.11(预计不久将支持其他版本)。

你可以使用pip安装momentfm包:

pip install momentfm

或者,直接从GitHub仓库安装最新版本:

pip install git+https://github.com/moment-timeseries-foundation-model/moment.git

要为其中一个任务加载预训练模型,请使用以下代码片段之一:

预测

from momentfm import MOMENTPipeline

model = MOMENTPipeline.from_pretrained(

"AutonLab/MOMENT-1-large",

model_kwargs={

"task_name": "forecasting",

"forecast_horizon": 96

},

)

model.init()

分类

from momentfm import MOMENTPipeline

model = MOMENTPipeline.from_pretrained(

"AutonLab/MOMENT-1-large",

model_kwargs={

"task_name": "classification",

"n_channels": 1,

"num_class": 2

},

)

model.init()

异常检测、插值和预训练

from momentfm import MOMENTPipeline

model = MOMENTPipeline.from_pretrained(

"AutonLab/MOMENT-1-large",

model_kwargs={"task_name": "reconstruction"},

)

model.init()

表示学习

from momentfm import MOMENTPipeline

model = MOMENTPipeline.from_pretrained(

"AutonLab/MOMENT-1-large",

model_kwargs={"task_name": "embedding"},

)

model.init()

🧑🏫 教程

以下是帮助您开始使用MOMENT进行各种任务的教程和可复现实验列表:

- 预测

- 分类

- 异常检测

- 插值

- 表示学习

- 真实世界心电图(ECG)案例研究 -- 这个教程还展示了如何为真实世界的ECG分类问题微调MOMENT,在多个GPU上执行训练和推理,以及参数高效微调(PEFT)。

特别感谢Yifu Cai和Arjun Choudhry提供的教程!

所有这些实验都可以在一个配备48 GiB RAM的NVIDIA A6000 GPU上复现。

[!提示] 对使用MOMENT还有更多问题?查看常见问题解答,也许能找到您的答案!

BibTeX

@inproceedings{goswami2024moment,

title={MOMENT: A Family of Open Time-series Foundation Models},

author={Mononito Goswami and Konrad Szafer and Arjun Choudhry and Yifu Cai and Shuo Li and Artur Dubrawski},

booktitle={International Conference on Machine Learning},

year={2024}

}

⛑️ 研究代码

我们设计这个代码库时力求轻量化,在此过程中删除了大量代码!我们在这里发布了完整但较为凌乱的研究代码。其中包括处理不同数据集的代码,以及预训练、微调和评估MOMENT及其他基线的脚本。该代码的早期版本曾在Anonymous Github上提供。

➕ 贡献

我们鼓励研究人员向MOMENT贡献他们的方法和数据集。我们正在积极制定贡献指南。敬请关注更新!

📰 媒体报道

- Moment:一系列开放时间序列基础模型,Samuel Chazy的Medium文章

- MOMENT:用于时间序列预测、分类、异常检测的基础模型,Nikos Kafritsas发表于Towards Datascience

- CMU研究人员提出MOMENT:用于通用时间序列分析的开源机器学习基础模型系列,Mohammad Asjad撰写的MarketTechPost文章

- 人工智能:时间序列基础模型在数据分析和预测中的崛起,Dr. Tehseen Zia撰写的Unite AI博客

- 时间序列AI:MOMENT模型,Gradient AI主办的网络研讨会

- 预测影响,与Azul Garza Ramírez的基础模型专题讨论,由Mariana Menchero和Faranak Golestaneh代表国际预测学会主持的播客

🤟 当代研究

在构建时间序列预测基础模型方面有许多出色的工作!以下是一个不完整的列表。请查看我们论文中的表9,了解与这些研究的定性比较:

- TimeGPT-1,由Nixtla开发,[论文,API]

- Lag-Llama:面向概率时间序列预测的基础模型,由摩根士丹利和ServiceNow研究院开发,[论文,代码,Hugging Face]

- 小型时间混合器(TTMs):用于增强多变量时间序列零/少样本预测的快速预训练模型,由IBM开发,[论文,Hugging Face]

- Moirai:用于通用预测的时间序列基础模型 [论文,代码,Hugging Face]

- 仅解码器的时间序列预测基础模型,由谷歌开发,[论文,代码,Hugging Face]

- Chronos:学习时间序列语言,由亚马逊开发,[论文,代码,Hugging Face]

- Timer:生成式预训练变换器是大型时间序列模型,由清华大学THUML开发,[论文,代码]

还有一些最近的工作致力于解决除预测之外的多个时间序列建模任务:

🪪 许可证

MIT许可证

版权所有 (c) 2024 卡内基梅隆大学Auton实验室

特此免费授予任何获得本软件及相关文档文件("软件")副本的人无限制地处理本软件的权利,包括但不限于使用、复制、修改、合并、出版、分发、再许可和/或销售软件副本的权利,以及允许获得软件的人这样做,但须符合以下条件:

上述版权声明和本许可声明应包含在软件的所有副本或主要部分中。

本软件按"原样"提供,不提供任何明示或暗示的保证,包括但不限于适销性、特定用途适用性和非侵权性的保证。在任何情况下,作者或版权持有人均不对任何索赔、损害或其他责任负责,无论是在合同诉讼、侵权行为还是其他方面,均由软件或软件的使用或其他交易引起、由软件引起或与之相关。

详情请参阅MIT许可证。

Github

Github Huggingface

Huggingface 论文

论文