FLAVR: 用于快速帧插值的流不敏感视频表示

WACV 2023(最佳论文入围者)

[项目页面] [论文] [[项目视频](https://github.com/tarun005/FLAVR/blob/main/youtu.be/HFOY7CGpJRM]

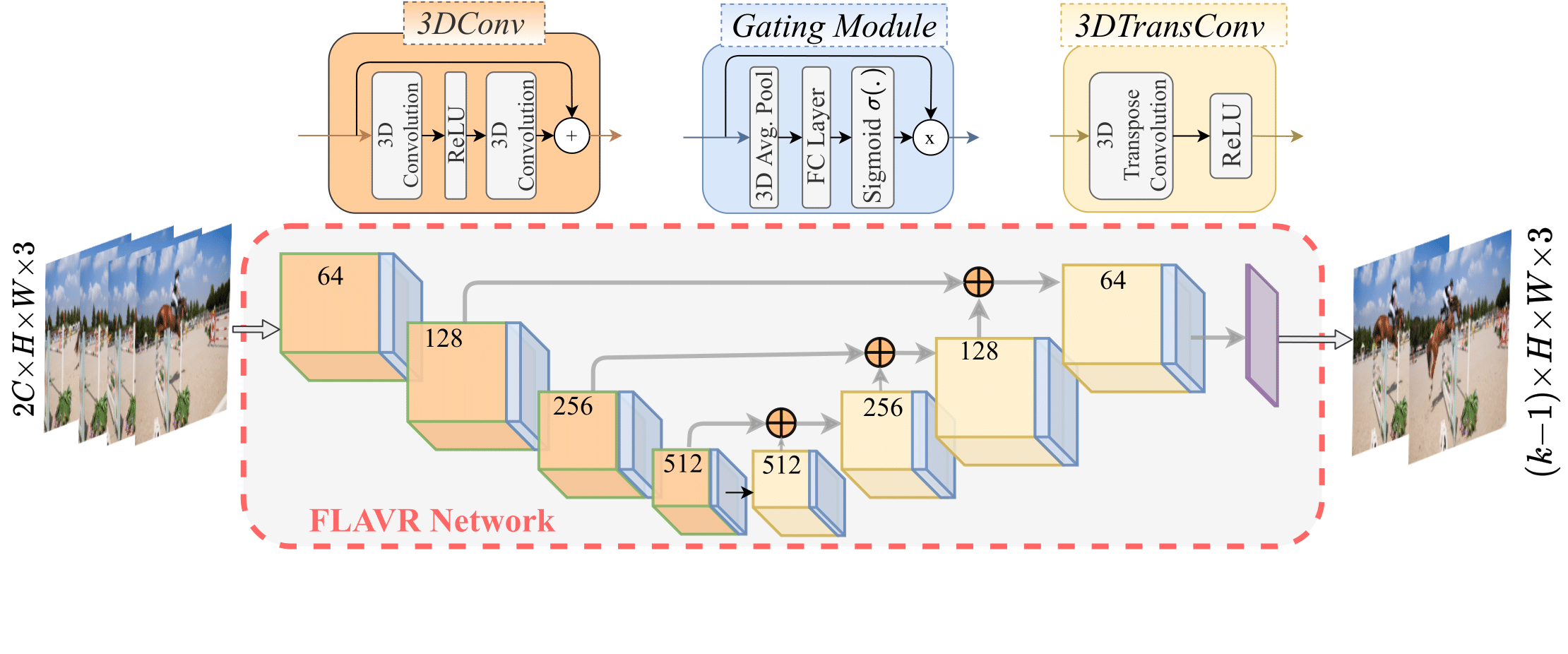

FLAVR是一种快速、无需光流的帧插值方法,能够进行单次多帧预测。它使用定制的编码器-解码器架构,结合时空卷积和通道门控,捕捉并插值帧间复杂的运动轨迹,生成逼真的高帧率视频。此仓库包含原始源代码。

推理时间

与先前的帧插值方法相比,FLAVR在速度和精度之间提供了更好的权衡。

| 方法 | 512x512图像的FPS(秒) |

|---|---|

| FLAVR | 3.10 |

| SuperSloMo | 3.33 |

| QVI | 1.02 |

| DAIN | 0.77 |

依赖项

我们使用以下环境来训练和测试模型:

- Ubuntu 18.04

- Python==3.7.4

- numpy==1.19.2

- PyTorch==1.5.0, torchvision==0.6.0, cudatoolkit==10.1

模型

在Vimeo-90K七元组上训练模型

要在Vimeo-90K数据集上训练自己的模型,请使用以下命令。您可以从此链接下载数据集。论文中报告的结果是使用8个GPU训练的。

python main.py --batch_size 32 --test_batch_size 32 --dataset vimeo90K_septuplet --loss 1*L1 --max_epoch 200 --lr 0.0002 --data_root <数据集路径> --n_outputs 1

在GoPro数据集上训练类似,将n_outputs改为7以进行8倍插值。

使用训练好的模型进行测试

预训练模型

您可以从以下链接下载预训练的FLAVR模型:

2倍插值

要在Vimeo-90K七元组验证集上测试预训练模型,可以运行以下命令:

python test.py --dataset vimeo90K_septuplet --data_root <数据路径> --load_from <保存的模型> --n_outputs 1

8倍插值

要测试多帧插值模型,使用相同的命令和多帧FLAVR模型,相应地更改n_outputs。

时间基准测试

测试脚本除了计算PSNR和SSIM值外,还将输出插值的推理时间和速度。

在Middleburry上评估

要在Middleburry公开基准上进行评估,请运行以下命令:

python Middleburry_Test.py --data_root <数据路径> --load_from <模型路径>

插值后的图像将以可直接上传到 排行榜 的格式保存在 Middleburry 文件夹中。

在自定义视频上使用 SloMo-Filter

你可以使用我们训练好的模型,并将慢动作滤镜应用到你自己的视频上(需要 OpenCV 4.2.0)。使用以下命令。如果你想将 30FPS 的视频转换为 240FPS 的视频,只需使用以下命令

python interpolate.py --input_video <输入视频> --factor 8 --load_model <模型路径>

使用我们的 预训练模型 进行 8 倍插值。要将 30FPS 的视频转换为 60FPS 的视频,请使用 2 倍模型,并将 factor 设为 2。

基线模型

我们还在我们的设置上训练了许多其他先前工作的模型,并提供了所有这些方法的模型。完整的基准测试脚本也将很快发布。

新消息 [2024年4月]:由于谷歌对加州大学圣地亚哥分校的谷歌云盘存储限额进行了令人震惊的削减,我失去了对下面列出的其他方法的预训练模型的访问权限。我希望将来能重新训练它们并发布新的链接,但不要指望。抱歉!

- SuperSloMo 使用 此处 的代码库实现。其他基线使用官方代码库实现。

- 这里呈现的基线数据略好于论文中报告的数据。

Google Colab

本仓库的 notebooks 目录中提供了一个 Colab 笔记本,用于在自定义视频上尝试 2 倍慢动作滤镜。

运动放大模型

很遗憾,我们目前无法提供用于运动放大的训练模型。我们正在努力尽快提供一个可用的模型。

致谢

代码大量借鉴了 Facebook 官方的 PyTorch 视频仓库 和 CAIN。

引用

如果这个代码对你的工作有帮助,请考虑引用我们。

@article{kalluri2023flavr,

title={FLAVR: Flow-Agnostic Video Representations for Fast Frame Interpolation},

author={Kalluri, Tarun and Pathak, Deepak and Chandraker, Manmohan and Tran, Du},

booktitle={WACV},

year={2023}

}

访问官网

访问官网 Github

Github 论文

论文