非平稳Transformer

这是以下论文的代码库: 非平稳Transformer: 探索时间序列预测中的平稳性,NeurIPS 2022。[幻灯片],[海报]。

:triangular_flag_on_post: 新闻 (2023.02) 非平稳Transformer已被纳入[时间序列库],该库涵盖长短期预测、插值、异常检测和分类。

讨论

已经有几个关于我们论文的讨论,我们非常感谢他们宝贵的意见和努力:[官方],[OpenReview],[知乎]。

架构

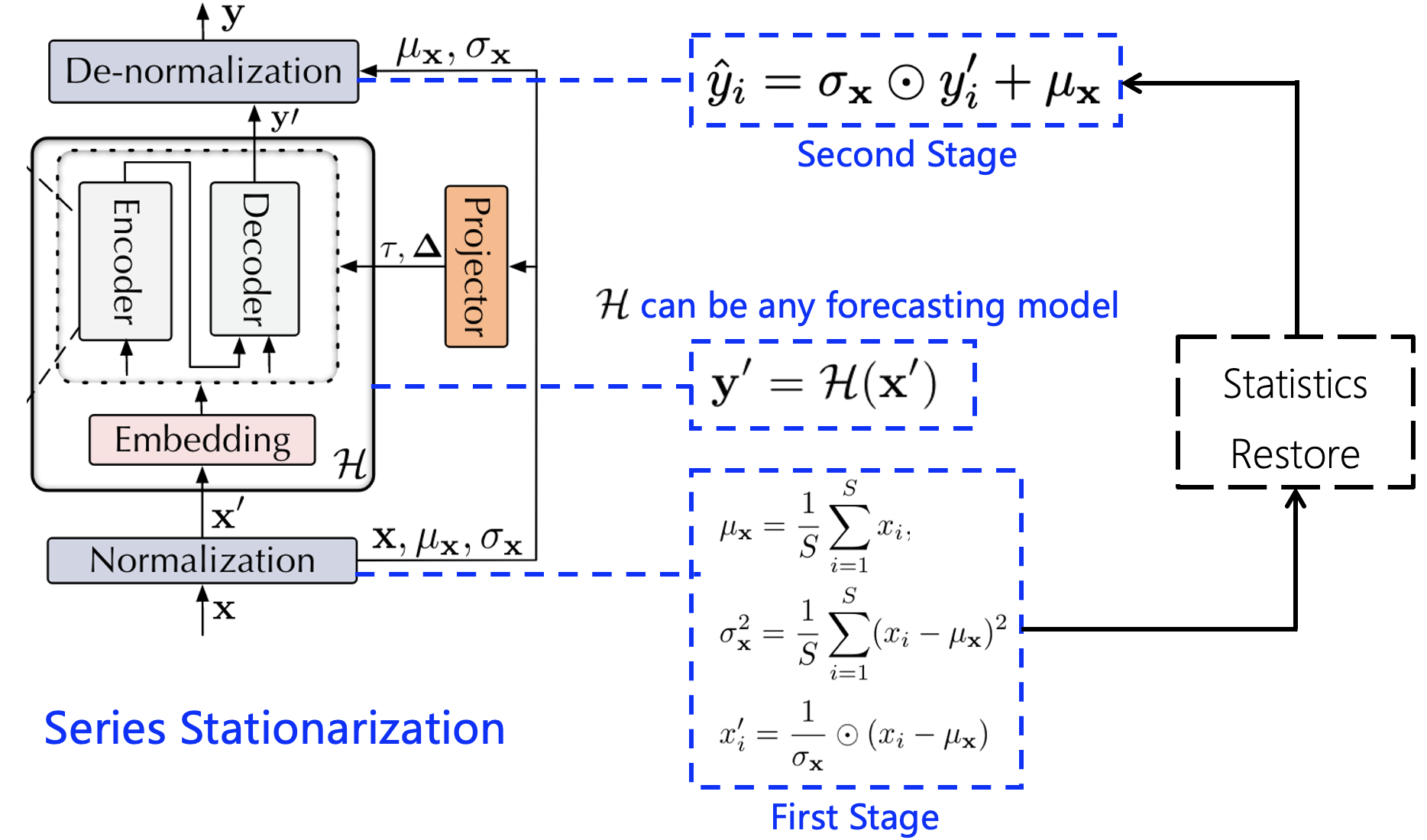

序列平稳化

序列平稳化统一了每个输入的统计特性,并通过恢复统计特性转换输出,以获得更好的可预测性。

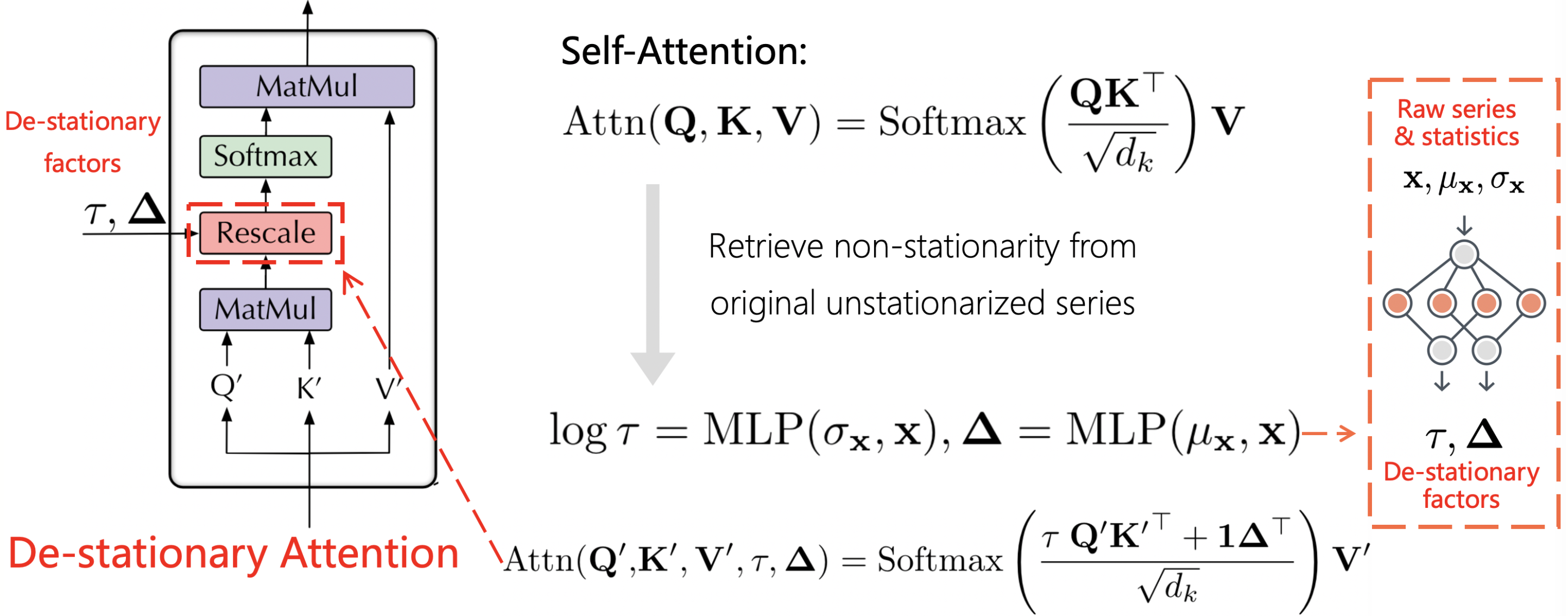

去平稳注意力

去平稳注意力旨在通过近似从非平稳序列中学习到的可区分注意力,将内在的非平稳信息恢复到时间依赖性中。

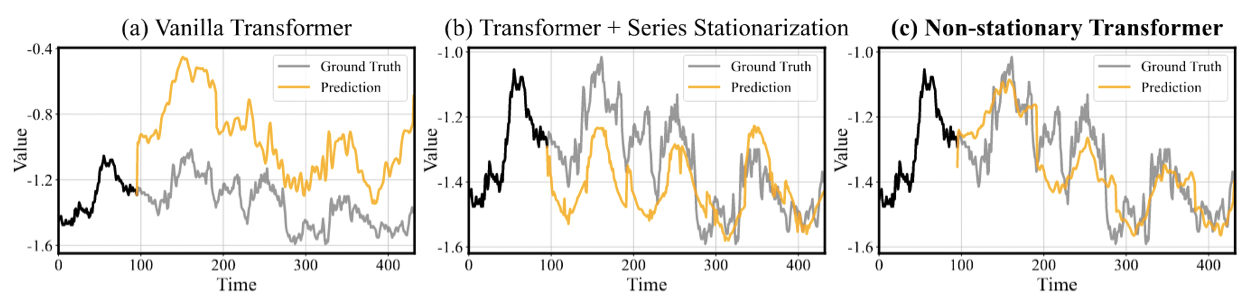

展示案例

准备工作

- 安装Python 3.7和必要的依赖项。

pip install -r requirements.txt

- 所有六个基准数据集可以从Google Drive或清华云获取。

训练脚本

非平稳Transformer

我们在./scripts文件夹下提供了所有基准数据集的非平稳Transformer实验脚本和超参数。

# 使用我们的框架的Transformer

bash ./scripts/ECL_script/ns_Transformer.sh

bash ./scripts/Traffic_script/ns_Transformer.sh

bash ./scripts/Weather_script/ns_Transformer.sh

bash ./scripts/ILI_script/ns_Transformer.sh

bash ./scripts/Exchange_script/ns_Transformer.sh

bash ./scripts/ETT_script/ns_Transformer.sh

# Transformer基线

bash ./scripts/ECL_script/Transformer.sh

bash ./scripts/Traffic_script/Transformer.sh

bash ./scripts/Weather_script/Transformer.sh

bash ./scripts/ILI_script/Transformer.sh

bash ./scripts/Exchange_script/Transformer.sh

bash ./scripts/ETT_script/Transformer.sh

非平稳框架促进其他基于注意力的模型

我们还提供了其他基于注意力的模型(Informer、Autoformer)的脚本,例如:

# 由我们的非平稳框架促进的Informer

bash ./scripts/Exchange_script/Informer.sh

bash ./scripts/Exchange_script/ns_Informer.sh

# 由我们的非平稳框架促进的Autoformer

bash ./scripts/Weather_script/Autoformer.sh

bash ./scripts/Weather_script/ns_Autoformer.sh

实验结果

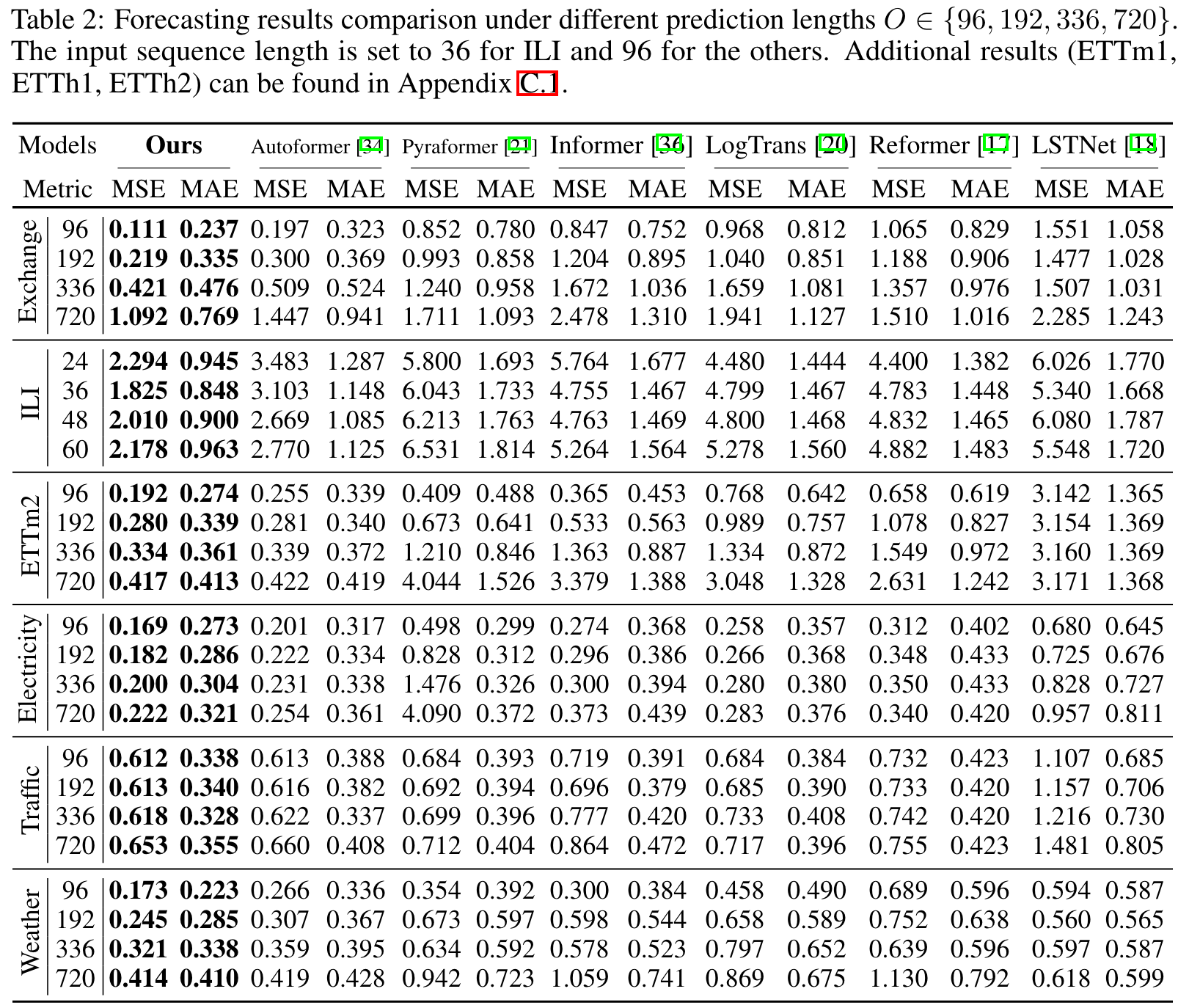

主要结果

对于多变量预测结果,配备我们框架的普通Transformer在所有六个基准和预测长度上始终达到最先进的性能。

模型促进

通过将我们的框架应用于六个主流的基于注意力的模型。我们的方法始终提高预测能力。总体而言,它在Transformer上实现了平均49.43%的提升,在Informer上47.34%,在Reformer上46.89%,在Autoformer上10.57%,在ETSformer上5.17%,在FEDformer上4.51%,使每个模型都超越了之前的最先进水平。

未来工作

我们将继续为以下模型配备我们提出的非平稳Transformers框架:

- Transformer

- iTransformer

- Informer

- Autoformer

- FEDformer

- Crossformer

- Reformer

- ......

注意:序列平稳化作为一个与架构无关的模块已被广泛应用于解决时间序列中的非平稳性问题。有关实现细节,请参考时间序列库。

引用

如果您觉得这个仓库有用,请引用我们的论文。

@article{liu2022non,

title={Non-stationary Transformers: Exploring the Stationarity in Time Series Forecasting},

author={Liu, Yong and Wu, Haixu and Wang, Jianmin and Long, Mingsheng},

booktitle={Advances in Neural Information Processing Systems},

year={2022}

}

联系方式

如果您有任何问题或想使用代码,请联系liuyong21@mails.tsinghua.edu.cn。

致谢

这个仓库基于Autoformer仓库构建,我们非常感谢作者们宝贵的代码和努力。

访问官网

访问官网 Github

Github 论文

论文