翻译版本:

目标

这个Python脚本是一个人工智能驱动的任务管理系统的示例。该系统使用OpenAI和向量数据库(如Chroma或Weaviate)来创建、优先排序和执行任务。这个系统的主要思想是基于先前任务的结果和预定义的目标来创建任务。然后,脚本使用OpenAI的自然语言处理(NLP)能力基于目标创建新任务,并使用Chroma/Weaviate存储和检索任务结果以提供上下文。这是原始任务驱动自主代理(2023年3月28日)的精简版本。

本README将涵盖以下内容:

工作原理

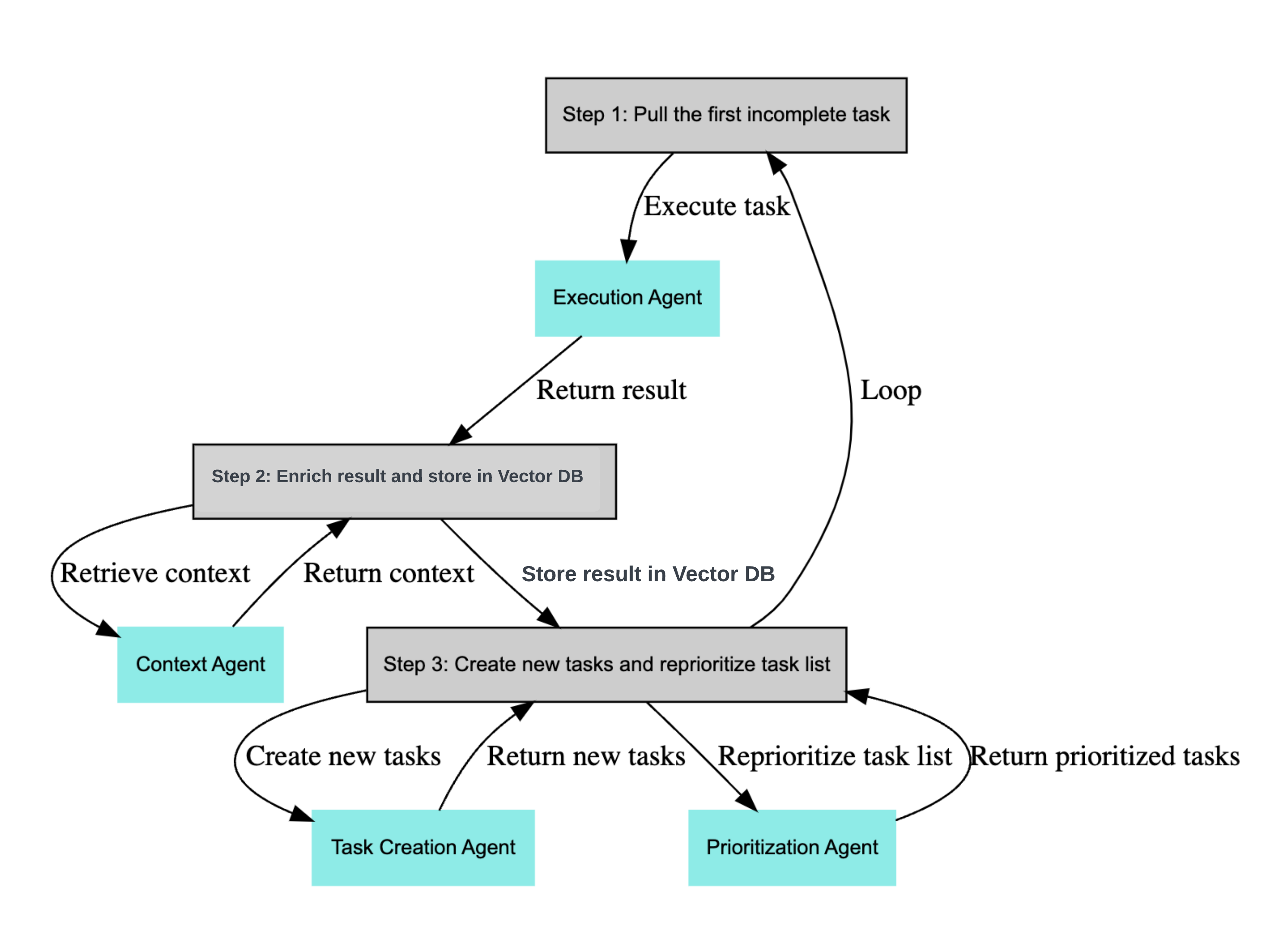

该脚本通过运行一个无限循环来工作,循环包括以下步骤:

- 从任务列表中提取第一个任务。

- 将任务发送给执行代理,执行代理使用OpenAI的API根据上下文完成任务。

- 丰富结果并将其存储在Chroma/Weaviate中。

- 基于目标和先前任务的结果创建新任务,并重新排序任务列表。

execution_agent()函数是使用OpenAI API的地方。它接受两个参数:目标和任务。然后,它向OpenAI的API发送一个提示,API返回任务的结果。提示包括AI系统任务的描述、目标和任务本身。结果以字符串形式返回。

task_creation_agent()函数是使用OpenAI的API基于目标和先前任务的结果创建新任务的地方。该函数接受四个参数:目标、先前任务的结果、任务描述和当前任务列表。然后,它向OpenAI的API发送一个提示,API返回一个新任务列表作为字符串。该函数然后将新任务作为字典列表返回,每个字典包含任务的名称。

prioritization_agent()函数是使用OpenAI的API重新排序任务列表的地方。该函数接受一个参数,即当前任务的ID。它向OpenAI的API发送一个提示,API返回重新排序的任务列表作为编号列表。

最后,脚本使用Chroma/Weaviate存储和检索任务结果以提供上下文。脚本根据TABLE_NAME变量中指定的表名创建一个Chroma/Weaviate集合。然后使用Chroma/Weaviate将任务结果与任务名称和任何其他元数据一起存储在集合中。

使用方法

要使用该脚本,您需要按照以下步骤操作:

- 通过

git clone https://github.com/yoheinakajima/babyagi.git克隆仓库,并cd进入克隆的仓库。 - 安装所需的包:

pip install -r requirements.txt - 将.env.example文件复制为.env:

cp .env.example .env。您将在这里设置以下变量。 - 在OPENAI_API_KEY和OPENAI_API_MODEL变量中设置您的OpenAI API密钥。为了与Weaviate一起使用,您还需要设置此处详述的其他变量。

- 在TABLE_NAME变量中设置存储任务结果的表名。

- (可选)在BABY_NAME变量中设置BabyAGI实例的名称。

- (可选)在OBJECTIVE变量中设置任务管理系统的目标。

- (可选)在INITIAL_TASK变量中设置系统的第一个任务。

- 运行脚本:

python babyagi.py

上述所有可选值也可以在命令行中指定。

在Docker容器内运行

作为前提条件,你需要安装 docker 和 docker-compose。Docker Desktop 是最简单的选择 https://www.docker.com/products/docker-desktop/

要在 docker 容器内运行系统,按照上述步骤设置你的 .env 文件,然后运行以下命令:

docker-compose up

支持的模型

此脚本可与所有 OpenAI 模型以及通过 Llama.cpp 的 Llama 及其变体一起使用。默认模型是 gpt-3.5-turbo。要使用不同的模型,请通过 LLM_MODEL 指定或使用命令行。

Llama

Llama 集成需要 llama-cpp 包。你还需要 Llama 模型权重。

- 在任何情况下都不要在此存储库的任何地方(包括问题、讨论或拉取请求)分享 IPFS、磁力链接或任何其他模型下载链接。它们将被立即删除。

获得模型权重后,将 LLAMA_MODEL_PATH 设置为要使用的特定模型的路径。为方便起见,你可以将 BabyAGI 仓库中的 models 链接到存放 Llama 模型权重的文件夹。然后使用 LLM_MODEL=llama 或 -l 参数运行脚本。

警告

此脚本设计为作为任务管理系统的一部分持续运行。持续运行此脚本可能导致高 API 使用量,因此请负责任地使用它。此外,脚本需要正确设置 OpenAI API,所以在运行脚本之前请确保你已设置好 API。

贡献

不用说,BabyAGI 仍处于初级阶段,因此我们仍在确定其方向和实现目标的步骤。目前,BabyAGI 的一个关键设计目标是保持简单,以便于理解和构建。为了保持这种简单性,我们恳请你在提交 PR 时遵守以下准则:

- 专注于小型、模块化的修改,而不是大规模重构。

- 引入新功能时,请详细描述你要解决的具体用例。

@yoheinakajima 的说明(2023年4月5日):

我知道 PR 数量在增加,感谢你们的耐心 - 因为我既是 GitHub/OpenSource 新手,本周也没有合理安排我的时间。关于方向,我一直在简单化和扩展之间犹豫 - 目前倾向于保持核心 Baby AGI 简单,并使用这个平台来支持和推广不同的扩展方法(例如,BabyAGIxLangchain 作为一个方向)。我相信有各种值得探索的观点方法,我认为有一个中心地方来比较和讨论是有价值的。更多更新即将到来。

我是 GitHub 和开源的新手,所以请耐心等待,因为我正在学习如何正确管理这个项目。我白天经营一家风险投资公司,所以通常会在哄孩子睡觉后晚上查看 PR 和问题 - 可能不是每晚都会查看。我开放引入支持的想法,将很快更新这一部分(期望、愿景等)。我正在与许多人交谈并学习 - 请耐心等待更新!

BabyAGI 活动报告

为了帮助 BabyAGI 社区了解项目进展,Blueprint AI 为 BabyAGI 开发了一个 Github 活动总结器。这份简明报告显示了过去 7 天(持续更新)BabyAGI 仓库的所有贡献摘要,方便你跟踪最新进展。

要查看 BabyAGI 7 天活动报告,请访问:https://app.blueprint.ai/github/yoheinakajima/babyagi

受启发的项目

自发布以来的短时间内,BabyAGI 启发了许多项目。你可以在这里查看所有这些项目。

背景故事

BabyAGI 是最初在 Twitter 上分享的任务驱动自主代理(2023年3月28日)的精简版本。这个版本精简到 140 行:13 行注释,22 行空白,105 行代码。仓库的名称源于对原始自主代理的反应 - 作者并不意味着暗示这是 AGI。

由 @yoheinakajima 用爱制作,他恰好是一位风险投资人(很想看看你在构建什么!)

访问官网

访问官网 Github

Github 论文

论文