什么是BigBird?

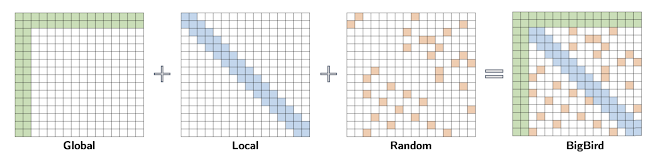

BigBird是在BigBird: Transformers for Longer Sequences中介绍的基于稀疏注意力的模型,相比普通的BERT,它能够处理更长的序列。

🦅 更长的序列 - 可以处理最多4096个token,是BERT最大处理512个token的8倍

⏱️ 计算效率 - 使用稀疏注意力而非全注意力,将复杂度从O(n2)改善到O(n)

如何使用

- 可以直接使用上传到🤗 Huggingface Hub的模型 :)

- 建议使用已解决部分问题的

transformers>=4.11.0版本。(MRC问题相关PR) - 应使用

BertTokenizer而非BigBirdTokenizer。(使用AutoTokenizer时会加载BertTokenizer。) - 详细用法请参考BigBird Tranformers documentation。

from transformers import AutoModel, AutoTokenizer

model = AutoModel.from_pretrained("monologg/kobigbird-bert-base") # BigBirdModel

tokenizer = AutoTokenizer.from_pretrained("monologg/kobigbird-bert-base") # BertTokenizer

预训练

详细内容请参考[预训练BigBird]

| 硬件 | 最大长度 | 学习率 | 批次大小 | 训练步数 | 预热步数 | |

|---|---|---|---|---|---|---|

| KoBigBird-BERT-Base | TPU v3-8 | 4096 | 1e-4 | 32 | 2M | 20k |

- 使用包括Everyone's Corpus、韩语维基百科、Common Crawl、新闻数据等多种数据进行训练

- 使用

ITC (Internal Transformer Construction)模型进行训练(ITC vs ETC)

评估结果

1. 短序列 (<=512)

详细内容请参考[在短序列数据集上微调] | | NSMC

(准确率) | KLUE-NLI

(准确率) | KLUE-STS

(皮尔逊相关系数) | Korquad 1.0

(精确匹配/F1) | KLUE MRC

(精确匹配/ROUGE-W) | | :---------------------- | :-----------: | :---------------: | :--------------------: | :--------------------: | :----------------------: | | KoELECTRA-Base-v3 | 91.13 | 86.87 | 93.14 | 85.66 / 93.94 | 59.54 / 65.64 | | KLUE-RoBERTa-Base | 91.16 | 86.30 | 92.91 | 85.35 / 94.53 | 69.56 / 74.64 | | KoBigBird-BERT-Base | 91.18 | 87.17 | 92.61 | 87.08 / 94.71 | 70.33 / 75.34 |

2. 长序列 (>=1024)

详细内容请参考 [在长序列数据集上微调]

| TyDi QA (精确匹配/F1) | Korquad 2.1 (精确匹配/F1) | 假新闻 (F1) | Modu 情感分析 (F1-macro) | |

|---|---|---|---|---|

| KLUE-RoBERTa-Base | 76.80 / 78.58 | 55.44 / 73.02 | 95.20 | 42.61 |

| KoBigBird-BERT-Base | 79.13 / 81.30 | 67.77 / 82.03 | 98.85 | 45.42 |

文档

引用

如果您使用了 KoBigBird,请按以下方式引用:

@software{jangwon_park_2021_5654154,

author = {Jangwon Park and Donggyu Kim},

title = {KoBigBird: Pretrained BigBird Model for Korean},

month = nov,

year = 2021,

publisher = {Zenodo},

version = {1.0.0},

doi = {10.5281/zenodo.5654154},

url = {https://doi.org/10.5281/zenodo.5654154}

}

贡献者

致谢

KoBigBird 是在 Tensorflow Research Cloud (TFRC) 项目的 Cloud TPU 支持下开发的。

我们还要感谢 Seyun Ahn 提供了精美的 logo。

Github

Github Huggingface

Huggingface 论文

论文