T-Eval:逐步评估大型语言模型的工具使用能力

✨ 简介

这是T-Eval:逐步评估大型语言模型的工具使用能力中描述的基准测试的评估框架。

[论文] [项目主页] [排行榜] [HuggingFace]

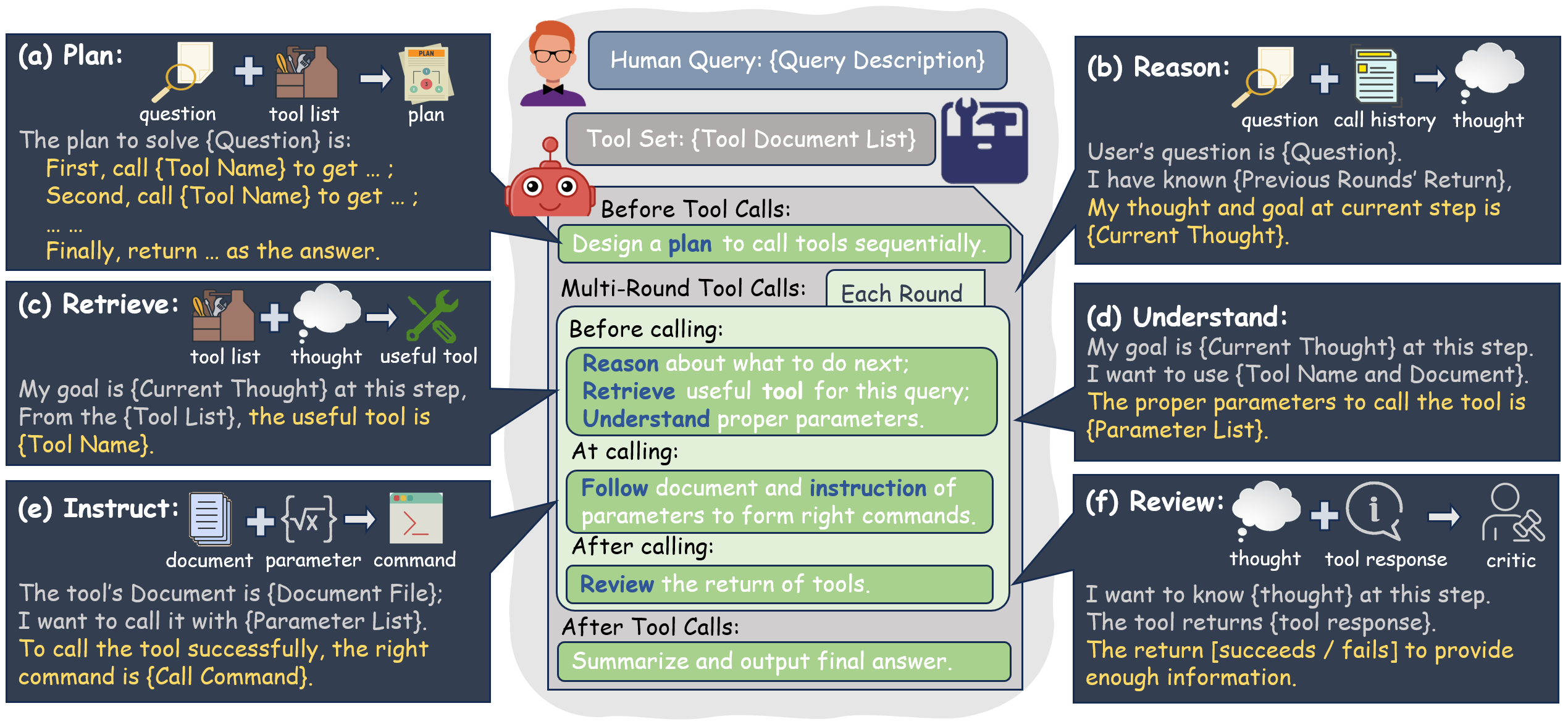

大型语言模型(LLM)在各种自然语言处理任务上取得了显著的性能,并通过工具扩展了更广泛的应用。然而,如何评估和分析LLM的工具使用能力仍然有待探索。与之前整体评估模型的工作不同,我们全面地将工具使用分解为多个子过程,包括指令遵循、规划、推理、检索、理解和审查。基于此,我们进一步引入T-Eval来逐步评估工具使用能力。T-Eval将工具使用评估沿模型能力分解为几个子领域,有助于深入理解LLM的整体和独立能力。我们在T-Eval上进行了广泛的实验,并对各种LLM进行了深入分析。T-Eval不仅与面向结果的评估保持一致,还提供了对LLM能力更细粒度的分析,为LLM在工具使用能力评估方面提供了新的视角。

🚀 最新动态

- [2024.02.22] 发布新的数据和1/5子集(包括中文和英文)以及用于更快推理的代码!🚀🚀🚀 排行榜将很快更新!我们还提供了模板示例供参考~

- [2024.01.08] 发布中文排行榜和~~中文数据~~,其中问题和答案格式为中文。(公布了中文评测数据集和榜单)✨✨✨

- [2023.12.22] 论文在ArXiv上发布。🔥🔥🔥

- [2023.12.21] 发布T-Eval的测试脚本和数据。🎉🎉🎉

🧾 待办事项

- 支持批量推理。注意:某些模型(ChatGLM、Qwen、InternV1)不支持批量推理。

- 将函数响应的角色从

system更改为function。 - 合并连续相同角色的对话。

- 为开源模型提供模板配置。

- 为T-Eval提供开发集,减少评估时间。

- 优化Lagent提供的huggingface模型的推理流程,速度将提高3倍。(请将Lagent升级到v0.2)

- 支持在Opencompass上进行推理。

注意:这些待办事项将在2024.2.1之后开始 感谢您的耐心等待!

🛠️ 准备工作

$ git clone https://github.com/open-compass/T-Eval.git

$ cd T-Eval

$ pip install -r requirements.txt

$ git clone https://github.com/InternLM/lagent.git

$ cd lagent && pip install -e .

🛫️ 快速开始

我们通过Lagent支持基于API的模型和HuggingFace模型。

💾 测试数据

我们提供Google Drive和HuggingFace数据集两种方式下载测试数据:

- Google Drive

[EN数据](英文格式)[ZH数据](中文格式)

T-Eval数据

- HuggingFace数据集

您也可以通过这个链接访问HuggingFace上的数据集。

from datasets import load_dataset

dataset = load_dataset("lovesnowbest/T-Eval")

下载后,请将数据直接放在data文件夹中:

- data/

- instruct_v2.json

- plan_json_v2.json

...

🤖 API模型

- 在环境中设置您的OPENAI密钥。

export OPENAI_API_KEY=xxxxxxxxx

- 使用以下脚本运行模型

# 一次性测试所有数据

sh test_all_en.sh api gpt-4-1106-preview gpt4

# 测试中文数据集

sh test_all_zh.sh api gpt-4-1106-preview gpt4

# 仅测试Instruct

python test.py --model_type api --model_path gpt-4-1106-preview --resume --out_name instruct_gpt4.json --out_dir work_dirs/gpt4/ --dataset_path data/instruct_v2.json --eval instruct --prompt_type json

🤗 HuggingFace模型

- 将huggingface模型下载到本地路径。

- 根据您测试的模型修改

meta_templatejson。 - 使用以下脚本运行模型

# 一次性测试所有数据

sh test_all_en.sh hf $HF_PATH $HF_MODEL_NAME $META_TEMPLATE

# 测试中文数据集

sh test_all_zh.sh hf $HF_PATH $HF_MODEL_NAME $META_TEMPLATE

# 仅测试Instruct

python test.py --model_type hf --model_path $HF_PATH --resume --out_name instruct_$HF_MODEL_NAME.json --out_dir data/work_dirs/ --dataset_path data/instruct_v1.json --eval instruct --prompt_type json --model_display_name $HF_MODEL_NAME --meta_template $META_TEMPLATE

💫 最终结果

完成所有测试样本后,详细的评估结果将记录在$out_dir/$model_display_name/$model_display_name_-1.json中(对于中文数据集,文件名后有_zh后缀)。要获取最终得分,请运行以下命令:

python teval/utils/convert_results.py --result_path $out_dir/$model_display_name/$model_display_name_-1.json

🔌 协议

T-Eval采用多轮对话式评估来衡量模型。我们保存的提示格式如下:

[

{

"role": "system",

"content": "您可以使用以下API:\n{'name': 'AirbnbSearch.search_property_by_place', 'description': '此函数接受各种参数在Airbnb上搜索房源。', 'required_parameters': [{'name': 'place', 'type': 'STRING', 'description': '目的地名称。'}], 'optional_parameters': [], 'return_data': [{'name': 'property', 'description': '最多3个房源的列表,包含id、名称和地址。'}]}\n请按以下格式生成响应:\ngoal: 调用此操作的目标\n\nname: 要调用的api名称\n\nargs: 仅一行的JSON格式api参数\n"

},

{

"role": "user",

"content": "使用以下参数调用AirbnbSearch.search_property_by_place函数:'place'为'Berlin'。"

}

]

其中role可以是['system', 'user', 'assistant'],content必须是字符串格式。在使用LLM推理之前,我们需要通过meta_template将其构造成原始字符串格式。meta_template的示例在meta_template.py中提供:

[

dict(role='system', begin='<|System|>:', end='\n'),

dict(role='user', begin='<|User|>:', end='\n'),

dict(

role='assistant',

begin='<|Bot|>:',

end='<eoa>\n',

generate=True)

]

您需要根据在meta_template.py中测试的huggingface模型指定begin和end令牌,并在test.py中指定meta_template参数,与您在meta_template.py中设置的名称相同。对于OpenAI模型,我们会为您处理。

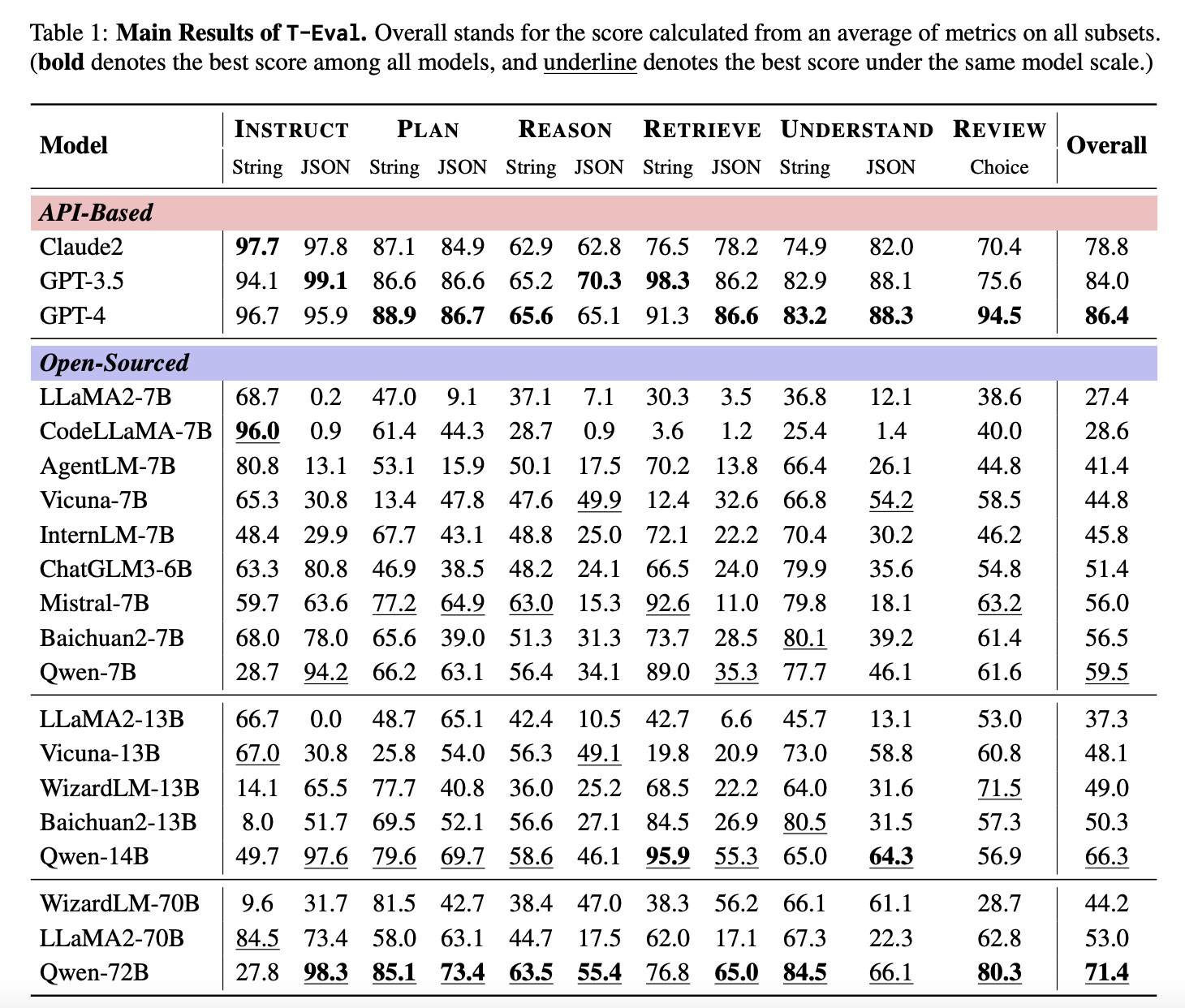

📊 基准测试结果

更详细全面的基准测试结果可参考🏆 T-Eval官方排行榜!

✉️ 提交您的结果

您可以将推理结果(通过运行test.py获得)提交到此邮箱。我们将运行您的预测并在排行榜上更新结果。请同时提供您测试模型的规模。您提交的样本结构应如下所示:

$model_display_name/

instruct_$model_display_name/

query_0_1_0.json

query_0_1_1.json

...

plan_json_$model_display_name/

plan_str_$model_display_name/

...

❤️ 致谢

T-Eval基于Lagent和OpenCompass构建。感谢他们出色的工作!

🖊️ 引用

如果您在研究中发现这个项目有用,请考虑引用:

@article{chen2023t,

title={T-Eval: Evaluating the Tool Utilization Capability Step by Step},

author={Chen, Zehui and Du, Weihua and Zhang, Wenwei and Liu, Kuikun and Liu, Jiangning and Zheng, Miao and Zhuo, Jingming and Zhang, Songyang and Lin, Dahua and Chen, Kai and others},

journal={arXiv preprint arXiv:2312.14033},

year={2023}

}

💳 许可证

本项目根据Apache 2.0 许可证发布。

访问官网

访问官网 Github

Github Huggingface

Huggingface 论文

论文