🪖 ReCon: 对比与重建

对比重建:基于生成式预训练指导的对比性3D表示学习 ICML 2023

Zekun Qi*, Runpei Dong*, Guofan Fan, Zheng Ge, Xiangyu Zhang, Kaisheng Ma 和 Li Yi

OpenReview | arXiv | 模型

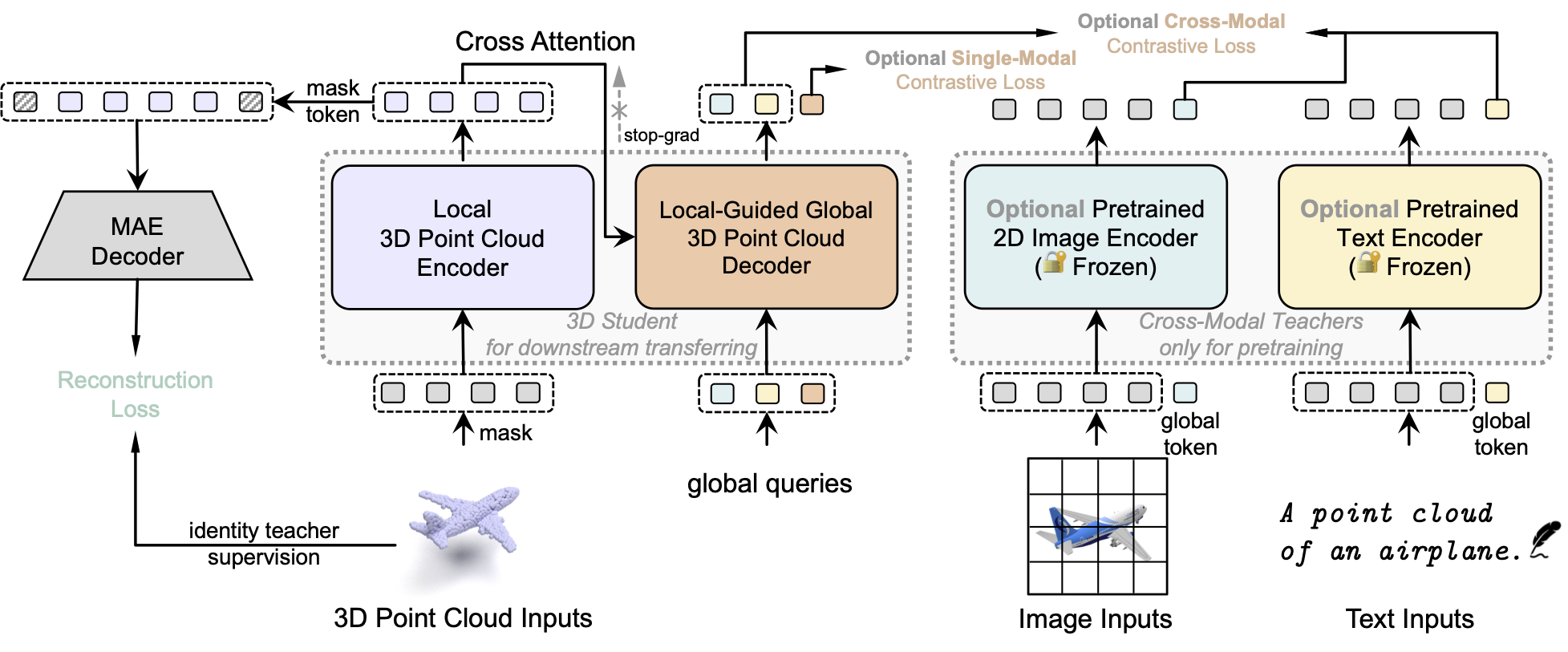

这个仓库包含了ReCon的代码发布:对比重建:基于生成式预训练指导的对比性3D表示学习(ICML 2023)。ReCon也是侦察的缩写 🪖。

对比与重建(ICML 2023)

新闻

- 🍾 2024年7月:ShapeLLM (ReCon++)被ECCV 2024接收,查看代码

- 💥 2024年3月:查看我们最新的工作ShapeLLM (ReCon++),在ScanObjectNN上达到95.25%的微调精度和65.4的零样本精度

- 📌 2023年8月:查看我们对高效条件3D生成的探索VPP

- 📌 2023年6月:查看我们对3D场景预训练的探索Point-GCC

- 🎉 2023年4月:ReCon被ICML 2023接收

- 💥 2023年2月:查看我们之前的工作ACT,已被ICLR 2023接收

1. 要求

PyTorch >= 1.7.0; python >= 3.7; CUDA >= 9.0; GCC >= 4.9; torchvision;

# 快速开始

conda create -n recon python=3.10 -y

conda activate recon

conda install pytorch==2.0.1 torchvision==0.15.2 cudatoolkit=11.8 -c pytorch -c nvidia

# pip install torch==2.0.1+cu118 torchvision==0.15.2+cu118 -f https://download.pytorch.org/whl/torch_stable.html

# 安装基本必需包

pip install -r requirements.txt

# Chamfer距离

cd ./extensions/chamfer_dist && python setup.py install --user

# PointNet++

pip install "git+https://github.com/erikwijmans/Pointnet2_PyTorch.git#egg=pointnet2_ops&subdirectory=pointnet2_ops_lib"

2. 数据集

我们在本工作中使用了ShapeNet、ScanObjectNN、ModelNet40和ShapeNetPart。详情见DATASET.md。

3. ReCon模型

| 任务 | 数据集 | 配置 | 准确率 | 检查点下载 |

|---|---|---|---|---|

| 预训练 | ShapeNet | pretrain_base.yaml | 不适用 | ReCon |

| 分类 | ScanObjectNN | finetune_scan_hardest.yaml | 91.26% | PB_T50_RS |

| 分类 | ScanObjectNN | finetune_scan_objbg.yaml | 95.35% | OBJ_BG |

| 分类 | ScanObjectNN | finetune_scan_objonly.yaml | 93.80% | OBJ_ONLY |

| 分类 | ModelNet40(1k) | finetune_modelnet.yaml | 94.5% | ModelNet_1k |

| 分类 | ModelNet40(8k) | finetune_modelnet_8k.yaml | 94.7% | ModelNet_8k |

| 零样本 | ModelNet10 | zeroshot_modelnet10.yaml | 75.6% | ReCon零样本 |

| 零样本 | ModelNet10* | zeroshot_modelnet10.yaml | 81.6% | ReCon零样本 |

| 零样本 | ModelNet40 | zeroshot_modelnet40.yaml | 61.7% | ReCon零样本 |

| 零样本 | ModelNet40* | zeroshot_modelnet40.yaml | 66.8% | ReCon零样本 |

| 零样本 | ScanObjectNN | zeroshot_scan_objonly.yaml | 43.7% | ReCon零样本 |

| 线性SVM | ModelNet40 | svm.yaml | 93.4% | ReCon svm |

| 部件分割 | ShapeNetPart | segmentation | 86.4% mIoU | 部件分割 |

| 任务 | 数据集 | 配置 | 5类10样本 (%) | 5类20样本 (%) |

| ------------------- | ----------- | --------------------------------------- | --------------- | --------------- |

| 小样本学习 | ModelNet40 | fewshot.yaml | 97.3 ± 1.9 | 98.9 ± 1.2 |

检查点和日志已在Google Drive上发布。你可以在分类测试中使用投票策略来复现论文中报告的性能。 对于分类下游任务,我们随机选择8个种子来获得最佳检查点。 对于零样本学习,*表示我们使用所有训练/测试数据进行零样本迁移。

4. ReCon预训练

使用默认配置进行预训练,运行脚本:

sh scripts/pretrain.sh <GPU> <exp_name>

如果你想尝试不同的模型或掩码比例等,首先创建一个新的配置文件,并将其路径传递给--config。

CUDA_VISIBLE_DEVICES=<GPU> python main.py --config <config_path> --exp_name <exp_name>

5. ReCon分类微调

使用默认配置进行微调,运行脚本:

bash scripts/cls.sh <GPU> <exp_name> <path/to/pre-trained/model>

或者,你可以使用以下命令。

在ScanObjectNN上进行微调,运行:

CUDA_VISIBLE_DEVICES=<GPUs> python main.py --config cfgs/full/finetune_scan_hardest.yaml \

--finetune_model --exp_name <exp_name> --ckpts <path/to/pre-trained/model>

在ModelNet40上进行微调,运行:

CUDA_VISIBLE_DEVICES=<GPUs> python main.py --config cfgs/full/finetune_modelnet.yaml \

--finetune_model --exp_name <exp_name> --ckpts <path/to/pre-trained/model>

6. ReCon测试&投票

使用默认配置进行测试&投票,运行脚本:

bash scripts/test.sh <GPU> <exp_name> <path/to/best/fine-tuned/model>

或:

CUDA_VISIBLE_DEVICES=<GPUs> python main.py --test --config cfgs/finetune_modelnet.yaml \

--exp_name <output_file_name> --ckpts <path/to/best/fine-tuned/model>

7. ReCon小样本

使用默认配置进行小样本学习,运行脚本:

sh scripts/fewshot.sh <GPU> <exp_name> <path/to/pre-trained/model> <way> <shot> <fold>

或

CUDA_VISIBLE_DEVICES=<GPUs> python main.py --config cfgs/full/fewshot.yaml --finetune_model \

--ckpts <path/to/pre-trained/model> --exp_name <exp_name> --way <5 or 10> --shot <10 or 20> --fold <0-9>

8. ReCon零样本

使用默认配置进行零样本学习,运行脚本:

bash scripts/zeroshot.sh <GPU> <exp_name> <path/to/pre-trained/model>

9. ReCon部件分割

在ShapeNetPart上进行部件分割,运行:

cd segmentation

bash seg.sh <GPU> <exp_name> <path/to/pre-trained/model>

或

cd segmentation

python main.py --ckpts <path/to/pre-trained/model> --log_dir <path/to/log/dir> --learning_rate 0.0001 --epoch 300

在ShapeNetPart上测试部件分割,运行:

cd segmentation

bash test.sh <GPU> <exp_name> <path/to/best/fine-tuned/model>

10. ReCon线性SVM

在ModelNet40上进行线性SVM,运行:

sh scripts/svm.sh <GPU> <exp_name> <path/to/pre-trained/model>

11. 可视化

我们使用PointVisualizaiton仓库来渲染漂亮的点云图像,包括指定颜色渲染和注意力分布渲染。

联系方式

如果你有任何与代码或论文相关的问题,欢迎发邮件给Zekun(qizekun@gmail.com)或Runpei(runpei.dong@gmail.com)。

许可证

ReCon在MIT许可证下发布。更多详情请参见LICENSE文件。此外,pointnet2模块的许可信息可以在这里找到。

致谢

本代码库基于Point-MAE、Point-BERT、CLIP、Pointnet2_PyTorch和ACT构建。

引用

如果你在研究中发现我们的工作有用,请考虑引用:

@inproceedings{qi2023recon,

title={Contrast with Reconstruct: Contrastive 3D Representation Learning Guided by Generative Pretraining},

author={Qi, Zekun and Dong, Runpei and Fan, Guofan and Ge, Zheng and Zhang, Xiangyu and Ma, Kaisheng and Yi, Li},

booktitle={International Conference on Machine Learning (ICML) },

year={2023}

}

@inproceedings{dong2023act,

title={Autoencoders as Cross-Modal Teachers: Can Pretrained 2D Image Transformers Help 3D Representation Learning?},

author={Runpei Dong and Zekun Qi and Linfeng Zhang and Junbo Zhang and Jianjian Sun and Zheng Ge and Li Yi and Kaisheng Ma},

booktitle={The Eleventh International Conference on Learning Representations (ICLR) },

year={2023},

url={https://openreview.net/forum?id=8Oun8ZUVe8N}

}

@inproceedings{qi2024shapellm,

author = {Qi, Zekun and Dong, Runpei and Zhang, Shaochen and Geng, Haoran and Han, Chunrui and Ge, Zheng and Yi, Li and Ma, Kaisheng},

title = {ShapeLLM: Universal 3D Object Understanding for Embodied Interaction},

booktitle={European Conference on Computer Vision (ECCV) },

year = {2024}

}

Github

Github 论文

论文