利用10亿人物角色实现合成数据创建的规模化

新闻

- [2024年7月8日] 🚀🚀🚀 添加了代码以演示使用gpt-4o(openai)或开源模型(vllm)进行基于人物角色的数据合成

- [2024年6月30日] 🚀🚀🚀 论文初步公布以及PERSONA HUB和合成数据样本的首次发布

简介

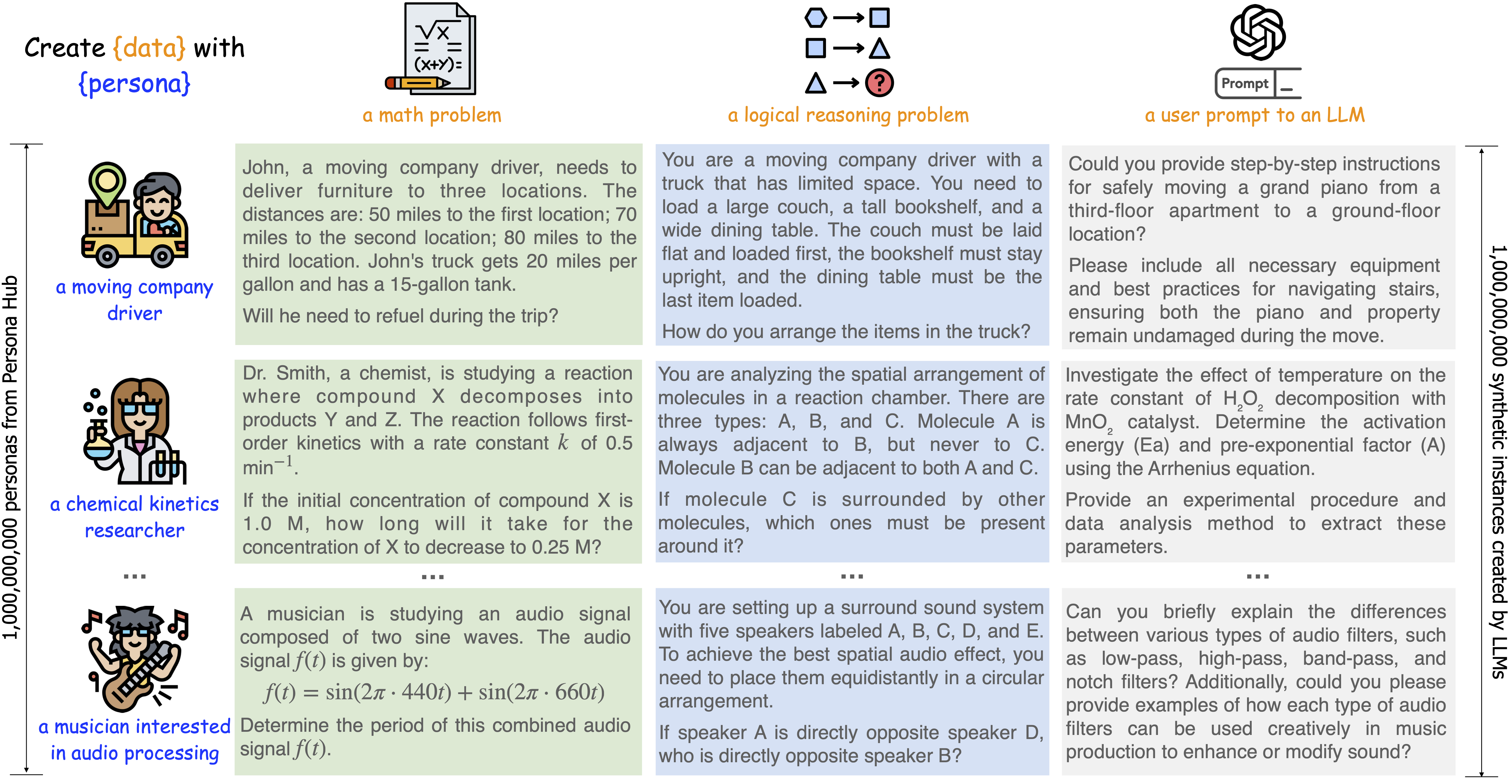

我们提出了一种新颖的基于人物角色驱动的数据合成方法,利用大型语言模型(LLM)中的各种视角来创建多样化的合成数据。为了充分发挥这种方法的规模效应,我们推出了PERSONA HUB——一个从网络数据中自动筛选出的10亿多样化人物角色集合。这10亿个人物角色(约占世界总人口的13%)作为分布式的世界知识载体,几乎可以触及LLM中包含的每一个视角,从而促进在各种场景下大规模创建多样化的合成数据。通过展示PERSONA HUB在大规模合成高质量数学和逻辑推理问题、指令(即用户提示)、富含知识的文本、游戏NPC和工具(函数)方面的应用案例,我们证明了基于人物角色驱动的数据合成方法具有多功能性、可扩展性、灵活性和易用性,可能会推动合成数据创建和实际应用的范式转变,这可能对LLM的研究和开发产生深远影响。

数据发布

合成数据样本

为了促进基于人物角色驱动的数据合成研究,我们初步发布了以下使用各种人物角色创建的合成数据样本,包括:

- 50,000个数学问题

- 50,000个逻辑推理问题

- 50,000条指令

- 10,000篇富含知识的文本

- 10,000个游戏NPC

- 5,000个工具(函数)

Persona Hub

我们还发布了PERSONA HUB的一个子集,包括:

- 200,000个人物角色

您也可以在huggingface上快速预览这些数据。

运行演示

您可以通过简单运行以下命令来尝试使用PERSONA HUB合成数据的演示:

# 确保您已安装datasets和openai(pip install datasets openai)并在运行前配置了openai_api_key

bash demo_openai_synthesize.sh # 使用gpt4o与PERSONA HUB合成数据

或

# 确保您已安装datasets、transformers和vllm(pip install datasets transformers vllm)

bash demo_vllm_synthesize.sh # 使用开源模型与PERSONA HUB合成数据

请注意,我们提供的数据合成提示模板仅供参考。您可以在code/prompt_templates.py中自定义所需的提示。

联系方式

请发送电子邮件至xinchan@global.tencent.com或dyu@global.tencent.com

免责声明

PERSONA HUB可以促进十亿规模的合成数据创建,以模拟来自各种现实世界用户的多样化输入(即用例)。如果将这些数据用作输入来大规模查询目标LLM以获取其输出,存在极高风险,可能导致LLM的知识、智能和能力被转储并轻易复制,从而挑战最强大LLM的领先地位。避免滥用并确保道德和负责任的应用至关重要,以防止隐私侵犯和其他道德问题。

发布的数据全部由公开可用的模型(GPT-4、Llama-3和Qwen)生成,仅用于研究目的。在使用合成数据时,用户还必须遵守这些模型各自的许可协议和使用政策。数据可能包含不准确、不安全的内容或偏见,对此我们不承担责任。使用前请评估其准确性和适用性。腾讯及其许可方按原样提供数据,不作任何明示或暗示的保证。数据中表达的观点和意见不一定反映腾讯的观点。

Github

Github Huggingface

Huggingface 论文

论文