ARCTIC 🥶: 双手灵巧操纵物体的数据集

[ 项目主页 ] [ 论文 ] [ 视频 ] [ 注册ARCTIC账号 ] [ ECCV'24竞赛 ] [ [排行榜](https://github.com/zc-alexfan/arctic/blob/master/docs/leaderboard.md ]

这是一个用于预处理、分割、可视化和渲染(RGB、深度、分割掩码)ARCTIC数据集的代码库。 此外,我们在此提供了复现我们在CVPR 2023论文(温哥华,不列颠哥伦比亚省 🇨🇦)中基线模型的代码,以及开发自定义模型的代码。

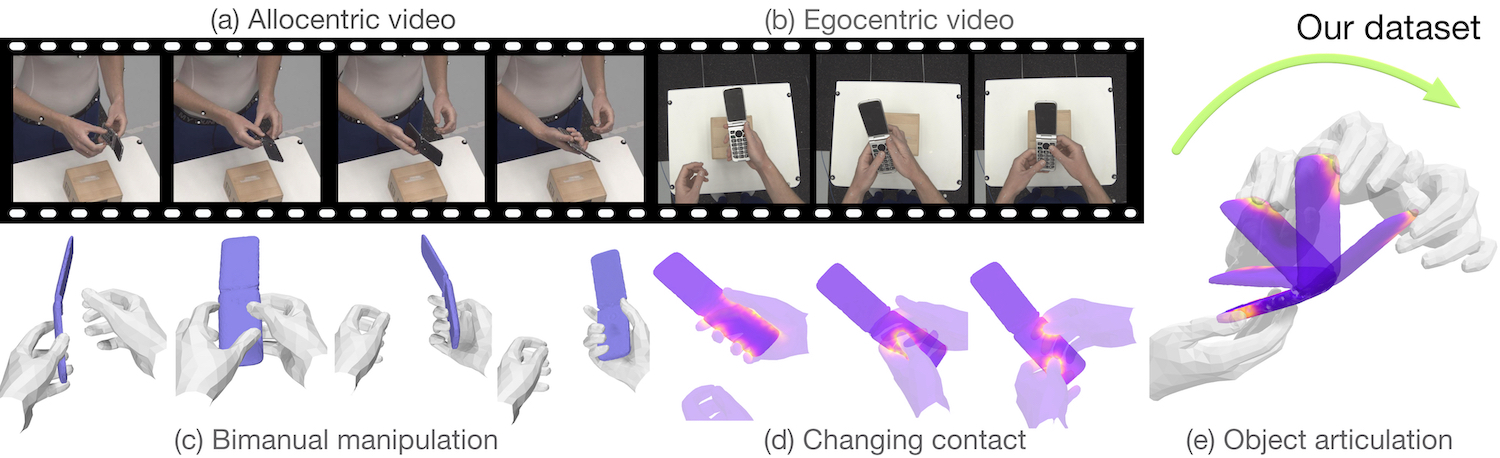

我们的数据集包含高度灵巧的动作:

新闻

✨CVPR 2024亮点:HOLD是第一个从单目视频中联合重建关节手和物体的方法,无需假设预先扫描的物体模板和3D手-物体训练数据。详情请查看我们的项目主页。

- 2024.07.07:我们在ECCV'24举办HANDS研讨会,无需模板重建ARCTIC中的手和物体。在此加入我们

- 2023.12.20:现在可以下载动作捕捉数据!请查看下载说明和可视化。

- 2023.09.11:ARCTIC排行榜上线!

- 2023.06.16:ICCV ARCTIC 挑战赛开始!

- 2023.05.04:ARCTIC数据集及其数据加载器、可视化工具、模型代码正式发布(1.0版)!

- 2023.03.25:ARCTIC ☃️ 数据集(0.1版)发布!🎉

CVPR2023受邀演讲/海报:

为什么使用ARCTIC?

数据集概述:

- 包含210万高分辨率图像和配对的标注帧,支持大规模机器学习。

- 图像来自8个第三人称视角和1个第一人称视角(用于混合现实设置)。

- 包含SMPL-X、MANO、关节物体的3D真实数据。

- 使用54个高端Vicon摄像头在动作捕捉环境中采集。

- 特征是高度灵巧的双手操作动作(超越准静态抓取)。

ARCTIC可用于的潜在任务:

- 无模板双手手-物体重建

- 生成带关节物体的手部抓取或动作

- 生成带关节物体的全身抓取或动作

- 从深度图像中评估场景中有人的关节物体姿态估计器的性能

- 研究我们新提出的任务:一致动作重建和交互场估计

- 研究第一人称视角的手-物体重建

- 从RGB图像重建带手和关节物体的全身

更多详情请查看我们的项目主页。

第三方ARCTIC资源

使用ARCTIC的项目

重建:

- Get a Grip:在第一人称视频中重建手-物体稳定抓取

- 野外第一人称图像中的3D手部姿态估计

- 缓解图像裁剪中透视畸变引起的形状歧义

- SMPLer-X:扩展表现力丰富的人体姿态和形状估计

- 第一人称手-物体交互姿态估计的基准和挑战

生成:

- ArtiGrasp:物理可行的双手灵巧抓取和关节操作合成

- GeneOH扩散:通过去噪扩散实现可泛化的手-物体交互去噪

- Text2HOI:基于文本引导的3D手-物体交互动作生成

- QuasiSim:用于灵巧操作迁移的参数化准物理模拟器

- InterHandGen:通过级联反向扩散生成双手交互

如有遗漏项目,请创建拉取请求。

功能

- 下载ARCTIC数据集的说明。

- 处理我们的数据集并构建数据分割的脚本。

- 将我们的3D数据渲染为RGB、深度和分割掩码的渲染脚本。

- 用于与我们的数据集交互的查看器。

- 设置数据、代码和环境以训练我们的基线模型的说明。

- 用于训练、可视化和评估ARCTIC基准的ArcticNet和InterField结果的通用代码库。

- 用于与预测结果交互的查看器。

入门

获取代码副本:

git clone https://github.com/zc-alexfan/arctic.git

- 设置环境:请参阅

docs/setup.md - 下载和可视化ARCTIC数据集:请参阅

docs/data/README.md - 训练和评估我们的ARCTIC基线模型:请参阅

docs/model/README.md - 在测试集上评估:请参阅

docs/leaderboard.md - 常见问题:请参阅

docs/faq.md

许可证

请参阅 LICENSE。

引用

@inproceedings{fan2023arctic,

title = {{ARCTIC}: 用于灵巧双手操作物体的数据集},

author = {Fan, Zicong and Taheri, Omid and Tzionas, Dimitrios and Kocabas, Muhammed and Kaufmann, Manuel and Black, Michael J. and Hilliges, Otmar},

booktitle = {IEEE计算机视觉与模式识别会议论文集 (CVPR)},

year = {2023}

}

我们的论文从 aitviewer 中受益良多。如果您觉得我们的查看器有用,为了感谢他们的辛勤工作,请考虑引用:

@software{kaufmann_vechev_aitviewer_2022,

author = {Kaufmann, Manuel and Vechev, Velko and Mylonopoulos, Dario},

doi = {10.5281/zenodo.1234},

month = {7},

title = {{aitviewer}},

url = {https://github.com/eth-ait/aitviewer},

year = {2022}

}

致谢

构建 ARCTIC 数据集是一项巨大的努力。作者衷心感谢:Tsvetelina Alexiadis (TA) 负责试验协调;Markus Höschle (MH)、Senya Polikovsky、Matvey Safroshkin、Tobias Bauch (TB) 负责捕捉设置;MH、TA 和 Galina Henz 负责数据捕捉;Priyanka Patel 负责对齐;Giorgio Becherini 和 Nima Ghorbani 负责 MoSh++;Leyre Sánchez Vinuela、Andres Camilo Mendoza Patino、Mustafa Alperen Ekinci 负责数据清理;TB 负责 Vicon 支持;MH 和 Jakob Reinhardt 负责物体扫描;Taylor McConnell 负责 Vicon 支持和数据清理协调;Benjamin Pellkofer 负责 IT/网络支持;Neelay Shah、Jean-Claude Passy、Valkyrie Felso 负责评估服务器。我们还要感谢 Adrian Spurr 和 Xu Chen 提供的有见地的讨论。OT 和 DT 得到了德国联邦教育和研究部(BMBF)的支持:图宾根人工智能中心,FKZ:01IS18039B"。

联系方式

如有技术问题,请创建一个 issue。其他问题请联系 arctic@tue.mpg.de。

商业许可请联系 ps-licensing@tue.mpg.de。

访问官网

访问官网 Github

Github 论文

论文