UniRef++:在空间和时间空间中分割每个参考对象

UniRef++的官方实现,这是ICCV2023 UniRef的扩展版本。

亮点

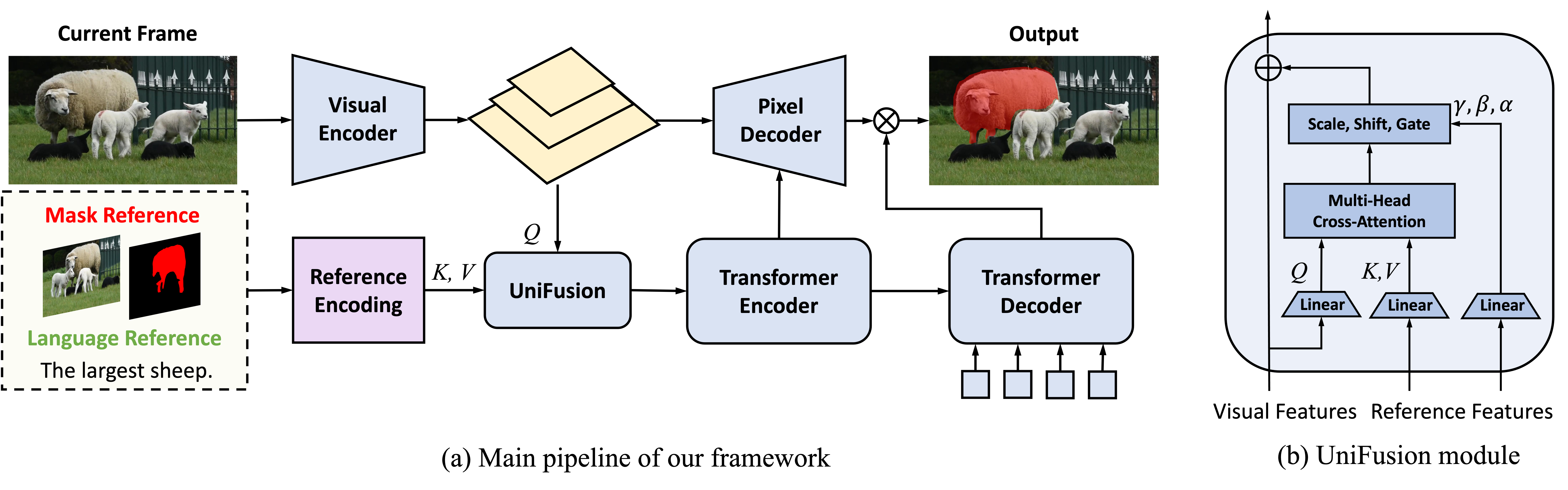

- UniRef/UniRef++是一个统一的模型,用于四个对象分割任务:指代图像分割(RIS)、少样本分割(FSS)、指代视频对象分割(RVOS)和视频对象分割(VOS)。

- UniRef++的核心是UniFusion模块,用于将各种参考信息注入网络。我们使用闪光注意力机制高效地实现了它。

- UniFusion可以作为SAM等基础模型的插件组件。

进度

- 添加训练指南

- 添加评估指南

- 添加数据准备

- 发布模型检查点

- 发布代码

结果

https://github.com/FoundationVision/UniRef/assets/21001460/63d875ed-9f5b-47c9-998f-e83faffedbba

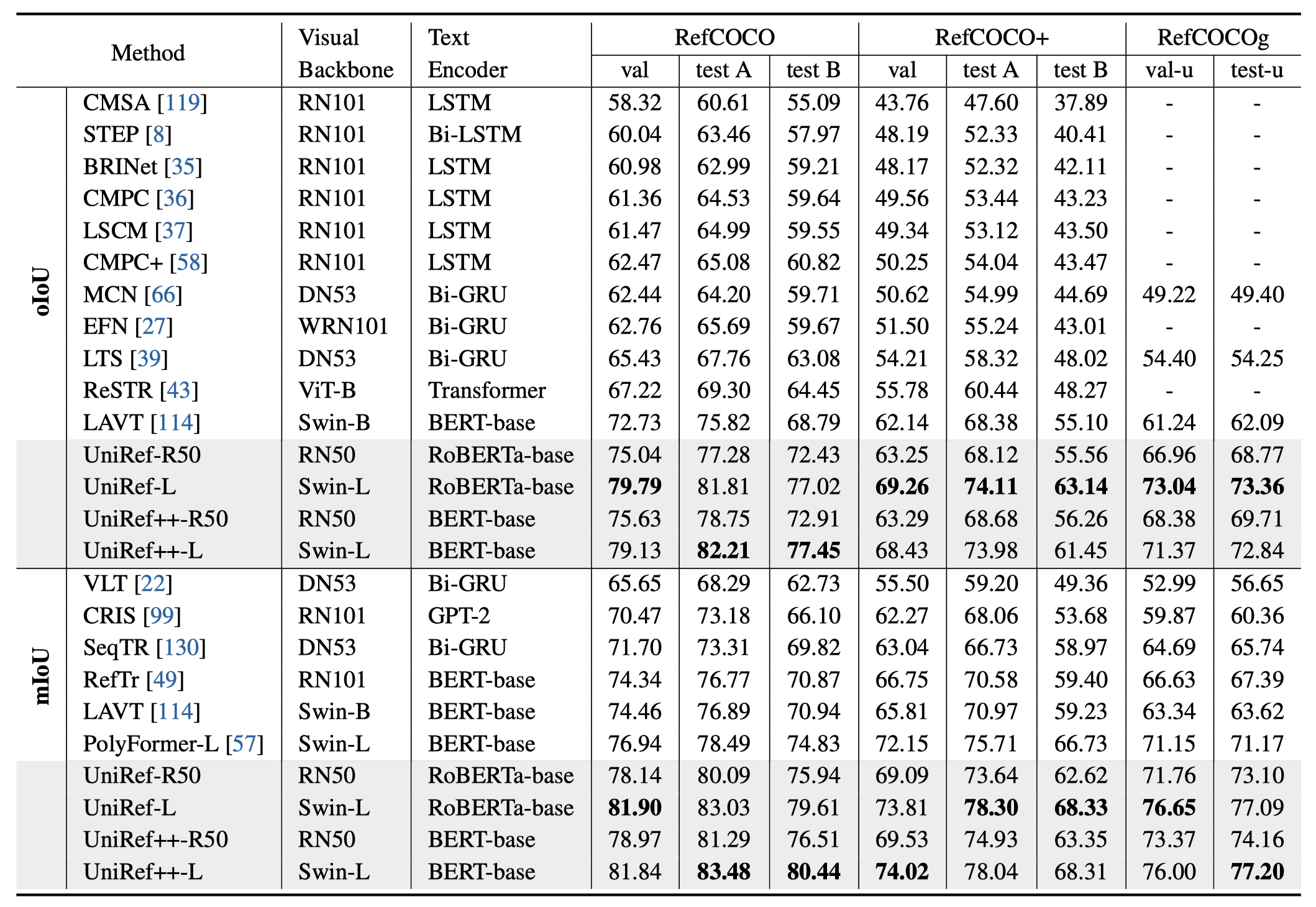

指代图像分割

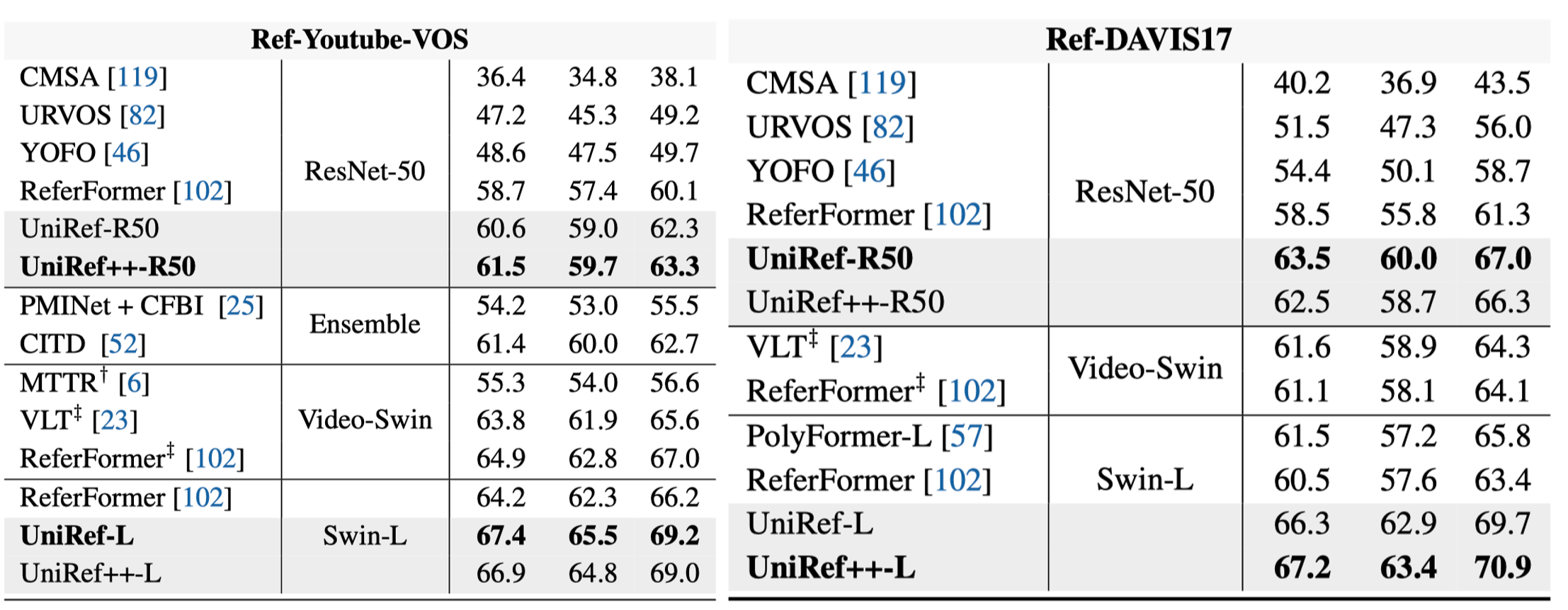

指代视频对象分割

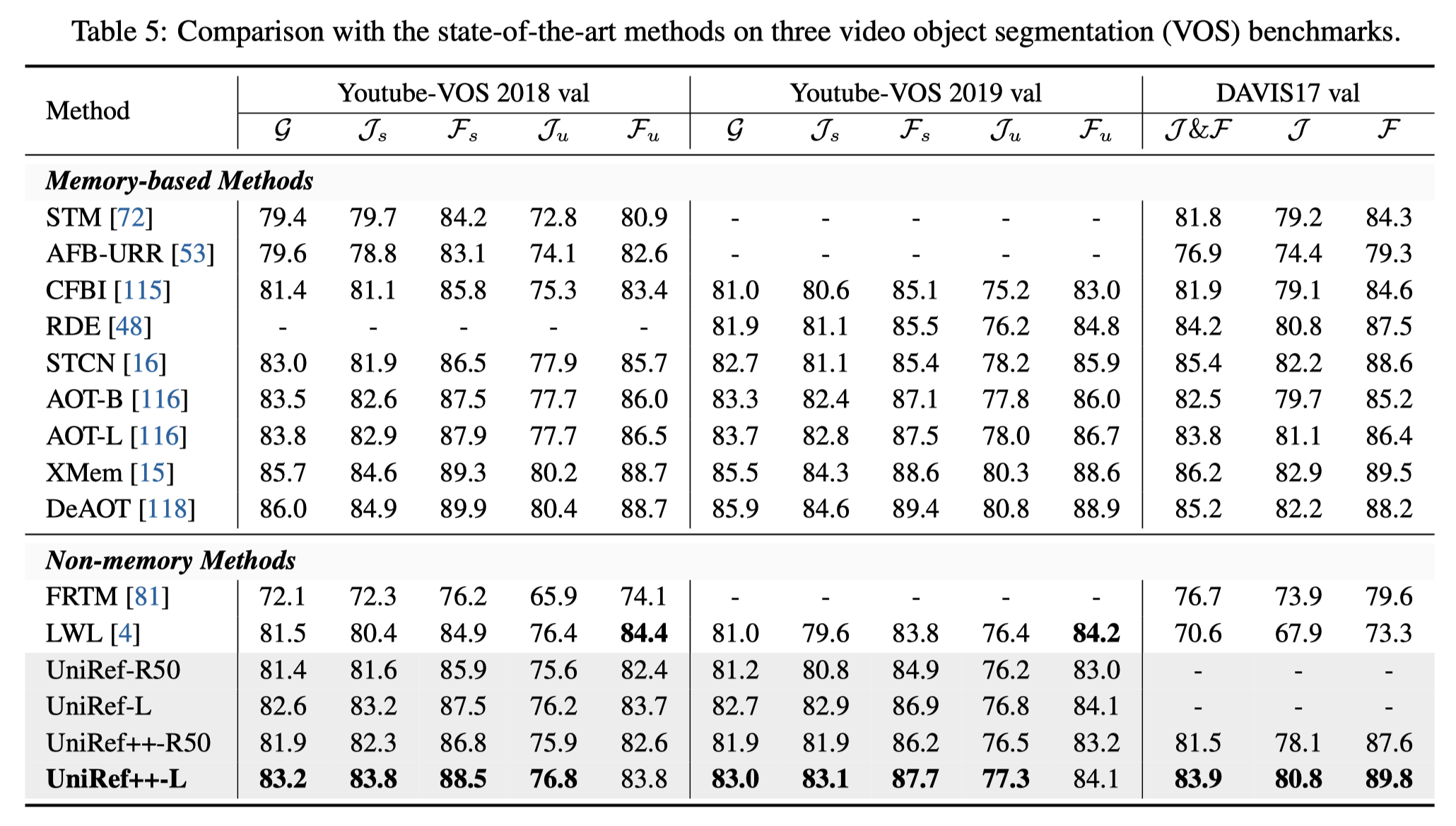

视频对象分割

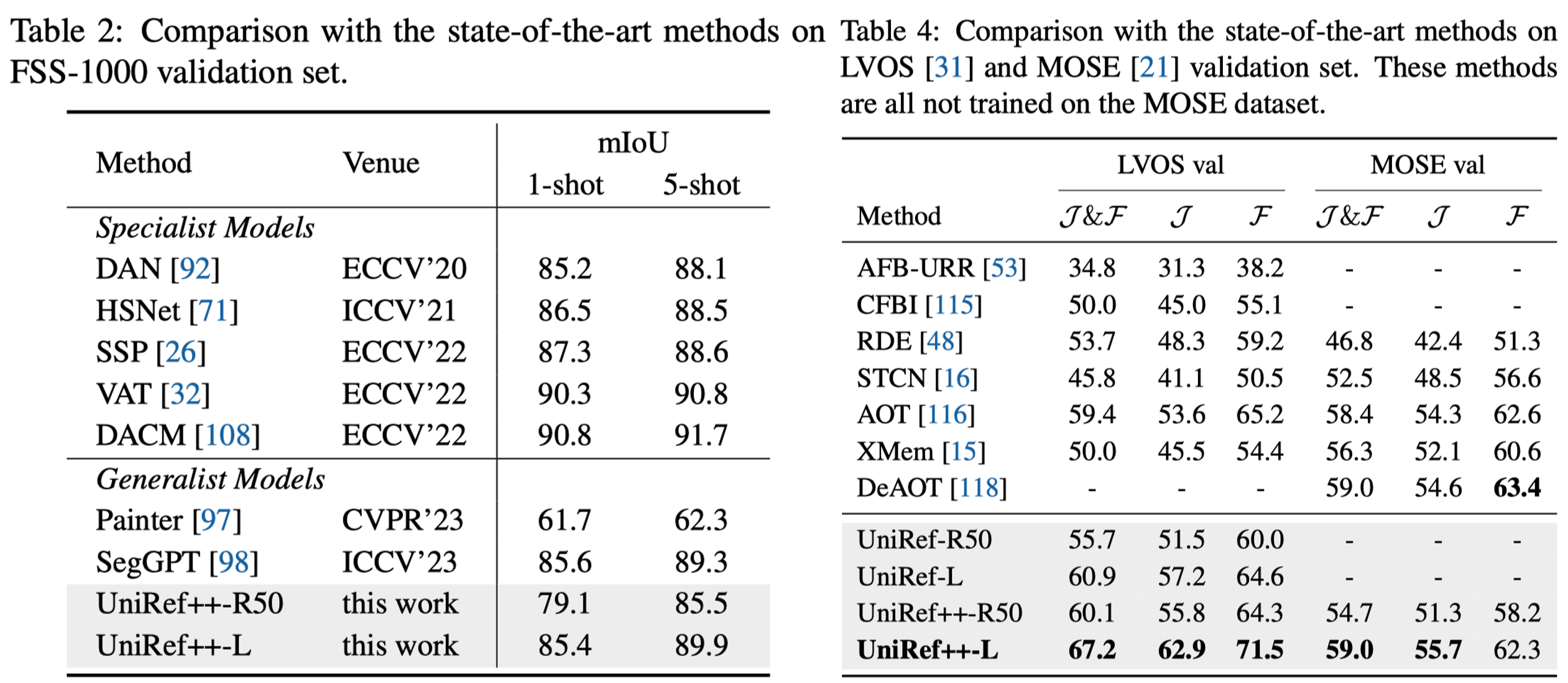

零样本视频分割和少样本图像分割

模型库

Objects365预训练

图像联合训练

视频联合训练

结果在验证集上报告。

| 模型 | RefCOCO | FSS-1000 | Ref-Youtube-VOS | Ref-DAVIS17 | Youtube-VOS18 | DAVIS17 | LVOS | 检查点 |

|---|---|---|---|---|---|---|---|---|

| UniRef++-R50 | 75.6 | 79.1 | 61.5 | 63.5 | 81.9 | 81.5 | 60.1 | 模型 |

| UniRef++-Swin-L | 79.1 | 85.4 | 66.9 | 67.2 | 83.2 | 83.9 | 67.2 | 模型 |

安装

请参阅INSTALL.md

入门指南

请参阅DATA.md了解数据准备。

请参阅EVAL.md了解评估。

请参阅TRAIN.md了解训练。

引用

如果您在研究中发现这个项目有用,请考虑引用:

@article{wu2023uniref++,

title={UniRef++: Segment Every Reference Object in Spatial and Temporal Spaces},

author={Wu, Jiannan and Jiang, Yi and Yan, Bin and Lu, Huchuan and Yuan, Zehuan and Luo, Ping},

journal={arXiv preprint arXiv:2312.15715},

year={2023}

}

@inproceedings{wu2023uniref,

title={Segment Every Reference Object in Spatial and Temporal Spaces},

author={Wu, Jiannan and Jiang, Yi and Yan, Bin and Lu, Huchuan and Yuan, Zehuan and Luo, Ping},

booktitle={Proceedings of the IEEE/CVF International Conference on Computer Vision},

pages={2538--2550},

year={2023}

}

致谢

该项目基于UNINEXT代码库。我们还参考了Detectron2、Deformable DETR、STCN、SAM等仓库。感谢他们的出色工作!

访问官网

访问官网 Github

Github