🔥 学习可解释性工具 (LIT)

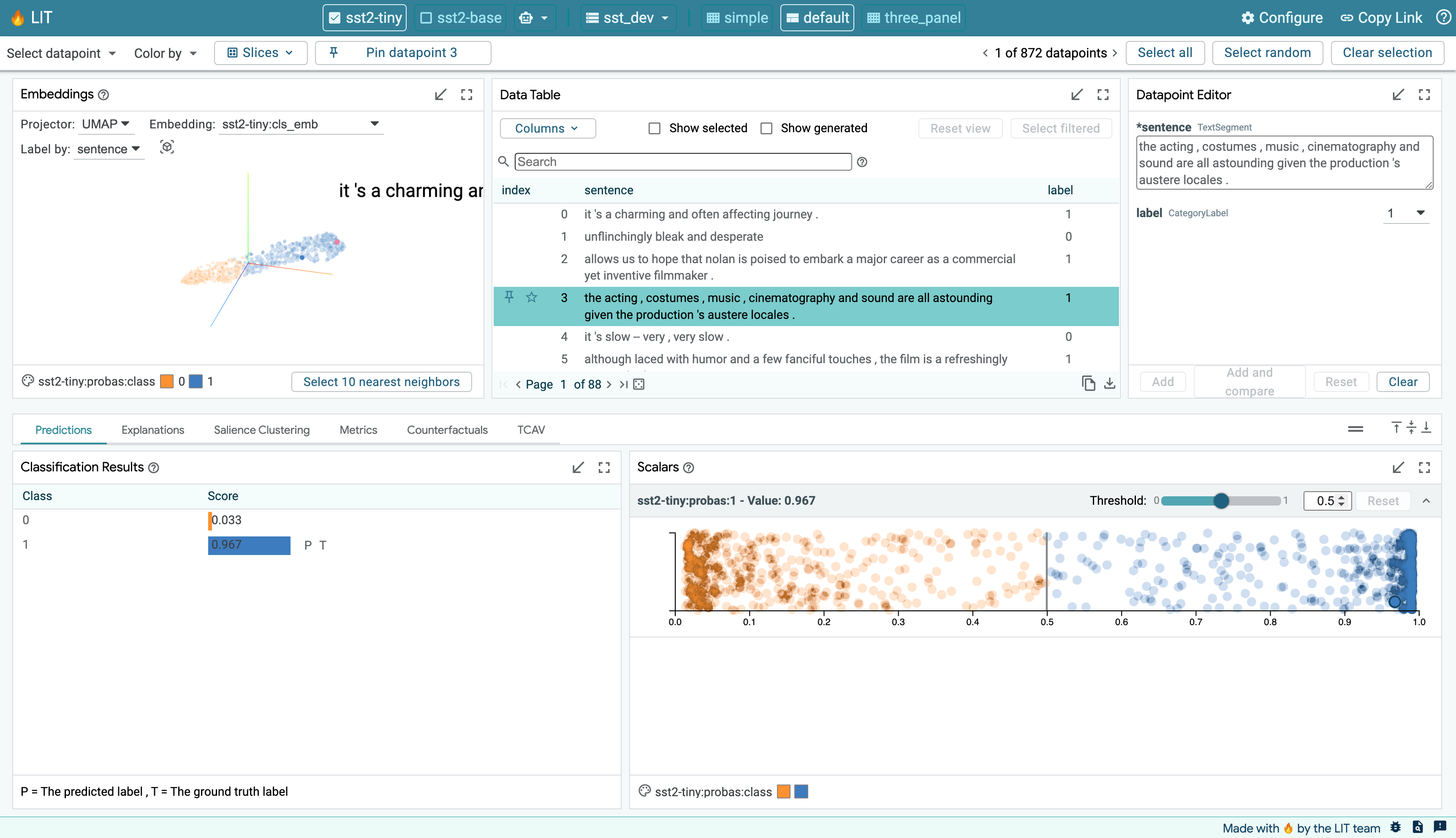

学习可解释性工具(🔥LIT,前身为语言可解释性工具)是一个可视化、交互式的机器学习模型理解工具,支持文本、图像和表格数据。它可以作为独立服务器运行,也可以在 Colab、Jupyter 和 Google Cloud Vertex AI 等笔记本环境中运行。

LIT 旨在回答以下问题:

- 我的模型在哪些类型的例子上表现不佳?

- **为什么我的模型做出这样的预测?**这个预测是否可归因于对抗性行为,或训练集中不良的先验?

- 如果我改变文本风格、动词时态或代词性别等因素,我的模型行为是否一致?

LIT 通过基于浏览器的用户界面支持各种调试工作流程。功能包括:

- 通过显著性图和丰富的模型预测可视化进行局部解释。

- 包括自定义指标、切片和分箱以及嵌入空间可视化的聚合分析。

- 通过手动编辑或生成器插件动态创建和评估新样本的反事实生成。

- 并排模式比较两个或多个模型,或一个模型在一对样本上的表现。

- 高度可扩展以支持新的模型类型,包括分类、回归、跨度标注、序列到序列和语言建模。开箱即用地支持多头模型和多个输入特征。

- 与框架无关,兼容 TensorFlow、PyTorch 等。

LIT 有一个网站,提供在线演示、教程、设置指南等。

通过加入 lit-announcements 邮件列表 获取 LIT 的最新信息。

文档

下载和安装

LIT 可以通过容器镜像运行、通过 pip 安装或从源代码构建。如果您更新了任何前端或核心后端代码,则需要从源代码构建。

构建容器镜像

使用 docker 或 podman 构建镜像:

git clone https://github.com/PAIR-code/lit.git && cd lit

docker build --file Dockerfile --tag lit-nlp .

查看高级指南了解使用默认 LIT Docker 镜像的详细说明、在不同场景下将 LIT 作为容器化 Web 应用运行的方法,以及如何创建自己的 LIT 镜像。

pip 安装

pip install lit-nlp

pip 安装将安装使用 LIT 核心包所需的所有必要先决条件包。

它不会安装提供的演示所需的先决条件,因此您需要自行安装这些包。请参阅 requirements_examples.txt 了解运行演示所需的包列表。

从源代码安装

克隆仓库:

git clone https://github.com/PAIR-code/lit.git && cd lit

注意:确保您运行的是 Python 3.9+。如果您系统上有不同版本,请使用下面的 conda 说明设置 Python 3.9 环境。

使用 venv 设置 Python 环境:

python -m venv .venv

source .venv/bin/activate

或使用 conda 设置 Python 环境:

conda create --name lit-nlp

conda activate lit-nlp

conda install python=3.9

conda install pip

设置好环境后,安装 LIT 的依赖项:

python -m pip install -r requirements.txt

python -m pip install cudnn cupti # 可选,用于 GPU 支持

python -m pip install torch # 可选,用于 PyTorch

# 构建前端

(cd lit_nlp; yarn && yarn build)

注意:使用 -r requirements.txt 选项安装 LIT 库、其测试套件和内置示例所需的所有依赖项。您也可以使用 -r requirements_core.txt(核心库)、-r requirements_test.txt(测试套件)、-r requirements_examples.txt(示例)和/或它们的任意组合来安装这些依赖项的子集。

注意:如果在 Ubuntu/Debian 上运行 yarn 时看到错误,请确保您已安装正确版本。

运行 LIT

在演示页面上探索托管的演示集合。

快速入门:分类和回归

要探索来自流行的 GLUE 基准测试的分类和回归模型任务:

python -m lit_nlp.examples.glue.demo --port=5432 --quickstart

导航到 http://localhost:5432 访问 LIT 用户界面。

您的默认视图将是一个在斯坦福情感树库上微调的小型 BERT 模型,但您可以使用工具栏或右上角的齿轮图标切换到 STS-B 或 MultiNLI。

然后导航到 http://localhost:5432 访问用户界面。

笔记本使用

在lit_nlp/examples/notebooks可以找到展示在笔记本中使用LIT的Colab笔记本。

我们提供了一个简单的Colab演示。运行所有单元格以在笔记本中查看LIT在示例分类模型上的应用。

更多示例

请参阅lit_nlp/examples。大多数示例的运行方式与上面的快速入门示例类似:

python -m lit_nlp.examples.<example_name>.demo --port=5432 [可选 --args]

用户指南

添加自己的模型或数据

您可以通过创建自定义的demo.py启动器轻松地使用自己的模型运行LIT,类似于lit_nlp/examples中的那些。基本步骤如下:

- 编写遵循

DatasetAPI的数据加载器 - 编写遵循

ModelAPI的模型包装器 - 将模型、数据集和任何额外的组件传递给LIT服务器类

完整的步骤说明,请参阅添加模型和数据。

用新组件扩展LIT

LIT可以轻松地通过新的可解释性组件、生成器等进行扩展,无论是在前端还是后端。请查看我们的文档以开始使用。

拉取请求流程

要对LIT进行代码更改,请在dev分支上工作,并针对该分支创建拉取请求(PR)。main分支用于稳定版本,预期dev分支将始终领先于main分支。

鼓励使用草稿PR,尤其是对于首次贡献者或从事复杂任务的贡献者(例如,Google Summer of Code参与者)。请使用这些来与LIT团队交流想法和实现,除了问题之外。

在发送PR或将草稿PR标记为"准备审核"之前,请对您的代码运行Python和TypeScript代码检查工具,以确保符合Google的Python和TypeScript风格指南。

# 从此仓库的根目录使用以下命令在您的代码上运行Pylint

pushd lit_nlp & pylint & popd

# 从此仓库的根目录使用以下命令在您的代码上运行ESLint

pushd lit_nlp & yarn lint & popd

引用LIT

如果您在工作中使用了LIT,请引用我们的EMNLP论文:

@misc{tenney2020language,

title={The Language Interpretability Tool: Extensible, Interactive Visualizations and Analysis for {NLP} Models},

author={Ian Tenney and James Wexler and Jasmijn Bastings and Tolga Bolukbasi and Andy Coenen and Sebastian Gehrmann and Ellen Jiang and Mahima Pushkarna and Carey Radebaugh and Emily Reif and Ann Yuan},

booktitle = "Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: System Demonstrations",

year = "2020",

publisher = "Association for Computational Linguistics",

pages = "107--118",

url = "https://www.aclweb.org/anthology/2020.emnlp-demos.15",

}

免责声明

这不是Google的官方产品。

LIT是一个研究项目,由一个小团队积极开发中。可能会有一些错误和不完善之处,但我们在早期阶段就发布了,因为我们认为它已经相当有用了。我们希望LIT成为一个开放的平台,而不是一个封闭的花园,我们非常欢迎您的建议和反馈 - 请在问题中给我们留言。

访问官网

访问官网 Github

Github 文档

文档 论文

论文