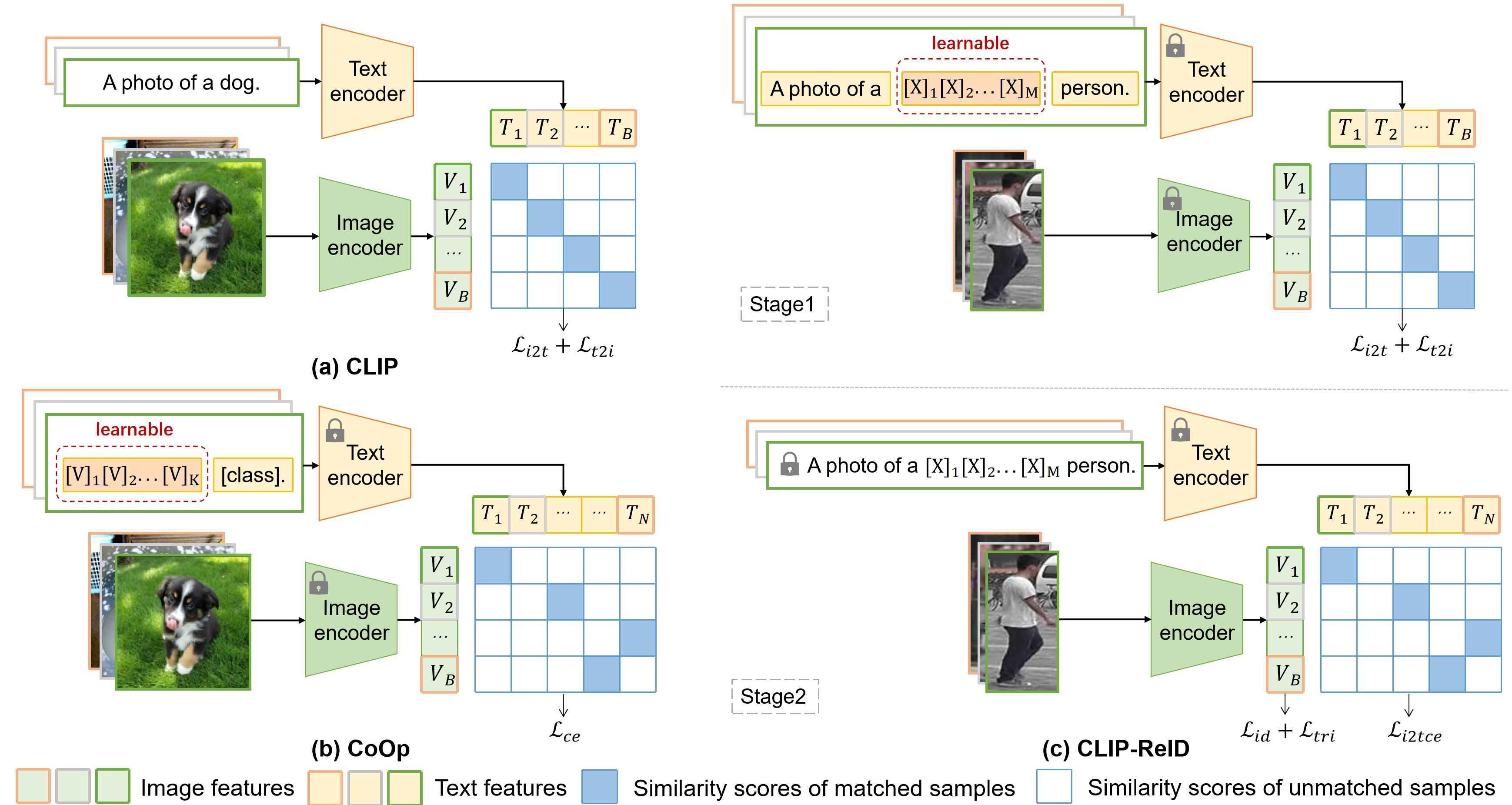

CLIP-ReID: 利用视觉-语言模型进行图像重识别而无需具体文本标签 [pdf]

流程

安装

conda create -n clipreid python=3.8

conda activate clipreid

conda install pytorch==1.8.0 torchvision==0.9.0 torchaudio==0.8.0 cudatoolkit=10.2 -c pytorch

pip install yacs

pip install timm

pip install scikit-image

pip install tqdm

pip install ftfy

pip install regex

准备数据集

下载数据集(Market-1501、MSMT17、DukeMTMC-reID、Occluded-Duke、VehicleID、VeRi-776),然后将它们解压到 your_dataset_dir。

训练

例如,如果你想为Market-1501运行基于CNN的CLIP-ReID基线,你需要修改configs/person/cnn_base.yml底部为

DATASETS:

NAMES: ('market1501')

ROOT_DIR: ('your_dataset_dir')

OUTPUT_DIR: 'your_output_dir'

然后运行

CUDA_VISIBLE_DEVICES=0 python train.py --config_file configs/person/cnn_base.yml

如果你想为MSMT17运行基于ViT的CLIP-ReID,你需要修改configs/person/vit_clipreid.yml底部为

DATASETS:

NAMES: ('msmt17')

ROOT_DIR: ('your_dataset_dir')

OUTPUT_DIR: 'your_output_dir'

然后运行

CUDA_VISIBLE_DEVICES=0 python train_clipreid.py --config_file configs/person/vit_clipreid.yml

如果你想为MSMT17运行基于ViT的CLIP-ReID+SIE+OLP,运行:

CUDA_VISIBLE_DEVICES=0 python train_clipreid.py --config_file configs/person/vit_clipreid.yml MODEL.SIE_CAMERA True MODEL.SIE_COE 1.0 MODEL.STRIDE_SIZE '[12, 12]'

评估

例如,如果你想测试MSMT17的基于ViT的CLIP-ReID

CUDA_VISIBLE_DEVICES=0 python test_clipreid.py --config_file configs/person/vit_clipreid.yml TEST.WEIGHT 'your_trained_checkpoints_path/ViT-B-16_60.pth'

致谢

veri776视角标签来自 https://github.com/Zhongdao/VehicleReIDKeyPointData。

训练模型和测试日志

| 数据集 | MSMT17 | Market | Duke | Occ-Duke | VeRi | VehicleID |

|---|---|---|---|---|---|---|

| CNN-基准模型 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 |

| CNN-CLIP-ReID | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 |

| ViT-基准模型 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 |

| ViT-CLIP-ReID | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 |

| ViT-CLIP-ReID-SIE-OLP | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 | 模型|测试 |

| 请注意,以上列出的所有结果均未经重新排序。 |

经过重新排序后,ViT-CLIP-ReID-SIE-OLP 在 MSMT17 数据集上达到了 86.7% 的 mAP 和 91.1% 的 R1。

引用

如果您在研究中使用了此代码,请引用:

@article{li2022clip,

title={CLIP-ReID: 在没有具体文本标签的情况下利用视觉-语言模型进行图像重识别},

author={李思远 and 孙力 and 李清丽},

journal={arXiv 预印本 arXiv:2211.13977},

year={2022}

}

Github

Github 论文

论文