MultiPLY:3D世界中的多感官物体中心化 具身大语言模型

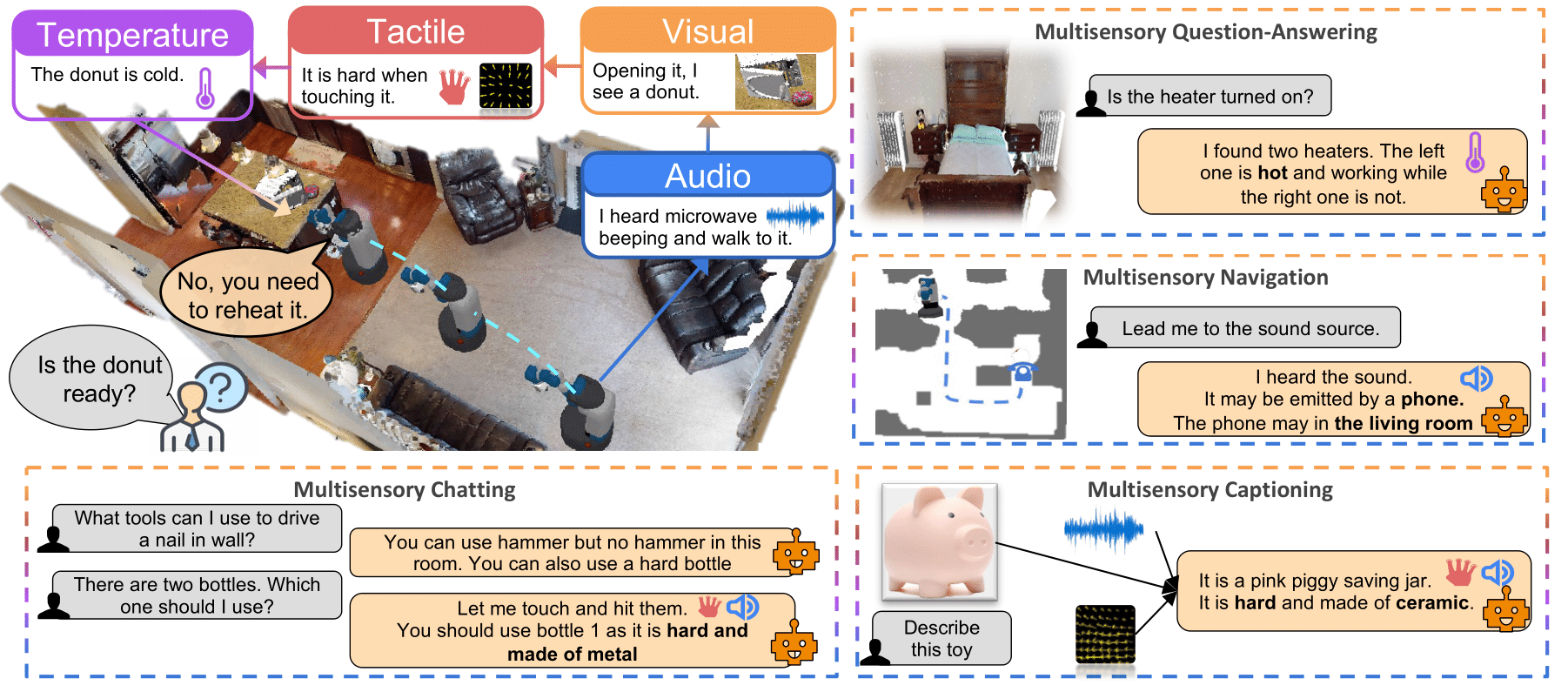

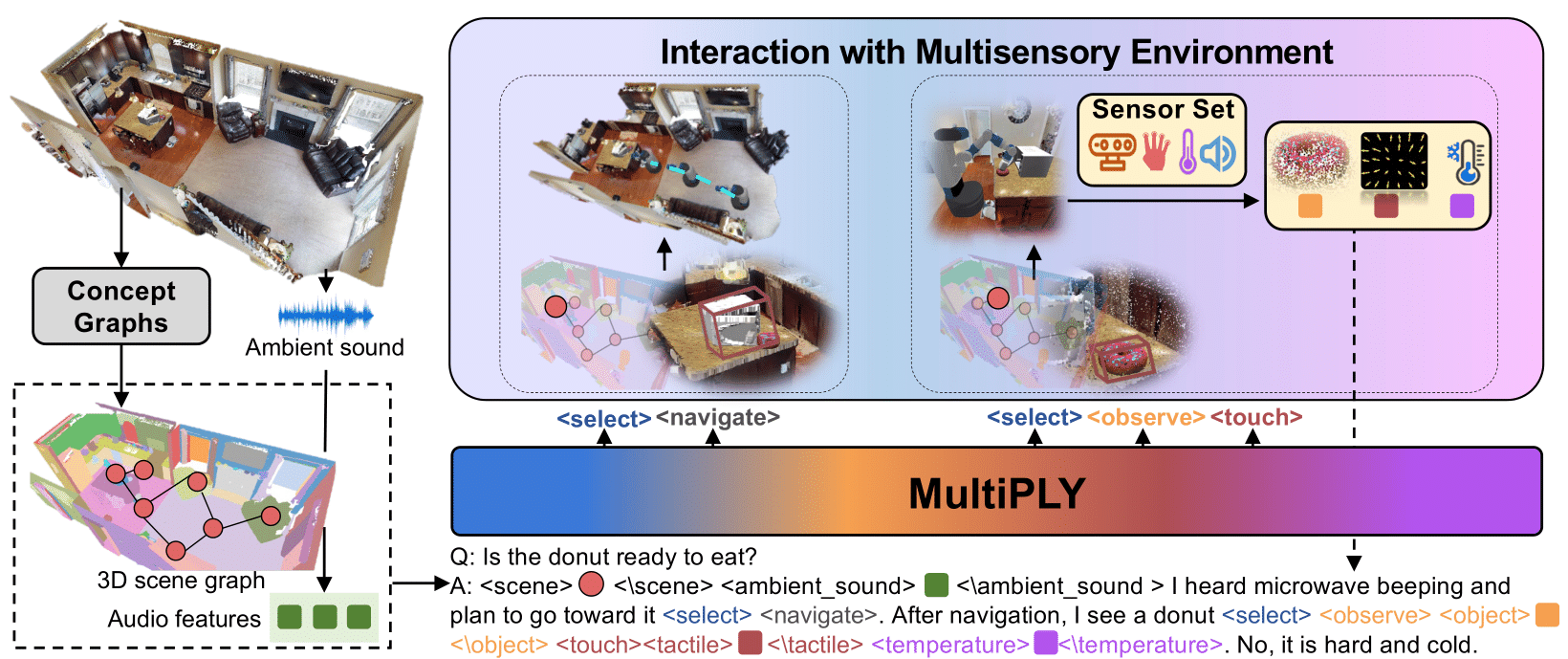

MultiPLY是一个多感官具身大语言模型,能够主动与3D环境中的物体交互并动态收集其多感官信息。它能够将多感官交互数据(包括视觉、听觉、触觉和热感信息)整合到大语言模型中,从而建立单词、动作和感知之间的关联。

方法

我们首先将场景编码为抽象的以物体为中心的表示,而物体的多感官细节只有在代理执行动作并与之交互时才会揭示。我们设计了一组动作标记,表示代理与环境交互的动作。交互结果通过状态标记被附加回大语言模型。

要求

待完成

训练

我们使用FSDP训练。在不同的集群上可能会有所不同。以下是在训练集群上的一个示例:

RANDOM=$$

DIV=1000

OFFSET=24000

MASTER_PORT=$(($RANDOM%$DIV+$OFFSET))

export OMP_NUM_THREADS=1

export TOKENIZERS_PARALLELISM=true

NODE_RANK=${SLURM_PROCID}

SLURM=${SLURM_NODELIST:0:3}

ip=${SLURM}${SLURM_NODELIST:4:2}

# 运行训练脚本

NUM_GPUS_PER_NODE=${1:-8}

echo $NUM_GPUS_PER_NODE

NUM_NODES=${2:-1}

CMD="torchrun --nnodes=$NUM_NODES --nproc_per_node=$NUM_GPUS_PER_NODE --master_addr=$ip --node_rank=$NODE_RANK"

$CMD \

fsdp_train.py --folder retrieval_attention3 --num_epochs=1000

数据集整理

待完成

引用

@article{multiply,

author = {Hong, Yining and Zheng, Zishuo and Chen, Peihao and Wang, Yian and Li, Junyan and Chen, Zhenfang and Gan, Chuang},

title = {MultiPLY: A Multisensory Object-Centric Embodied Large Language Model in 3D World},

journal = {arXiv},

year = {2024},

}

访问官网

访问官网 Github

Github 论文

论文