FreeAskInternet

🎉🎉🎉 太棒了,我们现在有logo了!🎉🎉🎉

在任何电脑上完全免费、本地、私密且无需GPU运行类似www.perplexity.ai的应用 [!重要]

如果您无法正常使用此项目,很可能是由于您的互联网连接或IP存在问题,您需要自由的互联网连接才能正常使用此项目。

什么是FreeAskInternet

FreeAskInternet是一个完全免费、私密且本地运行的搜索聚合器和使用LLM生成答案的工具,无需GPU。用户可以提出问题,系统将使用searxng进行多引擎搜索,并将搜索结果结合到ChatGPT3.5 LLM中,根据搜索结果生成答案。所有过程都在本地运行,无需GPU或OpenAI或Google API密钥。

特点

- 🈚️ 完全免费(无需任何API密钥)

- 💻 完全本地(无需GPU,任何电脑都可运行)

- 🔐 完全私密(所有内容都在本地运行,使用自定义llm)

- 👻 无需LLM硬件即可运行(无需GPU!)

- 🤩 使用免费的ChatGPT3.5 / Qwen / Kimi / ZhipuAI(GLM) API(无需API密钥!感谢OpenAI)

- 🐵 支持自定义LLM(ollama,llama.cpp),是的,我们喜欢ollama!

- 🚀 使用Docker Compose快速易部署

- 🌐 网页和移动设备友好的界面,专为Web搜索增强AI聊天设计,可从任何设备轻松访问。

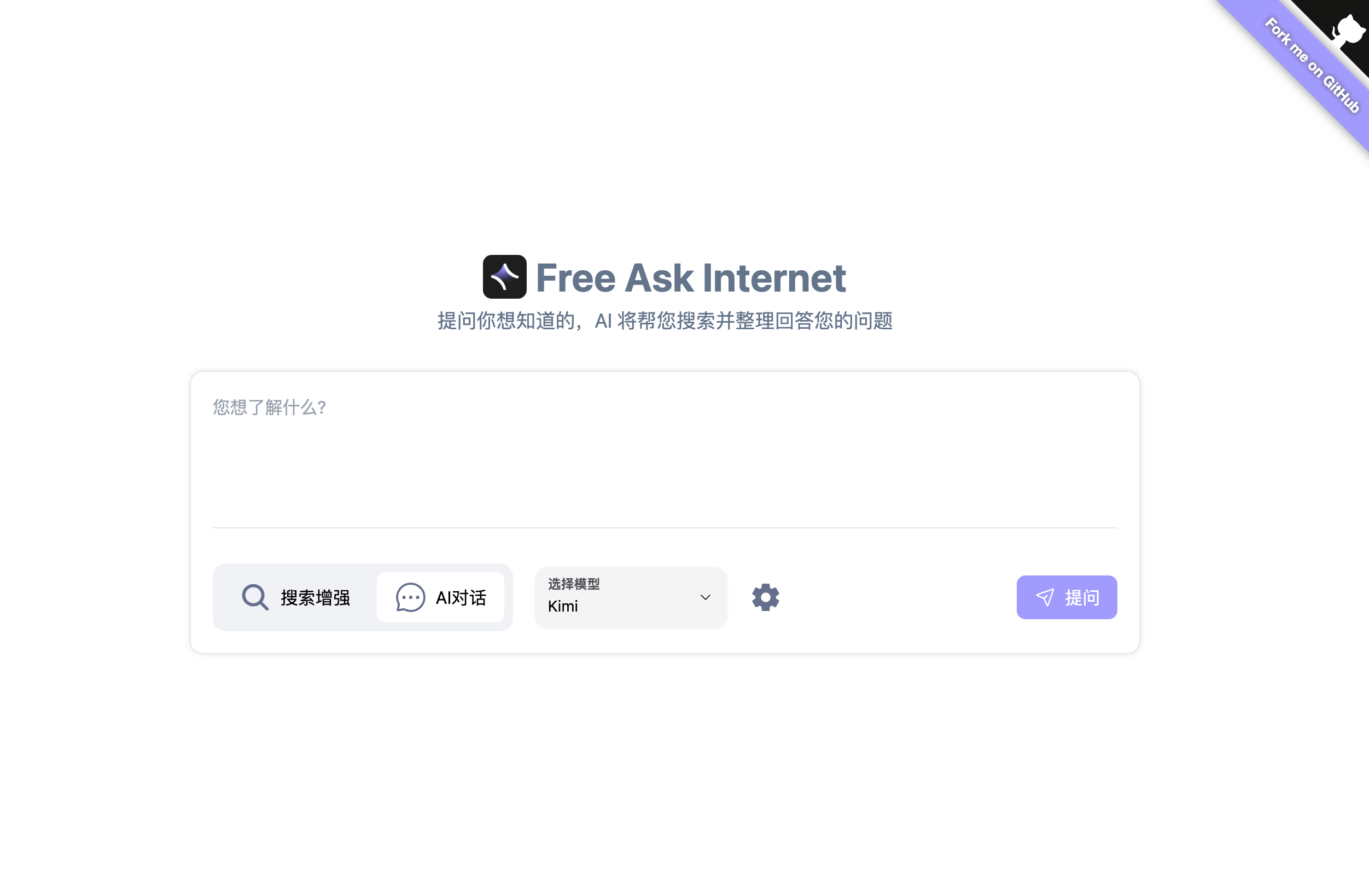

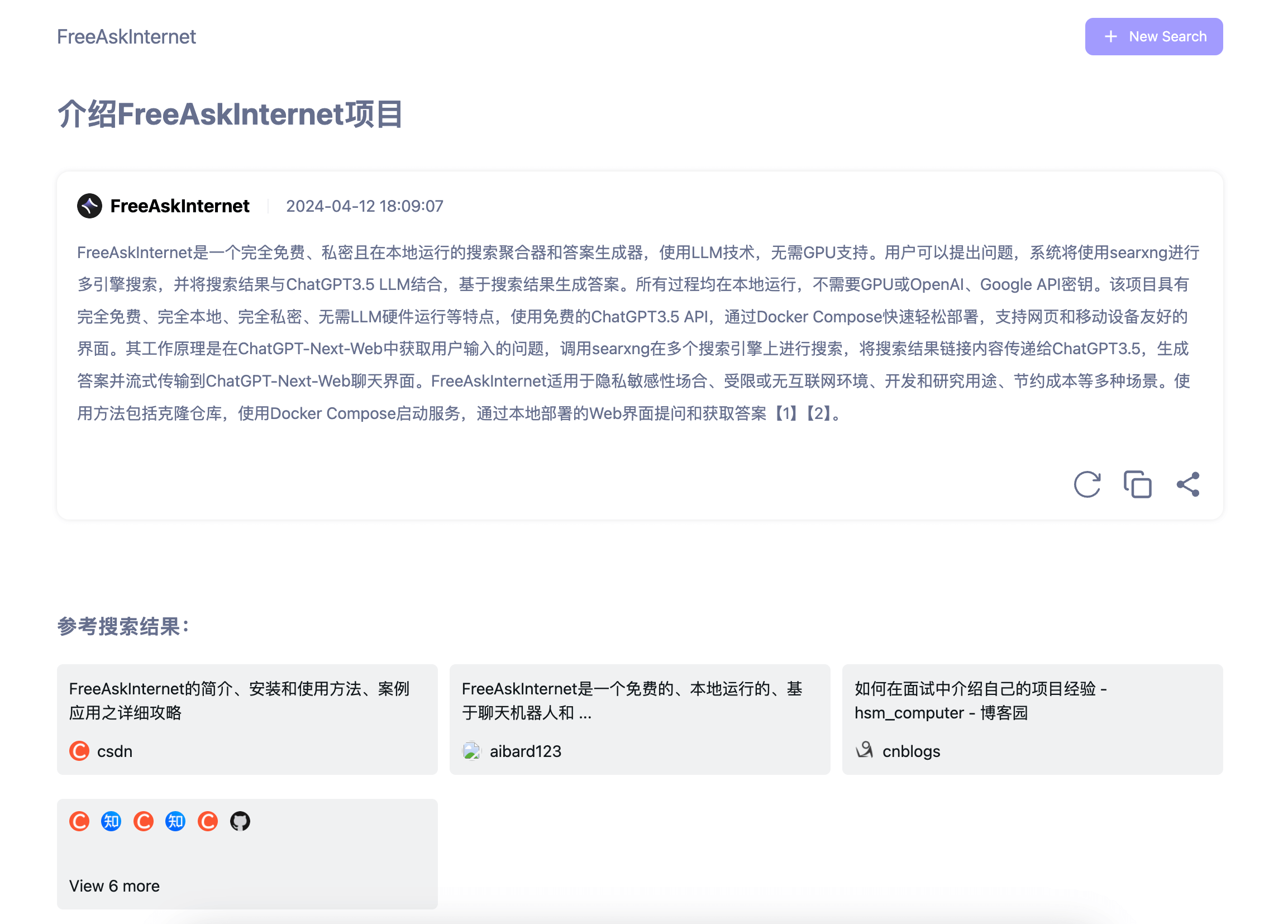

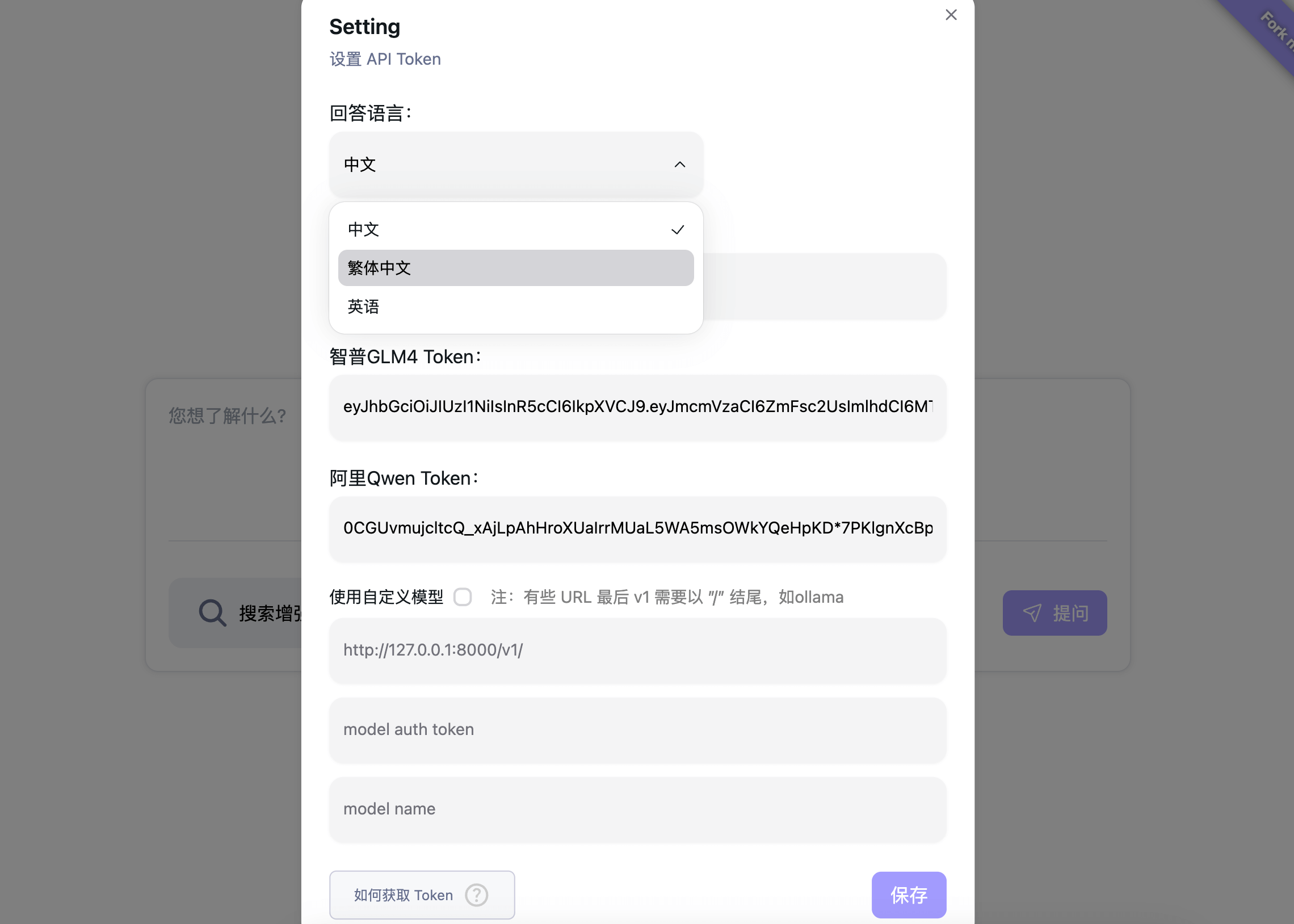

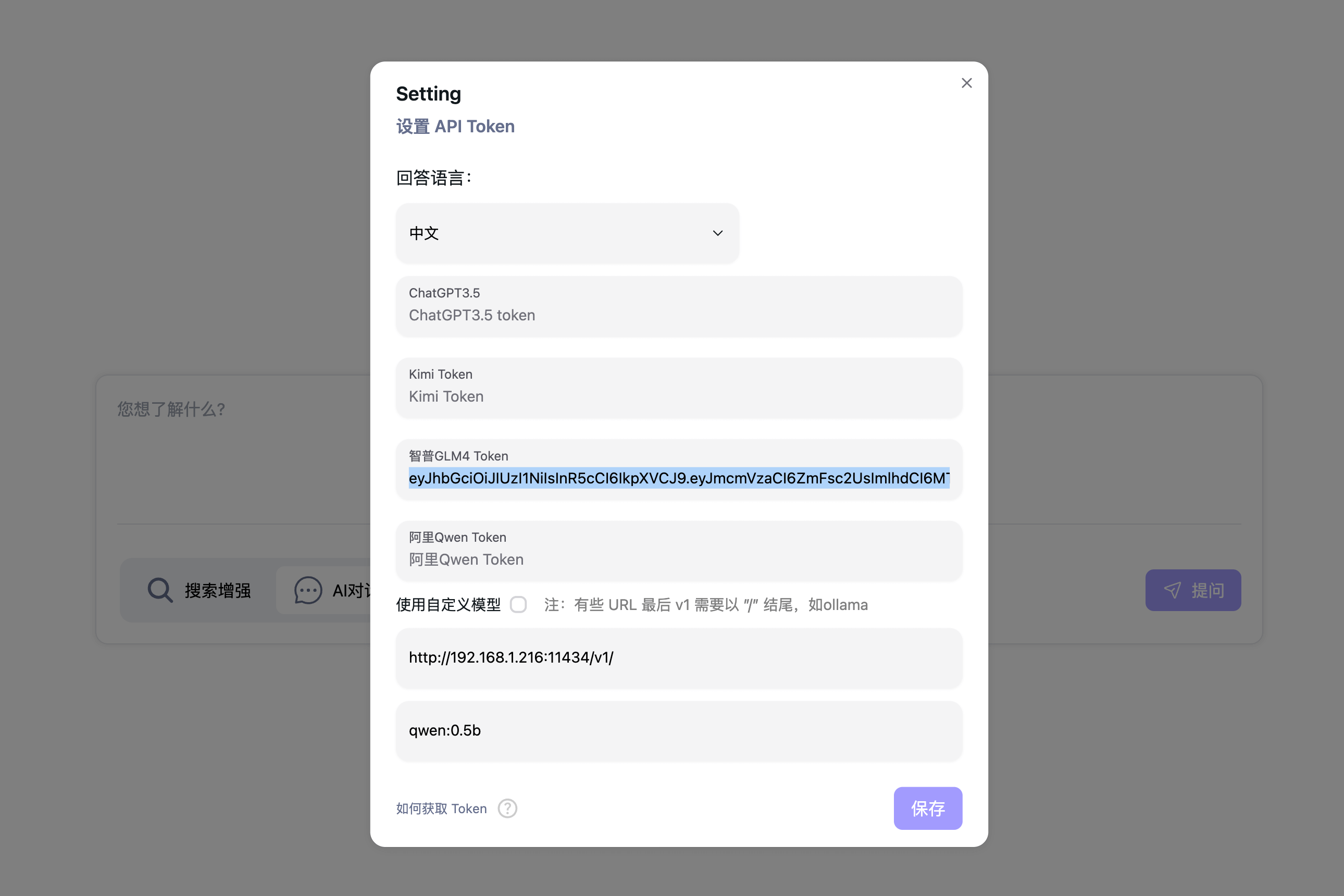

截图

- 首页:

- 基于搜索的AI聊天:

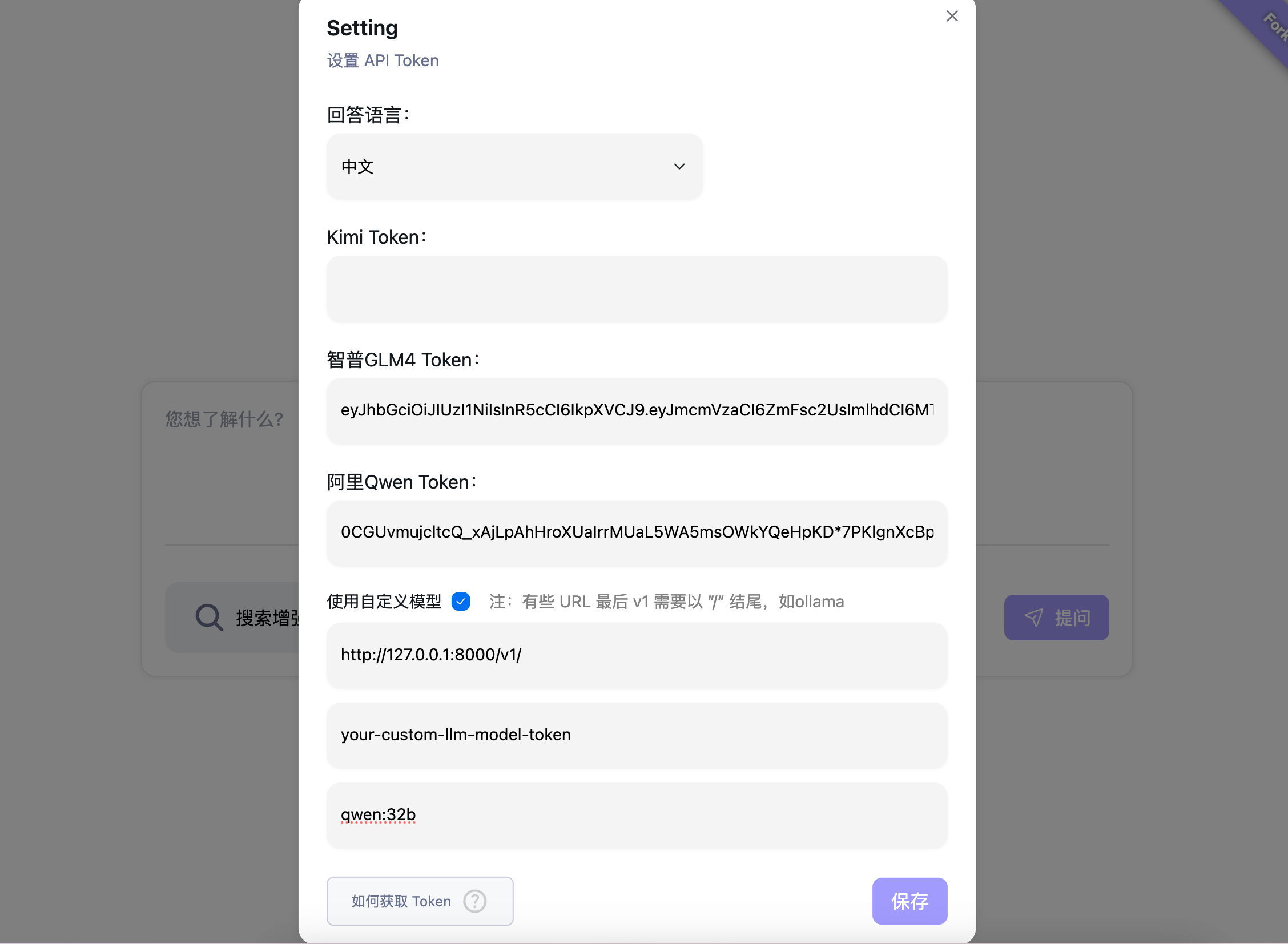

- 多种LLM模型和自定义LLM如ollama支持:

工作原理

- 系统在FreeAskInternet UI界面(本地运行)获取用户输入的问题,并调用searxng(本地运行)在多个搜索引擎上进行搜索。

- 爬取搜索结果链接的内容,并传递给ChatGPT3.5 / Kimi / Qwen / ZhipuAI / ollama(通过使用自定义llm),要求LLM基于这些内容作为参考来回答用户问题。

- 将答案流式传输到聊天UI。

- 我们支持自定义LLM设置,因此理论上可以支持无限多的llm。

状态

该项目仍处于非常早期阶段。可能会有一些bug。

运行最新版本

git clone https://github.com/nashsu/FreeAskInternet.git

cd ./FreeAskInternet

docker-compose up -d

🎉 现在您应该能够在 http://localhost:3000 打开网页界面。默认情况下,没有暴露其他端口。(旧版网页界面可访问 http://localhost:3030)

如何获取和设置Kimi / Qwen / ZhipuAI Token?

如何获取Token?

我们使用 https://github.com/LLM-Red-Team 项目提供这些服务,您可以参考他们的readme。

参考: https://github.com/LLM-Red-Team/kimi-free-api

如何使用自定义LLM如ollama?(是的,我们喜欢ollama)

- 启动ollama服务

export OLLAMA_HOST=0.0.0.0

ollama serve

- 在设置中设置ollama url:

您必须使用计算机的IP地址,而不是localhost/127.0.0.1,因为在docker中无法访问这个地址。

模型名称是您想通过ollama提供服务的模型。

ollama模型参考: https://ollama.com/library

如何更新到最新版本

cd ./FreeAskInternet

git pull

docker compose down

docker compose rm backend

docker compose rm free_ask_internet_ui

docker image rm nashsu/free_ask_internet

docker image rm nashsu/free_ask_internet_ui

docker-compose up -d

致谢

- ChatGPT-Next-Web : https://github.com/ChatGPTNextWeb/ChatGPT-Next-Web

- FreeGPT35: https://github.com/missuo/FreeGPT35

- Kimi\Qwen\ZhipuAI https://github.com/LLM-Red-Team

- searxng: https://github.com/searxng/searxng

特别感谢我们的logo设计师

许可证

Apache-2.0 许可证

访问官网

访问官网 Github

Github 论文

论文