引言

随着人工智能技术的快速发展,自动驾驶正在逐步从实验室走向现实世界。然而,要实现真正的自动驾驶,还面临着诸多挑战,其中视觉感知系统的性能至关重要。近年来,大规模预训练的视觉基础模型在计算机视觉领域取得了巨大成功,为自动驾驶的视觉感知系统带来了新的机遇。本文将全面探讨如何打造适用于自动驾驶的视觉基础模型,包括面临的挑战、现有的方法以及未来的发展机遇。

自动驾驶视觉基础模型面临的挑战

数据多样性与质量

自动驾驶场景复杂多变,涉及各种天气条件、道路环境、交通参与者等。要训练出鲁棒的视觉基础模型,需要海量的高质量、多样化数据。然而,收集和标注如此庞大的数据集既耗时又昂贵。此外,一些极端场景(如事故)的数据更是难以获取。

实时性要求

自动驾驶对系统的实时性有着极高的要求。视觉基础模型通常规模庞大,如何在有限的计算资源下实现快速推理是一个巨大挑战。

可解释性与安全性

自动驾驶直接关系到人身安全,因此模型的可解释性和鲁棒性尤为重要。如何设计既具有强大感知能力,又能提供可靠决策依据的模型是一个关键挑战。

跨域泛化

自动驾驶系统需要适应各种未知环境。如何提高视觉基础模型的泛化能力,使其能够应对训练数据中未出现的场景,是一个重要的研究方向。

数据准备方法

为了应对数据获取的挑战,研究人员提出了多种数据生成和增强的方法:

基于GAN的方法

生成对抗网络(GAN)在图像生成领域取得了巨大成功,也被广泛应用于自动驾驶数据的合成。

DriveGAN[1]是一个典型的例子,它通过无监督学习直接从像素级数据中学习环境的动态行为。DriveGAN不仅可以控制车辆的转向,还能调整场景的天气条件和非玩家对象的位置。这种方法为自动驾驶系统提供了一个高度可控的虚拟环境,可用于大规模数据生成和场景重现。

SurfelGAN[2]则采用了一种更加高效的方法,利用带纹理的表面元素(surfels)重建场景,并使用GAN网络生成逼真的相机图像。这种方法只需要有限的激光雷达和相机数据,就能重建复杂的交通场景,为自动驾驶系统的仿真测试提供了宝贵的数据资源。

基于扩散模型的方法

近年来,扩散模型在图像生成领域展现出了强大的性能,也被应用到自动驾驶场景生成中。

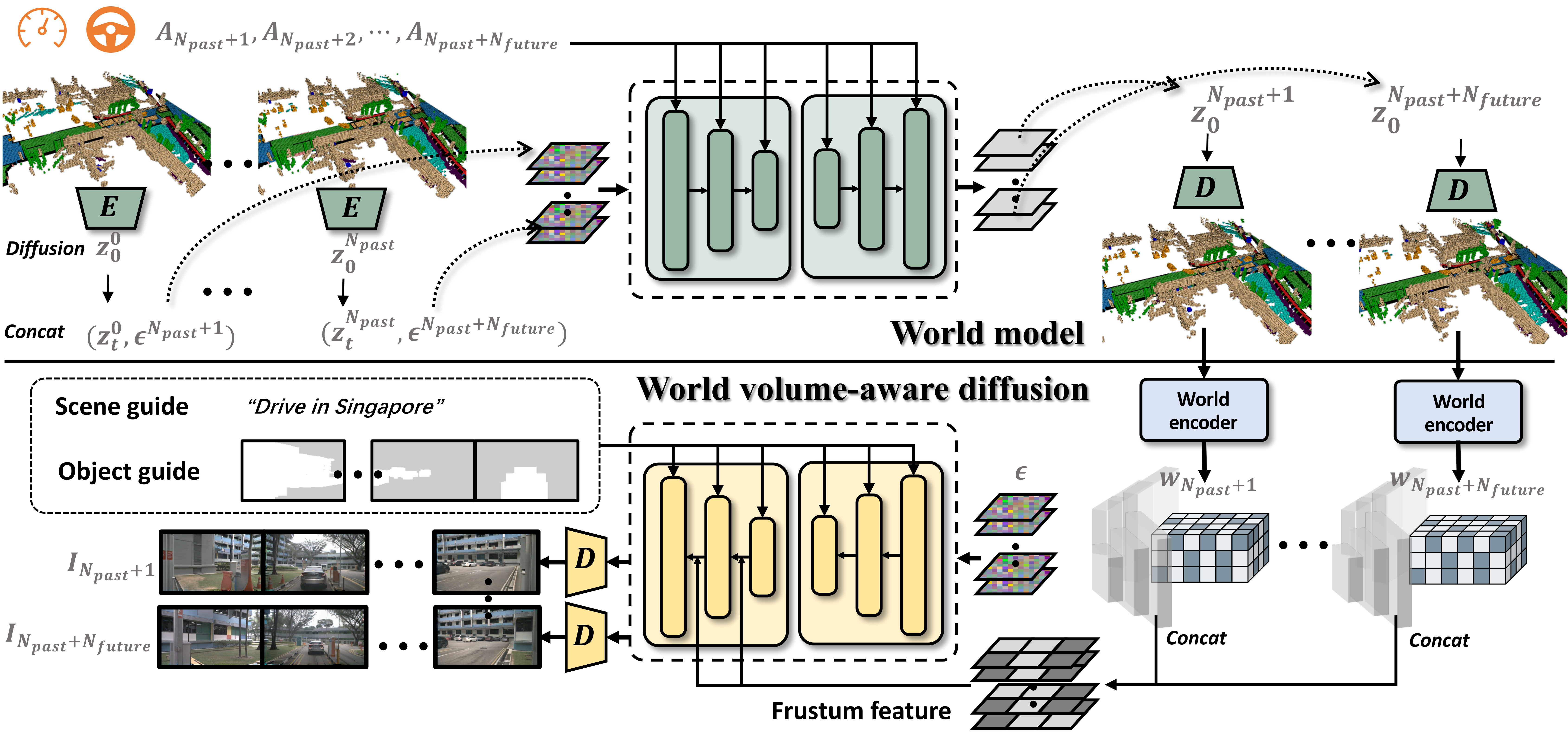

WoVoGen[3]提出了一种基于世界体积感知的多相机驾驶场景生成方法。该方法首先根据车辆控制序列预测未来的4D时空世界体积,然后基于这个世界体积和传感器之间的关联性生成多相机视频。这种方法不仅能生成高质量的街景视频,还支持场景编辑任务。

Panacea[4]则专注于生成全景可控视频。该方法通过创新的4D注意力机制和两阶段生成流程来保持时间和跨视图的一致性,并利用ControlNet框架实现对鸟瞰图布局的精确控制。Panacea在nuScenes数据集上的评估证明了其在生成高质量多视图驾驶场景视频方面的有效性。

基于神经辐射场(NeRF)的方法

神经辐射场(NeRF)技术在3D场景重建和新视角合成方面展现出了巨大潜力,为自动驾驶数据生成带来了新的可能性。NeRF通过隐式地学习场景的3D结构和外观,可以从稀疏的2D图像重建连续的3D场景表示。

AutoNeRF[5]就是一个将NeRF应用于自动驾驶场景重建的代表性工作。该方法通过结合车载相机图像和激光雷达点云数据,实现了大规模户外场景的高质量重建。AutoNeRF不仅能生成逼真的新视角图像,还能提供准确的深度信息,为自动驾驶系统的感知和规划模块提供了丰富的训练数据。

MARS[6]则进一步扩展了NeRF在动态场景中的应用。该方法通过分解静态背景和动态对象,并为每个动态对象建立单独的NeRF模型,实现了对复杂交通场景的高效重建和渲染。这种方法不仅能生成连续的视频序列,还能支持交互式的场景编辑,为自动驾驶系统的仿真测试提供了更加灵活的工具。

自监督训练方法

为了充分利用大量未标注的数据,研究者们提出了多种自监督训练方法:

对比学习

对比学习通过学习同一场景不同视角或时间点的表征之间的关系,来获得有意义的特征表示。

DINO[7]是一种基于自蒸馏的视觉transformer自监督学习方法。它通过让同一图像的不同增强版本互相学习,实现了高质量的特征提取。这种方法在自动驾驶场景中特别有价值,因为它可以从大量未标注的街景图像中学习到丰富的语义信息。

重建任务

通过预测被遮挡或未来的图像内容,模型可以学习到场景的内在结构和动态特性。

MaskFeat[8]提出了一种新颖的自监督学习范式,通过预测被遮挡区域的HOG(Histogram of Oriented Gradients)特征来学习视觉表征。这种方法在自动驾驶场景中特别有效,因为它能够捕捉到物体的结构和边缘信息,这对于障碍物检测和场景理解至关重要。

知识蒸馏

知识蒸馏允许将大型预训练模型的知识转移到更小、更高效的模型中,这对于自动驾驶系统的实时性要求非常重要。

SEED[9]提出了一种自监督知识蒸馏框架,通过让学生模型模仿教师模型的表征分布来学习。这种方法不仅可以提高模型的性能,还能大幅减少模型的规模,使其更适合部署在计算资源有限的自动驾驶平台上。

基于渲染的方法

通过结合3D几何信息和2D图像生成任务,模型可以学习到更加鲁棒和通用的特征表示。

NeRF-Supervised[10]提出了一种利用神经辐射场(NeRF)进行自监督学习的方法。该方法通过预测不同视角下的图像内容来学习场景的3D结构和外观。这种方法在自动驾驶场景中特别有价值,因为它可以帮助模型理解复杂的3D环境,提高对遮挡和视角变化的鲁棒性。

模型适应方法

为了使视觉基础模型更好地适应自动驾驶任务,研究者们提出了多种模型适应方法:

视觉基础模型适应

预训练的大规模视觉模型如CLIP、SAM等,通过在海量互联网数据上训练,具有强大的视觉理解能力。然而,如何将这些通用能力迁移到自动驾驶特定任务中仍然是一个挑战。

AdaptSAM[11]提出了一种轻量级的适应方法,通过微调SAM模型的少量参数,实现了在自动驾驶场景中的高效目标检测和分割。这种方法不仅保留了SAM模型的通用性,还大大提高了其在特定任务上的性能。

大语言模型适应

大语言模型(LLM)如GPT系列在自然语言处理领域取得了巨大成功。研究者们正在探索如何将LLM的强大推理能力应用到自动驾驶决策中。

LLM-Driver[12]是一个将大语言模型应用于自动驾驶的创新尝试。该方法通过将视觉信息转化为文本描述,然后利用LLM进行推理和决策。这种方法不仅提高了系统的可解释性,还能处理复杂的交通规则和道德决策问题。

多模态基础模型适应

多模态基础模型如CLIP-ViL通过联合学习视觉和语言表征,展现出了强大的跨模态理解能力。这为自动驾驶系统的多传感器融合和场景理解带来了新的可能性。

MMAD[13]提出了一种多模态自动驾驶框架,它结合了视觉、语言和控制信号。通过预训练的多模态基础模型,MMAD能够更好地理解复杂的驾驶场景,并生成更加自然和安全的驾驶决策。

未来展望

尽管自动驾驶视觉基础模型在近年来取得了显著进展,但仍然存在许多挑战和机遇:

-

数据效率: 如何利用有限的标注数据训练出更加强大的模型仍然是一个关键问题。未来的研究可能会更多地关注半监督学习、弱监督学习等方向。

-

模型压缩与加速: 如何在保持性能的同时减小模型规模、提高推理速度,对于自动驾驶系统的实际部署至关重要。模型量化、知识蒸馏、神经网络架构搜索等技术将继续受到关注。

-

多模态融合: 未来的自动驾驶系统将更多地依赖于多种传感器的协同工作。如何设计能够有效融合视觉、激光雷达、雷达等多模态数据的基础模型是一个重要方向。

-

可解释性与安全性: 随着自动驾驶系统逐步投入实际应用,模型的可解释性和安全性将变得越来越重要。未来的研究可能会更多地关注如何设计既具有高性能又可解释、可验证的模型。

-

终身学习: 自动驾驶系统需要能够不断适应新的环境和情况。如何设计能够持续学习、不断更新的视觉基础模型是一个具有挑战性的研究方向。

-

跨域泛化: 提高模型在不同地理位置、天气条件、交通规则下的泛化能力仍然是一个重要挑战。领域自适应、元学习等技术可能会在这个方向上发挥重要作用。

-

与规划和控制的深度集成: 未来的研究可能会更多地关注如何将视觉感知与决策规划、控制执行等模块进行更加紧密的集成,实现端到端的自动驾驶系统。

-

伦理和法律问题: 随着自动驾驶技术的发展,相关的伦理和法律问题也将变得越来越重要。未来的研究可能需要更多地考虑如何在模型设计中融入伦理准则和法律约束。

结论

打造适用于自动驾驶的视觉基础模型是一项充满挑战且意义重大的任务。本文系统地回顾了该领域的研究现状,包括数据准备、自监督训练、模型适应等多个方面。我们看到,基于GAN、扩散模型、NeRF等技术的数据生成方法为解决数据匮乏问题提供了新的思路;对比学习、重建任务、知识蒸馏等自监督学习方法使得模型能够