llama-cpp-python:为大语言模型赋能的Python绑定工具

llama-cpp-python是一个为著名的llama.cpp库提供Python绑定的开源项目。它为开发者提供了一套简单而强大的工具,可以轻松地在Python中使用和部署大语言模型。无论您是想快速尝试最新的语言模型,还是要构建复杂的AI应用程序,llama-cpp-python都能满足您的需求。

主要特性

llama-cpp-python具有以下主要特性:

-

高级和低级API:提供了简单易用的高级API,同时也保留了对底层C API的直接访问。

-

OpenAI兼容接口:可以作为OpenAI API的替代品,无需修改现有代码即可使用自定义模型。

-

GPU加速支持:支持CUDA、Metal、hipBLAS等多种GPU加速后端,充分利用硬件性能。

-

多模态模型支持:可以处理图像和文本输入的多模态模型,如llava。

-

函数调用:支持OpenAI兼容的函数调用和工具调用功能。

-

兼容性:与LangChain、LlamaIndex等流行的AI框架兼容。

-

Web服务器:内置OpenAI兼容的Web服务器,可以快速部署模型API。

安装

llama-cpp-python的安装非常简单:

pip install llama-cpp-python

对于需要GPU加速的用户,可以通过设置环境变量来启用CUDA支持:

CMAKE_ARGS="-DGGML_CUDA=on" pip install llama-cpp-python

项目还提供了预编译的wheel包,支持基本的CPU功能和CUDA加速:

pip install llama-cpp-python \

--extra-index-url https://abetlen.github.io/llama-cpp-python/whl/cpu

使用示例

以下是一个简单的文本补全示例:

from llama_cpp import Llama

llm = Llama(model_path="./models/7B/llama-model.gguf")

output = llm(

"Q: 太阳系中的行星有哪些? A: ",

max_tokens=32,

stop=["Q:", "\n"],

echo=True

)

print(output)

llama-cpp-python还支持从Hugging Face Hub直接下载和使用模型:

llm = Llama.from_pretrained(

repo_id="Qwen/Qwen2-0.5B-Instruct-GGUF",

filename="*q8_0.gguf",

verbose=False

)

对于需要处理图像的多模态任务,可以使用如下代码:

from llama_cpp import Llama

from llama_cpp.llama_chat_format import Llava15ChatHandler

chat_handler = Llava15ChatHandler(clip_model_path="path/to/llava/mmproj.bin")

llm = Llama(

model_path="./path/to/llava/llama-model.gguf",

chat_handler=chat_handler,

n_ctx=2048,

)

llm.create_chat_completion(

messages = [

{"role": "user", "content": [

{"type" : "text", "text": "这张图片里有什么?"},

{"type": "image_url", "image_url": {"url": "https://example.com/image.jpg"}}

]}

]

)

内置Web服务器

llama-cpp-python提供了一个兼容OpenAI API的Web服务器,可以快速部署模型API:

pip install 'llama-cpp-python[server]'

python3 -m llama_cpp.server --model models/7B/llama-model.gguf

服务器支持代码补全、函数调用、多模态模型等高级功能,可以轻松集成到现有的AI应用中。

结语

llama-cpp-python为开发者提供了一个强大而灵活的工具,可以轻松地在Python中使用和部署最先进的大语言模型。无论是个人开发者还是企业用户,都能从中受益,快速构建创新的AI应用。随着项目的不断发展,我们可以期待看到更多令人兴奋的特性和改进。

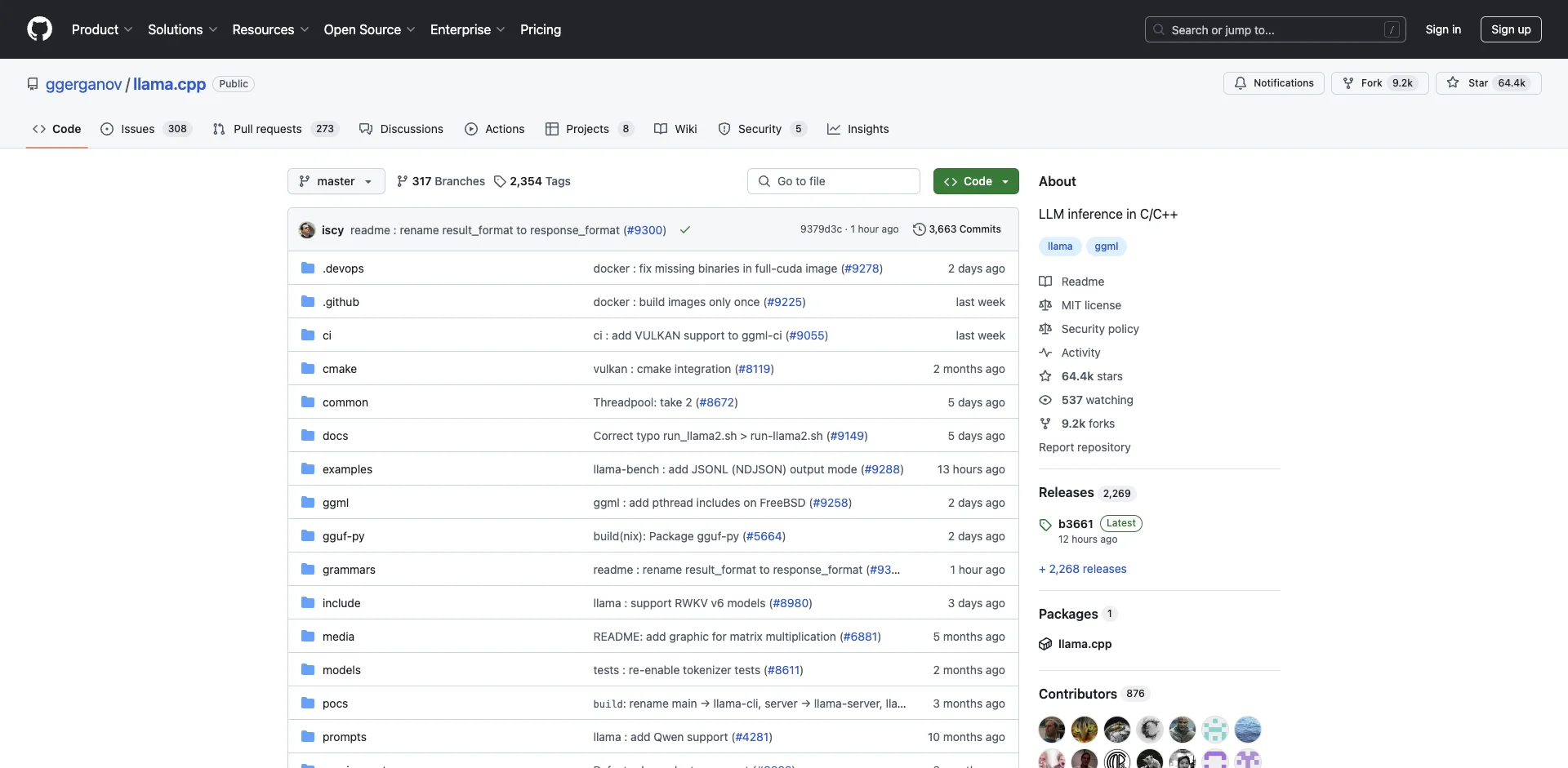

如果您对llama-cpp-python感兴趣,可以访问项目GitHub页面了解更多信息,或者查阅官方文档获取详细的使用指南。让我们一起探索大语言模型的无限可能吧!