强大的多模态大语言模型家族

用于无OCR文档理解

阿里巴巴集团

📢 新闻

- 🔥🔥🔥 [2024.7.16] 我们的论文 PaperOwl 被ACM MM 2024接收。

- 🔥🔥🔥 [2024.5.08] 我们发布了由DeepSpeed支持的 DocOwl1.5 训练代码。现在您可以基于DocOwl1.5微调出一个更强大的模型!

- 🔥🔥🔥 [2024.4.26] 我们发布了 TinyChart 的arXiv论文,这是一个用于图表理解的最先进的3B多模态大语言模型,具有程序思维能力(ChartQA:83.6 > Gemin-Ultra 80.8 > GPT4V 78.5)。TinyChart的演示可在 HuggingFace 🤗 上体验。代码、模型和数据都在 TinyChart 中发布。

- 🔥🔥 [2024.4.3] 我们在 ModelScope

和 HuggingFace 🤗 上构建了DocOwl1.5的演示,由DocOwl1.5-Omni支持。在 DocOwl1.5 中还发布了启动本地演示的源代码。

和 HuggingFace 🤗 上构建了DocOwl1.5的演示,由DocOwl1.5-Omni支持。在 DocOwl1.5 中还发布了启动本地演示的源代码。 - 🔥 [2024.3.28] 我们在 HuggingFace 🤗 和 ModelScope

上发布了 mPLUG-DocOwl 1.5 的训练数据(DocStruct4M、DocDownstream-1.0、DocReason25K)、代码和模型(DocOwl1.5-stage1、DocOwl1.5、DocOwl1.5-Chat、DocOwl1.5-Omni)。

上发布了 mPLUG-DocOwl 1.5 的训练数据(DocStruct4M、DocDownstream-1.0、DocReason25K)、代码和模型(DocOwl1.5-stage1、DocOwl1.5、DocOwl1.5-Chat、DocOwl1.5-Omni)。 - [2024.3.20] 我们发布了 mPLUG-DocOwl 1.5 的arXiv论文,这是一个用于无OCR文档理解的最先进的8B多模态大语言模型(DocVQA 82.2,InfoVQA 50.7,ChartQA 70.2,TextVQA 68.6)。

- [2024.01.13] 我们的科学图表分析数据集 M-Paper 已在 HuggingFace 🤗 和 ModelScope

上发布,包含447k高分辨率图表图像和相应的段落分析。

上发布,包含447k高分辨率图表图像和相应的段落分析。 - [2023.10.13] mPLUG-DocOwl/UReader 的训练数据和模型已开源。

- [2023.10.10] 我们的论文 UReader 被EMNLP 2023接收。

- [2023.07.10] mPLUG-DocOwl在 ModelScope 上的演示已可用。

- [2023.07.07] 我们发布了mPLUG-DocOwl的技术报告和评估集。

🤖 模型

-

mPLUG-DocOwl1.5 (Arxiv 2024) - mPLUG-DocOwl 1.5:用于无OCR文档理解的统一结构学习

-

TinyChart (Arxiv 2024) - TinyChart:通过视觉令牌合并和程序思维学习实现高效图表理解

-

mPLUG-PaperOwl (ACM MM 2024) - mPLUG-PaperOwl:使用多模态大语言模型进行科学图表分析

-

UReader (EMNLP 2023) - UReader:使用多模态大语言模型实现通用无OCR视觉情境语言理解

-

mPLUG-DocOwl (Arxiv 2023) - mPLUG-DocOwl:用于文档理解的模块化多模态大语言模型

📺 在线演示

注意:由于HuggingFace的ZeroGPU Spaces中的GPU是动态分配的,因此HuggingFace的演示不如ModelScope稳定。

📖 DocOwl 1.5

📈 TinyChart-3B

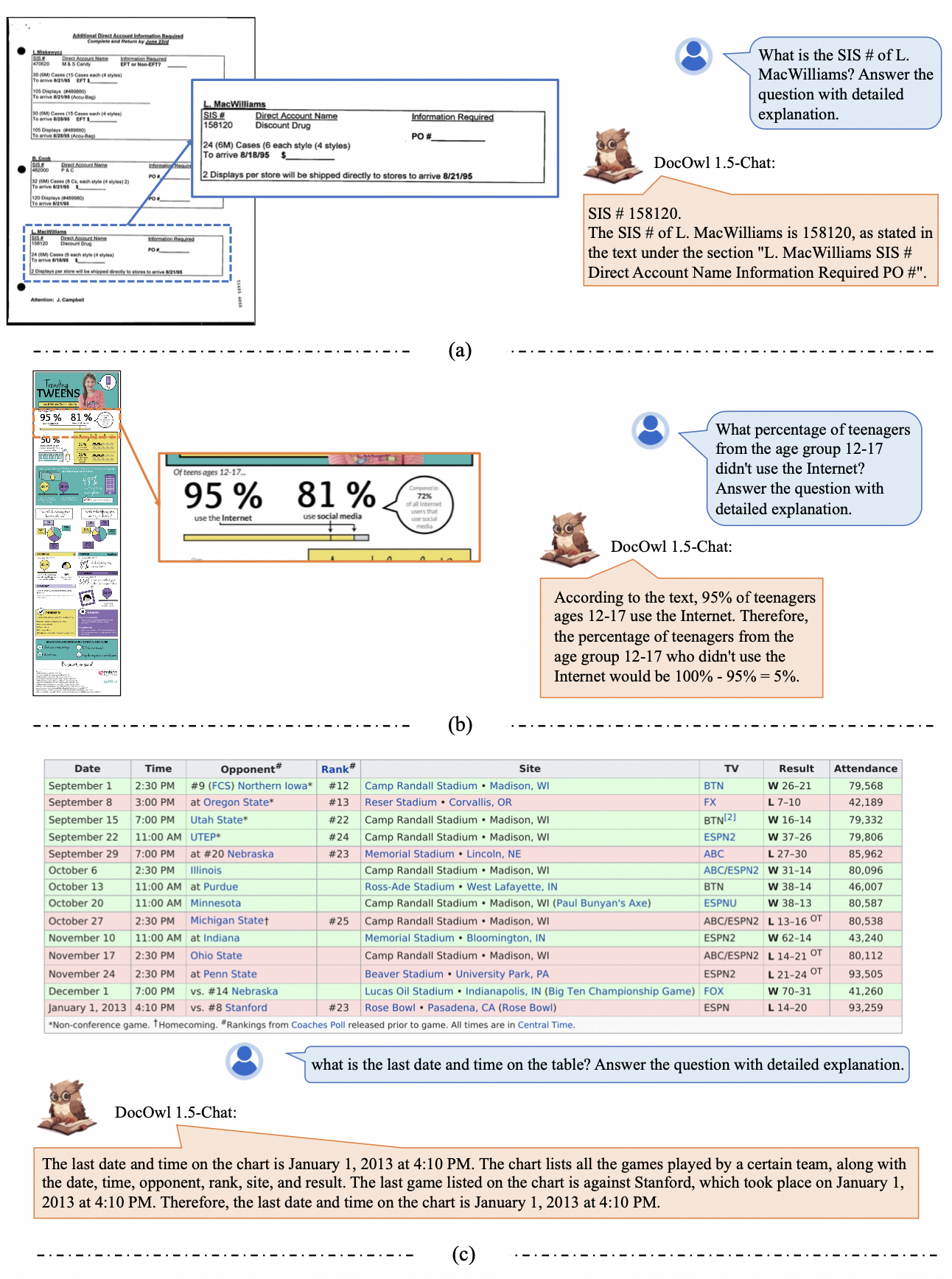

🌰 案例

Github

Github Huggingface

Huggingface 论文

论文