Ferret:在任何地方、任何粒度下指代和定位任何事物

Ferret:在任何地方、任何粒度下指代和定位任何事物

一个接受任何形式指代并在回复中定位任何事物的端到端多模态大语言模型。 [论文]

Haoxuan You*, Haotian Zhang*, Zhe Gan, Xianzhi Du, Bowen Zhang, Zirui Wang, Liangliang Cao, Shih-Fu Chang, Yinfei Yang [*: 共同第一作者]

概述

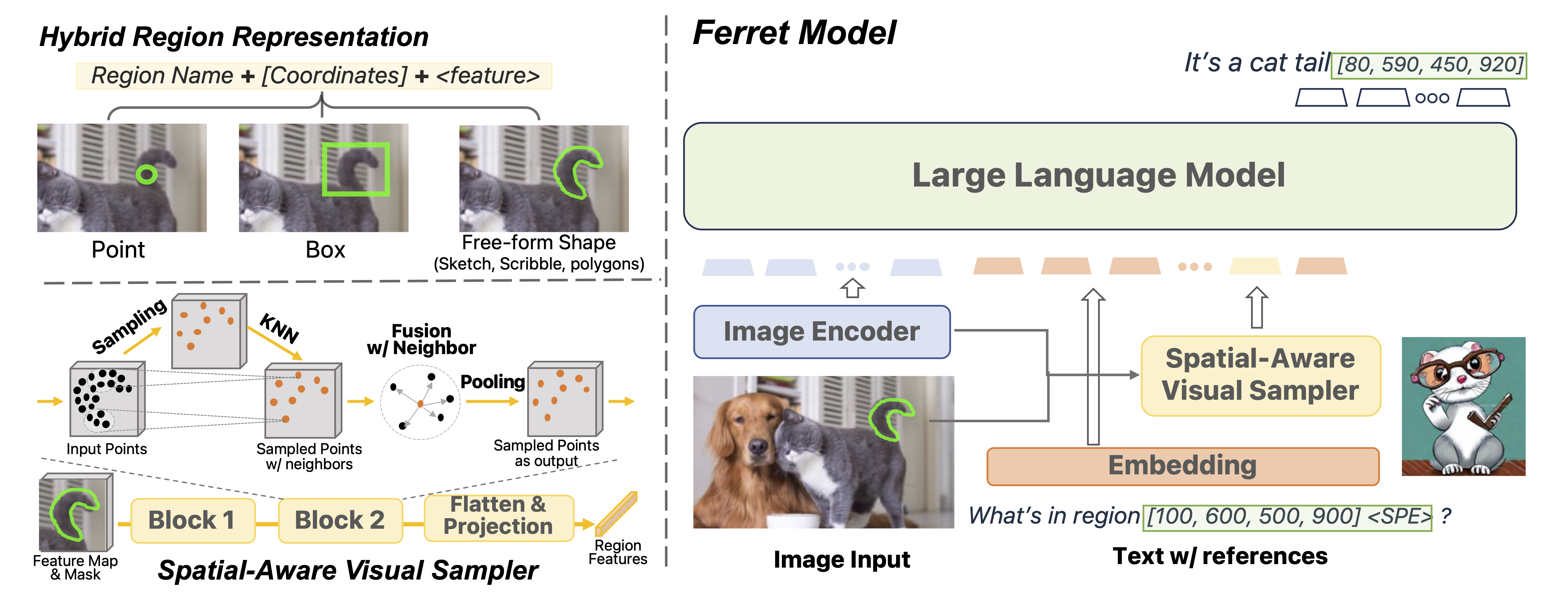

Ferret 模型示意图。

主要贡献:

- Ferret 模型 - 混合区域表示 + 空间感知视觉采样器使多模态大语言模型能够进行细粒度和开放词汇的指代和定位。

- GRIT 数据集(约110万条) - 一个大规模、层次化、稳健的定位与指代指令微调数据集。

- Ferret-Bench - 一个多模态评估基准,同时要求指代/定位、语义、知识和推理能力。

发布

- [12/14] 🔥 我们发布了模型检查点(7B, 13B)。

- [10/30] 🔥 我们发布了FERRET模型的代码和Ferret-Bench。

使用和许可声明:数据和代码仅供研究使用。它们还受限于遵守LLaMA、Vicuna和GPT-4的许可协议。数据集采用CC BY NC 4.0许可(仅允许非商业用途),使用该数据集训练的模型不应用于研究目的以外的用途。

目录

安装

- 克隆此仓库并进入FERRET文件夹

git clone https://github.com/apple/ml-ferret

cd ml-ferret

- 安装包

conda create -n ferret python=3.10 -y

conda activate ferret

pip install --upgrade pip # 启用PEP 660支持

pip install -e .

pip install pycocotools

pip install protobuf==3.20.0

- 为训练情况安装额外的包

pip install ninja

pip install flash-attn --no-build-isolation

训练

FERRET在8张80GB内存的A100 GPU上进行训练。要在更少的GPU上训练,你可以减少per_device_train_batch_size并相应增加gradient_accumulation_steps。始终保持全局批量大小不变:per_device_train_batch_size x gradient_accumulation_steps x num_gpus。

超参数

我们在微调时使用了与LLaVA(Vicuna)类似的一组超参数。

| 超参数 | 全局批量大小 | 学习率 | 训练轮数 | 最大长度 | 权重衰减 |

|---|---|---|---|---|---|

| FERRET-7B | 128 | 2e-5 | 3 | 2048 | 0 |

| FERRET-13B | 128 | 2e-5 | 3 | 2048 | 0 |

准备 Vicuna 检查点和 LLaVA 的投影器

开始之前,请准备我们的基础模型 Vicuna,这是一个经过指令微调的聊天机器人。请按照这里的说明下载其权重。FERRET 使用的是 Vicuna v1.3。

然后下载 LLaVA 的第一阶段预训练投影器权重(7B,13B)。

FERRET 训练

评估

详细信息请参阅此文档。

检查点

我们提取了预训练模型与 Vicuna 之间的差异。请先按照之前的说明下载 Vicuna 的权重。然后使用 wget 或 curl 下载我们准备好的权重偏移:7B,13B,并解压下载的偏移。最后,通过运行以下脚本将偏移应用到 Vicuna 的权重上:

# 7B

python3 -m ferret.model.apply_delta \

--base ./model/vicuna-7b-v1-3 \

--target ./model/ferret-7b-v1-3 \

--delta path/to/ferret-7b-delta

# 13B

python3 -m ferret.model.apply_delta \

--base ./model/vicuna-13b-v1-3 \

--target ./model/ferret-13b-v1-3 \

--delta path/to/ferret-13b-delta

注意:Apple 对附加权重差异的权利特此根据 CC-BY-NC 许可授权。Apple 不对 LLaMa 或任何其他第三方软件做出任何陈述,这些软件受其自身条款约束。

关于如何使用预训练权重设置本地演示,请参考下一节。

演示

要运行我们的演示,您需要训练 FERRET 并在本地使用检查点。我们使用 Gradio 网页界面。请依次运行以下命令。

启动控制器

python -m ferret.serve.controller --host 0.0.0.0 --port 10000

启动 Gradio 网页服务器

python -m ferret.serve.gradio_web_server --controller http://localhost:10000 --model-list-mode reload --add_region_feature

启动模型工作进程

这是负责加载检查点并在 GPU 上进行推理的工作进程。每个工作进程负责 --model-path 中指定的单个模型。

CUDA_VISIBLE_DEVICES=0 python -m ferret.serve.model_worker --host 0.0.0.0 --controller http://localhost:10000 --port 40000 --worker http://localhost:40000 --model-path ./checkpoints/FERRET-13B-v0 --add_region_feature

等待进程完成模型加载,直到看到 "Uvicorn running on ..."。现在,刷新 Gradio 网页界面,您将在模型列表中看到刚刚启动的模型。

Ferret 交互式演示示例。

引用

如果您发现 Ferret 有用,请使用以下 BibTeX 进行引用:

@article{you2023ferret,

标题={Ferret: 在任何地方指代和定位任何内容,精确到任意粒度},

作者={游浩轩 and 张浩天 and 甘哲 and 杜显志 and 张博文 and 王子瑞 and 曹亮亮 and 张世富 and 杨茵菲},

期刊={arXiv预印本 arXiv:2310.07704},

年份={2023}

}

Github

Github 论文

论文